| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> 如何判断候选人有没有千卡GPU集群的训练经验? -> 正文阅读 |

|

|

[科技知识]如何判断候选人有没有千卡GPU集群的训练经验? |

| [收藏本文] 【下载本文】 |

|

大模型如此火热,如何判断候选人有没有千卡GPU集群的实际训练经验? |

|

供求关系反了。一般有这个能力的人不是公司挑他,而是他挑愿意去哪个公司。 |

|

问下千卡训练多久挂一次,挂了之后咋弄,有效训练时间是多长。有好多paper 都分享了千卡训练的经验,paper 里些的问题基本都是普遍存在的问题,随便挑几个问下就知道有没有搞过千卡了。paper 里的问题基本都大家踩坑踩出来的,没踩过的很难回答到关键细节点上。比如这篇paper https://arxiv.org/pdf/2403.07648.pdf 还有字节的megascale等文章。 除此之外,我们也开源了蚂蚁千卡训练系统dlrover,主演解决k8s上分布式训练的稳定性问题,希望对于正在或者将要做千卡训练的小伙伴有所帮助,https://github.com/intelligent-machine-learning/dlrover |

|

说来惭愧,我们组用的阿里云的计算资源(2000+的A800的卡),已经非常稳定了,几乎不需要做太多工作。 预训练的任务一般一个月也就挂一两次吧,平台有自动重启的机制,会自动重启任务并载入最近保存的ckpt。所以实在说不上有啥技术含量。 我感觉预训练更多的工作还是在数据的处理上。 |

|

千卡确实是个挑战,因为64张卡后,每个GPU的吞吐量就开始快速下滑;64卡后如何做通信优化,我觉得这是关键点之一,有经验的人肯定绕不过去;打哈哈的更大概率,就是没有真正的经验。 |

|

|

|

|

除非上一个工作是基础大模型公司,或者研究生阶段是大模型第一梯队实验室,不然哪来千卡集群经验? |

|

这题我会,而且我还把对面搞到差点精神崩溃,看我的眼神里面充满了愤怒、悲怆、颓唐、哀痛、草泥马以及对我人格的质疑。 方法也很简单,把Megatron的log打印出来,argument的部分,一行一行问: 这个参数什么意思? 一般怎么设置? 改了之后会怎么样? 业界有无更好的的解决方案? …… 能回答上来三分之一差不多代码框架跟机器学习功底都不错,能回答一半以上基本有很强的大规模训练经验了。 澄清一下,通常来说这个是用来问算法的,因为现在用Megatron跑这种大规模训练真的是有卡就行,而算法一般是不太在意效率的,所以为什么要用这个参数来跑才是算法应该有sense的地方。 其他答案里面在意效率的,那是要问构架的,而真的要牵扯到构架的话,在目前Sparse MoE的大背景下,你的某一个tensor的mapping要怎么做都是非常非常困难且细致的问题,不是泛泛而谈就能把效率提上去的。而且真要问八股问题直接问TP+EP+(V)PP怎么做就行了,市面上99%的人都搞不明白。 |

|

校招:没有去实习,可以默认基本没有(去特别头部的llm团队,实习时间长,可能会有) 社招:了解下上家的公司/团队,基本心里有数了(互联网大厂的基座llm团队可能会有、核心业务的推理层业务可能会有) 不用技术面,背景判断就能分析个八九不离十了。 |

|

只用过128卡,但跑多了发现故障率和16卡没啥区别,看运气。。。。 补充一下 有一次,连续一天分配的16张卡里都有坏卡/节点故障,中间有找IT申请屏蔽。但还是脸黑到这种程度 |

|

绝大部分人应该都不会有千卡GPU的训练经验吧,像我这样的苦逼PhD能够有几张A100已经在开香槟庆祝了(逃) 主要千卡GPU跟普通的多卡并行已经不是一个概念了,里面的坑跟普通会调DDP训个模型完全不是一个性质的东西,千卡以上对于GPU吞吐量、GPU通信这些概念都得熟悉并且有基本的优化方案,这就对候选人的工程能力有比较高的要求,大部分在校学生可以先pass掉。 另外可以参考候选人之前做的研究方向,千卡GPU训练通常都是做foundation models的了,如果对LLM预训练、SFT、RLHF三阶段比较清楚的,或者是训过Stable Diffusion级别文生图模型,有类似经历的,估计也八九不离十,即使没有相关经验上手肯定也会比一般人要快。 |

|

你问出这个问题就说明你压根不是圈内的人。 圈内的人只要你报出你的单位或者你的几个朋友同事,我们都知道你是不是有千卡训练的经验。 这个招聘要求,并不是按照字面上的意思来的。这个招聘要求,实际上翻译一下就是:我们只要某某公司(比如文心一言,讯飞星火)这种的核心成员。这些人内部圈子大家都是互相认识的,基本找一两个朋友都能跳过去。所以这个招聘要求说的更直白一点就是:如果你不是我朋友或者朋友的朋友,就不要来浪费你时间了。 我这么说是不是你会更好理解一些。 |

|

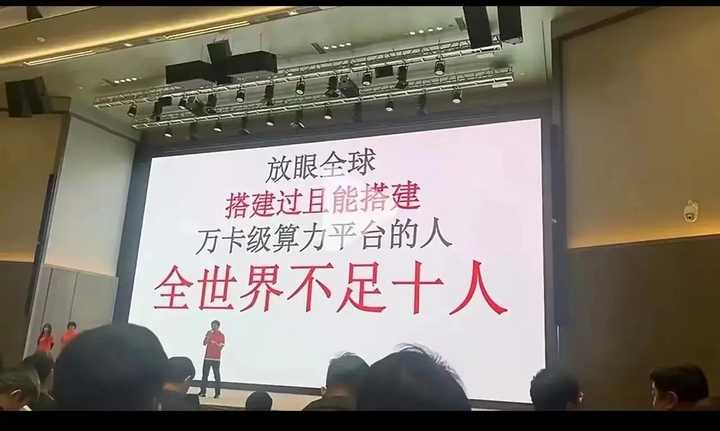

当然是看他的ppt呀: |

|

|

|

|

如果只是说训练经验,我感觉训练千卡和16卡并不会有太大区别。因为在大厂(说的是能搞也在搞千卡甚至万卡集群的大厂),都有专门的infra团队在打磨系统,在系统比较稳定之后,训练模型的同学都只需要提交任务,不会有明显额外的经验。PS:当然,清洗和整理数据可能才是重点。 |

|

看从哪个公司出来的就能知道。。。 |

|

看简历,一共也没有几个坑会有这种经验 |

|

我一个做模型算法的害得搞集群运维是吧,专人专职都做不到,你这个公司我看也没什么前景,我就不浪费时间面试了 |

|

你能问出这个问题来,就证明,你也没有,他也没有。 |

|

你应该优先看看这个候选人的负责的业务线有没有千卡 猎头都是按照产品线,业务线,职级去估算这个人的履历的 简单来说,就是业务配个经理,机器配个人,产品配个跑腿的,都是研究业务行不行,产品行不行就能知道这个人行不行了 你倒好。。不研究产品行不行。。研究人行不行。。 |

|

你们读书时候老师没有和你们说过,人才都是特招邀请过去的嘛? |

|

其实这个经验不重要 对于大规模集群,nvidia或代理商会直接提供技术支持 大部分坑已经总结在nvidia的fae报告里了 事实上已经是纯工程化的东西 |

|

这是哪家的HR跑来这里免费提问了? 不知道知识付费吗? 总想着吃免费的午餐? 呵呵,不懂得免费的才是最贵的吗? |

|

以下是一些可以判断候选人是否有千卡GPU集群训练经验的技术细节: 1. 面试 询问候选人是否有使用过千卡GPU集群进行训练的经验。询问候选人对千卡GPU集群训练的了解程度,包括: 千卡GPU集群的架构和工作原理千卡GPU集群训练的常见挑战和解决方案千卡GPU集群训练的性能优化技巧询问候选人是否有使用过常见的千卡GPU集群训练工具和框架,例如: TensorFlowPyTorchHorovod询问候选人是否有参与过千卡GPU集群训练项目的经验。 在评估候选人是否有使用千卡GPU集群训练经验的具体技术细节方面,你可以询问以下问题以判断他们的专业水平: 1. 分布式训练框架知识: - 询问候选人是否熟悉并有实际使用经验,如TensorFlow的`tf.distribute.Strategy`或PyTorch的`torch.nn.parallel.DistributedDataParallel`。 - 能否解释多GPU同步和异步训练的区别及其对模型性能的影响。 2. 资源管理和调度: - 是否了解并使用过诸如Kubernetes、Slurm或其他集群管理工具来调度和管理GPU资源。 - 对容器技术如Docker在部署分布式训练作业方面的应用有何理解。 3. 训练作业的配置: - 在多卡训练中如何处理数据的分布和加载,以及如何设置batch size,是否有理解对梯度更新机制的影响。 - 是否有经验设置高级优化器如Adam或LAMB,并理解它们对于训练稳定性和收敛速度的影响。 4. 性能优化: - 能否详述在多GPU环境中对模型进行性能调优的经验,包括使用混合精度训练、层次化内存管理(如NVIDIA的NCCL)、Tensor Fusion等。 - 是否了解如何利用GPU的特性来优化计算,比如避免数据传输瓶颈、使用异步I/O、优化内存使用等。 5. 调试和监控: - 是否熟悉使用GPU性能分析工具(如NVIDIA Nsight Systems和Nsight Compute)来诊断瓶颈和性能问题。 - 对分布式训练中的故障排查和调试有什么经验,比如网络通信错误、内存溢出、性能下降等。 6. 实际案例分析: - 请求候选人分享一个他们在分布式GPU环境中遇到的具体问题及其解决方案的例子。 - 如何处理和优化大规模参数模型的存储和加载。 7. 最佳实践和理论知识: - 是否熟悉梯度累积、权重衰减、学习率预热等训练技巧。 - 对分布式训练中常见的概念,如模型并行、数据并行和流水线并行有没有深入理解。 8. 代码和仓库管理: - 是否有使用版本控制系统管理分布式训练代码的经验,以及如何确保代码的可重复性和可追溯性。 2. 技术测试 让候选人完成一个使用千卡GPU集群进行训练的任务。评估候选人完成任务的能力,包括: 任务的完成时间任务的完成质量任务的代码质量 3. 背景调查 查看候选人的简历和第三方个人资料,是否有相关工作经历或项目经验。联系候选人的推荐人,了解候选人的相关技能和经验。 以下是一些可以帮助您判断候选人答案的资源: TensorFlow 教程:在 GPU 上训练: https://www.tensorflow.org/tutorials/images/cnnPyTorch 教程:在 GPU 上训练: Horovod 文档: https://horovod.readthedocs.io/en/stable/NVIDIA GPU 加速深度学习: 通过以上方法,您可以对候选人是否有千卡GPU集群训练经验进行全面的评估。 |

|

|

|

|

有这种经验的人极少,如果有人敢这么说自己,那就肯定是有的,不然随便问个问题就回不上来 |

|

压根没啥技术含量,难的是没有一千张卡 |

|

国内有那几家公司有千卡GPU??? 这个不难判断吧 |

|

惭愧只会单卡 |

|

想白嫖是吧,建议先分清,自己是想招搭建千卡的运维,还是招算法工程师。没有千卡平台,招来做什么? 张口是节点啊,ib啊,排队啊,训练时间啊,参数大小啊这种的,一般就是训过的。数据上的话,就是正常的去重啊,过滤啊,多少百分比做聚类啊之类的。 然后,用的是非NVIDIA的卡的话,问问训练时会遇到啥错误。现在都还好了,过去的话非NVIDIA的卡的话,像bf16这种数据格式导致的各种问题,会比较常见。 以前不用deepspeed的时候,都是自己写并发,麻烦点。现在都是一行命令的事,没啥区别 |

|

假装自己是chatgpt: 要判断候选人是否具备千卡GPU集群的训练经验,可以考虑以下几点。首先,如果题主所在公司有能力配置千卡A100/H100级别的GPU集群,那么公司内部很可能已经拥有相关技能的专家,可以寻求他们的帮助和指导。 在拥有千卡规模私有GPU集群的情况下,通常会由一个团队负责运维和管理,团队成员间分工明确:有的负责网络和存储基础设施,有的负责开发辅助支持工具,有的专注于通信和计算效率的优化,还有人负责运行和优化上层算法代码。因此,在招聘过程中,应根据职位的具体需求制定相应的面试问题。 可能的面试问题可以包括: - 分布式训练的基本原理。虽然这是基础内容,可能通过背诵得来,但询问这类问题可能无法有效判断候选人的实践能力。 - 在候选人过往的经验中,千卡训练任务出现故障的频率,以及他们如何诊断和修复这些故障。探询他们遇到过的具体故障原因,以及他们为解决这些问题实施的工具和软件优化措施,设计的故障检测策略等。 - 候选人在实际训练任务中进行了哪些提高了GPU算力利用率诊断和优化工作,以及这些工作效果如何。 如果公司选择通过购买云服务来获取GPU集群的训练能力,那么可以让云服务提供商提供一套效率较高的训练代码以供使用。在遇到问题或者训练效率不满意的情况下,可以请求云服务提供商进行修复。在这种情况下,候选人的训练经验可能与那些在几十卡GPU环境下的经验没有太大差异。 |

|

别面试了,建议给候选人付费咨询 |

|

不用判断的,有千卡训练的都是大公司了吧,圈子都很小了吧,猎头都熟悉了对吧,给钱挖对方就是了 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |