| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> RWKV和Mamba等recurrence类的模型真的能够击败transformer吗? -> 正文阅读 |

|

|

[科技知识]RWKV和Mamba等recurrence类的模型真的能够击败transformer吗? |

| [收藏本文] 【下载本文】 |

|

RWKV和Mamba等recurrence模型都存在着状态机制,而这个状态的大小是恒定的。这种恒定大小的状态足够记录所有的历史信息以用来进行后续复杂的… |

|

调了近一个月。mamba最大的优势我认为在于作为language model时候,省去了transformer频繁的矩阵操作,直接用一个hidden state传递信息,但关系建模能力和transformer比不了,起码在我的领域拼点,同等参数量情况下怎么调都没法超越transformer。已经考虑放弃了。 |

|

有recurrence和内在状态的神经网络未来可能击败transformer,特别是在机器人、不能联网等有计算资源、能源限制的应用场景下。人类的通用智能不是靠记住所有历史信息,其内在恒定甚至变小的状态就能支持通用智能;现在LLM推理时使用的全部历史信息,对transformer而言更像外在的机械的原始信息,类似于人类面对外在记录介质的情形,但对过长的序列也未见得能特别有效地利用起来,且导致了过大的计算资源需求。 从现有的争议最少能称为通用智能的人类智能来看,恒定大小的内部状态完全可以支持通用智能。一般认为,人类大脑在出生后的很短的时间神经元和突触数量在增长并达到最大,其后开始神经元和突触数目减少,到青春期之后,神经元数量稳定下来基本不变【1,2】。成年后新皮层神经元数甚至仍在减少【3】(如图1),新皮层一般被认为是和人类的通用智能最相关的大脑部分。人脑中recurrence确实普遍存在,而且其中每个神经元、每个突触等都有自己的历史状态。 |

|

|

人类男性和女性的神经元总数(非等距对数标度)与年龄(线性标度:18-105 岁)的函数关系。【3】 人类智能的通用性并不靠记住所有历史信息,相反地,我们一般人就是无法记住大量细节。人的感官模态中最大的数据量来自于视觉,但绝大部分人都难以记住所有视觉细节,例如你现在能回想起一张毛爷爷的全部细节吗?再说人的自然语言处理能力,一般人看过一篇哪怕几千字的小说,不故意去花大量时间精力背的话,也并不能一字不落地记住每段话,相反记住的只是精彩的情节、某些你也不知道什么原因就记住的要点。人类拥有一套进化优化过的、对从短期到长期的信息有所区分筛选的记忆系统,各种外部刺激和内在状态会影响记忆的效果,甚至有一些虚假记忆,但这一般对人的生活来说并没太大的影响。为了更好更快地记录历史信息、进行复杂推理:人一般就是有损地记忆信息,自主或不自主地“衡量”了信息的重要性,意识能控制的最多是多记几遍、想办法进行各种关联;但凡有可能,人类不会仅依赖自身的记忆、不会只在脑海中思考,而是会借助各种工具,利用笔记、书籍、影像记录等较客观地记录重要历史信息,利用笔纸演算、计算模型、控制变量的科学实验等等在进行推理。有必要时,如果自己搞不定,还会和他人交流求助合作,人类社会现有的所有科技、制度、文化艺术等成果,都不是一蹴而就的,是大量通用智能体合作交流,并不断在现实世界实践交互的结果。所以,为什么人工通用智能(AGI)一定要在其内部直接记住所有历史信息、一定要在内部直接进行复杂推理?题主所说“重复之前的所有内容”的任务,依靠内在状态的模型可以靠加上存储所有历史的模块并将之作为工具使用来实现,甚至可能效率更高。 实用的小型化通用智能系统,需要有灵活地生成和整合长时记忆的能力、以及内在世界模型(灵活的理解、想象、推理能力)。拥有有效的记忆和推理能力,就可以摈弃现有LLM中不必要的二次方的计算要求,减少记忆资源需求。目前的LLM主要以自回归过程为实现手段,将所有历史存储在计算内存中,没有对AI模型(神经网络)内部记忆系统的要求。但为什么最先做出效果的是记忆资源要求较小的文本数据,而不是图像数据?当然有得益于语言对人的高信息密度特性,图像中的有效信息密度很低,就是说对人来说的同等信息量时图像数据会大很多倍,如果不加区分地直接全部存储、使用时全部用在实时计算中,至少在当时的技术水平下,可能难以实现短期内训练出有效的同等规模视觉大模型,现在含视觉的多模态大模型也仍然存在诸多问题。“二次方”的计算资源要求,导致了LLM长下文长度限制、以及对长度外推机制的需求。Sora的计算资源要求估计、Altaman的7万亿言论,都在说明这种方案巨大的计算和存储资源需求,它们在现实的应用场景中不一定能满足,比如自由移动的机器人会有电源限制,本地调用云端计算的模式在不能联网时也会出问题,所以答主推断:未来在实际应用场景中,具有内部状态的神经网络模型可能会超越现有的基于所有历史进行自回归的Transformer方案。 答主一直有希望AI系统直接通过内部的神经网络去存储记忆的一点执念,但也相信:只要计算系统的存储能力允许,那么直接记录下所有原始的文本、视频等信息作为客观对照,应该还能有利于AGI调试。目前以RAG为代表的辅助技术正在扩展LLM的记忆更多信息的能力,应该能有一些进步,希望未来能在现有LLM技术框架下也发展形成一套更好的长期记忆系统。 欢迎各种形式的交流和批评指正。 【1】Ackerman, S. (1992). The Development and Shaping of the Brain, In Discovering the brain. 【2】人的神经元数量在6岁之后基本就不变了,有没有可能是外界环境变化的影响? 【3】Wall?e, S., Pakkenberg, B., & Fabricius, K. (2014). Stereological estimation of total cell numbers in the human cerebral and cerebellar cortex.Frontiers in human neuroscience,8, 508. |

|

不是没有可能,但是需要一个比较solid的工作来证明和推动。 举几个例子。 扩散模型很早就有了,但是在图像生成领域,GAN处于统治地位。直到OpenAI相继推出GLIDE和DALLE2,以及开源的Stable Diffusion,扩散模型一下子火了起来,而GAN反而成了昨日黄花。如果现在你去问选什么架构做图像生成,几乎都会推荐你用Diffusion,而不是GAN。 GPT-1最先出来,但是后面谷歌的BERT压了它一头,当年在自然语言处理领域,BERT可谓红极一时,但是后面OpenAI相继推出GPT-2,GPT-3以及现在的ChatGPT,decoder-only的GPT成为了大家的共识,而BERT已经被逐渐遗忘。 所以,我觉得后面出现压GPT一头的架构一定是必然的,但是需要有一个比较牛的工作来推动。比如之前大家一直用经典的DDPM,现在比较SOTA的SD3用了Rectified Flow,后面基于Rectified Flow也会慢慢火起来。 文生图之SD3:迈向transformer时代79 赞同 · 9 评论文章 目前看RWKV和Mamba虽然有一些进展,但是我感觉没那么让人惊艳,所以还是先观望一阵吧。 |

|

Mamba 和 RWKV 這類的模型本質上是 Linear RNNs。Transformers 自從 2016 年提出以來,打敗了諸如 ConvS2S 此類的 Non-linear RNNs,成為 NLP 領域的統治模型。如果 Mamba 和 RWKV 這類的模型能超越 Transformers,這意味着 Linear RNNs 比 Non-linear RNNs 還要強大。我最近一直困惑的是,如果 Linear RNNs 真的那麼強大,爲什麼上個世紀成爲主流 RNNs 的模型是 LSTM?畢竟 Linear RNNs 比 Non-linear RNNs 的一大優勢就是參數量相對較小,還可以並行運算。如果 Linear RNNs 的性能還很強,那麼 Linear RNNs 簡直就是理想型模型。有點跑題了,我懷疑 Linear RNNs 可能藏有某種缺陷,可能可以勝任時序任務,但是在 NLP 領域還是得靠 Transformers。另外,現在 Non-linear RNNs [1] 也可以並行運算了,或許 RNNs 的時代又回來了。 [1] Yi Heng Lim, Qi Zhu, Joshua Selfridge, & Muhammad Firmansyah Kasim (2024). Parallelizing non-linear sequential models over the sequence length. In The Twelfth International Conference on Learning Representations. |

|

民族主义版:RWKV是中国的,Transformer是美国的,怎么无法战胜?不要长他人志气,灭自己威风。 科研版:以RWKV为代表的线性大模型依然有很多改进可以做,有很多内容可以研究。而transformer的核心组件基本是在2022年左右就都已经提出来了。 大厂版:选择技术成熟稳定的transformer,没有技术风险,无需探索,可以快速完成业务指标。 未来版:两类模型会共存,RWKV作为一种新型rnn,天然适合很多序列场景。两类模型各有特色,根据场景选择。 |

|

|

RWKV和Mamba等递归模型能否击败Transformer?最近发布的Eagle 7B就是基于RWKV架构的。Eagle 7B 是一个 7.52B 大语言模型,它不是基于 transformer 架构,而是基于 Recurrent Neural Network (RNN)RWKV-v5构建的7B模型(推理成本降低 10-100 倍+的线性变压器),也许是更高效、更可扩展的架构,可降低人工智能成本,并减少对环境的影响。与 Mamba 一样,它是无注意力的,这加快了推理过程,并允许更长的上下文窗口。感兴趣可以访问如下文章: Eagle 7B:最多语言基准测试超越所有7B模型,最环保的7B模型3 赞同 · 0 评论文章 而Mamba很热门,曾经被认为要取代Transformer,但论文最终没有被accepted。目前来看,两者都没有表现出取代Transformer的态势。 RWKV模型通过结合RNN的时效性和Transformer的并行计算能力,试图在模型训练速度和推理效率方面实现最佳平衡。RWKV利用时间衰减因子作为注意力机制的一种形式,并通过参数化的通道混合模块来增强模型的能力,这使得其在某些任务上表现出色 。RWKV在不同上下文长度和模型大小的情况下展示了一定的性能提升,尤其在训练速度上比GPT快,显示出“1 + 1 > 2”的效果 。 Mamba模型则尝试通过状态空间模型(SSM)来解决Transformer在处理长期依赖和大规模数据时的局限性。Mamba通过使用时变SSM,不但在语言、音频和基因组学等多种模态中达到了最先进(SOTA)性能,还显示了在处理复杂任务(如复制和归纳等)和长序列数据上的优势 。Mamba模型的设计理念在于利用状态空间来表示和处理序列信息,这种方法在某些情况下能够提供比传统Transformer更高的性能和效率。 然而,尽管RWKV和Mamba在某些方面显示出了优越性,但它们是否能完全取代Transformer还有待观察。Transformer模型由于其广泛的应用、成熟的生态系统和持续的改进,依然在许多领域保持着主导地位。RWKV和Mamba面临的挑战之一是如何保持模型的长期记忆能力而不失效率,尤其是在处理非常复杂的序列任务时。此外,这些模型的有效性也依赖于特定任务和数据集 。 RWKV和Mamba等递归模型在解决Transformer的某些限制方面展示了潜力,尤其是在训练效率、处理长序列和多模态任务方面。然而,这些模型是否能够在所有方面超越Transformer,还需要进一步的研究和验证。在深度学习领域,技术的进步是迭代的,新的模型架构和优化技术不断推动着整个领域的发展。因此,未来可能会有更多的模型出现,进一步推动或颠覆现有的模型架构。 |

|

|

|

|

|

|

|

信mamba,不如信rwkv真的。普通人别碰mamba |

|

不能,因为transformer包括encoder和decoder,而线性rnn只是一种decoder。视觉领域,现在还是cnn和vit的主场,没有rnn什么事(捂脸)。 言归正传,回到技术层面,我发现大家似乎都不太区分线性rnn和线性attention。 严格来说,线性attention才是传统attention的竞争对手(包括encoder和decoder),而线性rnn其实是attention + causal mask的竞争对手。 当然,因为大语言模型的成功,现在大家更关心decoder only模型。至于大语言模型为什么采用decoder only的架构,有兴趣的小伙伴可以参考我之前的一篇回答。 为什么现在的LLM都是Decoder only的架构?74 赞同 · 5 评论回答 回到线性rnn和线性attention的区别。 首先,线性rnn里的线性指的是去掉传统rnn中的非线性依赖,从而支持并行计算(卷积或者parallel scan);线性attention里的线性指的是去掉softmax,从而降低原来序列长度平方的计算开销。 尽管两者的出发点不同,在decoder架构的背景下,线性attention + causal mask可以表达成线性rnn的形式,只是状态空间从以往的向量变成了矩阵,可以看成是一种扩大状态空间的做法。 关于线性rnn状态空间大小带来的局限性,大家可以参考我另一篇回答。 目前是否有挑战Transformer的新型架构?24 赞同 · 17 评论回答 以RWKV(线性RNN)和RetNet(线性attention)为例,两者都是通过rnn的方式对kv cache进行压缩,然后用q从中检索信息。 如果不考虑指数衰减、归一化等技巧,前者压缩的是exp(k)和v元素相乘得到的向量,而后者压缩的是k和v外积得到的矩阵。前者通过q进行元素相乘来检索信息,后者通过q进行矩阵向量乘来检索信息。 所以,线性attention + causal mask是一种特殊的rnn,可以分享线性rnn中用来涨点的技巧,例如门控机制,感兴趣的小伙伴可以参考 @sonta 的GLA论文。 目前看来,线性attention相比线性rnn,有以下几个优势。第一,线性attention的状态空间更大,可以缓解压缩序列信息的压力。第二,线性attention的算子实现可以采取chunkwise的做法,局部使用矩阵乘法。第三,线性attention可以保留多头注意力的设计,方便张量并行。 最后,这篇回答并没有拉踩线性attention和线性rnn的意思,因为两者的技术路线非常接近,并且有相互收敛的趋势。 最近的工作甚至还会加上滑动窗口注意力,来提高模型在recall任务上的表现。可谓是,三个臭皮匠,顶个诸葛亮(捂脸)。 另外,作为它们竞争对手的attention实在过于强大。要知道,基于attention的大语言模型已经成功将序列长度扩展到1M的量级。 对attention如何在系统上进行序列并行感兴趣的小伙伴,可以参考我之前的一篇回答。 Megatron-LM 中 Context Parallel 的工作原理是什么?37 赞同 · 10 评论回答 这么看来,追求scaling的人们,并不太在意当前系统昂贵的开销,正如他们所相信的:It is easy to make a smart model cheaper. It is hard to make a cheap model smarter. |

|

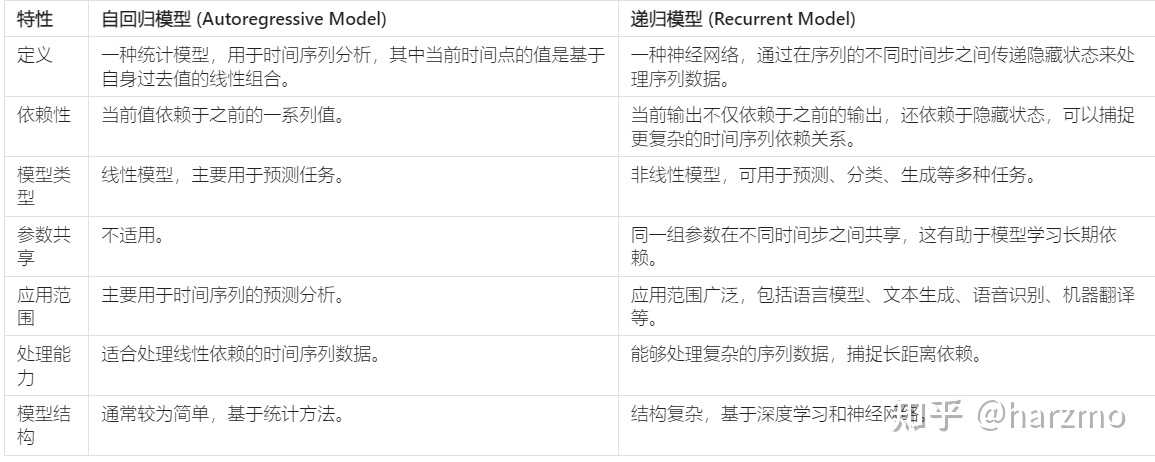

我们先回答为什么选择性 SSM 以及 Mamba 架构的扩展是完全递归模型? 递归模型(Recurrent Model)是一类用于处理序列数据的神经网络,它们通过在模型的不同时间步之间维护一个或多个内部状态来处理序列。这些内部状态允许模型“记住”之前的信息,并将这些信息用于当前和未来的决策。最典型的递归模型例子是递归神经网络(RNN)。 所以选择性SSM和Mamba架构之所以被视为递归模型。 内部状态的维护:类似于传统RNN,这些架构通过维护一个状态(或多个状态),在模型的不同时间步之间传递信息。这使得模型能够在处理当前输入时,考虑到之前的上下文信息,从而实现对序列的动态处理。自回归性质:Mamba和其他选择性SSM架构通常采用自回归(autoregressive)方式生成序列,即在生成当前元素时依赖于之前的元素。这种依赖于先前状态的生成过程本质上是递归的。逐步处理序列数据:这些模型能够逐个时间步处理序列数据,并在每一步更新其内部状态。这种逐步处理和状态更新的过程是递归模型的典型特征。长期依赖能力:与传统的RNN相比,选择性SSM和Mamba架构通过更高效的状态管理和更新机制,能够捕获长期依赖关系,这对于处理长序列尤其重要。它们通过精心设计的机制(如选择性状态空间)优化了信息的保存和忘记,使模型能够在保持效率的同时,处理非常长的序列。 注意这个2自回归性质!!!!同时注意自回归和递归的区别,自回归模型的核心特性是当前时刻的输出依赖于之前一个或多个时刻的输出,我们并没有说必须依赖所有时刻。 |

|

|

好回到主题,自回归的Transformer(attention机制是核心)(目前的主流LLM思路),尽管transformer提供了较好的并行训练,但是attention+自回归就导致了推理缓慢:训练阶段:可以并行处理。由于Transformer在训练时可以接收到整个输入序列,因此可以同时计算序列中所有位置的自注意力。这使得训练过程相对高效。推理阶段:必须序列化处理。在生成文本或其他序列化数据时,每生成一个新元素,就需要考虑到之前所有生成的元素。这意味着在生成每个新元素时都需要重新计算注意力,导致推理速度相对较慢。(kv cache技术缓解推理慢的问题)那么为什么并行的Transformer遇上递归的自回归推理的时候就必须考虑之前所有的时刻呢? 首先,自回归不一定需要计算之前所有时刻,但是transformer自身设计的时候就是计算所有序列的attention。最初的设计可能并没有考虑到未来推理需要处理超长上下文时间效率的的问题,当然通过一些改进例如kvcache等也可以缓解这个问题,并不是无解的。 其次,自回归Transformer模型在处理例如文本生成等序列任务时,依赖之前所有时刻的输出主要是因为它们利用全局自注意力机制来捕捉序列中的长距离依赖。这种设计选择反映了Transformer架构的一个核心优势:能够直接计算序列中任意两个位置之间的关系,而不受它们距离的限制。 生成连贯性:为了生成语法正确、逻辑连贯的文本,模型必须考虑整个已生成文本的上下文。这包括近期生成的词汇,也包括更早之前生成的内容,确保新生成的文本部分能够和之前的文本自然衔接。长距离依赖问题:语言中经常存在需要跨越长距离复杂的依赖关系,其中当前的输出可能与序列中相当遥远的部分相关。全局自注意力机制使得模型能够直接考虑这些长距离依赖,而不是仅依赖于近期的历史。比如代词的指代关系可能需要参考很早之前提到的名词。自回归Transformer通过利用之前所有时刻的信息来解决这一问题,确保生成的内容在语义上的准确性和完整性。保持全局一致性:在生成复杂的文本结构时,需要保持主题或叙述的一致性,这可能要求模型理解并考虑整个文本的上下文信息。这包括不仅是最近几个词或字符的信息,也包括更远处的信息,以确保生成内容的连贯性和语境相关性。自回归模型通过引入之前所有时刻的输出,有助于维持整体的一致性和上下文的相关性。 最后,虽然并行处理在训练阶段大大提高了效率,但在自回归模型的推理阶段,由于每一步的输出都依赖于之前所有步骤的累积输出,这就使得推理过程变为逐步和序列化的。为了生成下一个输出,模型需要重新考虑包括最新输出在内的所有先前信息,以确保生成的连续性和准确性,从而导致transformer的并行优势因为自回归的原因在推理时无法充分发挥。 而非自回归Transformer模型(如vit)在通过一次性生成所有输出或者通过其他方法减少对先前元素的依赖,以提高推理速度。这些模型试图在保持生成质量的同时,减少生成过程中必须序列化处理的步骤数,从而加快推理速度。视觉任务中使用的许多Transformer模型并不是基于自回归的设计,所以它们不会因为自回归带来的序列化处理而导致推理过程缓慢。这些模型包括但不限于视觉Transformer(ViT)和其他基于Transformer的结构,它们在处理图像分类、目标检测、图像分割等任务时通常采用非自回归方式。 那么视觉Transformer(ViT)/非自回归Transformer模型的特点,以及他们推理速度需落后mamba吗?:并行处理能力:在推理阶段,由于模型不依赖于先前的输出来生成当前的输出,因此可以并行处理输入数据,大大提高了处理速度。全局注意力机制:这些模型利用Transformer的全局注意力机制来捕捉图像内的全局依赖关系,而不是顺序地生成图像的每一部分,这对于理解复杂的视觉场景非常有效。适用于多种视觉任务:非自回归Transformer模型被广泛应用于多种视觉任务,如图像分类、目标检测、图像分割等,展现了极好的灵活性和性能。 一方面,在视觉任务中,vit的全局自注意力机制本身对于上一代架构CNN在捕捉长距离依赖方面的限制是一个极大优势,特别是在处理大规模数据集和构建大型模型时。但现在来看cnn就没用了吗,如下大卷积核的设计也在统一着多模态模型。到目前都不敢说transformer完全击败了CNN,因为在视觉任务上尤其是医学图像分割任务,cnn表现还是优于transformer,所以谈mamba击败transformer为时尚早。 一方面,于这些非自回归的视觉Transformer模型,推理速度主要受限于模型大小、输入数据的分辨率以及硬件性能,而不是像自回归模型那样受限于序列化处理的需要。所以mamba扩张上下文,推理速度这一优势并不存在。而其他的优势例如精度,对于视觉任务暂时也并不明显,所以也谈不上"真的击败transformer"。 |

|

|

RNN:最适合处理具有时间序列特性的数据,例如语音识别、股票价格预测等。其在处理较短的序列数据上效果较好,但在处理长序列数据时,由于梯度消失或爆炸问题,性能会受到限制。Transformer:由于其强大的全局上下文捕获能力和并行处理能力,特别适合于需要大量上下文信息的任务,如机器翻译、文本摘要 大核卷积一统多种模态!RepLK正统续作UniRepLKNet:ImageNet 88%,时序预测SOTA,极简高效! - 知乎 (zhihu.com) (23 封私信 / 3 条消息) 如何理解 Mamba 模型 Selective State Spaces? - 知乎 (zhihu.com) 最新模型VMamba:颠覆视觉Transformer,下一代主流Backbone? - 知乎 (zhihu.com) Mamba详细介绍和RNN、Transformer的架构可视化对比 (qq.com) |

|

隐式大卷积核将统治未来架构 Convolutional neural network will be great again! 在2022年我就意识到,上世纪的RNN LSTM CNN的设计受限于计算资源。如今情况得以改善,自然基础架构要升级。从transformer和CNN的不同就能体现出来。 然而,如果计算资源再进一步增大,那么未来的网络架构会是什么样?人与AI machine的关系将会如何? 回到问题,单纯击败transformer并不能带来真正的变革hh 2016 DeepMind AlphaGo -> 2023 OpenAI ChatGPT -> 2030 ? ? |

|

你会觉得,RWKV和Mamba等递归模型(recurrence models)更像是人脑的机制,它会有意忽略掉一些,有意记住一些。 同时又能在有相关信息的提示时,唤醒一些从前被忽略的长期记忆。 这当然是好的。但是,为啥感觉,现在市场上还是 Tansformer 更受关注呢? RWKV和Mamba等递归模型(recurrence models)的确先进 RWKV(Receptance Weighted Key Value)虽然在某些方面与传统的Transformer模型有相似之处,但它并不是一个纯粹的Transformer模型。 RWKV是一种结合了Transformer和RNN优点的新型深度学习网络架构。它实现了高度并行化的训练与高效推理,具有线性时间复杂度,在处理长序列时表现出优于传统Transformer的性能。 RWKV模型的关键创新在于其注意力层,这是它与传统Transformer模型的主要区别。在RWKV中,自注意力(self-attention)被替换为位置编码(Position Encoding)和TimeMix,而前馈网络(Feed-Forward Network,FFN)被替换为ChannelMix。这些改动使得RWKV在保持Transformer高效并行训练的同时,也能够在推理时保持较低的计算和内存复杂度。 因此,RWKV可以被视为一种对Transformer架构的扩展或改进,它借鉴了Transformer的设计思想,但通过创新的方式解决了Transformer在长序列处理上的一些局限性。尽管RWKV保留了Transformer的一些核心概念,如使用嵌入层、层归一化(Layer Normalization)和因果语言模型头,但它的注意力机制和网络层的实现与传统Transformer有所不同。 这一点很重要很重要,因为人类使用 AI 的趋势就是“一点脑子不想动,越来越懒并且越来越依赖”。 所以,如果不能解决好越来越长的序列问题,早晚 Transformer 模式的产品会被用户需求拖垮。 整个 AI 行业最终的假设是“算力和能源便宜的不要不要的”,但这终归是假设。 先说 RWKV RWKV模型通过其独特的架构设计,能够在保持状态大小恒定的同时,有效地处理长序列。这种设计允许模型在每个时间步更新其状态,以包含最新的信息,同时丢弃不再需要的历史信息。这种机制使得RWKV在处理长序列时,能够保持较低的计算复杂度,这对于资源有限的环境尤其重要。 然后说 Mamba Mamba模型则采用了选择性状态空间模型(SSM),它允许模型根据内容动态地过滤和处理信息。这意味着Mamba可以在处理长序列时,只关注对当前任务最相关的信息,从而提高效率。Mamba的性能在某些任务上已经超过了基于LLaMa的模型,显示出其在处理长序列方面的潜力。 然而, 尽管这些递归模型在理论上具有处理长序列的能力,但在实际应用中,它们是否能够完全“击败”Transformer模型还需要考虑多个因素。 Transformer模型在许多NLP任务中已经取得了显著的成功,其并行化能力和易于扩展的特性使其在工业界得到了广泛应用。 这个并行化能力和易于扩展的特性,就是行业里经常说的Scaling laws,这样它就比较容易商业化,资本就容易和技术相互结合,我就知道,投入了多少钱(或者多少算力), 我就能提高多少模型性能、花费多少训练时间、或者提供多少资源消耗,就能对模型大小或参数数量,产生多大的影响,也能把数据量和任务复杂性等因素之间,建立一个有数学规律的模型。 或者,更直白一点的说,Tanrsformer 模型更容易整合好供应链,更适合卖显卡,更能适应资本市场的潮汐规律。 而递归模型虽然在理论上有优势,但在实际应用中可能面临训练难度大、泛化能力不足等问题。 一旦训练难度大、泛化能力不足,他就只能少数精英公司和精英技术人员才能玩儿,卖不了多少显卡,还非常容易在买方市场产生“价格卡特尔”(cartel)。 而且,对于复杂的任务,如需要重复之前所有内容的任务,递归模型可能面临挑战。这类任务通常需要模型具有强大的记忆能力,而递归模型的状态大小是恒定的,这可能限制了其在这类任务上的表现。 上面提到了,它之所以能“记忆的效率和成本很高”,就是因为它原则放弃一部分。 然而,这并不意味着递归模型无法处理这类任务,而是可能需要特定的设计和优化来提高其在这些任务上的性能。 总的来说,RWKV和Mamba等递归模型在处理长序列方面展现出了潜力,但是否能完全超越Transformer模型还需要更多的实证研究和实际应用来验证。 在实际应用中,选择哪种模型往往取决于具体任务的需求、资源限制以及模型的可扩展性等因素。 更重要的是,这一轮 Tanrsformer,是资本市场的推动,而下一轮是什么,谁知道呢? |

|

RWKV和Mamba等recurrence模型在处理特定任务上可能会表现出色,尤其是在处理具有长期依赖关系或序列记忆需求较高的任务时。它们的状态机制允许在序列中保持一定程度的记忆,并在后续推理中使用。然而,对于更复杂的任务,如需要处理大量历史信息或要求长期记忆的任务,这些模型可能会受到限制。相比之下,transformer模型在处理长序列和复杂任务时通常表现较好,因为它们利用了自注意力机制来处理序列中的长距离依赖关系,而不受固定大小状态的限制。因此,对于不同的任务,选择适合的模型取决于任务的特性以及所需的记忆和推理能力。 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |