| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> 如何看待谷歌 DeepMind 创始人称,「 OpenAI 只是依靠规模突破,并无原生创新」这一言论? -> 正文阅读 |

|

|

[科技知识]如何看待谷歌 DeepMind 创始人称,「 OpenAI 只是依靠规模突破,并无原生创新」这一言论? |

| [收藏本文] 【下载本文】 |

|

“OpenAI所做的只是拿走了人工智能的想法,遵循硅谷的增长思维(growth mentality)去做规模化,这很有趣,他们自己可能也没想到会有突破… |

|

Demis说的没错。 这其实是个几年前的历史问题,也是大语言模型的根基问题。被描述为Scaling Law (Dario的说法),或者Scaling Hypothesis (Demis的说法) 你可以从这两个词的用法,就知道信仰的坚定程度。 你现在去看90后00后研究员,对大语言模型的大已经习以为常,已经进入Farming/Roll装备的阶段。而像ilya,Dario,Demis这些70后,80后研究员,他们处于从无到有的AGI副本开荒阶段。Scaling Law是ilya和Dario最为自豪的发现,他们对自己顶着OpenAI内部的质疑,把这套坚持下来的开拓精神充满自豪感。 Demis把称之为实证/实验,而不是优雅的结构设计,不是先发明了算法理论,而是先发现了“现象”——这在计算机这种至始至终由人类掌控的领域中,是很少见的“现象”。 暴力不符合Demis优雅的英吉利之魂,Demis认为AI的智力可能与大脑的结构非常相似,这里存在着一个Demis的暗示:我们对AI的研发水平可能与我们对大脑的理解水平是同步的。 但OpenAI说:No,暴力=智力,这就是Law 扩大规模=智力涌现? 即使在OpenAI内部在早期也只有ilya和Dario这种有极高技术直觉的人,才相信这一套“歪理邪说”。这也就是Demis所说的,即使最早研究Scaling的人,也很少有人相信这种“规则”。 我相信大部分人的直觉都是一样的,包括Demis,就是吃什么补什么。训练A就知道A,训练B就知道B,但ilya和Dario在非常小规模的模型中,似乎感觉到这些语言模型,训练了AB之后,还会知道A1B1,A2B2…… (当然,训练AB是不会知道CD的) 我们当然知道7B模型和70B模型的区别,但在非常小规模的时候,比如说<1B时,你能感觉出来区别吗?这就是技术的直觉。 这些东西与其说是发明创新,不如说是发现了什么,发现这个“神之bug”之后,OpenAI就开始了疯狂的规模化利用“bug”的道路,Dario应该也是明确了这个Law是有效的,才大摇大摆,自信满满地离开OpenAI,创立了Anthropic。 Demis说的没错,这不是很优雅,非常不英吉利。我想大概ilya有战斗民族之魂,Dario有南欧人奔放之魂。 Demis拥有很强智力优越感,他相信自己可以构建一套模拟大脑运作的顶层算法,来实现AGI,而不是这种上不了台面的投喂机制。 但他现在也直呼:Scaling,香还是香的,我们也在不遗余力地扩大模型,但我们依然在研究新模式和新算法。 我们可能认为OpenAI充满了创新,我们的看法是对的,因为我们是平凡人。 但在现代AI元祖Google和Deep Mind看来,OpenAI那是整的啥玩意儿,就是吞噬算力巨兽罢了。优雅在哪里? ilya:并不需要优雅,战斗就完事了。 你可以看出Sam Altman 现在的暴力作风: 海量的合成数据(GPT,Sora)+行星级算力(7万亿芯片计划) 没有数据量和算力解决不了的事,如果有的话,再给我来一万倍。 说好听点就是《山姆奥特曼の野望》,说难听点就是路径依赖。 我非常肯定,Sam打心眼里崇拜ilya这样拥有的战斗之魂的人。 我一直觉得Demis和Sam是AI届的金童玉女,他们相爱相杀的故事才刚刚开始。 (为什么Demis是金童,因为他从小就是天才,为什么Sam是玉女……好吧,话题到此为止) |

|

|

ilya,Dario,Demis |

|

|

来自Demis最新出炉的采访录,99.99%的人还没看过 |

|

在几年前能把模型扩大到1750亿本身就很难。而且OpenAI不可能只靠规模创新,肯定有很多训练和微调方法,只是不公开技术细节,所以一直领先其它LLM。ChatGPT是个产品,从用户的输入到生成的输出背后估计不只是由LLM直接生成,还有很多其它后处理方法以及在inference阶段增强performance的技巧,这些技术细节OpenAI已经研究了几年,别的公司再去追赶很难了。 Google也挺难受的,一直保持技术领先而且开源,忽然就被反超了。如果Google藏着transformer和BERT,NLP和AI领域估计也没有这么快的发展。 |

|

Scaling Laws不是创新吗? |

|

|

OpenAI在2020年的一月份发表了这篇论文,它得出来这么一个结论。 We study empirical scaling laws for language model performance on the cross-entropy loss. The loss scales as a power-law with model size, dataset size, and the amount of compute used for training, with some trends spanning more than seven orders of magnitude. Other architectural details such as network width or depth have minimal effects within a wide range. Simple equations govern the dependence of overfitting on model/dataset size and the dependence of training speed on model size. These relationships allow us to determine the optimal allocation of a fixed compute budget. Larger models are significantly more sample efficient, such that optimally compute-efficient training involves training very large models on a relatively modest amount of data and stopping significantly before convergence 中文版: 我们研究了语言模型在交叉熵损失上性能的经验性缩放律。损失以幂律形式随模型大小、数据集大小以及用于训练的计算量进行缩放,其中一些趋势跨越了七个数量级以上。其他架构细节,如网络宽度或深度,在广泛的范围内影响甚微。简单的方程描述了模型/数据集大小对过拟合的依赖性,以及模型大小对训练速度的依赖性。这些关系允许我们确定固定计算预算的最优分配。更大的模型在样本效率上显著更高,因此,最优的计算效率训练涉及在相对适量的数据上训练非常大的模型,并在完全收敛之前显著停止。 简单版本: 研究语言模型学习的时候会用一个标准(称之为交叉熵损失)来评价其性能,这个性能的变化会跟几个因素有关系。想象一下,如果有一个更大的模型(就像是一个更大的脑袋),或者我们用更多的数据来训练它,又或者我们用更多的计算资源来支持它学习,这个模型的表现会怎么样呢?他们发现,模型的表现(或者说损失)会按照一种特定的规律改变,这个规律就像是数学中的幂律关系,意味着变化非常大,可以达到超过七个数量级。但是,模型里其他的一些设计选择,比如它有多宽或者多深,在很大程度上影响不大。 再简单一点儿,OpenAI提出的这个定律,证明了在大语言模型的范畴里,模型大小、数据量大小、计算资源的大小这三个只要同等比例增长,那么模型的性能就越好。 这在以前是不被理解的,因为大家都在追求模型上的美,这种结论就像是跟你说,人有多大胆,地有多大产似的。 但OpenAI牛就牛在,它提出了定律,还亲自去实践,然后ChatGPT出现了。 并且你知道吗,带有Laws是什么概念,你看物理学的laws就知道了。 |

|

|

|

|

最近参与了一些讨论,很多人都提出了这样一个问题,力大砖飞本质上靠的,还是互联网上的数据,那万一这些数据本身有bias怎么办?比如一道非常刁钻的量化面试题,可能网上论坛一百个讨论的人里面99个的答案是错的(而且这些错误回答往往还拿高赞)那让llm学,十有八九是学到了那些错误的答案,然后吐出来,然而让懂统计的人来看,他们一眼就能发现那个正确答案。 那么问题来了,有可能通过人类标注和AI标注来找出来那些正确答案,然后喂给AI么?很可惜的是,以现有的资源几乎做不到。更可行的还是,让AI在训练的时候自己学会甄别正确的信息和错误的信息。 想象一下人是怎么学习的,如果从一开始就把三三得九和庞加莱猜想的证明一股脑喂给一个人,那大概率这个人会被训成智障。大家都是从基础的东西开始学,建立了基本的认知能力,然后再去学更高阶的东西。换成AI也一样,应该先通过一些基础的数据来训练,建立起来对这个世界的认知,然后再基于这个基础认知来接收和消化更复杂的训练数据。 很可惜,现在的LLM结构做不到这一点,哪怕你先喂给他大学统计的书,再喂给他那个充满了错误回答的量化面试题讨论,它无法基于前面的知识去否定后面的错误回答。除非人为把统计书upsample个一百遍,这样可能能够压制论坛错误讨论的noise,但要是加入这么多主观的heuristics就变成了无穷无尽的长尾效应,离AGI更远了。 这是一个急需原生创新的点。 |

|

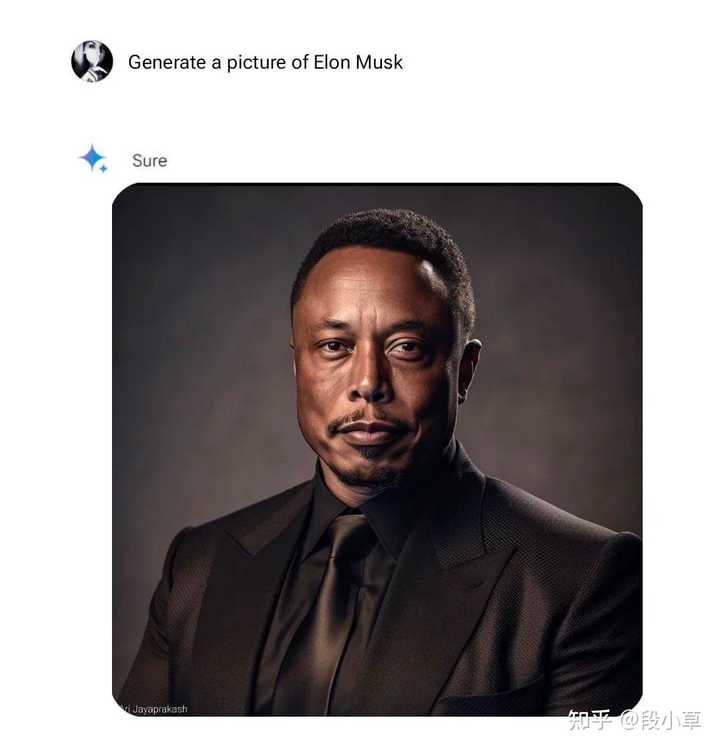

Demis 这次对 OpenAI 的评价,我觉得有一定的道理,但 Google 也别喊冤,如果 OpenAI 真的没有核心竞争力,那为什么一年多了,仍然没有超越 ChatGPT 的产品出现?反而 Gemini 这边一堆恶评。这其实是两个话题:一个是技术,一个是产品。 核心问题在于:当一项新技术、一个产品存在致命缺陷的时候,如何确定何时应该推向 toC 市场? 从产品层面说,OpenAI 有一定运气成分。大家显然对 OpenAI 和 ChatGPT 的容忍程度是高于 Google / Meta 的。OpenAI 并不是第一个推出聊天机器人的,但之前的大都失败了[1]: ——2016 年微软在Twitter上推出名为Tay的对话机器人,16小时后就因其厌女和种族主义言辞而被迫关闭; ——2022年11月,Meta发布Galactica,在公众测试后三天,就因大量有偏见和无意义的文本关闭。 |

|

|

某种程度上说,不论是 LLMs 还是文生图,幻觉是不可避免的。但当出现同样问题的时候,大公司显然更容易陷入舆论旋涡。这也许有点双标——ChatGPT 犯错,大家说是幻觉,是技术缺陷;Meta 和 Google 犯错,大家说是种族歧视,是别有用心。 这也是 Demis 这次说的「Google 原本认为这些系统在发布前需要提高 100 倍的准确性」。 但反过来说,OpenAI 在 AI 安全方面的确下了功夫,在 GPT-4 发布前花了半年时间调试,甚至在发布后也很大程度上阉割了 GPT-4 的智能,我们至今不知道 Ilya 在 OpenAI 究竟看到了什么。 所以我觉得这也是 Google 要承认的 —— GPT 确实很强;OpenAI 的安全过滤确实做的更好,不至于犯下像 Gemini 那样的致命错误。 另一个角度,不妨想想,Google 为什么最近在 AI 方面、在国内国外都被拿来嘲讽?——Gemini 语料抄百度,这基本是实锤;Gemini 画图有种族偏见,现在已经紧急撤下了画人的功能。 |

|

|

换句话说,OpenAI 的成功的确归功于「力大砖飞」的 Scale Law,但绝对不仅仅是 Scale Law。如果 Google 到现在都觉得靠堆算力堆数据能打平甚至胜过 GPT-4,那肉眼可见的迎接他们的是下一次失败。 顺便找了找原文,哪怕是财新的报道。同样的一篇谈话,外媒大都在写 Gemini 最近的图像生成问题,几乎没有以嘲讽 OpenAI 作为标题的。 |

|

|

在 MWC 2024(巴塞罗那通信展)期间,Google DeepMind CEO Demis Hassabis 参与了对话[2],谈论了 AGI 和 Google 如何在 AI 竞赛中输给 OpenAI 的话题,以下是外媒的记录[3]: 其中关于 OpenAI 的部分: 过去十年中大部分重大 AI 创新都源自 Google Research、Brain 和 DeepMind。而 OpenAI 采取了这些理念和技术,并“应用了硅谷的增长心态和黑客精神,将其发展到极致”。 OpenAI 的模型成功并非来自于创新的突破,而是通过扩大现有创新的规模。 我认为没有人预见到这一点,可能连他们自己也没想到,这些新能力仅仅通过扩大规模就显现出来,而不是通过某种新创新。在大多数科学技术领域的历史中,通过做同样的事情但规模更大来实现技术飞跃是非常罕见的。通常情况下,你只能获得渐进式的进步,而通常需要通过某种新的洞见或突破来实现真正的飞跃。但这次并非如此。 令人惊讶的是,对于 ChatGPT,“尽管存在明显的缺陷——幻觉、缺乏事实性——公众似乎已经准备好接受这些系统。” Google 原本认为这些系统在发布前需要“提高 100 倍的准确性”,但 OpenAI 的发布证明了“数百万人发现这些系统有价值”,他补充说。“它们并不需要 100% 准确就能找到有价值的应用场景,这对整个行业来说都是一个惊喜。” Hassabis 还提到,他们原本认为这些系统将主要适用于科学家和特定专业人士。但实际上,“普通大众愿意使用这些稍显粗糙的系统,并在其中找到价值和应用场景。因此,这促使 Google 改变了看法。” 这导致 Google 在 2023 年 4 月将 Google Brain 与 DeepMind 合并,目标是“整合我们所有的计算资源和工程人才,共同打造可能的最大创新。”他说。“Gemini,我们最先进、最强大的 AI 模型,就是这种整合的成果之一。” 参考^https://new.qq.com/rain/a/20230303A03F1100^https://www.mwcbarcelona.com/agenda/speakers/11800-demis-hassabis^https://aibusiness.com/nlp/google-deepmind-ceo-on-agi-openai-and-beyond-mwc-2024 |

|

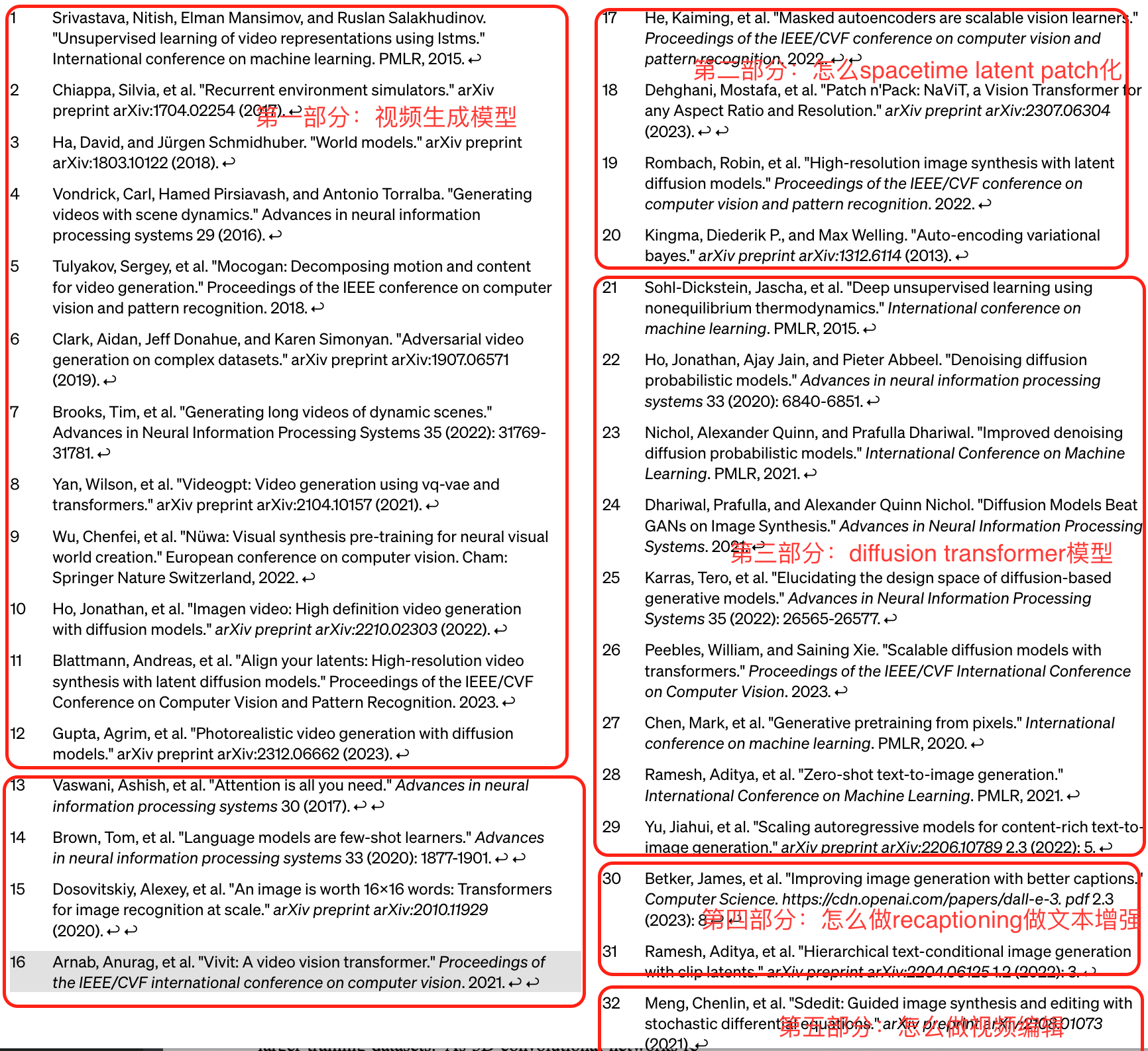

Sora从技术报告来看,确实没有原创性的创新,绝大部分内容都是在强调一件事: we find VAE/ViViT/NaViT/DiT/Recaptioner can scale to video generation (from image generation)。但是OpenAI最牛的地方就是找到了这条Scale的路径,数据/模型/参数规模 scale up之后,生成效果吊打之前所有模型,更“涌现”了3D一致性/真实世界模拟器/数字世界模拟器等能力。Sora出现的意义不亚于ChatGPT,标志着GAI和AGI的研究从大语言模型向多模态大模型的转变,越来越接近World Model。而这两个里程碑的工作仅仅相隔一年多,均由OpenAI发布引爆,只能说一句斗宗强者恐怖如斯。所以说,有没有原生创新还重要吗?创新不是目的,效果才是,其实可能并不需要眼花缭乱的方法,OpenAI的Scale规模实验哲学是非常值得大家学习。 详细的解析可以看全文: Sora(二):Sora没有黑科技!从Dalle 3到Sora,从文生图扩展到文生视频,从Sora技术报告和32篇参考文献解析需要的所有技术53 赞同 · 0 评论文章 |

|

|

|

|

|

|

|

不是没有创新,而是在规模面前,创新可能被掩盖了。当然,OpenAI也不会为了创新而创新。 从 ChatGPT 到 Sora,为何 OpenAI 能连续打造出王炸级神器?30 赞同 · 1 评论回答 |

|

|

另外,谷歌这言论实在有点吃不到葡萄说葡萄酸。 |

|

Sora技术背后的论文DiT曾经被CVPR2023拒稿,理由是“缺乏创新”。 换我审稿我也拒,你小子把UNet换成Transformer就想发顶会?让你见识一下学术界的严格。 结果,人家“依靠规模突破”以及近一年时间的不眠不休,搞出了Sora。 Sora的出现反过来证明DiT很有“创新”吗?不见得吧。 怎么样把模型的规模做上去,是真正的创新,但在学术上,可能远不如增加一个花哨的模块更“创新”。 |

|

对的,靠数据规模突破。 |

|

“模型规模越大,效果越好。“ 这是 OpenAI 的方法论,也是他们一直坚持的东西,事实也证明了他们的 Insight。 道理虽然很简单,但是能一直坚持下去沿着这条路走,这种精神比创新更可贵吧。 |

|

传统武术大师:你们这都是练死劲儿,没用。我这个叫化劲儿,我这个才有用。三百斤重的英国大力士扳不动我的一个手指头。 现代搏击选手:(大力一拳直接干飞) 好吧不皮了。其实DeepMind也是值得全体脱帽致敬的选手了。但是谁能证明大力出奇迹就是错的呢。不限于AI,各个领域天天都讲scale up,不也是一种大力出奇迹吗? |

|

这个看法非常有意思,做为 AI 领域大家公认的大牛 Denis Hassabis 的言论其实代表了一整派的看法:Transformer 大力出奇迹带不来真正的 AGI! 这个原始来源可能参考一下 https://aibusiness.com/nlp/google-deepmind-ceo-on-agi-openai-and-beyond-mwc-2024 先介绍一下 DeepMind,他是剑桥CS 专业毕业,然后有伦敦大学认知神经科学博士,可以说他的研究经历是一派标准的 计算机+大脑神经理论 的综合。在这方面确实不太少。 2011 年创立了 DeepMind,然后并入了谷歌。在谷歌最有名的战果就是 AlphaGo,通过深度神经网络CNN 与蒙特卡洛搜索算法综合完成超越人类最难策略游戏。 所以他对人工智能相关的认知,其实代表了很大一个方向与流派的认知,可能跟 Yann Lecun 的认知很像。既现在的大力出奇迹的 Transformer 这个方向不会带来最终的 AGI,或者我认为不会带来强人工智能,达到 通常意义上的人的智能==AGI, 是不是有可能我表示可能性不小。 |

|

|

如果没有横空出世的 OpenAI的 ChatGPT,那 DeepMind 才是那个通向 AGI 的“明灯”,毕竟超过不可能的“Go”是完全轰动人类世界的让人震撼在大事啊,可惜了!尽管后来的 AlphaFold 可能在实际应用中更有意义,但是因为生物玄学这东西离大家太远了,于是大家并不清楚 AlphaFold 的重要性:在医药研发与生物研发领域有着突破性的速度,但是 DeepMind 真的是做出了天才应有的成果。 首先,Demis是认同随着人类加大投入,在算力、数据、研发人员上的规模增加是一定会带来比现阶段更好的 AI 能力。而且似乎大家都认可“AGI”会在几年内到来。 关于 Transformer 的能力或者说 OpenAI 是不是能通向 AGI 这条路,下面这一段我觉得评价得非常值得大家思考: “I don’t think anyone predicted it, maybe even including them, that these new capabilities would just emerge just through scale, not for inventing some new innovation, but actually just sort of scaling,” Hassabis said. “And it’s quite unusual in the history of most scientific technology fields where you get step-changing capability by doing the same thing, just bigger – that doesn’t happen very often. Usually, you just get incremental capabilities, and normally you have to have some new insight or some new flash of inspiration, or some new breakthrough in order to get a step change. And that wasn’t the case here.” The other surprising thing was that with ChatGPT, “the general public seems to be ready to use these systems even though they clearly have flaws – hallucinations, they’re not factual,” Hassabis said. 总结一下: 大家没想到,甚至 OpenAI 可能也没想到,增加规模就能出现“涌现”,而不是通过创新。这个方法(增加规模达到新的功能)在科学史上很少出现,就是做大规模同样的事。通常是能力提升才有的,而能力要:洞察力,要灵感,要突破。而这个增大规模只能呵呵。ChatGPT 这东西毛病不少,又不准。 Google 期望的是一个百分百准确的东西才能上市,结果人家推出了 ChatGPT,大家接受了!!!!(表示一下:可能做产品与技术的是不了解市场的 8/2 定律的,8/2 给你足够的市场机遇,10/0 带给你的是研发恶梦,现在谷歌就把自己逼到了死角,比如画画出个黑人的Musk 又怎么了?这东西真的不能用吗?) 不过 Demis并没有透露他们的 AGI 方向的进展如何,只说在材料领域里的应用,如果能找到室温超导就更好了。 所以总结一下: OpenAI 的成功可能来源于一次不符合科学发展史的创新,规模就是“涌现”。现在 DeepMind 还是有货的,只是还没有达到 100%这个标准,所以不能给大家看。 真的期望 AGI 早一天到来。 这样人类是不是就能躺平了? |

|

有点书生气了,在他的位置讲这个话也不合适,很容易有没吃到葡萄说葡萄酸的意思。创新有很多方面,不仅限于优雅的理论和巧妙的技巧 "突破点在于规模",是OpenAI花了好几年时间和大量成本做出来的最重要的原生创新。或许只是简单的一句话,但是只要看看今天全世界的ai lab/大模型公司在往哪个方向走,就能感受到这有多重要 "高效组织大规模的算力和数据",是他们在工程和商业上做出来的重大创新。有聪明的团队和正确的路线只是事情成功的开始,整合调配并高效利用资源也同等重要 |

|

最顶尖的科技领域有个公认的颠扑不破的真理:力大砖飞。其实,很多时候,人类都是在解决力不够大怎么办的问题。如果力够大,那就够大了,没问题了。 当然,解决力不够大也有两个思路,一个是新思路,让力不用那么大。一个是加把劲儿的思路。 加把劲儿,其实是近些年突破的一个常态。 OpenAI是一个,还有个更著名的:特斯拉。不对,应该说是马斯克。 比如星舰,32台猛禽发动机,搞定这个东西当然是高科技,但也是力大飞砖的思路。 更早一点,Model S,7000多节三元电池,BMS的噩梦,特斯拉工程硬生生找到了一个很优秀的组合,创造了电动汽车续航、安全、管理上平衡的奇迹。 在这之前,全世界的其他电动汽车都在忙着创新软包电池……比如比亚迪的磷酸铁锂。还有很多如碳酸锂、超级电容之类……啊,那才是百花齐放的时代……但都被大力出奇迹的Model S给干掉了~ 对此,我有两个看法。 一、基础工作还是要扎实去做,才有创新突破的可能。比如数据标准,比如码电池…… 二、某种程度,也可能是科学理论陷入停滞造成的,失去了新思路的方向。就好像水滴来袭之前的人类太空舰队,看着都是高科技,底子里就是一堆砖。 |

|

事实如此 |

|

大道至简 很多创新大概只能算trick |

|

大实话,这波大力出奇迹也快到头了 |

|

其实最早哲学也有这个问题,就是那句我思故我在,到现在也没解决这个问题,但是绕过去,用科学方法,只注意现象就行了,至于本质是什么?不讨论,因为没能力,也就没意义。 在西部世界里,也是探讨了人的本质,执着找到关键钥匙。 AI包括元宇宙,开始也是这个思路,人是怎么来的,然后依照这个建立同样的系统。但是从围棋AI战胜柯洁开始,AI不在钻这个牛角尖了。 open就是,它不再是寻找人的本质,再按人的本质来建立,不再纠结本质,只要他做出的结果能解答人的问题就可以。 至于人的本质到底是什么?也许人类灭亡也未必能知道,因为清楚了,必定能窥视造物主。 |

|

原子弹理论的最关键点是,可以被造出来。这在ai上一样。 大模型的成功关键是找到了本质——规模够大才能成功。 这种理念甚至能颠覆人类对于意识的产生、人类社会是否可控等产生颠覆性影响。 人类意识可能只是在400万亿级别以上的神经网络接受信号后产生的自动辨别行为。 人类的意识不再神圣。 下一个不再神圣的可能就是社会发展理论,经济学之类的都将被唯一真理取代。 甚至自由市场的效率将完全被超大模型的经济经济取代,也是非常有可能的。 在围棋ai诞生前,围棋因为其复杂的计算量,被认为是人力智力优越的体验,事实是ai击碎了一切。 气象学被认为是多种复杂因素造成的混沌产物,实际上接近被大模型攻克。 社会学呢?有人认为自由市场不可能被颠覆,然而实际上我们放到微观,一个成功企业中几乎是各方面都被计划安排的很好,比一个随机性的企业更有效率。 显然苏联计划经济失败的原因在于制定计划的人,不在于计划本身,当能力超越了存在的边界,就会产生危害。 而大模型的成功,可能会会自由市场理论带来冲击,人类有可能来到全面计划经济时代——当然,制定计划的可能并不是人而是一种Ai。 |

|

呵呵,之前国内 AI 行业内都是认为研究基础理论好,而鄙视应用的。毕竟那个时候,美国在理论研究方面领先。 后来自从 ChatGPT 横空出世之后,他们就开始反过来鼓吹应用更好,至于 ChatGPT 根本没有自己原创的理论,他们是闭口不说,一点骂都没骂过。 |

|

这么说也没错。但是你家alpha go也是这个尿性的啊,组合一下RL、CNN和MCTS而已嘛。 |

|

“只是” 能scale up是一种能力。 |

|

人类的学习是观察领会 open Ai的涌现现象是根据概率组合 这是两种完全不同的思维模式 在open ai不能找到有效的修剪幻觉的技术路径之前(现在还在用人工在后台进行打标签和修剪),搞出来的东西只能算是文秘、打底稿、画草图、编写剧部有清晰明确功能要求的代码这种提供原始素材的功能,这非常有用,类似于把谷歌搜索的答案进行了易读性的组合整理,但不是AGI。 换个角度,也许我们学习的过程,就是修剪幻觉的过程。 从资本市场的角度,在现有的热度和资金流动性下,我以旧有的经验去判断新出现的现象,时间会证明我大概率是对的,就像特斯拉比所有车企的市值加一起都高的多得多,这种常识能判断的现象是一眼就明白的道理,时间也给出了符合常识的答案,然而在资本市场,运行的是时间与空间的波浪,所以特斯拉符合理性的时候,理性的投资者也已经倒下了。 |

|

靠规模突破就是closeai的基因,但说毫无创新普通人听听就好。 就好像希尔伯特(还是谁?)说爱因斯坦数学不好,这个不好可以碾压高校大部分精英,只不过比不过最顶尖的数学家。 |

|

这个“规模就是智商”就是deepmind开创的,难道只许他用? 这个一个明显案子就是当年的alphago,基本上棋谱每增加10-20倍,胜率就超过80%。 每增加100倍棋谱,就可以让2子。 虽然说alphazero等水平更高,但是只是利用棋谱的方法不一样而已。 数据规模就是智商。 现在openai 也一样。 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |