| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> 如何看待阿里EMO模型的发布? -> 正文阅读 |

|

|

[科技知识]如何看待阿里EMO模型的发布? |

| [收藏本文] 【下载本文】 |

|

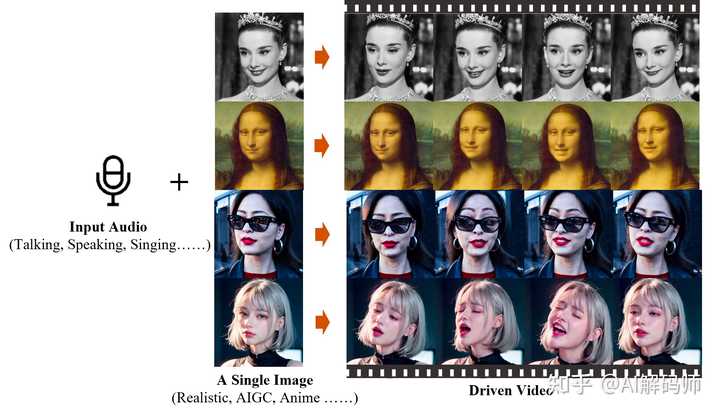

2月28日,阿里巴巴智能计算研究所发布了一款全新的生成式AI模型EMO(Emote Portrait Alive)。EMO仅需一张人物肖像照片和音频,… |

|

果然没有改错的绰号,这名字改得好,让大家都emo了 |

|

|

|

|

效果惊艳是真的惊艳,但是被议论也是有点情理之中。 |

|

|

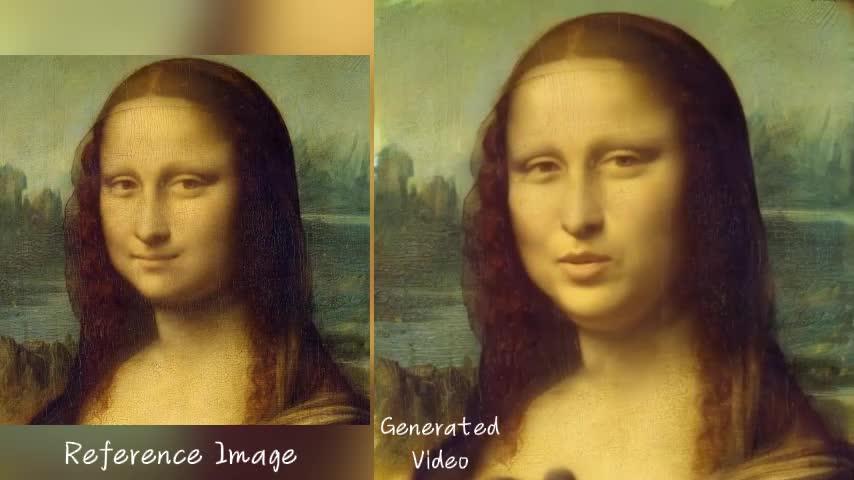

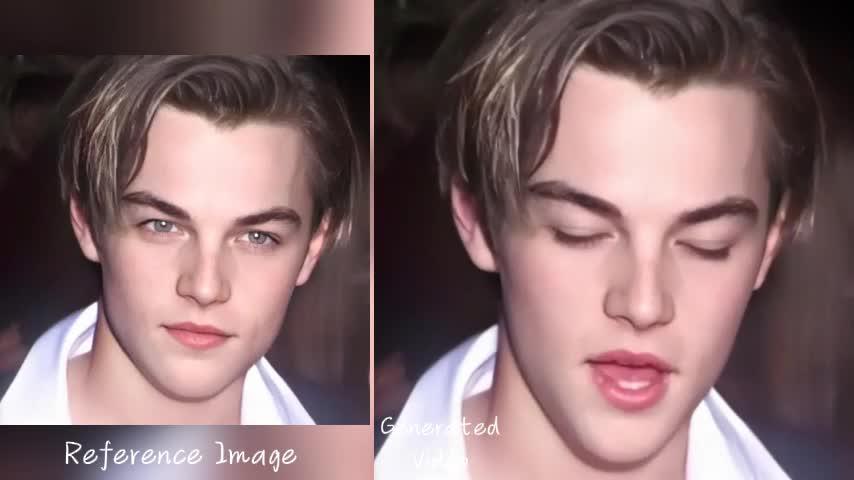

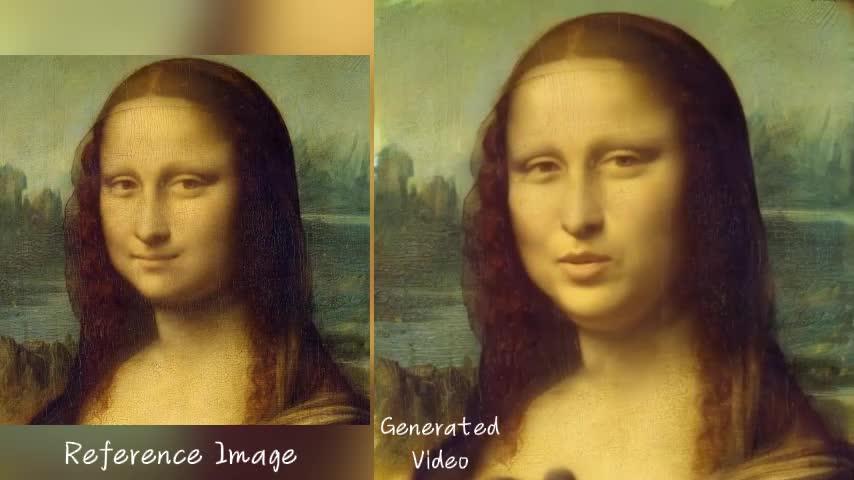

我来说两句——图片来源于EMO论文 阿里最新EMO模型可以让蒙娜丽莎说话、唱歌。 AI合成视频——蒙娜丽莎开口唱歌 | AI美女演唱MeLody328 播放 · 21 赞同视频 |

|

|

? 可以让坤坤成为RAP之王,唱Eminem的《RAP GOD》 AI合成视频-坤坤+Eminem| 张国荣+陈奕迅275 播放 · 4 赞同视频 |

|

|

? 只需要一张照片实现丝滑变脸,毫无破绽,令人振奋。 阿里最新AI生成视频——通过照片和视频实现换脸功能472 播放 · 6 赞同视频 |

|

|

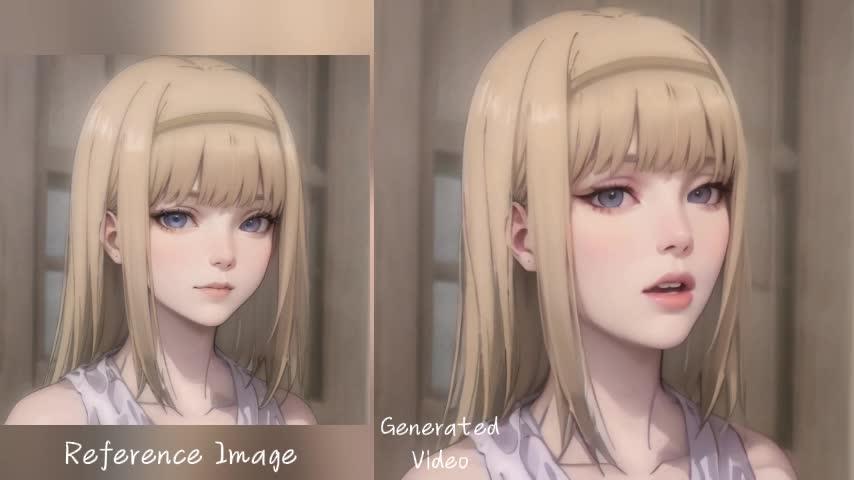

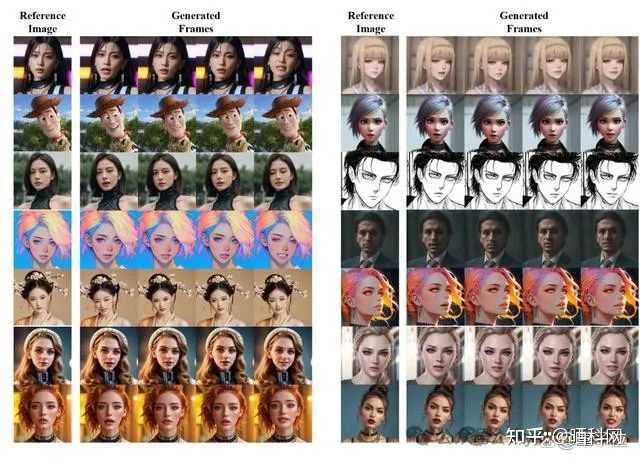

? 从演示的内容来看,用户仅需提交一张照片和一段音频给EMO,便能够创造出任意长度且表情生动的视频。 从放出的视频来看,只需上传张国荣的照片和一首歌曲,EMO便能制作出仿佛他在唱歌的真实视频,而且形象逼真。 观察EMO产出的视频,可以发现人物的口型与背景音乐的同步性极佳,表情变化也十分丰富,使得角色仿佛赋予了生命,整体效果令人印象深刻。 原论文地址详见: EMO: Emote Portrait Alive - Generating Expressive Portrait Videos with Audio2Video Diffusion Model under Weak Conditions?arxiv.org/abs/2402.17485 |

|

|

项目地址: https://humanaigc.github.io/emote-portrait-alive/?humanaigc.github.io/emote-portrait-alive/ 尽管市场上存在众多AI产品能够实现类似的视频生成效果,但EMO模型在效果方面,有两个关键方面展现了其独特优势。 |

|

|

第一是嘴型同步的精确度。 将语音精确映射到虚拟人物的嘴型是一项技术挑战,因为不同的语音音素可能对应相似的嘴型动作,而同一音素在不同的语境中可能需要不同的嘴型来表达。 另外自然语言中的连读、重音和情感变化也会对嘴型产生影响,这使得实现完美同步变得更加复杂。 而EMO模型在处理这些细节方面表现出色,无论是在停顿、高潮还是转音时,都能实现与音频的完美匹配。这一点真的很不错,效果令人赞叹。 |

|

|

第二是视频的持续时长。 大多数AI产品生成的视频时长通常限制在几分钟内。 而根据论文描述,EMO能够制作任意长度的视频,同时保持角色表情的多样性和自然性,避免重复和单调,这使得生成的视频更加生动和吸引人。 |

|

|

说完了优点,也再谈谈个人理解的不足之处,EMO在某些方面仍有改进空间。 从视频中看,目前生成的视频中的角色无法改变其原始的姿态和空间位置,还是传统的数字人,而不是如同Sora一样,有类似世界模型的效果。 尽管如此,已经很让人惊艳了。 照理来说这是一个非常令人振奋的消息,但是这个消息在众多AI爱好者的讨论群里面,讨论的方向有点奇怪,这是为什么呢? |

|

|

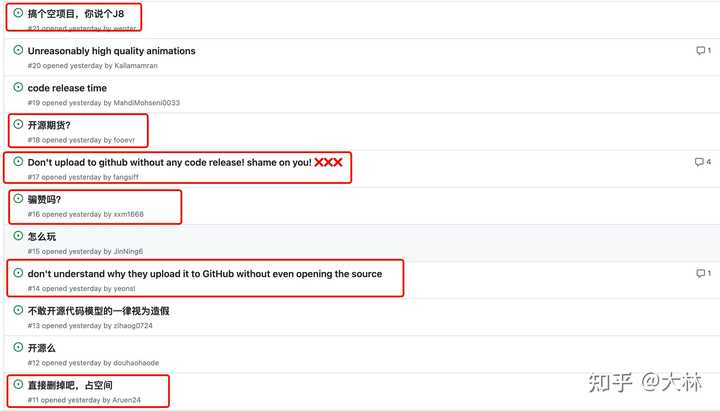

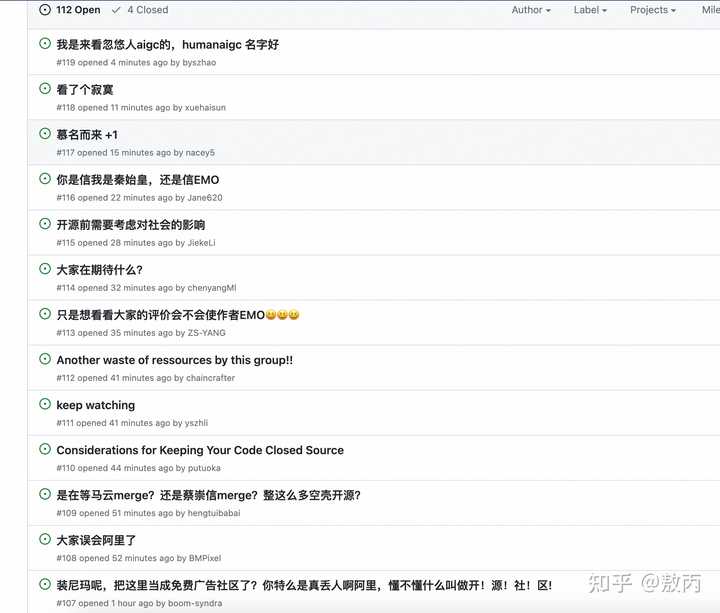

因为阿里这个团队已经多次在开源平台上没有放出代码,被网友戏称是README开源(整个仓库只有README放上去了),让大家有被放鸽子的感觉。 而且不只是这个项目,这个团队多个项目空仓库还是蛮让人不太能理解的,已经收获了不少星了。 大家讨论的焦点主要在感觉把开源社区用作广告宣传了,这一点还是蛮令人费解的,这也是让人诟病的地方,不过其实现在人工智能的算力投入太大,不开源也在情理之中,未来可能开源的模型会变少。 |

|

|

我用AI工具生成的图片 不过无论如何,这个技术的发布让大家看到了AI数字人生成的惊艳时刻,期待这个模型真正发布应用的时刻! 我是德里克文,一个对AI绘画,人工智能有强烈兴趣,从业多年的室内设计师!如果对我的文章内容感兴趣,请帮忙关注点赞收藏,谢谢! |

|

先别公开比较好,留点时间给我们升级下活体算法…… |

|

先不谈效果,反正Github的Issue已经翻天了~ 不少AI群也是讨论纷纷~ 彻底emo了~ |

|

|

|

|

|

|

|

|

|

|

sora视频女主,坤坤,高启强,罗翔,蒙娜丽莎,纷纷亮相。 sora视频女主能歌善舞 |

|

|

0 面部表情很自然 |

|

|

0 还有 |

|

|

0 张国荣 + 陈奕迅的音频 |

|

|

0 快速说唱 |

|

|

0 |

|

|

0 蒙娜丽莎看起来没那么可怕 |

|

|

0 高启强讲法律(罗翔) |

|

|

0 效果上面,看demo视频,确实动作,表情,口型,音调音速都很完美,可以说是很厉害了。 但是,这漫天的谩骂你猜猜为什么? |

|

|

|

|

|

大林:谁也没想到,阿里发布的新项目,竟然遭受了谩骂0 赞同 · 0 评论文章 |

|

|

|

|

怎么说呢确实是个非常强而且非常实用的模型,起码以后给领导拍视频的时候,让领导摆个姿势拍个照,然后录一小段音频,这不效果直接嘎嘎好了,省的还得有人给领导举着稿子,搞不好还得读好几遍 |

|

最近的新技术不断呐,国内的模型技术也开始雄起了! 这两天阿里发布了一个新型的模型框架:EMO,只需要使用一张照片外加一段音频,就可以直接生成表情丰富且真实的人像视频。 是真的很真实的那种真实哦! 感觉马上就不知道未来的世界到底是真实还是虚拟的了。 只需要上传一张照片然后配上顶级歌手的歌,那你就是“歌王”了呀。 不过可惜的是这项技术还没开放体验入口,我们只能先来看看官方的例子了! 不过迟早的事情。 先直接上一段视频: |

|

|

0 以上就是上传一张奥黛丽·赫本的肖像图,然后再上传 Samantha Harvey 对歌曲 Perfect 的翻唱版本音频。 然后通过 EMO 框架生成的视频! 感觉真人复活了有么有!相当真实了啊! 然后我们简单说下 EMO 的工作原理: EMO 主要是通过一个称为 Audio2Video 扩散模型的过程,将音频信号直接转换成视频。它绕过了传统方法中需要的 3D 模型或面部标记,直接从音频中提取信息来生成表情动态和嘴唇同步的视频,从而在不需要复杂预处理的情况下,创造出自然流畅且表情丰富的人像视频。 这种方法提高了视频的真实性和表达力,使得生成的人像视频在视觉上更为逼真和动态自然。 一句话也解释不清,对原理感兴趣的小伙伴可以看下官方的论文: https://arxiv.org/pdf/2402.17485.pdf 然后我们来看看 EMO 都有哪些功能! 最简单的让肖像唱歌,比如让最近很火的 Sora 中的 AI 女士唱首歌: |

|

|

0 EMO 还支持各种语言和不同的肖像风格: |

|

|

0 |

|

|

0 即使上传的音频速度很快,也可以很好的保证视频中人物的稳定以及和音频的动态同步。 |

|

|

0 上传的音频不仅限于唱歌的音频,各种语言的口语音频也是信手拈来哦! |

|

|

0 |

|

|

0 当我们熟悉的人物肖像和熟悉的声音结合,又会是怎样的一种场景嘞!这个是影视再创作了吧! |

|

|

0 小伙伴们心动了没有!这效果真的是相当牛掰了! 听雨是相当期待的! 最近经常听到的一句话就是未来已来,人工智能的未来真的是肉眼可见的到来呀! 至于上传空项目以及把开源社区当广告白嫖之类的这个就不讨论了。。。希望早点开源出来吧。。。 |

|

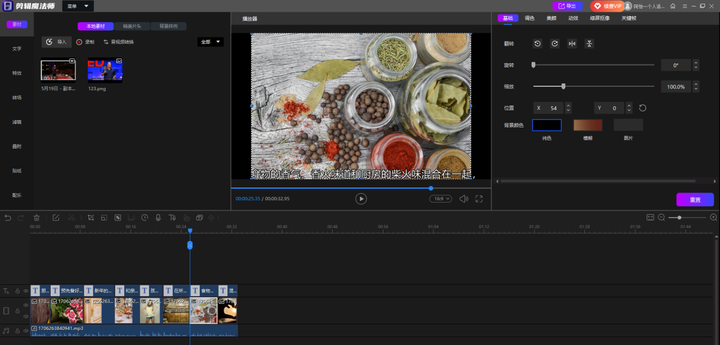

果不其然,Sora带火了“AI生成视频”。 国内头部大模型也紧跟其后,但我找了半天没有找到入口,如果有入口的朋友可以滴滴我~ 据说这个模型只需要提供一张照片和一段任意音频文件,EMO即可生成会说话唱歌的 AI 视频,以及实现无缝对接的动态小视频,最长时间可达1分30秒左右。表情非常到位,任意语音、任意语速、任意图像都可以一一对应。 但其实“AI生成视频”我之前就有试过了,虽说不能生成这么长的视频,但是基础的AI操作和理解还是可以实现的。 好比剪辑魔法师的“文生视频”,输入一段文字就可以给我一个完整的视频。 |

|

|

好比度加创作工具也有AI创作视频的功能,还有AI笔记。 |

|

|

所以其实“AI生成视频”在国内不算稀奇。在国内我比较担心的是“版权和安全”的问题。 如今,用AI编造的故事不仅能够蒙骗普通网友,就连全球各大媒体也纷纷上当。 |

|

|

(AI热图) 而国内在去年就有这样一起事件。 甘肃平凉市公安局崆峒分局网安大队发现,多达21个网站上同步出现了一条本地“新闻”:甘肃一火车撞上修路工人,致9人死亡。 如此骇人听闻的标题外加大体量的集中报道,这条“新闻”的点击量很快超过了1.5万,引发了不少网友的讨论。 但此事纯属子虚乌有,完全就是一个博流量的幌子。 当地网警立刻介入,调查后发现,犯罪嫌疑人洪某就是利用了AI技术进行的新闻造假。 |

|

|

AI技术日趋完美,图片视频都可以以假乱真。 特别是随着midjourney、Stable Diffusion等制图工具的兴起,现在用AI生成照片的效果,早就脱离了“一眼假”的尴尬,达到了肉眼难以分辨的程度,正式宣布“有图有真相”的时代已经结束。 最好还是希望在AI科技发展的同时,可以有相应的法律政策跟上予以规范。 |

|

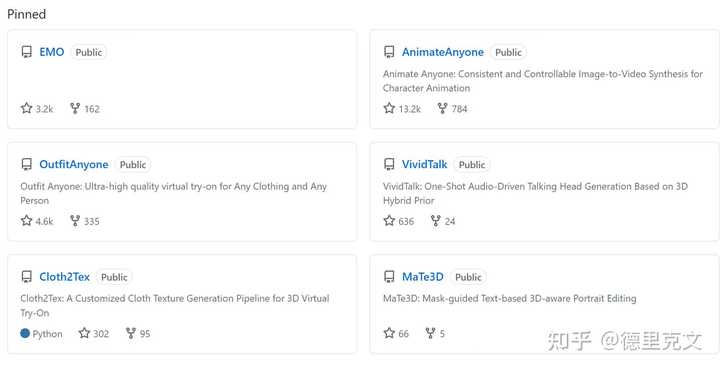

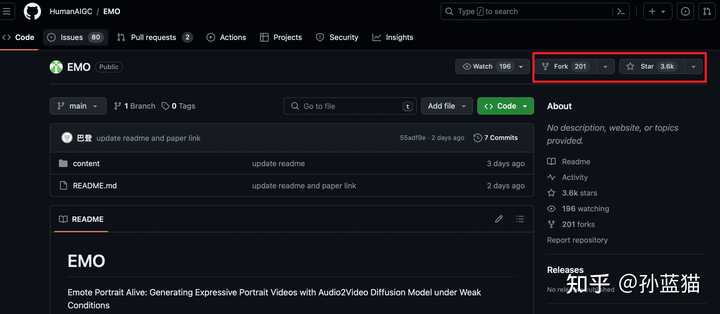

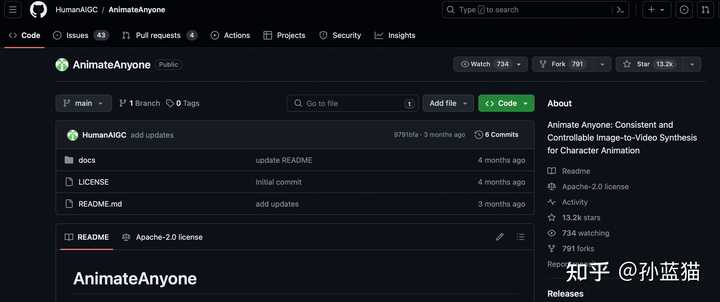

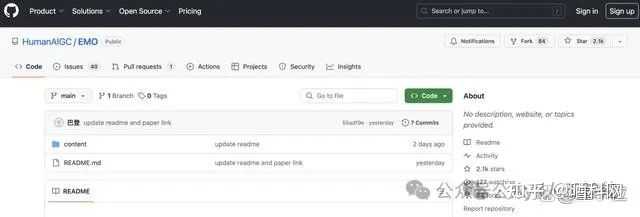

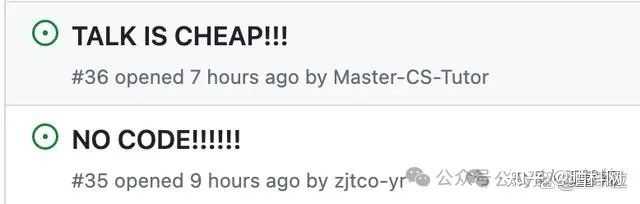

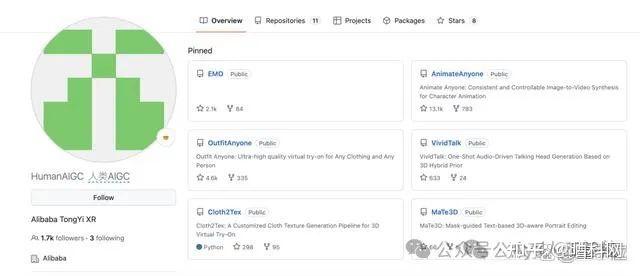

混 GitHub 也有一段时间了,见过一堆几千 star 但很水的大模型 repo(一般都是套壳项目),但没见过这么水的.. 一个啥也没有的 repo,还特么有 3.6k 的stars???而且不是,这 201 forks,你们都 fork 了些啥呀!! |

|

|

然后我看了下同一 GitHub 账号下的另一个仓库(HumanAIGC/AnimateAnyone),也是一个空 repo,居然也有 13.2k stars 和 791 forks... |

|

|

对比一下我司做的开源产品 PaddlePaddle/PaddleNLP ,开放源码+日常投人力维护,也才 11k stars..突然有点心酸了是怎么回事(不是打广告哈) 不过 issue 区整整四页都在骂也是第一次见哈哈哈哈,特别精彩,在线看瓜移步 https://github.com/HumanAIGC/EMO/issues |

|

|

部分issue截图 |

|

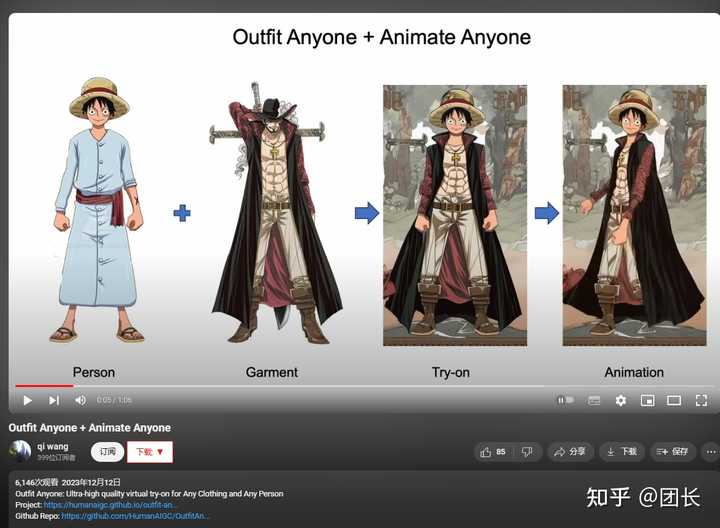

不看!跑到开源社区打个广告装个逼,有啥好看的! sora至今也不能公测,所以我谈都不谈,但是sora至少不会跑到Github专门立个项打个广告, 而且这发布号在油管上一篇视频还是三个月前,关于换装扭屁股的简单SD应用 |

|

|

哪怕这么基础的SD应用,他们也不舍得开源,而是通过Github引流到一个叫什么魔搭的国内网站 |

|

|

打开是这样,和许多套皮的AI商业设计网站大同小异的感觉,模特也不能改,就只能自己上传衣服,呃呃呃 |

|

|

反正我觉得不靠谱,看看再说,阿里这么大的公司还在Github搞点引流广告我觉得实在不应该 |

|

细思极恐!继奶牛猫跳洗澡舞、兵马俑跳科目三之后,阿里现在又整活整出了高启强普法、蒙娜丽莎唱歌这一出。 只要一张人物肖像图+一段音频就可以让画面中的人物按照音频中指定的内容唱歌或是说话,关键是口型基本一致,面部表情和头部姿态也都做到非常自然,最长的视频时间还可达到1分30秒左右。 |

|

|

也就是你可以大概想象一下,用单张静态AI美女头像就可以生成唱歌视频,这个过程就相当于,AI先看一下照片,然后打开声音,再随着声音一张一张地画出视频中每一帧变化的图像。 这下谁还能分得清虚拟还是现实... ...· 个人看法 仔细一想,现如今生成式AI技术在不断进步发展,一方面确实带给了我们许多的便捷,与此同时,也给许多别有用心的人、甚至是灰色产业提供了新的技术加持。 EMO这一图生视频AI工具的发布,虽然我们可以为它的技术突破升级而感到欣喜,但也应该提升我们自己对于外界信息真实性的判断。 |

|

|

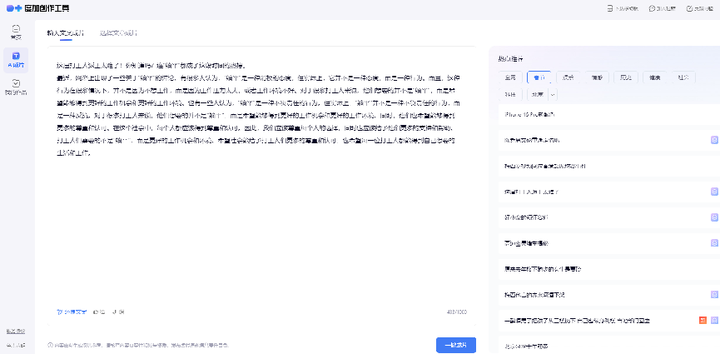

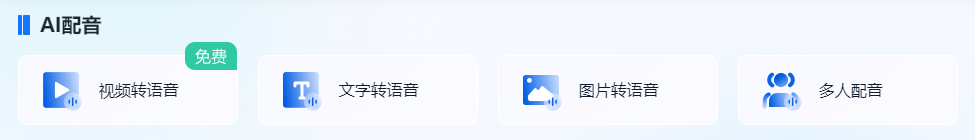

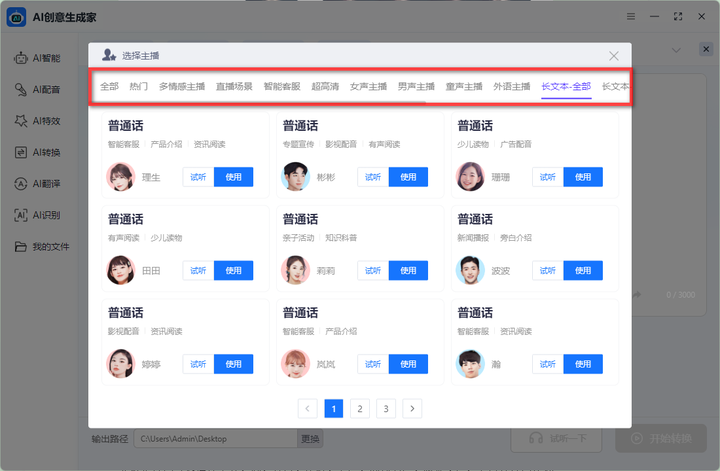

从前阵子OpenAI的Sora到DeepMind的Genie,再到如今阿里的EMO模型,无一印证着AI视频已经成为了今年AI发展的主旋律。 AI视频生成作为多模态应用里的“圣杯”,正在引领着一场关于内容创造的革命。 回顾之前的一年里,生成式AI的发展就已经十分可观,不间断地推陈出新发布了许多令人惊喜的AI工具,就好比下面分享的这一款就非常值得大家一用~ · AI创意生成家主要亮点功能:AI写作+AI绘画+AI对话+AI配音 身边许多朋友都称呼它为“六边形战士”的一个国产AI工具,而这一称呼其实是因为软件中配备了特别多样式的AI功能。 |

|

|

覆盖了内容创作、绘画生成、对话聊天、音频合成、智能翻译等等类型,综合性十分之高的这一AIGC工具就足以辅助我们高效完成各个场景下的任务需求。 【AI写作】 作为我们都非常喜闻乐见的内容写作功能,它的表现就十分的可圈可点! 为方便我们有针对性地进行内容创作、高效精准地输出优质内容,它便细心地将AI写作细分为营销、办公、分析、论文等多个场景下的选项。 |

|

|

每当有创作需求就可以直接按照分类的模版去点击创作,大大降低了使用创作的门槛以及技术要求。 而且它不仅是一个基础的AI写作工具,同时还搭配了一个内容编辑器可供我们在线编辑排版,像加粗、标记、添加序号等功能操作在这就都可以搞定! 创作完成过后还可以一键复制,或是导出为所需的文档格式,不用另外操作,很是省事~ |

|

|

【AI配音】 而常常被大家所忽视的“AI配音”这一功能就和阿里EMO大模型图生视频中的音频合成有异曲同工之妙~ 导入文本即可一键生成不同音色的配音,生成的音频效果自然真实、堪比人声。 |

|

|

关键是音色可选择性十分之高,方言、外语、童声、沉稳男声、温柔女声,上百种音色任你挑,轻轻松松就能完成海量配音任务~ |

|

|

那么有关话题的分享就先到这~ 又是干货满满的分享,我看谁还没点赞收藏喜欢,有什么意见也可以在评论区直说 @视频编辑助手 绝对欢迎! |

|

EMO + Qwen 或可助丫丫永生 |

|

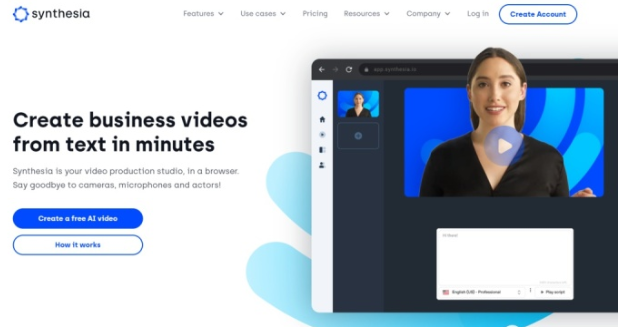

继AI写作、AI绘画后,AI生成视频也爆了。 EMO模型的出彩之处在于只要一张照片+一段音频,即可生成AI视频,视频中的人物还能说话唱歌。 其实AI应用在视频这块也不是一次两次了,市面上还有很多好用的AI视频工具,这里顺便推荐给大家! ※Synthesia Synthesia 是一个 AI 视频创作平台,它可以用不同语言从文本中创建专业视频,支持 120 多种语言,有 50 多种视频模板可供选择。 使用很简单,编写视频脚本,然后选择一个适合的模板,输入你的文本,选择一个真实的AI主持人来讲述你的视频,之后还可以添加视觉效果,如图片、图标、背景等。生成视频,等待几分钟后就可以下载或分享我们创作的 AI 视频了。 |

|

|

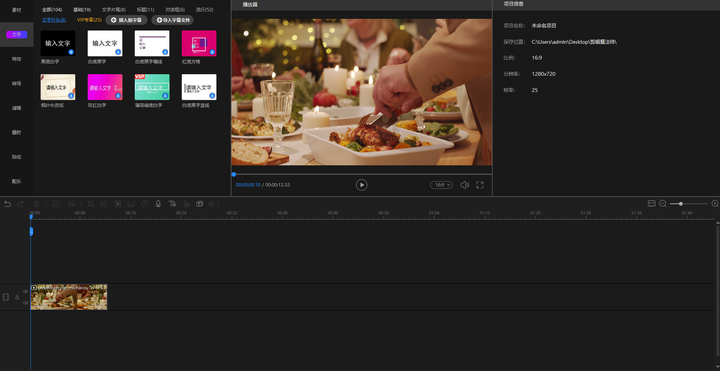

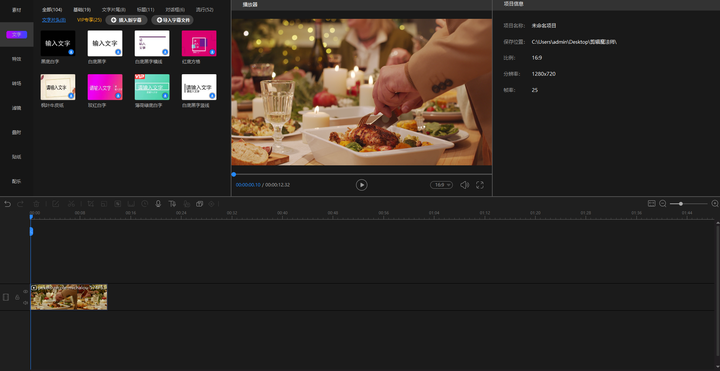

※剪辑魔法师 一款专业的多轨道视频剪辑软件,采用AI智能技术,剪辑工具很多样,支持视频剪辑、拼接合并、裁剪分割、调速、倒放、封面添加等功能,而且还提供丰富的转场、特效、滤镜、字幕、动态贴纸等素材,想要剪辑什么类型的视频都很方便。 |

|

|

一款专业的多轨道视频剪辑软件,采用AI智能技术,剪辑工具很多样,支持视频剪辑、拼接合并、裁剪分割、调速、倒放、封面添加等功能,而且还提供丰富的转场、特效、滤镜、字幕、动态贴纸等素材,想要剪辑什么类型的视频都很方便。 |

|

|

※Moonvalley 号称最强大的AI视频生成工具,使用体验感很不错~ 在这个工具中输入简单的文本描述,就能进行视频创作,写实风格、动漫风格等等多种选择,生成视频前再进行具体的参数设置,调整至满意的效果即可~ |

|

|

分享完毕啦~不管你喜欢不喜欢都给@职场小马一点支持和关注呗,评论区见! |

|

模型本身的效果不用说非常炸裂,只是在GIthub上一行代码不放这个操作确实~~ |

|

|

从Star数可以看出大家还是很期待的..... |

|

|

本来是一次很好的宣传机会,只是不知道怎么这样了~~ |

|

|

|

|

|

|

|

我缺的不是算法,缺的是算力, wav2lips就够用,阿里慢慢玩。 |

|

AI确实没有护城河,暂时没觉得emo模型和之前的Wav2Lip视频融合语音技术有多大区别。 之前霉霉说英文中文配音视频挺火的,已经是五个月前的新闻了。 |

|

|

Wav2Lip是一个开源工具,它是一种神经网络可以让视频中的人说话时的嘴唇的动作和音频的内容保持一致,根据语音调整嘴唇的变化,使得生成的视频人物口型跟输入的语音同步。 |

|

|

适用于任何人脸、任何语言、可以无缝地与原始视频融合,还可以匹配转动的脸型的口型。 在网传的谷歌内部资料《AI没有护城河》这篇文章中,说到: AI 模型的替代性很强。 各公司的模型有强有弱,但是核心功能都是类似的,很容易被替代。模型之间的差异,目前来看不是决定性的。 一家公司推出的新功能,其他公司很快就能赶上。 |

|

|

某些公司可能有独家技术,但不是关键部分。AI 的架构和原理都是公开的,不同的只是各家的实现。 网上有 AI 的开源模型,功能越来越强。只要按照教程操作,即使是家用电脑,也能很快架设一个可用的 AI 服务。 阿里花了五个月,看来是赶上了前人,效果上来看应该差不多,不过是否自研了还得等开源后再评价。 起码证明国内的开发能力还是很强的,站在巨人的肩膀上也好,自己从头开始也好,在AI浪潮中,保持开放包容的心态,希望能尽快追赶上国外甚至走在前面吧。 |

|

如果你不开源就别去开源平台上建项目,就算你非要去建项目,那也一开始就说好我不开源,只是来宣传的,而不是建项目骗点赞收藏!一个大厂这么搞还是反反复复这么搞真不嫌丢人吗? |

|

让我们看到了“参考网络”模型工具的应用。 参考网络(ReferenceNet)工具在EMO 的应用(一种思维方式的迁移) 在EMO模型中的作用是,提取参考图像和动作帧中的特征,为生成的视频提供关键的指导信息。这个网络利用深度学习技术,对输入的参考图像进行深度分析,提取出面部的特征信息,如眼睛、鼻子、嘴巴的形状和位置等。通过对动作帧进行处理,提取出与音频内容相关的动态特征。提取到的这些特征信息会被用于指导生成器的工作,保证生成的视频中人物的口型、面部表情和头部姿态与参考图像和音频内容保持一致,生成的视频更加准确、自然和逼真。 参考网络在EMO模型中扮演了非常关键的角色,保证了生成的视频与输入的参考图像和音频内容之间的高度一致性和自然性。这也是EMO模型能够在生成式AI领域中脱颖而出的重要原因之一。 例如,在帧编码阶段,系统使用一种称为“参考网络”的工具来提取特征,能够从单张参考图像和运动帧中提取关键信息,包括面部的形状、纹理、表情以及头部姿态等。这些特征提取后,将作为后续生成过程的基础,帮助系统更好地理解参考图像和动态运动。 另外一种替代方案是,基于深度学习的自编码器(Autoencoder)的方法。自编码器是一种无监督的学习算法,可以学习输入数据的低维表示。通过训练一个自编码器模型,可以将参考图像和运动帧作为输入,并学习提取关键的特征表示(作为后续生成过程的基础)。这种特征也是包含面部的形状、纹理、表情以及头部姿态等信息。 |

|

我们还是先看一下官方给出案例的效果,个人感觉还挺不错的,至少比前段时间pika和runway的效果要出色。也算是国产AI新的突破。下边是一些官方给到的效果视频,这里给大家演示下。 效果视频:来自 Sora 的 AI Lady 演唱 Dua Lipa 2. AI少女跨界表演 3. 奥黛丽·赫本翻唱艾德·希兰 4. AI Girl 富有表现力地演唱陶喆翻唱(国语) 还有很多的案例,大家可以去找一下,这里就不再重复了。 官网地址,官放也给出了官方的地址: GitHub地址,但是目前这个git里边只有一个README,这一点大家也吐槽的挺多,不过我感觉我们还是要给阿里一点时间,可能遇到一些比较难解的问题(程序员都懂): |

|

|

写在最后:最后还是说一下作者的一些观点吧,首先看到我们国内在AI领域的突破,我还是比较惊喜的,至少我们跟得上,另外呢对于最终实际应用的效果,我感觉还是得等官方把项目或者应用的入口放出来才能做评判,毕竟最开始runway和pika刚放出推广视频的时候也相当惊艳。所以无论如何我感觉我们还是给国产大模型一点时间,我们有后发优势,尽力去追赶,承认差距但是不要妄自菲薄。 |

|

|

|

|

Sora之后,居然还有新的AI视频模型,能惊艳得大家狂转狂赞! 有了它,《狂飙》大反派高启强化身罗翔,都能给大伙儿普法啦(狗头)。 这就是阿里最新推出的基于音频驱动的肖像视频生成框架,EMO(Emote Portrait Alive)。 有了它,输入单张参考图像,以及一段音频(说话、唱歌、rap均可),就能生成表情生动的AI视频。视频最终长度,取决于输入音频的长度。 你可以让蒙娜丽莎——这位AI届效果体验的老选手,朗诵一段独白。 年轻俊美的小李子来段快节奏的rap才艺秀,嘴形跟上完全没问题。 甚至粤语口型也能hold住,这就让哥哥张国荣来首陈奕迅的《无条件》。 总之,不管是让肖像唱歌(不同风格的肖像和歌曲)、让肖像开口说话(不同语种)、还是各种“张冠李戴”的跨演员表演,EMO的效果,都让咱看得一愣一愣的。 |

|

|

网友大感叹:“我们正在走进一个新的现实!” |

|

|

(2019版《小丑》说2008版《蝙蝠侠黑暗骑士》的台词) 甚至已经有网友开始对EMO生成视频开始了拉片,逐帧分析效果究竟怎么样。 如下面这段视频,主角是Sora生成的AI女士,本次为大家演唱的曲目是《Don’t Start Now》。 推友分析道: 这段视频的一致性,比以往更上一层楼了!一分多钟的视频里,Sora女士脸上的墨镜几乎没有乱动,耳朵、眉毛都有独立的运动。最精彩的是Sora女士的喉咙好像真的有呼吸哎!她唱歌的过程中身体还有微颤和移动,我直接大震惊! |

|

|

|

|

话说回来,EMO是热门新技术嘛,免不了拿来与同类对比—— 就在昨天,AI视频生成公司Pika也推出了为视频人物配音,同时“对口型”的唇形同步功能,撞车了。 具体效果怎么样呢,我们直接摆在这儿 评论区网友对比过后得出的结论是,被阿里吊打了。 |

|

|

EMO公布论文,同时宣布开源。 但是!虽说开源,GitHub上仍然是空仓。 再但是!虽然是空仓,标星数已经超过了2.1k。 |

|

|

惹得网友们真的是好着急,有吉吉国王那么急。 |

|

|

与Sora不同架构 EMO论文一出,圈内不少人松了口气。 它与Sora技术路线不同,说明复刻Sora不是唯一的路。 EMO并不是建立在类似DiT架构的基础上,也就是没有用Transformer去替代传统UNet,其骨干网络魔改自Stable Diffusion 1.5。 具体来说,EMO是一种富有表现力的音频驱动的肖像视频生成框架,可以根据输入视频的长度生成任何持续时间的视频。 |

|

|

该框架主要由两个阶段构成: 帧编码阶段部署一个称为ReferenceNet的UNet网络,负责从参考图像和视频的帧中提取特征。 扩散阶段首先,预训练的音频编码器处理音频嵌入,人脸区域掩模与多帧噪声相结合来控制人脸图像的生成。 随后是骨干网络主导去噪操作。在骨干网络中应用了两种注意力,参考注意力和音频注意力,分别作用于保持角色的身份一致性和调节角色的运动。 此外,时间模块被用来操纵的时间维度,并调整运动的速度。 在训练数据方面,团队构建了一个包含超过250小时视频和超过1500万张图像的庞大且多样化的音视频数据集。 最终实现的具体特性如下: 可以根据输入音频生成任意持续时间的视频,同时保证角色身份一致性(演示中给出的最长单个视频为1分49秒)。支持各种语言的交谈与唱歌(演示中包括普通话、广东话、英语、日语、韩语支持不同画风(照片、传统绘画、漫画、3D渲染、AI数字人) |

|

|

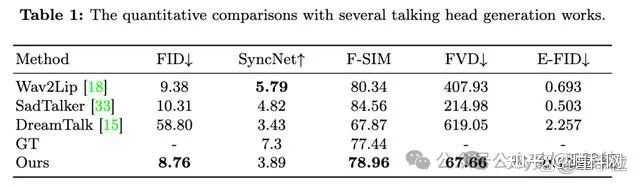

在定量比较上也比之前的方法有较大提升取得SOTA,只在衡量口型同步质量的SyncNet指标上稍逊一筹。 |

|

|

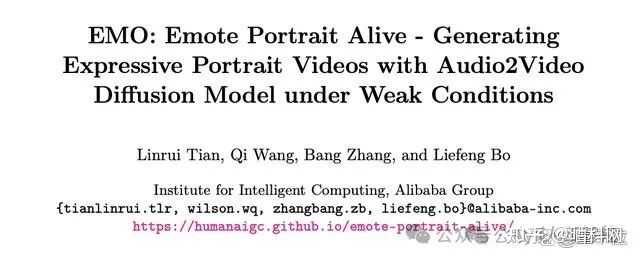

与其他不依赖扩散模型的方法相比,EMO更耗时。 并且由于没有使用任何显式的控制信号,可能导致无意中生成手等其他身体部位,一个潜在解决方案是采用专门用于身体部位的控制信号。 EMO的团队 最后,来看看EMO背后的团队有那些人。 论文显示,EMO团队来自阿里巴巴智能计算研究院。 作者共四位,分别是Linrui Tian,Qi Wang,Bang Zhang和Liefeng Bo。 |

|

|

其中,薄列峰(Liefeng Bo),是目前的阿里巴巴通义实验室XR实验室负责人。 薄列锋博士毕业于西安电子科技大学,先后在芝加哥大学丰田研究院和华盛顿大学从事博士后研究,研究方向主要是ML、CV和机器人。其谷歌学术被引数超过13000。 在加入阿里前,他先是在亚马逊西雅图总部任首席科学家,后又加入京东数字科技集团AI实验室任首席科学家。 2022年9月,薄列峰加入阿里。 |

|

|

EMO已经不是第一次阿里在AIGC领域出圈的成果了。 |

|

|

有AI一键换装的OutfitAnyone。 |

|

|

还有让全世界小猫小狗都在跳洗澡舞的AnimateAnyone。 就是下面这个: |

|

|

|

|

如今推出EMO,不少网友在感叹,阿里是有些技术积累在身上的。 |

|

|

总之,我们离“发给AI一个剧本,输出整部电影”越来越近了。 |

|

|

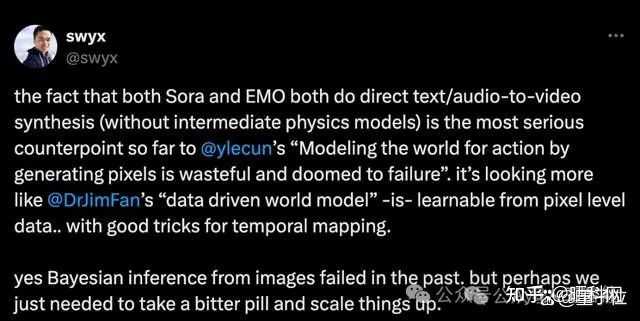

One More Thing Sora,代表文本驱动的视频合成的断崖式突破。 EMO,也代表音频驱动的视频合成一个新高度。 两者尽管任务不同、具体架构不同,但还有一个重要的共性: 中间都没有加入显式的物理模型,却都在一定程度上模拟了物理规律。 因此有人认为,这与Lecun坚持的“通过生成像素来为动作建模世界是浪费且注定要失败的”观点相悖,更支持了Jim Fan的“数据驱动的世界模型”思想。 |

|

|

过去种种方法失败了,而现在的成功,可能真就来自还是强化学习之父Sutton的《苦涩的教训》,大力出奇迹。 让AI能够像人们一样去发现,而不是包含人们发现的内容突破性的进展最终通过扩大计算规模来实现 论文:https://arxiv.org/pdf/2402.17485.pdfGitHub:https://github.com/HumanAIGC/EMO 参考链接:[1]https://x.com/swyx/status/1762957305401004061 来源:Aya人工智能微信公众号 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |