| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> CVPR 2024 有哪些值得关注的工作? -> 正文阅读 |

|

|

[科技知识]CVPR 2024 有哪些值得关注的工作? |

| [收藏本文] 【下载本文】 |

|

CVPR 2024 有哪些值得关注的工作? 关注问题?写回答 [img_log] 模式识别 计算机视觉 深度学习(Deep Learning) CVPR 人工智能? CVPR 2024 有哪些值得关注的工作? |

|

CVPR2024: Residual Denoising Diffusion Models |

|

|

我们将残差引入到扩散模型,提出了统一可解释的图像到图像分布变换框架—残差去噪扩散模型(RDDM,已公开代码)。 作者:Jiawei Liu, Qiang Wang, Huijie Fan*, Yinong Wang, Yandong Tang, Liangqiong Qu* 单位:中科院沈自所,国科大,沈阳大学,华南理工,香港大学 Residual Denoising Diffusion Models?arxiv.org/abs/2308.13712 |

|

|

https://github.com/nachifur/RDDM?github.com/nachifur/RDDM |

|

|

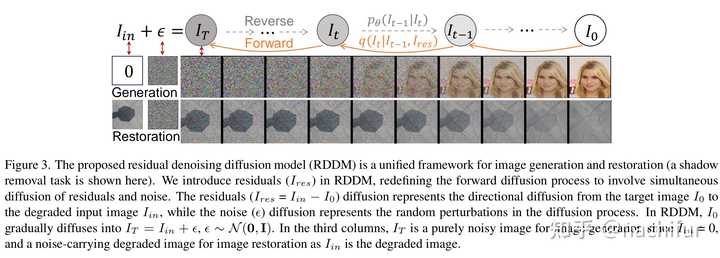

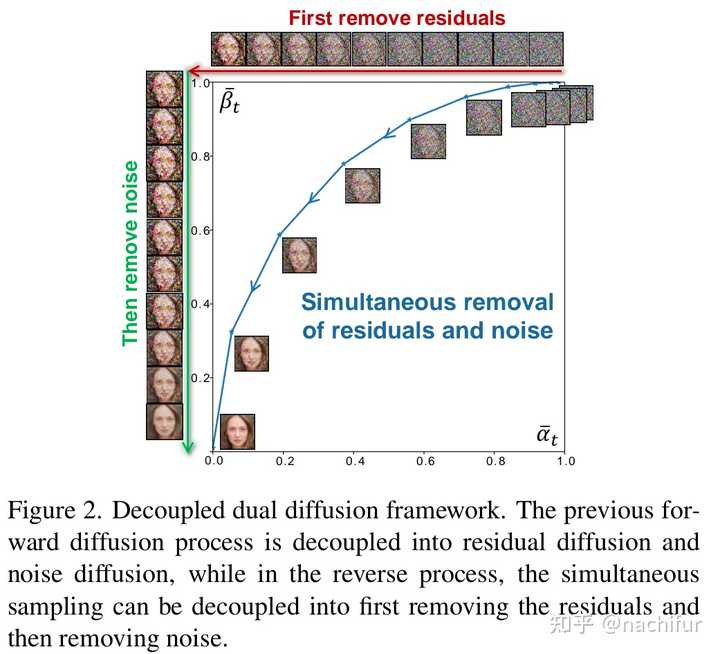

这是一种新的双扩散过程,将传统的单一去噪扩散过程解耦为残差扩散和噪声扩散。这种双重扩散框架通过引入残差,将最初无法解释图像恢复任务的基于去噪的扩散模型,扩展为图像生成和恢复的统一和可解释的模型。 |

|

|

具体来说,我们的残差扩散表示从目标图像到退化输入图像的方向扩散,并明确指导图像恢复的反向生成过程,而噪声扩散表示扩散过程中的随机扰动。残差优先考虑确定性,而噪声强调多样性,使得RDDM能够有效地统一具有不同确定性或多样性要求的任务,例如图像生成、恢复、翻译、补全。(下图中的(b)并行放大图像,可以使用MulimgViewer) |

|

|

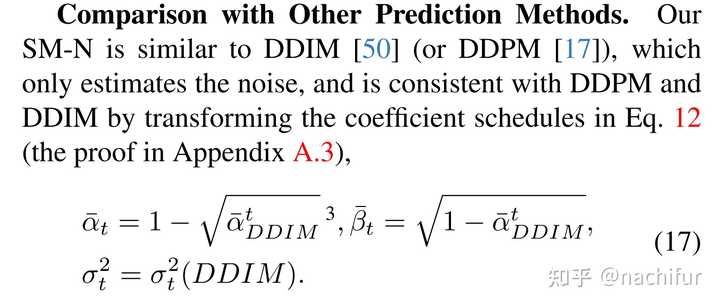

我们通过系数变换证明了我们的采样过程与DDPM和DDIM的采样过程是一致的。 |

|

|

并提出了一个部分路径无关的生成过程,以更好地理解反向过程。 |

|

|

值得注意的是,我们的RDDM使用通用的UNet,L1损失和batchsize 1,就可以与最先进的图像恢复方法竞争。我们提供代码和预训练模型,以鼓励进一步探索,应用和开发我们的创新框架。 ps:后续就将对RDDM进行详细介绍,代码也将进一步完善。 |

|

舔着个B脸来蹭蹭热度,首先说一点的是我没有投CVPR,因为投稿期间我在准备我的语言考试,之前考的分数不够目标院校,所以要加点分。但是我要了一个号,也算是以一个"伴随视角"来陪伴朋友们改稿到中稿吧。 我今天见证太多好友的成功,他们的工作都是十分优秀的。但是也知道了一些朋友们失败的消息(感谢这群优秀的伙伴不愿意看见我痛苦的徘徊于底层的科研,选择留下了继续陪陪我)开个玩笑,Y1S1他们的工作也同样十分优秀,也十分的用心,有很多我值得学习的地方。 其实我觉得CVPR依旧是很有他的含金量,虽然看着好像大家都有文章,但是我感觉上来说大家应该是更吃力了。学生审稿人的增加,还有AC的亲自下场"选妃"也使得整个Domain的口味难以琢磨。 不管如何,顶会可能是学术下一步的入场券,也能对自己这段时间的努力的一些奖励。但是每个人的节奏,工作的popular程度是不一样的。努力了很多次没有中其实不代表你并没有能力,而是每个人都有自己的节奏和模式。 我最喜欢的一句话是在MEGALO BOX中,南部赝对Joe说的一句"你的实力是货真价实的"! 所以继续加油吧! |

|

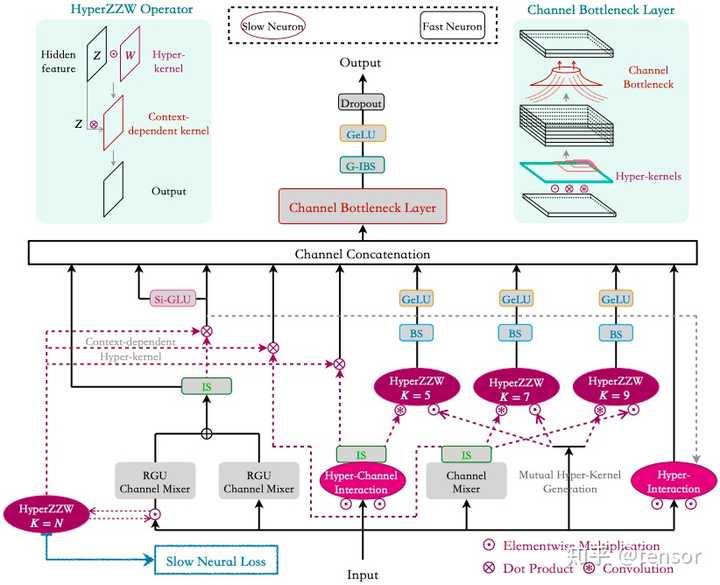

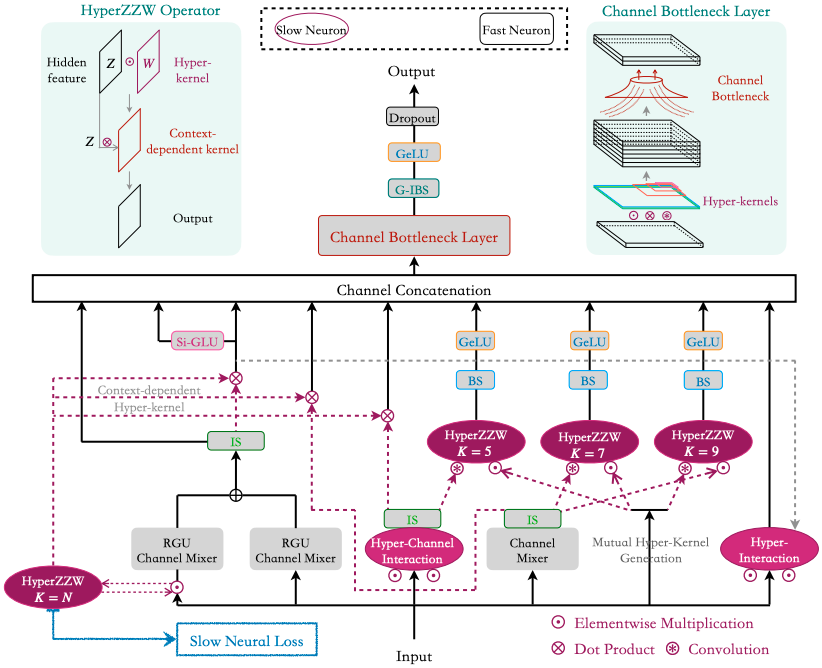

借楼宣传一下我们的工作,虽然它被CVPR 2024 Rejected... 该工作的proposal正式提出于2022年10月份,其模型搭建完全从零开始,中间经历了上千次魔改... 当前论文版本有待进一步完善,且arXiv只放出正文部分...因页数限制,正文只能集中在介绍架构细节。附录会有15页orz,投稿附录是11页 HyperZ?Z?W Operator Connects Slow-Fast Networks for Full Context Interaction https://arxiv.org/pdf/2401.17948.pdf?arxiv.org/pdf/2401.17948.pdf 与SSM/Mamba的关系: 其实SSM的核心也有long conv,即通过结构化参数构建大卷积核,而我们是通过一个小型的MLP生成大型隐式卷积核。和SSM同期的工作称之为continuous convolutional networks,包括FlexNet和CCNN。 至于Hyena/Mamba只不过增加了data-dependent gating,该思想源于self-attention。我们在2022年就认识到context-dependent weights的重要性,虽然发布比较晚。 至于slow and fast networks的概念起源于1990s。在1987年,Hinton在神经网络中提出slow and fast weights的概念,它们用于保存长期记忆long memory和短期记忆short memory;Jurgen在1992年提出使用一个slow network生成另一个fast network的权重,被称为Fast Weight Programmer (FWP);最近的工作是hypernetwork...具体related works放在了附录中。下面是Jurgen总结的关于FWP的相关工作: Neural nets learn to program neural nets with with fast weights (1991)?people.idsia.ch//~juergen/fast-weight-programmer-1991-transformer.html 下面是Hinton在2019年的presentation一节: |

|

|

我们提出了一个新的网络架构Terminator,其可以抛弃残差学习以及提出具有线性复杂度的self-attention的新变种,并且我们提出了很多新颖的模块去搭建和训练Terminator。另外,我们的架构对normalization操作也进行了革新,比如去掉里边的可训练Affine参数以及Momentum项。 第一,在ResNet论文中,作者强调的是残差学习可以避免性能退化,而非解决梯度消失问题。然而,PlainNet出现性能退化的原因一直未找到!我们认为根源在于传统CNN普遍采用单分支结构和小卷积核,这会导致每一层的特征提取能力被大大削弱,进而造成最后avg pooling layer无法得到准确的特征描述符。而残差连接的作用在于可以通过将上一层的特征补偿到下一层来减少信息损失。但残差补偿只能缓解上述问题,请先参考Figure 2。后续附录中将包括更多可视化结果,如特征图,权重和梯度信息等。透露一点:我们架构将不会再有梯度消失问题,因为浅层梯度值比深层梯度值还要大,呈现出递减趋势。 第二,为了扩大感受野或减少计算量,模型通常会使用中间下采样层,max pooling。Figure 2展示了下采样层严重破坏了物体的结构,并且其同样会造成信息损失。因此,我们的结构不再使用中间下采样层。 综上,为了在每一层尽可能减少信息损失,我们提出了full context interaction概念。它指的是模型在每一层能够同时综合全局和局部信息来增强特征提取能力。为了实现full context interaction,我们需要多分支结构和大卷积核。对于前者,如Figure 3所示,我们构建了多分支的Slow-Fast Neural Encoding (SFNE) block。对于后者,我们提出使用小型MLP作为slow network去生成大型隐式卷积核,这就可以避免大卷积核带来的参数爆炸问题。 第三,之前很多工作将self-attention机制中的attention matrix理解成是由激活值生成的context-dependent fast weights。attention matrix就是一个大型隐式权重矩阵,并且其可以根据输入动态变化。 第四,self-attention机制的缺点就是时间和空间上的二次复杂度。虽然之前工作致力于降低其复杂度,但它们依然依赖于通过query-key形式构造attention matrix。 第五,目前的vision transformer仍然需要将图像划分成patches再计算各个patch之间的attention scores。显然,这种方式无法得到每个像素的分数,即pixcel-level scores. 综上,我们提出的HyperZ?Z?W operator不仅可以得到context-dependent fast weights,并且只有线性复杂度。其通过对大型隐式卷积核和输入特征图进行点乘来获得pixcel-level scores。具体细节请看论文。 以上是论文的两个主要贡献。下面介绍SFNE block的构建。 |

|

|

Slow-Fast Neural Encoding (SFNE) 如上图所示,其主要结构分为四层 Input -> Channel Mixers -> Global and Local HyperZZWs -> Channel Concatenation -> Channel Bottleneck LayerChannel Mixers 包括三个不同模块:RGU是GLU的扩展; Hyper-Channel Interaction中同样嵌入HyperZZW,其可以看作是channel attention的更高效版本;最后是一层的MLP。因为后面的Global and Local HyperZZWs中的dot product and convolution opeartions是channel-wise,所以需要它们对通道信息进行交换。并且,channel mixers后边的instance standardization可以保证样本维度(B)和空间维度(H,W)的独立性。 2. HyperZZW (K=N) 进行全局特征提取,这里未使用卷积符号是因为其计算是dot product而非传统基于滑动窗口的卷积。HyperZZW (K=5-7-9) 进行局部特征提取。 3. 在通道维度上对全局特征和局部特征进行concat。我们的可视化结果显示,全局特征用于捕捉物体的粗略结构,而局部特征可以保留物体细节,特别是使用小卷积核。 4. Channel Bottleneck Layer. 上图展示的是一个九分支结构,如果每一层的channel数量乘以9,堆叠五个SFNE block会使得channel数量达到20000。这是不可接受的。因此,如上图右上角所示,我们对channel进行了压缩。比如输入channel=C,concat后为9C,Channel Bottleneck Layer会将其压缩成2C。在这里我们定义了一个压缩系数,请参考论文。 5. 我们还将SFNE中两个RGU的和进行channel concatenation. 还包括其它两个分支:Si-GLU和hyper interaction。它们可以在增加很少计算量和参数量的情况下提升模型性能。其实,它们也是为了增强full context interaction,进而减少信息损失。 我们的架构在多个数据集上超过之前baselines,并且表现出良好特性,比如快速收敛,零均值特征,较少模型参数等。然而,由于计算资源限制,我们无法完成ImageNet上的实验 (这也是被reviewers rejection的主要原因,虽然AC表面称应该鼓励探索zz)。其实,我们在rebuttal中没有明确指出,当然所有reviewers和AC也没发现问题所在,那就是global HyperZZW中的dot product是会随着输入变大而计算量逐渐增长 (ImageNet需要A100...并且计算成本暂时无法承担)。我们最多只能测试输入为96*96以及length=16000。当然,这也是self-attention存在的问题,因为计算得到的attention matrix (L*L)依然需要与Value (L*D)进行dot product。 最后,感兴趣的同学可以查看论文细节。评论区打开随时可以交流,或关注下面的文章! HyperZ?Z?W Operator Connects Slow-Fast Networks for Full Context Interaction0 赞同 · 0 评论文章 |

|

|

私信或Email: harviezzw@gmail.com |

|

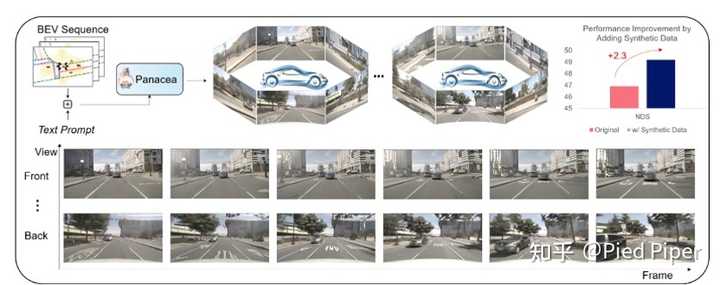

欢迎大家关注我们在CVPR2024上的面向自驾领域的视频生成工作Panacea! 论文链接:https://arxiv.org/abs/2311.16813 网页链接:https://panacea-ad.github.io/ Github链接:https://github.com/wenyuqing/panacea 欢迎参考demo网站,以及阅读原文了解更多详情,也欢迎评论区和github积极交流! 我们知道自动驾驶对于数据的有大量需求,那么AIGC 正是绝佳的工具来为自动驾驶合成数据。我们最新的工作正是面向这个需求,提出了一种全新的生成模型名叫Panacea,为自动驾驶合成高质量的,带标注的多视角视频数据,推动自驾领域的发展。 Panacea: 面向自动驾驶的多视角和可控视频生成 自动驾驶领域对高质量带标注的训练数据需求日益增长。本文提出了一种创新的方法“Panacea”,用于生成多视角且可控的驾驶场景视频,能够合成无限数量的多样化、带标注的样本,这对于自动驾驶的进步有至关重要的意义。 Panacea解决了两个关键挑战:“一致性”和“可控性”。一致性确保时间和视角的一致性,而可控性确保生成的内容与相应的标注对齐。Panacea结合了创新的4D注意力机制和两阶段的生成流程来实现一致性,并通过ControlNet框架引入鸟瞰图(BEV)布局,以进行精确控制,从而保证可控性。Panacea在nuScenes数据集上做了广泛的定性和定量评估,充分证明了其在生成高质量多视角驾驶场景视频方面的强大能力。这项工作显著推动了自动驾驶领域的发展,有效地增强了训练数据集,可有助于先进的BEV感知方法的训练。 Panacea能做什么? Panacea是一个出色的视频生成器,有能力合成高质量的,可控的,多视角自动驾驶视频。这样的能力使Panacea 可以批量合成大量带有标注的高质量视频训练数据。它不仅能扩充现有视频数据集,提供大量新的合成样本,而且还有可以将图片数据集增广为视频数据集,从而促进基于视频的BEV感知技术的发展。此外,Panacea卓越的生成真实性与可控性使Panacea成为真实世界驾驶模拟的一个可行选择。 下面展示了Panacea的广泛用途: 1. 基于BEV(鸟瞰图)布局序列合成多视角视频, 有助于扩充视频数据集,提升感知任务性能。 |

|

|

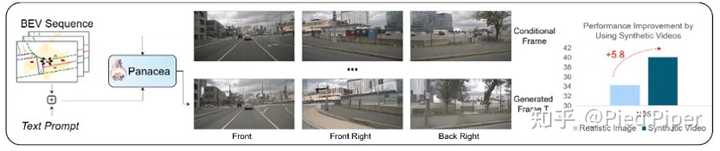

2. 通过初始帧和BEV布局生成多视角视频,可以有将仅图像的数据集增广为视频数据集,促进基于视频的感知技术的发展。 |

|

|

3. 可变属性控制的视频生成,如天气、时间和场景,可以模拟罕见天气等场景,提升数据的多样性。 |

|

|

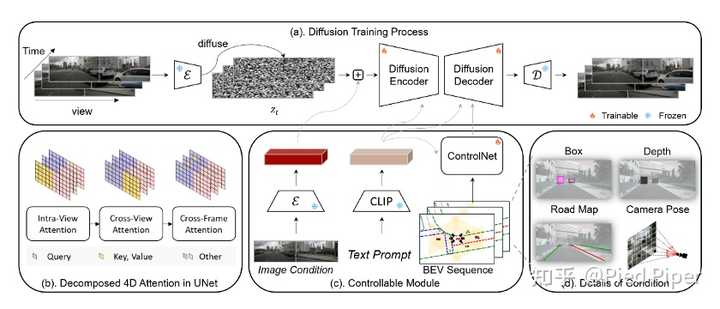

Panacea如何实现上述功能? Panacea基于Stable Diffusion (SD) [1] 模型构建。虽然SD模型在图像生成方面表现出色,但由于序列中不同视图和帧之间缺乏约束,无法直接应用于生成一致的多视角视频。Panacea采取了一个创新的架构:一个基于分解的4D注意力的UNet,如下图(b)所示,旨在同时生成整个多视角视频序列。其中扩散模型的输入维度为H × (W × V) × T × C,其中C代表潜在编码的维度。这个多视角视频序列沿宽度拼接相邻的视角,与它们固有的多视角特性相一致。下图(a)展示了Panacea的整体训练框架。Panacea是一个两阶段方法:初始阶段合成真实的多视角驾驶场景图像,随后的阶段沿时间轴扩展这些图像以创建视频序列,这种两阶段方法大幅度提升了生成的视频质量。此外,Panacea采用ControlNet [2] 来注入BEV序列, 如下图(c)所示。最后,除了这些核心设计之外,Panacea还保留了通过文本描述(如天气、时间和场景)操纵全局场景属性的多功能性,为生成特定样本提供了用户友好的界面。 |

|

|

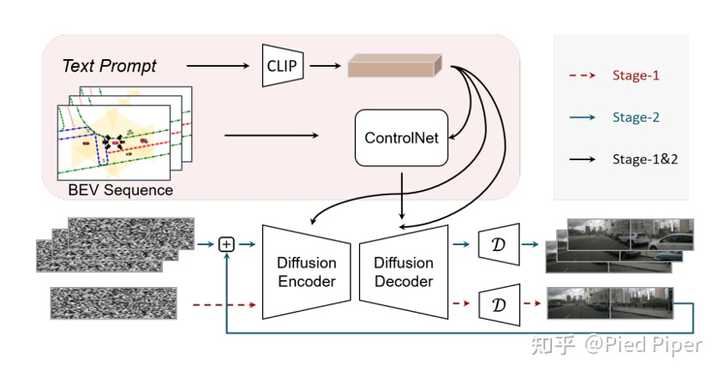

接下来详细介绍Panacea的几个核心模块: 分解的4D注意力机制: 基于分解的4D注意力UNet旨在实现跨视角和跨帧建模,同时确保计算的可行性。多视角视频生成的一种最直接朴素的方法可能采用完全的4D(HWVT)注意力。然而,这种方法需要过多的内存和计算资源,超出了即使是最先进的A100 GPU的能力。因此,Panacea采用了一种更高效的架构,称为分解的4D注意力,选择性地保留了最关键的注意力操作:相邻视角之间的注意力和空间对齐的时间片段之间的注意力。 这在现有的视角内空间注意力基础上引入了两个新的注意力模块——跨视角注意力和跨帧注意力,消融实验证明,这种分解的4D注意力机制有助于合成连贯的多视角视频,同时保持了网络的可行性和效率。 两阶段方法: 为了提高生成质量,Panacea进一步采用了两阶段的训练和推理流程。通过跳过时间感知模块,Panacea也可以作为多视角图像生成器运行,从而实现两阶段视频生成的统一架构。在训练过程中,首先训练一组专门用于多视角图像生成的权重。然后通过将条件图像与扩散输入拼接在一起,训练第二阶段视频生成权重。值得注意的是,在这第二阶段训练中,Panacea使用真实图像而不是生成的图像作为条件。这种方法使训练过程具有与单阶段视频生成方案相当的效率。在推理过程中,如下图,Panacea首先使用第一阶段的权重采样多视角初始帧, 随后基于这些多时间初始帧,使用第二阶段的权重,生成一个多视角视频。这种将空间与时间合成过程解藕开的两阶段流程显著提高了生成视频的真实性。 |

|

|

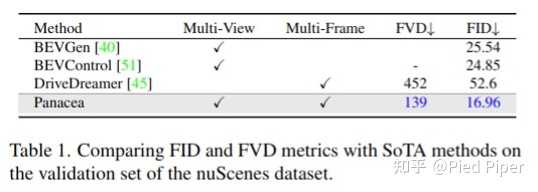

可控性引入方法: Panacea模型是为促进自动驾驶系统而设计, 因此合成视频的可控性成为一个关键属性。Panacea集成了两类控制信号:一类是粗粒度的全局控制,包括文本属性,一类是细粒度的布局控制,涉及BEV布局序列。 粗粒度全局控制使Panacea模型能够生成多样的多视角视频。这是通过将CLIP编码 [3] 的文本提示集成到UNet中实现的,这种方法类似于Stable Diffusion中使用的方法。得益于Stable Diffusion预训练模型,Panacea能够根据文本提示合成特定的驾驶场景。 Panacea模型的细粒度布局控制有助于生成与标注一致的合成样本。 Panacea 采用BEV布局序列作为细粒度控制信号。具体来说,持续时间为T的BEV序列将被转换为透视视图并提取出控制元素,如物体边界框、物体深度图、道路图和相机姿态嵌入。 然后这些控制元素将组成具有19个通道的布局控制图像:10个用于深度,3个用于边界框,3个用于道路图,以及3个用于相机姿态嵌入。这些19通道图像将通过ControlNet集成到UNet中。值得注意的是,Panacea额外引入了相机姿态作为控制条件,以便更精确地控制合成视频的视角。 实验分析 将Panacea与各种最新的驾驶场景生成方法在FVD 和FID 上进行比较,如下表所示, Panacea实现了139的FVD和16.96的FID。这些指标都显著超过了所有对手,包括基于视频的方法如DriveDreamer和基于图像的解决方案如BEVGen和BEVControl, 展示了Panacea显著优越的生成质量。 |

|

|

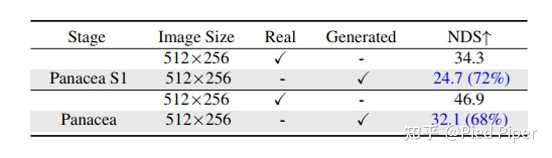

除了生成质量指标以外,Panacea 还采取感知性能指标来量化评估可控性,基于StreamPETR [4]。首先使用Panacea生成nuSences的整个验证集。然后,使用预训练的StreamPETR模型在生成的验证集上测试感知性能。与真实数据的感知分数相比的相对性能可以用于衡量生成数据与控制信号BEV序列之间的对齐程度(可控性)。如下表所示,Panacea实现了68%的相对性能,突显出生成视频与BEV控制信号的强大对齐能力。此外,Panacea的初始阶段合成的多视角图片,也实现了72%的相对性能。 |

|

|

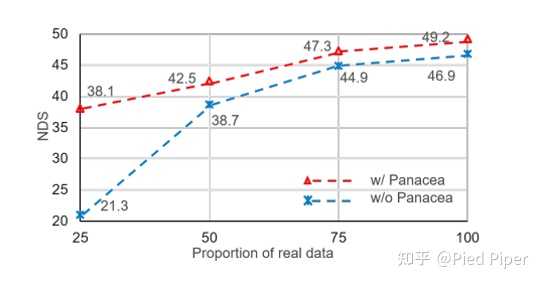

除了在验证集上的评估外,Panacea更重要的特性是其生成无限数量带标注训练样本的能力。使用Panacea在nuScenes合成一个新的训练数据集Gen-nuScenes,来作为StreamPETR模型的辅助训练资源。如下表所示,实验结果表明,仅在Gen-nuScenes上训练的StreamPETR模型取得了36.1%的nuScenes检测得分(NDS),达到了十分可观的于真实nuScenes训练集训练的模型相比77%的相对性能。更重要的是,将生成的数据与真实数据结合,使StreamPETR模型的NDS提高到了49.2,比仅使用真实数据训练的模型高出2.3点。 |

|

|

此外,下图展示了Gen-nuScenes如何一致地增强StreamPETR在各种真实数据比率下的性能。这些结果共同证明了Panacea模型生成可控的多视角视频数据的强大能力,是自驾领域的强大助力。 |

|

|

除此之外,Panacea模型还可以通过使用真实图像作为条件,将仅图像的数据集增广为视频数据集。这种增广有助于促进基于视频的感知技术的发展。如小表所示,NDS增加了5.8点,带来了显著改善。 |

|

|

总结和展望 Panacea 强大的可控多视角视频生成能力对自动驾驶具有重大意义。其中分解的4D注意力模块可以高效地确保时间和跨视角的一致性,而两阶段训练策略可进一步提高生成质量,也可以使Panacea同时具有扩充现有视频数据集以及将图片数据集增广为视频数据集的两种功能。更值得注意的是,Panacea擅长处理各种控制信号,以产生带有精确标注的视频。大量实验都证明了Panacea在生成高质量、标注良好的多视角驾驶场景视频方面的强大能力。这些视频非常宝贵,不仅在鸟瞰图视觉感知中发挥作用,而且在真实世界驾驶模拟中也显示出前景。在未来,Panacea有希望整合更多样化的控制信号,也有潜力作为真实世界的自动驾驶模拟器。 [1] Andreas Blattmann, Robin Rombach, Huan Ling, Tim Dockhorn, Seung Wook Kim, Sanja Fidler, and Karsten Kreis. Align your latents: High-resolution video synthesis with latent diffusion models. In CVPR, pages 22563–22575. IEEE, 2023. 2, 3, 5 [2] Lvmin Zhang and Maneesh Agrawala. Adding conditional control to text-to-image diffusion models. CoRR, abs/2302.05543, 2023. 2, 3, 6, 12 [3] Alec Radford, Jong Wook Kim, Chris Hallacy, Aditya Ramesh, Gabriel Goh, Sandhini Agarwal, Girish Sastry, Amanda Askell, Pamela Mishkin, Jack Clark, Gretchen Krueger, and Ilya Sutskever. Learning transferable visual models from natural language supervision. In ICML, volume 139 of Proceedings of Machine Learning Research, pages 8748–8763. PMLR, 2021. 5 [33] Aditya Ramesh, Prafulla Dhari [4] Shihao Wang, Yingfei Liu, Tiancai Wang, Ying Li, and Xiangyu Zhang. Exploring object-centric temporal modeling for efficient multi-view 3d object detection. CoRR, abs/2303.11926, 2023. 2, 3, 6, 12 |

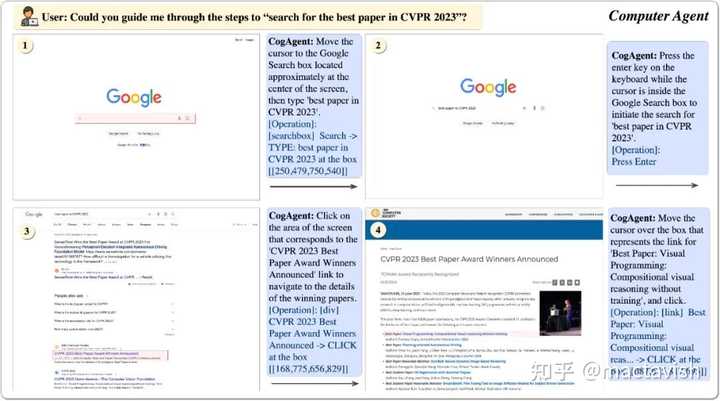

基于语言预训练模型(LLM)的Agent是当下热门的研究话题,具备良好的应用前景。但是,一个严重的问题是,受限于LLM的模态,它只能接受语言形式的输入。 以网页agent为例,WebAgent 等工作将网页HTML连同用户目标(例如“Can you search for CogAgent on google”)作为LLM的输入,从而获得LLM对下一步动作的预测(例如点击按钮,输入文本)。 然而,一个有趣的观察是,人类是通过视觉与GUI交互的。 比如,面对一个网页,当给定一个操作目标时,人类会先观察他的GUI界面,然后决定下一步做什么;与此同时,GUI天然是为了人机交互设计的,相比于HTML等文本模态的表征,GUI更为直接简洁,易于获取有效信息。 也就是说,在GUI场景下,视觉是一种更为直接、本质的交互模态,能更高效完整提供环境信息;更进一步地,很多GUI界面并没有对应的源码,也难以用语言表示。因此,若能将大模型改进为视觉Agent,将GUI界面以视觉的形式直接输入大模型中用于理解、规划和决策,将是一个更为直接有效、具备极大提升空间的方法。 对此,我们提出了多模态大模型CogAgent,可以实现基于视觉的GUI Agent。下图展现了其工作路径与能力。 |

|

|

CogAgent模型同时接受当前GUI截图(图像形式)和用户操作目标(文本形式,例如“search for the best paper in CVPR 2023”)作为输入,就能预测详细的动作,和对应操作元素的位置坐标。 |

|

|

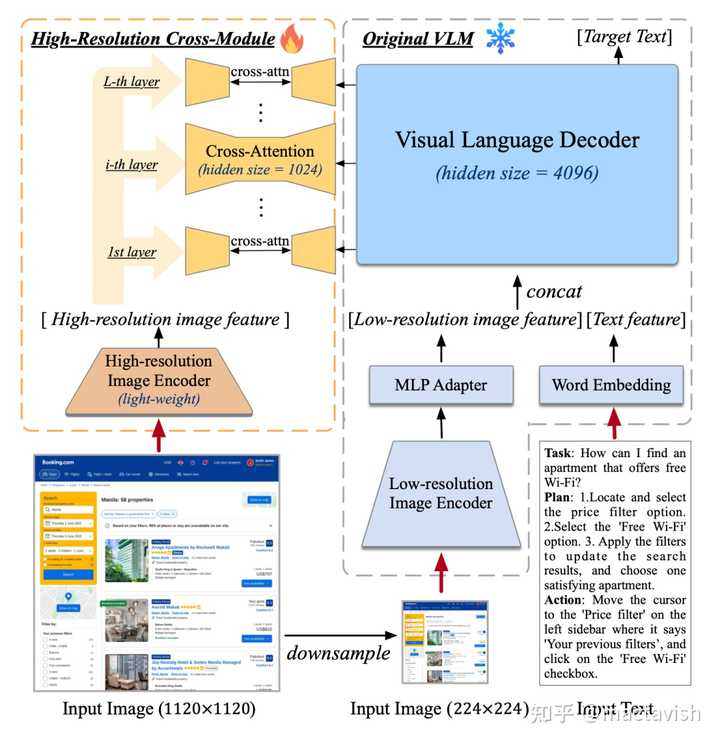

为了使模型具备对高分辨率图片的理解能力,可以看清~720p的GUI屏幕输入,我们将图像输入的分辨率大幅提升至1120×1120(以往的模型通常小于500*500)。 然而,分辨率的提升会导致图像序列急剧增长,带来难以承受的计算和显存开销——这也是现有多模态预训练模型通常采用较小分辨率图像输入的原因之一。 对此,我们设计了轻量级的“高分辨率交叉注意力模块”,在原有低分辨率大图像编码器(4.4 B)的基础上,增加了高分辨率的小图像编码器(0.3 B),并使用交叉注意力机制与原有的VLM交互。在交叉注意力中,我们也使用了较小的hidden size,从而进一步降低显存与计算开销。 结果表明,该方法可以使模型成功理解高分辨率的图片,并有效降低了显存与计算开销。 在消融实验中,我们比较了该结构与CogVLM原始方法的计算量。结果表明,当分辨率提升时,使用文中提出的方案(with cross-module,橙色)将会带来极少量的计算量增加,并与图像序列的增长成线性关系。 特别的,1120×1120分辨率的CogAgent的计算开销(FLOPs),甚至比490×490分辨率的CogVLM的1/2还要小。在INT4单卡推理测试中,1120×1120分辨率的CogAgent模型占用约12.6GB的显存,相较于224×224分辨率的CogVLM仅高出不到2GB。 下面我们展示一个《原神》场景的实例 |

|

|

|

|

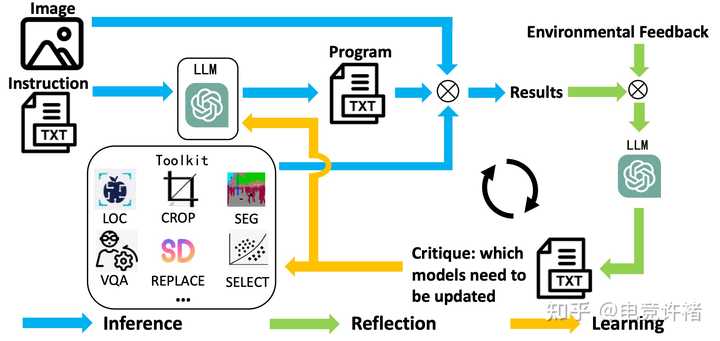

题目:CLOVA: A Closed-LOop Visual Assistant with Tool Usage and Update 链接:https://arxiv.org/pdf/2312.10908.pdf 设计了闭环学习框架,赋予tool-usage visual assistants 更新所使用 tool的能力。 |

|

|

|

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |