| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> DeepMind 提出可交互生成式世界模型 Genie,有什么意义?和 Sora 比有什么不同? -> 正文阅读 |

|

|

[科技知识]DeepMind 提出可交互生成式世界模型 Genie,有什么意义?和 Sora 比有什么不同? |

| [收藏本文] 【下载本文】 |

|

项目网站: https://sites.google.com/view/genie-2024/ 刚刚,谷歌定义了生成式 AI 的全新范式 —— 生成式… |

|

Genie的最大意义在于:再次揭示了生成式模型在通往AGI的路上将要发挥的重要作用。 在阅读答案之前,请读者先思考一个问题:CV生成式模型有什么用?也许你想到了DALL-E、Stable Diffusion、Sora这样的模型,然后回答:“生成式模型可以生产娱乐内容”,或者“生成式模型可以辅助人类创造多媒体资产”。不过在我看来,这只是生成式模型的初级价值,而不是它的最终价值。 CV生成式模型的最终价值在于:它可以帮助人们以更小的代价去模拟这个世界,从而允许AI算法在模拟世界中学习,最终走向AGI。 如果要充分理解上面这句话,就要接受如下的观点:AI算法的智能程度,完全取决于它的训练环境的真实性和复杂性。之所以NLP领域能够创造出GPT这样强大的AI,就是因为NLP所需的环境比较简单,可以通过对话(chat)任务模拟出来。反观CV领域,所需的环境要复杂好几个数量级,而目前还没有已知的方式进行模拟,因而CV领域就很难构建出GPT这样的AI。如果想要详细理解上述观点,可以看我去年写的文章。 谢凌曦:【VALSE 2023】走向计算机视觉的通用人工智能:GPT和大语言模型带来的启发606 赞同 · 39 评论文章 |

|

|

当时我写道,CV面临的困难之一,是构建更复杂的虚拟环境: 更复杂的虚拟环境。当前构建虚拟环境的方法主要有两种。一是基于真实数据产生的虚拟环境:收集实际场景数据,并将其建模为点云、面片(mesh)、神经辐射场(NeRF)等数据结构,并支持高速、大规模的渲染。这种做法的成本还比较高,难以规模化生产环境。当前可用的3D数据集(如Habitat[1]),相比于2D数据集,规模要小好几个数量级,且依然局限于某些特殊场景(如室内或者街景)。二是通过仿真学方法构建虚拟环境:通过3D建模、生成式算法(包括GAN和扩散模型)等方式,直接采样虚拟数据并渲染3D环境。这种做法虽然能够批量生成环境(如ProcTHOR[2]),但它不易还原真实世界的数据分布。一方面,图像上通常包含影响算法学习的artifacts(即使肉眼难以观察出来),从而难以保证在虚拟数据上训练的模型的迁移能力。然而不论是哪种方法,虚拟环境的大小和真实度还不能满足要求,且难以允许AI算法与环境中的其他智能体互动。 我甚至认为,这是未来3-5年整个CV领域最重要的任务,没有之一。Genie的出现,让我看到了一些希望,即生成式模型能够帮助我们更快地构建大规模的虚拟环境。虽然Genie的效果还比较差[3],能力还有诸多不足,但它走在正确的道路上。 最后简单说说跟Sora的区别。根据Sora的demo判断,我认为它至少拥有和Genie相当的模拟世界的能力,也能够通过prompt来生成未来将要发生的场景。因此,Genie看起来像是Sora的一个子集,只是速度应该会比Sora快上不少。有理由相信,OpenAI也在投入相同的方向,或许过段时间就会发布一个具有类似逻辑,但是能力更强的模型。 参考^Savva M, Kadian A, Maksymets O, et al. Habitat: A platform for embodied ai research[C]//Proceedings of the IEEE/CVF international conference on computer vision. 2019: 9339-9347.^Deitke M, VanderBilt E, Herrasti A, et al. Procthor: Large-scale embodied ai using procedural generation[J]. arXiv preprint arXiv:2206.06994, 2022.^目前看来,Genie似乎对于较长的交互序列不能保证稳定,同时生成的图像质量较差,在自然图像上会产生大量artifacts。 |

|

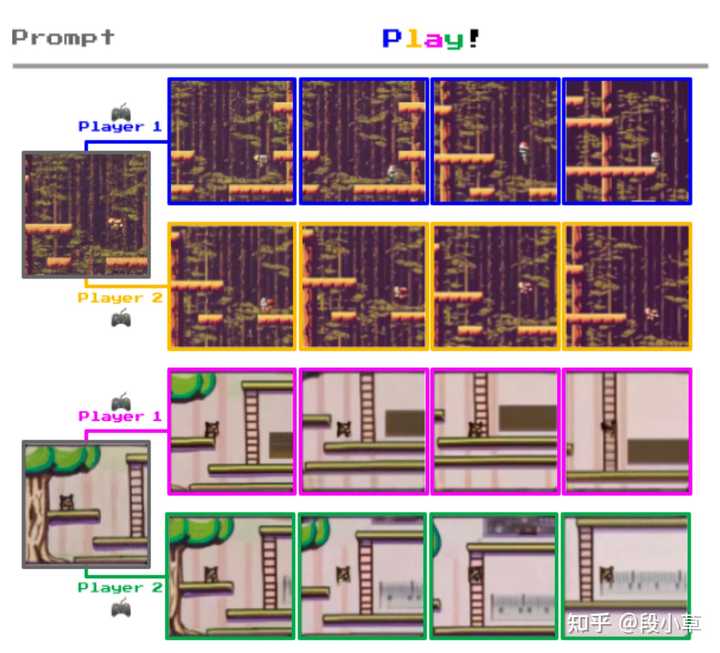

我从容易理解的角度说一下,顶蘑菇大家都玩过吧。 |

|

|

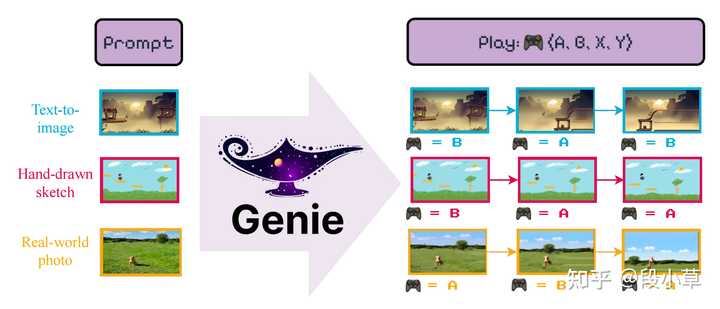

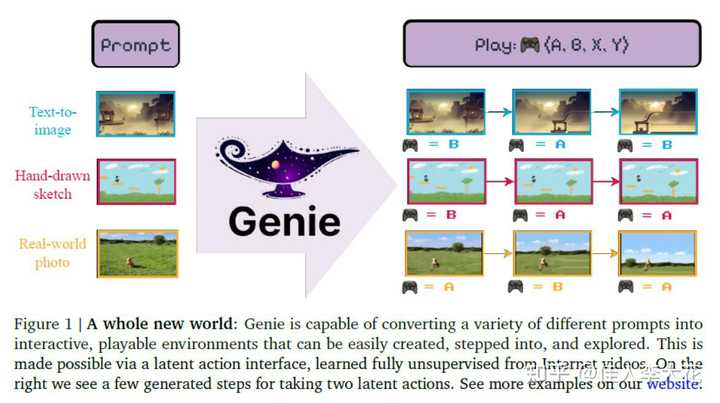

Sora做的是:你给他一个prompt,比如生成一段在森林里顶蘑菇的视频,然后它就会在一段时间内给你提供一个顶蘑菇的视频。 Genie做的是:你给他一张顶蘑菇的截图,给你一个游戏手柄,然后图片会动起来,动的逻辑会跟你手柄的操作逻辑是一致的。 这俩有本质上的不同,Sora是端到端的,你提供prompt,它提供视频,中间没有交互;Genie提供了交互的机会,理论上你不停,储存足够,电力不停,那视频就会一直持续。 这也是Genie名字的来源Generative Interactive Environment(生成式可交互环境)。 Generative生成式说的是视频生成这一部分,Interactive可交互就是我说的游戏手柄,Environment环境就是Genie所说的世界模型,它是逐帧的可交互的世界模型。 |

|

|

例子1图片 |

|

|

例子1生成视频 |

|

|

例子2图片 |

|

|

例子2视频 |

|

|

你可以从这些视频上找到很多熟悉的身影,比如魂斗罗之类的。 |

|

|

非常惊艳的作品。 我没看到可以开枪的那类型视频,如果可以实现,那可以在二维世界中验证,这个世界模型是否可以理解被击毁、碎片掉落这类型的逻辑,如果可以,那同样的逻辑就可以迁移到3维世界里。 |

|

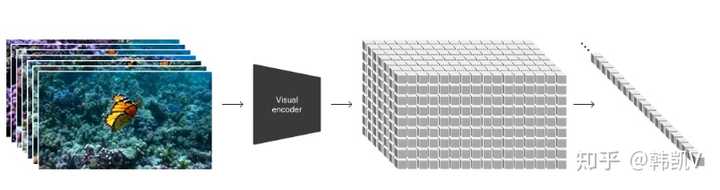

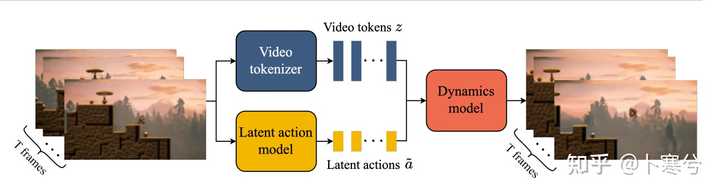

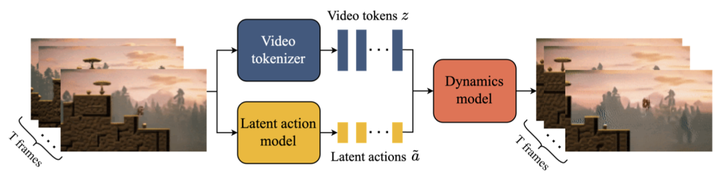

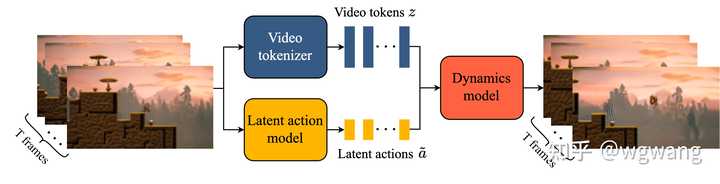

省流:完全由视频训练而来,可以实现文/图生成可交互环境(类似2D横版游戏的操作)。 Genie[1] 基于ST-Transformer架构,是第一个在无监督学习下从互联网视频中训练出来的可生成交互环境得模型,训练素材是超过20万小时的公开在线游戏视频数据集。 Genie可以通过文本、合成图像、照片、草图等方式描述和生成无数个可控制动作的虚拟世界。Genie具有11亿参数,可以被视为一种基础的世界模型。它由一个时空视频 tokenizer、一个自回归动力学模型(autoregressive dynamics model)以及一个简单且可扩展的潜在动作模型(latent action model / LAM)组成。Genie可以在没有真实动作标签或其他领域特定要求的情况下,让用户以帧为单位在生成的环境中进行操作。此外,通过学习到的潜在动作空间,还可以训练出能够模仿未见过的视频行为的 Agent,为未来通用 Agent 的训练铺平了道路。 |

|

|

相比于 Sora 作为图像/视频生成,Genie 多了交互性,也就是在文/图基础上生成了可交互的世界,也就证明在生成过程中,模型能够在一定程度上理解空间和物体之间的互动关系。 |

|

|

Genie包含三个关键组件: 一个潜在动作模型(LAM),用于推断视频帧之间的潜在动作;一个视频 tokenizer,将原始视频帧转换为离散的 token;一个动态模型,根据当前帧的 token 和潜在动作预测下一个帧。 整个模型分为两个阶段进行训练,首先训练视频 tokenizer,然后训练潜在动作模型和动态模型。 |

|

|

Genie 的缺陷: Genie可能会产生不真实的未来场景(类似 LLMs 的幻觉);尽管在时空表示上取得了进展,但仍然受到内存限制,只能记住 16 帧,难以在长期内保持一致的环境。Genie 目前的运行速度约为每秒 1 帧,并且需要未来的进步才能实现高效的帧速率进行交互。 我觉得 Genie 的意义在于,证明模型的确可以从视频/图像中学习到「一定的物理规则」,如果说 Sora 只是生成了看似符合规则的视频,那么 Genie 则更进一步,做出了可以交互的环境,在这个环境中,有动作,也有和环境要素之间的障碍、碰撞等交互。尽管这样的「物理规则」不那么精确,但的确是通过学习/预测而来。 就像 Genie 论文里自己说的,Genie 的意义不止在于可以让大家体验到自己生成游戏的乐趣,更在于可以训练通用 Agents,通过在更多视频(不只是横版游戏视频)下学习,帮助 Agents 程序模仿来从未见过的行为(即给定起始帧,预测不在学习材料中的环境交互行为)。 参考^https://sites.google.com/view/genie-2024/ |

|

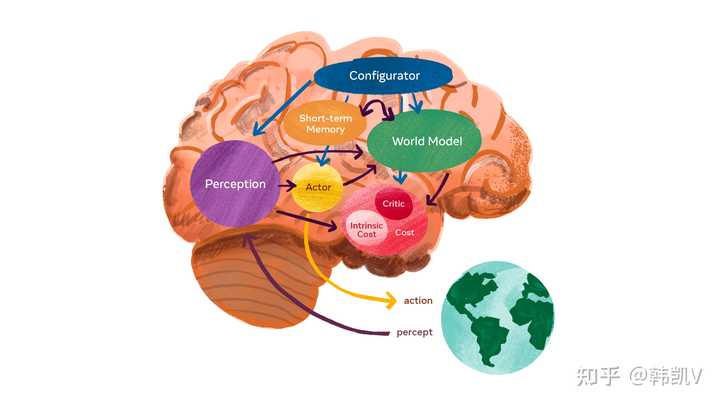

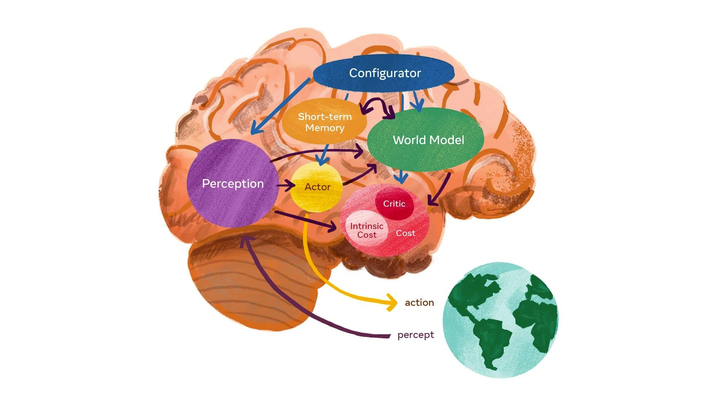

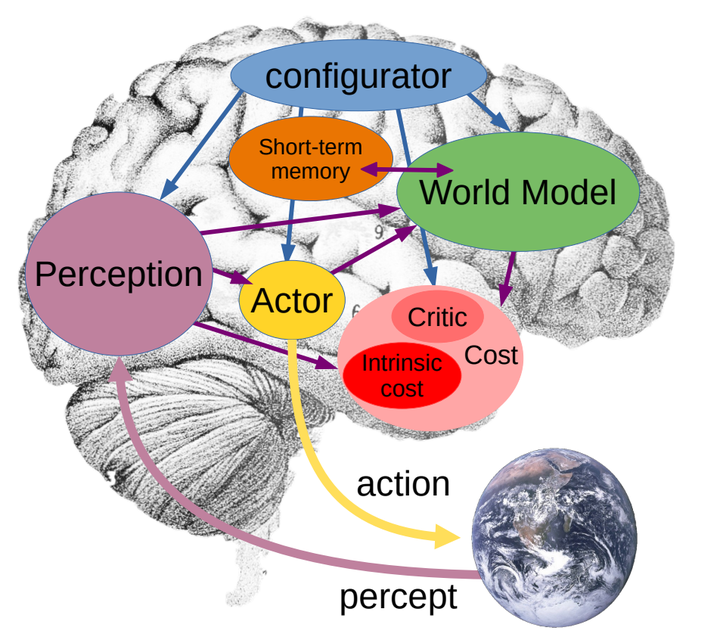

谷歌这次是想通过世界模型来弯道超车OpenAI啊,因为后者前几天发布的Sora也号称是世界模拟器(World Simulators),不过谷歌的Genie更接近传统意义上的世界模型[1]。关于世界模型的介绍,详细可参考俞扬老师的文章:俞扬:什么是world models/世界模型,大概是意思是超越感知模型,还要有模拟和想象世界变化的能力。 |

|

|

那么比较有代表性的世界模型工作有: 视觉自回归模型:以视觉生成为中心,通过自回归学习的方式对环境(以视频为载体)进行建模,从而学习到一个能表达世界的模型。代表工作有:谷歌Genie[2]、伯克利LVM[3],顺便推广一下我们近期的工作DeLVM[4],如何高效构建LVM: 九亿少年酒后的梦:DeLVM:自回归视觉模型的高效训练方法12 赞同 · 0 评论文章 文生视频模型:如Sora自己的标题“Video generation models as world simulators”所说,openai希望通过视频生成大模型来构建物理世界的通用模拟器。 |

|

|

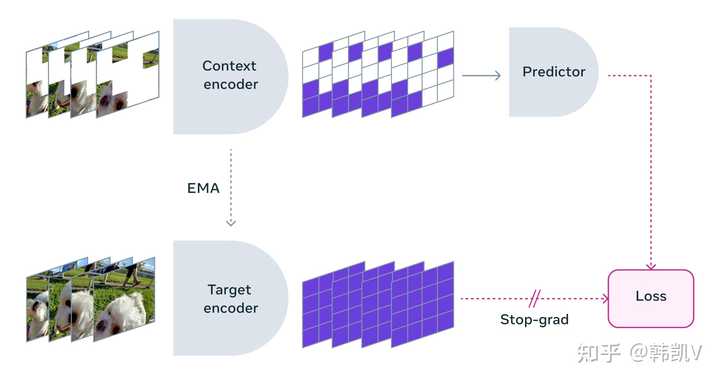

对比学习:这是Yann Lecun一直在倡导的世界模型路径,代表工作是他的V-JEPA[5],通过对比学习的方式学习视频的抽象表征。不过个人不太看好这条路,只是学习到了中间表征,没法直接用于下游任务。 |

|

|

参考^Yann LeCun on a vision to make AI systems learn and reason like animals and humans https://ai.meta.com/blog/yann-lecun-advances-in-ai-research/^Genie: Generative Interactive Environments https://arxiv.org/abs/2402.15391^Sequential Modeling Enables Scalable Learning for Large Vision Models https://arxiv.org/abs/2312.00785^Data-efficient Large Vision Models through Sequential Autoregression https://arxiv.org/abs/2402.04841^V-JEPA: The next step toward Yann LeCun’s vision of advanced machine intelligence (AMI) https://ai.meta.com/blog/v-jepa-yann-lecun-ai-model-video-joint-embedding-predictive-architecture/ |

|

短期内不好看,我个人观点单纯视觉的无监督模型还不成熟,短期内不会带来比较大的突破。 Genie本质上还是一个条件视频生成模型,只不过这里的条件是通过无监督学习到的latent action,问题来了,论文里面的latent action空间大小只有8,这就是Genie最大的局限了,真实的物理世界岂能是8大小的空间能表达的。 我个人觉得视觉生成还是看好多模态的路线,就是用文本来控制生成。OpenAI最早做Image GPT,后来有转做更成功的多模态模型CLIP和DALLE,以及现在的Sora,无不是最好的证明。 之前红极一时的自监督视觉模型如moco和simclr只能成为下游任务的backbone,而后来出来的CLIP、DALLE和SD却已经成为真正的生产力。 把无意义的像素和人类可以理解的自然语言绑定是一个更好的选择。 这次我站队OpenAI。 |

|

眼前一亮的模型,用 AI 直接生成一个可交互的场景。简而言之,AI 直接生成 2D 游戏,连控制逻辑都不需要去写了!参考下图: |

|

|

源自论文《Genie:Generative Interactive Environment》 需要特别强调的是,这个模型并不是生成了一堆元素供游戏引擎调用,而是这个模型本身就替代了游戏引擎的部分计算功能!它可以直接通过 T0 时刻的画面 + 用户数据入的指令来合理预测 T1 时刻的画面,从而提供一个可互动的场景,并不需要额外加一个游戏引擎程序!现在连游戏引擎本身的计算逻辑竟然都可以被生成式神经网络替代了?控制论再一次哭倒。 当精度不断提高后,这个模型可以解决过去 RL 等网络训练场景不足的问题。论文也提到,该模型有潜力给未来的 Agent 提供"无限"的交互场景。这可能也是 Google 探索该模型的动机。虽然个人总感觉这有些套娃的味道,毕竟 AI 训练是为了和人类价值对齐。那么如果 AI 训练的场景是由另外一个 AI 生成的,就有点自依赖的味道了。 值得注意的是,这个模型大量使用了 ViT (Visual Transformer)模型。没错,大名鼎鼎的 Transformer 又出现了。前段时间爆火的 SORA 的关键结构 DiT(Diffusion Transformer)也用到了 Transformer。现在 Transformer 越来越有种统一 AI … 算法工程师只需要猛加参数量 + 数据的味道了。 总之,该模型进一步拓宽了生成式 AI 的可能性,兴许未来会有更多生成式 AI 发光发亮的场景。这值得期待。 |

|

看了一会案例动画视频,第一个冒进我脑子里的想法是:以后我可能会有好多好多类似于超级马里奥兄弟的游戏玩啦! 我感觉这些2D横板的world设计得都挺好看,如果再结合关卡、障碍和各种敌人,可玩性应该很不错欸。 前两天看到魂斗罗重制版即将登陆PS和Switch,玩了试玩关卡,找回了小时候的感觉。不过有点遗憾的就是,关卡依然是那些熟悉的关卡,如果未来能做出来更有想象力,更有挑战性的游戏,说不定横板游戏还能再创辉煌呢! |

|

|

开心的YY完了,正经看看人家的论文。文章的第一张图,就清晰明了的概述了genie构建的“新世界”: |

|

|

想象一下,你可以用一句话、一张图或者一张照片就创造出一个小世界,并且在这个世界里做不同的事情。 在这个示意图里,有三个小框框,每个框框里都有一个不同的场景:一个是从文字生成的图像,一个是手绘的草图,还有一个是真实世界的照片。然后,“Genie”就像个魔术师一样,把这些场景变成了可以玩的小游戏。在图的右边,你可以看到按不同的按钮(比如“A”和“B”)会在游戏里做不同的动作。这就像是在电脑上玩游戏,但是这个游戏是你自己用一个图片或者一句话创造出来的。 看效果确实足够炫酷,仔细读一读模型的技术部分,我觉得Genie和目前流行的大模型们主要有几个不同: Genie学习互联网视频,却并不依赖标记或注释的动作数据。它能够通过学习潜在的动作空间控制每一帧,不需要定义明确的动作标签。这与目前大模型们多依赖监督学习或半监督学习的方法不太相同。Genie不仅可以生成图像或视频,最重要的是,它能够创造出可交互、可玩的环境。用户可以在这些环境中进行帧级的控制,也就是说,用户们可以控制环境中发生的每一项动作。Genie使用的核心设计是基于空间时间Transformer架构,这是一种特殊的Transformer,用于处理视频等具有时间和空间维度的数据,与只处理静态图像的传统Transformer模型有很大不同。Genie采用一个自回归的动态模型,用于预测视频的下一帧。这种模型能够在给定当前帧和潜在动作的情况下,自动预测下一帧的样子。Genie展示了在增加计算资源的情况下,其架构能够充分的扩展,最终达到了11亿参数量,显示了它的可扩展性以及处理大规模数据集的能力。Genie在不同的环境(如2D平台游戏和机器人视频)中展示了模型的通用性,并且在未见过的视频上进行了行为模仿训练,表明其未来或能成为一款通用智能体。 我觉得谷歌这一轮就是在向世界“秀肌肉”,展示“大力”确实能够出奇迹! 从视频生成的角度来说,我并不认为Genie可以胜过Sora,但是在生成的视频中直接增加按钮,确实是一项很厉害的创新,让每个人都能成为游戏设计师。 不过目前的游戏生成效果让我不禁联想起曾经的元宇宙,希望谷歌再接再厉,生成像素级2D游戏显然不符合现在的市场需求,能直接生成3D大作才能彰显实力! |

|

大概看了一下官方论文,虽然都是生成视频,但是 Genie 是一个跟 Sora 或者说其他文生视频模型路线差异非常大的模型。 |

|

|

Genie: Generative Interactive Environments 简单说,Genie 是根据一张初始图像和一组“潜在动作”(latent actions)生成一段视频,这里面潜在动作是核心,它作为一组条件,使得模型生成的下一帧图像是可控的,用户可以指定场景接下来以什么动作/剧情“演下去”,这就是谷歌为什么称之为是交互式的生成模型。 我觉得这也是 Genie 跟 Sora 等文生视频区别最大的地方。 对于 Sora 这样的 text-to-video 模型,用户提供一段文字描述给模型之后,就什么都控制不了了,生成的视频是什么样的,完全看模型自己对 prompt 的理解和推理能力。也就是说这个过程是不可控的,你没法指定视频按照你想要的方式生成。 Genie 通过训练一个“潜在动作模型”学习两个视频帧之间的联系。 |

|

|

模型包含三个关键组成部分: latent action model ,用于推断每对帧之间的潜在动作;video tokenizer,将原始视频帧转换成离散的 tokens;dynamics model,给定一个潜在动作和过去视频帧的 tokens,预测视频的下一帧。 训练阶段只需要用到视频数据,采用无监督的方式,模型能学习到一段视频中哪些部分是可控的,并且推断出各种潜在动作,这可以看作 Genie 模型理解世界的方式。 在推理阶段,模型根据提供的初始图像和指定的动作顺序集,不断地预测下一帧图像。 |

|

|

所以,在官方发布的博文中可以看到,给定一组顺序相同的潜在动作的情况下,尽管图像prompt不同,模型能够生成行为一致的视频。 比如,下面4段视频的 latent actions 都是{6, 6, 7, 6, 7, 6, 5, 5, 2, 7},类似于完成一个向前的跳跃动作。 |

|

|

|

|

|

|

|

|

|

|

|

虽然从实际效果看,Genie 生成的视频还很初级,而且目前学习到潜在动作的数量也有限,官方论文中提到目前latent action的数量设定为 8,所以现在来看,还只能生成一些简单的行为模式。 但如上所说,这个工作有意思的地方在于它把 AI 视频生成变成了可控的,通过可交互的方式,用户就像编辑文字一样可以编辑视频。 当然核心问题是要落到模型学习latent actions的能力如何,尤其是推及到更复杂和一般化的视频场景中。现在官方演示的主要集中在游戏和机器人场景中,而且从演示的视频来看,动作和行为模型都是比较简单的(相对于真实的物理世界)。 所以,如果真的让模型理解世界,或者说成为所谓的“世界模型”,未来可能还是要落到基于大量的数据训练上,自然也需要更大的模型(目前Genie参数数量是11B)。不过,Genie 基础架构也是用的 Transformer,简单粗暴地通过 scale up 提高模型的学习和推理能力也不是不可能。 |

|

|

这是和OpenAI的Sora杠上了。上周,谷歌先是推出了最新版的Gemini,几小时之后,OpenAI就发布了公司的首个视频生成模型——Sora。技惊四座,一下把Gemini的风头全部抢过去了。 仅仅一周左右,谷歌就宣布推出可交互式生成模型Genie。 Genie,Generative Interactive Environments,是一个 110 亿参数的基础世界模型,可以通过单张图像提示生成可玩的交互式环境。根据官网介绍,Genie是一种由互联网视频训练出的基础世界模型,能够从合成图像、照片甚至草图生成无穷无尽的可玩(可动作控制)世界。 |

|

|

在过去的几年里,生成式人工智能开始出现,这些模型能够通过语言、图像甚至视频生成新颖且富有创造性的内容。谷歌称Genie是一种新范式,即生成式交互环境(Genie),通过该范式,可以从单个图像提示生成可交互的、可玩的环境。 Genie是从一个包含大量公开互联网视频的大型数据集中训练出来的。主要关注2D平台游戏和机器人技术的视频,但是是通用的,应该适用于任何类型的领域,并且可以扩展到更大的互联网数据集。 Genie的独特之处在于,它能够仅从互联网视频中学习精细的控制。这是一项挑战,因为互联网视频通常没有关于正在执行的动作的标签,甚至没有关于应该控制图像的哪一部分的标签。值得注意的是,Genie不仅学习观测中哪些部分通常是可以控制的,而且还推断出在生成的环境中保持一致的各种潜在动作。请注意,相同的潜在动作在不同的提示图像上是如何产生相似行为的。 |

|

|

只需要一张图片,就能创造一个全新的交互环境。这为生成和步入虚拟世界打开了各种新方式的大门,例如,我们可以采用最先进的文本到图像生成模型,用它来生成起始帧,然后借助Genie让这些起始帧变得栩栩如生。在这里,我们使用Imagen2生成图像,并通过Genie让它们活起来。 |

|

|

Genie 能做到的不止如此,它还可以应用到草图等人类设计相关的创作领域。 |

|

|

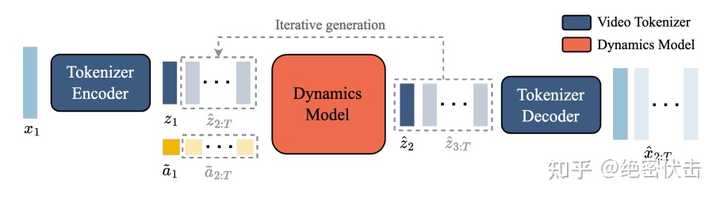

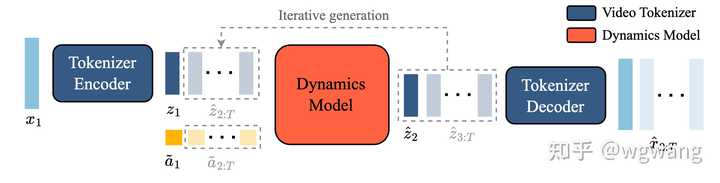

Genie对于训练通用智能体也有影响。先前的工作已经表明,游戏环境可以成为开发人工智能智能体的有效试验场,但由于经常受到可用游戏数量的限制。借助Genie,未来的人工智能智能体可以在一个永无止境的、新生的、生成的世界中接受训练。 Genie技术报告 Genie,这是第一个从无标签的互联网视频中以无监督方式训练的生成式交互环境。该模型可以生成无穷无尽的、可通过文本、合成图像、照片甚至草图描述的动作可控的虚拟世界。拥有110亿参数的Genie可以被认为是一个基础世界模型。 Genie主要包含三个组件:潜在动作模型(Latent Action Model ,LAM)、视频分词器(Video Tokenizer)、动态模型(Dynamics Model)。 Genie的模型结构如下所示: |

|

|

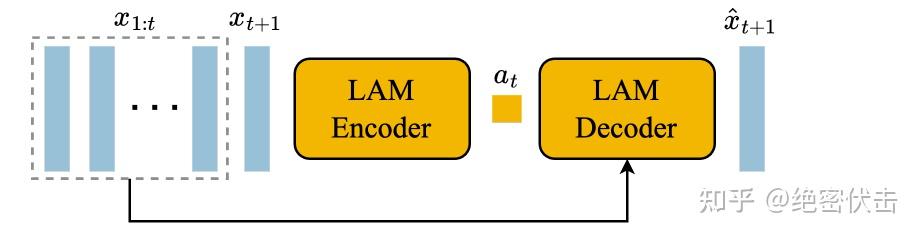

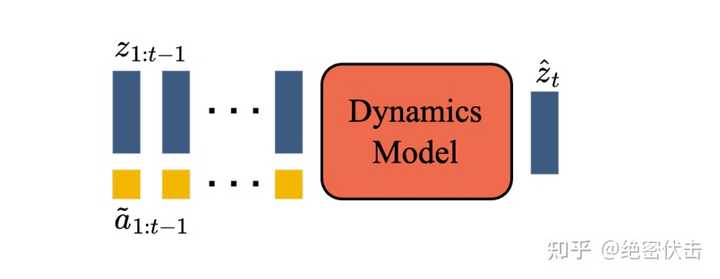

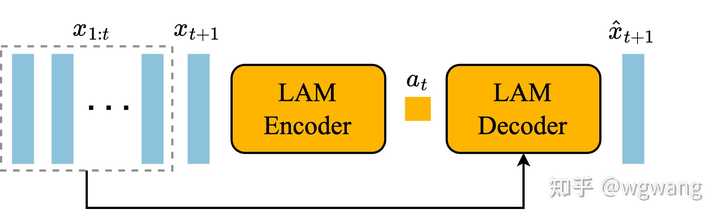

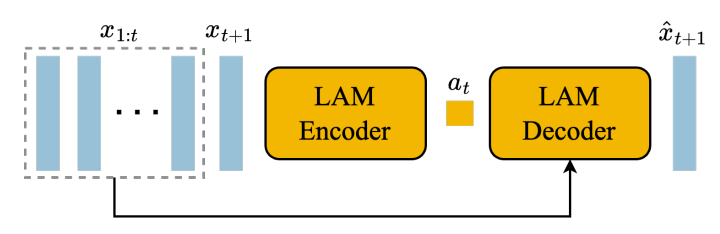

Genie将 帧视频作为输入,通过Video Tokenizer将它们标记为离散的token ,并使用Latent action Model 推断每帧之间的潜在动作 ?。然后,两者都被传递到Dynamicds model中,以迭代方式为下一帧生成预测。 Latent action Model的结构如下所示: |

|

|

是一个encoder-decoder架构。 分词器使用标准的VQ-VQAE进行训练,过程如下: |

|

|

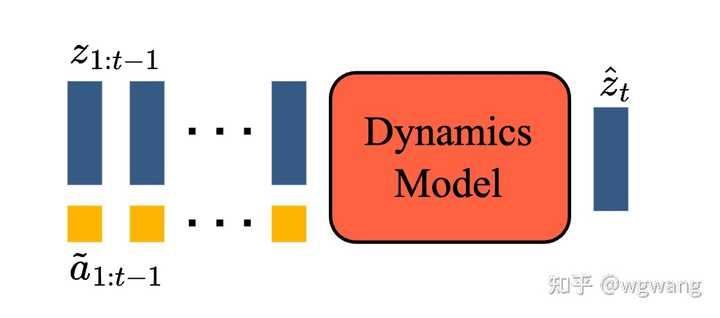

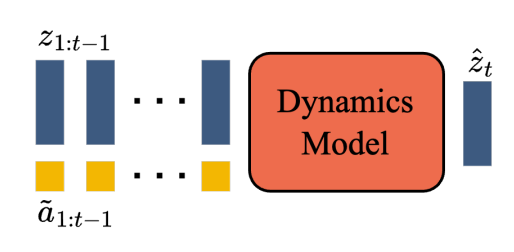

动态模型:是一个仅包含解码器的 MaskGIT transformer,如下图所示: |

|

|

下图是Genie的推理过程: |

|

|

更多技术报告细节,可以参考下面链接: Genie: Generative Interactive Environments |

|

Sora这才问世不久,DeepMind的世界大模型Genie也紧随其后崭露头角!· 关于Genie 就在昨天,谷歌DeepMind团队发布的这一基础世界模型Genie,是现阶段市面上唯一一个仅通过超20万小时的公开在线游戏视频数据集而训练出来的可生成交互环境的模型,这也就意味着Genie需要自行从视频中识别出不同动作的特征和模式。 |

|

|

也正是因为这独特的训练方式,Genie具备了可用于推断每对帧之间潜在动作的能力、将原始视频帧转换为离散token以及用于在给定潜在动作和过去帧token的情况下,预测视频的下一帧的这三大能力。 · 区别于Sora 和竞争对手OpenAI两周前火遍全球的文生视频模型Sora同为“世界大模型”的它,事实上也存在着明显的区别。 在视频的生成上,Sora采用的方式是直接将文字生成视频,这种模式就会更加倾向于“大力出奇迹”;而Genie从目前官网上披露出来的情况来看,大部分情况下还是需要先用文生图模型来生成起始帧图片,再用Genie二次生成视频。 |

|

|

另外在视频生成的时长上,Sora可以生成的视频时长高达一分钟,而Genie则基本维持在一两秒左右,比起说是视频,其实更像是动图。 · Genie的现实意义 然而不管是Sora也好,Genie也罢,仅仅只是把它们当做一个普通的视频生成工具就有些过于大材小用了。 实际上,作为“世界模拟器”的它们,主要想要实现的是让虚拟世界模仿现实物理世界的各种属性(重力、摩擦力、动能、光、声、电、材料、生物等等),在虚拟世界中操控物体动作,在仿真的物理条件下来做实验。 这样一来能够为我们带来的最大好处,就在于大家可以通过它们来把需要试错的部分放在虚拟世界中进行。 |

|

|

它们的意义就不再只局限于让大家体验到自己生成游戏/视频的乐趣,更多的是在于训练通用的Agents。 通过在更多视频(不只是横版游戏视频)的学习下,帮助Agents程序来模仿从未见过的行为(即给定起始帧,预测不在学习材料中的环境交互行为),为未来通用Agent的训练铺平道路。 说白了,当Genie和Sora这类世界模拟器推出之后,也就意味着当下的人工智能正在步入一个更为高级的层面和领域。 |

|

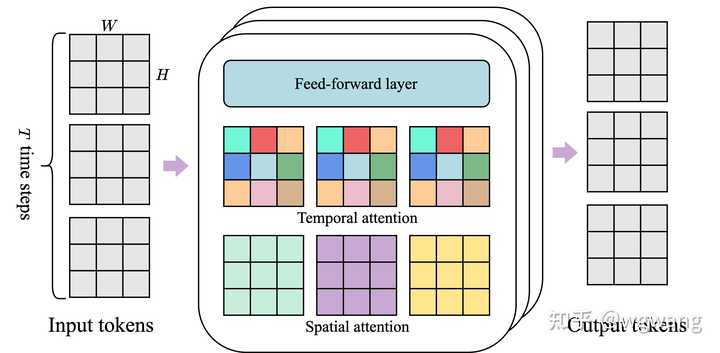

条条大路通往 AGI,但共同点都是“规模”:需要很多很多的数据,使用很大很大的模型,用很强很强的算力去把模型训练出来,在标注很多数据来实现这个。 简单地说,这个Genie可以自行理解(无监督训练)并创建新的视频(生产视频)。它宣传很牛,但实际效果有待验证。 不过,Genie 的出现,基本上可以确定: 去年大厂卷大语言模型 今年大厂卷视频模型 去年的赢家是 nvidia 今年的赢家还是 nvidia 国内呢,去年没有赢家,今年估计是华为 下面是模型的简要介绍 Genie是一个由纯视频数据训练的生成交互式环境。Genie架构中的几个组件基于视觉变换器网络(ViT)(Vaswani等人,2017 年; Dosovitskiy等人,2021)。值得注意的是,变换器的二次内存成本对视频构成了挑战,视频可以包含高达字母O?(10^4)词元(token)。因此,我们采用了具有内存效率的ST变换器架构(下图)所有模型组件,平衡模型容量和计算约束。 |

|

|

st变换器网络 与每个词元都关注所有其他词元的传统变换器网络不同,ST变换器网络包含字母L时空块与交错的空间和时间注意力层,然后是前馈层(FFW)作为标准注意力块。每个时间步骤内,空间层的自我关注超过1×H×W词元,跨T时间步骤,在时间层参加T×1×1词元。与序列转换器类似,时间层采用带有因果掩码的因果结构。至关重要的是,我们的架构中计算复杂性的主导因素(即空间注意力层)与帧数成线性关系而不是二次方关系,这使得视频生成在扩展交互上具有一致的动态性更加高效。此外,请注意,在 ST 块中,我们在空间和时间组件之后仅包含一个 FFW,省略了后空间 FFW 以允许扩大模型的其他组件,我们观察到这显着改善了结果。 2.1模型组件 如下图所示,模型包含三个关键组件: |

|

|

1)推断潜在动作的潜在动作模型 在每对帧之间, 2)将原始视频帧转换为离散标记的视频标记器 3)动力学模型,给定潜在动作和过去的帧标记,预测视频的下一帧。 该模型按照标准自回归视频生成管道分两个阶段进行训练:我们首先训练用于动态模型的视频分词器。然后,我们共同训练潜在动作模型(直接来自像素)和动态模型(在视频标记上)。 潜在动作模型(LAM)为了实现可控视频生成,我们根据前一帧采取的动作来预测每个未来帧。然而,此类动作标签在来自互联网的视频中很少可用,并且获取动作注释的成本可能很高。相反,我们以完全无监督的方式学习潜在动作 |

|

|

视频分词器将视频压缩为离散标记以降低维度并实现更高质量的视频生成。这里使用 VQ-VAE,为每一帧生成离散表示。分词器在整个视频序列上使用标准 VQ-VQAE 目标进行训练。 |

|

|

动力学模型 动力学模型是仅解码器的MaskGIT。将潜在行为视为 潜在行为和动力学模型的附加嵌入有助于提高各代的可控性。 |

|

|

下图是Genie 在推理时生成动作可控的视频的过程 |

|

|

|

|

每一次看到国外的 AI 进展我们都不能直接访问,我就会问一下,这样的操作,我们的 AI 是不是永远只能在后面跟随? 在谈世界模型,我想先找一个大家能接受的世界模型的定义:来自于 Yann LeCun 的论文: 可配置性:世界模型可以根据当前任务的不同需求进行配置,这允许智能代理在不同情境下重用相同的模型。预测性:世界模型能够预测未来的世界状态,这包括自然演变或由代理行为引起的变化。层次化:世界模型能够在多个抽象层次上表示感知和行动计划,这使得代理能够在不同的时间尺度上进行推理和规划。自监督学习:文章提出了一种自监督学习范式,用于训练世界模型,使其能够同时产生信息丰富且可预测的表示。能量模型:世界模型的训练涉及到能量模型(Energy-Based Model, EBM),这是一种通过学习能量函数来捕捉输入之间相互依赖性的模型。联合嵌入架构:文章提出了一种非生成性的预测性世界模型架构,称为联合嵌入预测架构(Joint Embedding Predictive Architecture, JEPA),它通过学习输入之间的依赖关系来进行预测。层次化规划:文章还讨论了如何使用世界模型进行层次化规划,即在不确定性环境下进行多级规划。 https://openreview.net/pdf?id=BZ5a1r-kVsf |

|

|

而这次我们看到的“Genie”, 可能比单纯的文本生成视频这一类的更接近 世界模型。 它从一个单向的世界变成了“可交互”的,如果这是正确的路,那它必然会有对于完整的 Wolrd 有自己的模拟,可是很遗憾的是,这个东西只介绍了它的效果对于技术路线,好像没有什么细节可言。 我们假设它是真的通过一个或者几个模型,多个 Agent 来完成的,那可能真的是像真实的物理世界一样,是通过各种物理实体的模拟达到了这样一个效果。 而这,可能是一个最正确,最经典的方式,通过模拟所有的存在来完成,它准确,但是它的计算量如果没有一个特别优秀的方式,很难做到实用。 但是不妨碍它是一个对未来 AGI 的精典试探。 相比于 SORA 的可能性的大力出奇迹,我更喜欢 Genie 这种方案,因为“大力出的奇迹可能只能到那儿”,尽管这个东西可能达到模拟人的智能,但是它的成本应该是极高的,在现有的算力/能源成本下,不太可能达到人人都拥有自己的人工智能的程度。 期望这个 Genie 这个方向有一天能完全模拟这个世界。这样我们就有了非常优秀的世界模型,在这个基础上,我们可以延伸出无数的精典应用!彻底改变我们的生活! |

|

google 的 Gemini 魔法正在施展,而这里的 Genie 又是一个 Gemini 的新拓展。自从 google 将自家大模型 Gemini "扶正" 之后,随之将 Brad 更名为 Gemini、推出开源大模型 Gemma,在大模型应用领域真的是动作频频。这里的 Genie 被定义为 "可交互生成式世界模型",和 Sora 相比有所不同,Sora 就是一个 text-to-video 的视频生成应用,而 google 的 Genie 的重点在 "交互"、在 "动作可控"。看了 Gemini 发布的官网,一些效果演示视频也主要是在类似超级马里奥的游戏动画生成,这说明 google 认为 Gemini 目前在小游戏动画的生成上面是很有优势的。 |

|

|

当然,"动作可控" 是不是很容易联想到应用到机械人,确实,google 也在发布官网的最后延伸拓展了一下,认为 Gemini 的这种交互式的生成对于多面手智能体的导航定位也有帮助,并演示了在自家的机械手 RT1 上的应用,可以用于生成潜在的机械手动作。 |

|

|

直接对比 Sora,在视频生成效果上明显 Sora 会更加好,而 Gemini 主打的是可控,两者虽同属于视频动画生成应用,但侧重点有所不同,自然应用场景也会有所不同。 自我感想:估计 google 在看到 Sora 这么惊艳的视频生成效果之后,也知道要是硬刚视频内容的高质量很容易碰壁,避其锋芒寻求错位的侧重点是个不错的选择。 |

|

一些答主已经总结了:Genie是一个用视频训练出来的、用于可交互虚拟环境生成的生成器。 那么,为什么不在现实世界中进行直接的交互式训练来做这个生成器?所有已知的视频游戏,都是人类在现实世界中进行了交互式训练之后,根据自身的想象力并利用工具发展出来的。行为作为人类对真实世界的“世界模型”好坏的验证手段是最便利的,但不是现在的人工智能体最方便的手段。虚拟环境构建成本、现实世界实体的试错成本都很高。作为人类日常生活相关的互联网世界,在长期的生产生活实践中已经积累了海量文本、视频,虽然都是人为压缩过的对人来说高密度的信息,但总好过在现实世界的让智能体自己去提取信息了,能喂就不让它自己找吃的,大概是大数据、大模型这条AI技术路线的思路。Sora和Genie是曲线救国,先造个高保真的虚拟环境,虚拟环境再用于更好的AI训练?莫非这就是传说中的“梯云纵”,不停地一脚踩在另一只脚上然后上天?但不管怎么说,它们都是在人类互联网世界的山顶上尝试去飞的非常现实的技术路线,应该而且我也希望它们有更大的发展。 不过答主比较喜欢另一条路线:AI和机器人领域结合。所以有这样一个疑问:什么时候AI领域能和机器人好好结合,直接在现实世界中学习?智能机器人会是下一个技术趋势吗? 外行人之见,大概能知道这条路线中可能存在的问题也非常多。有些话说得比较极端,欢迎拍砖交流。 |

|

做一个基于Action输入生成画面的交互式模型——这个 Idea 我想很多人都想到过,我在很久之前就有类似的想法了 在我当时的想象中,这个模型大概是这样的: 首先它大概是一个基于文本和图像序列再生成新图像的模型,因为这里的“文本”实际也可以是我们输入的Action,Action其实就类似我们敲击的每个按键,wasd space jkl 对应的动作在一个循环的每个周期中接收一个 Action 信息,然后基于Action和当前的画面预测出下一帧的画面如此循环往复就成了一个游戏了 显而易见,要训练出这样的模型,训练数据中的每个样本一定长这样:input 是 Action 和 LatestFrameImages,Label 是 NextFrameImage 但我们不得不回答一个问题,这样的训练数据从哪里来?公开互联网上虽然有海量的游戏视频,但似乎并没有其中最为核心的——每个连续画面所对应的 Action 靠自己收集?显然这样是走不通的,因为自己能收集到的数据太有限了,量级和通用性都不可能满足需要 而 DeepMind 给出的答案就是我们先训练一个能基于连续帧画面得到 Action 的模型,然后再用这个模型结合互联网上的游戏视频数据生成出足量的样本数据 那么如何训练出这样基于连续帧画面输出Action的模型呢,难道我们要先收集 Input 是 CurrentFrameImage 和 NextFrameImage,Label 是 Action 的数据吗? DeepMind 这时又告诉我们,我们并不需要知道 Action 是什么,我们可以直接基于 LatestFrameImages 和 NextFrameImage 训练出一个在 Latent Space 的 Action,我们叫它 Latent Action Model |

|

|

基于 LAM Encoder,我们就能得到 Latent Action 而且最棒的地方在于,这个模型的训练是一个无监督的过程,所以我们只要收集海量视频数据就行,视频数据难道还缺吗?无监督大法好 这就是 Genie 最核心的设计 有趣的是,不同的 Latent Action 可能对应着向前走、不动、向后走、或跳,而这个从 Latent Action 到我们人能理解的动作概念之间的映射关系在训练的时候是并不知晓的,只有当我们使用不同的 Latent Action 实际用 LAM 进行推理之后,我们才能通过观察知道不同的 Latent Action 到底对应了什么动作 有了这个 Latent Action Model,就可以训练出能基于历史图像和动作输入生成下一帧的模型:Dynamics Model |

|

|

有了这个 Dynamics Model,就可以基于任意一张图像作为初始的输入,然后辅助以一个 Latent Action 就能持续的预测出下一帧的图像 Genie 这个模型是很有趣的,可以说这是一个比 Sora 更接近实现 AGI 之路终点的模型,因为 Sora 的突破是一举将文生视频从10分做到了60分,最大的变化不过是投入的算力远超之前的模型,而 Genie 却是给出了一个全新的无监督可交互生成模型的框架,在这个框架下如果进一步 scale 可能会出现很值得期待的结果 设想一下,如果我们并不是在游戏视频的基础上训练这个模型,而是在海量的第一人称现实世界视频的基础上训练呢?那么事情就变成了: 基于海量的第一人称现实世界视频训练一个 Latent Action Model搞清楚不同的 Latent Action 到底对应了人的什么行为,比如左看、右看、抬头、前进、后退、伸手、握拳、说话、等等等等基于 LAM 和海量的第一人称现实世界视频标注出视频对应的 Latent Action训练出一个超大的 Dynamics Model 等等,或许不应该再继续叫它 Dynamics Model 了,现在应该称它为:人生模拟器 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |