| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> Sora懂不懂物理世界? -> 正文阅读 |

|

|

[科技知识]Sora懂不懂物理世界? |

| [收藏本文] 【下载本文】 |

|

我们真实的视频是会体现 真实世界的物理规律,以航行为例这意味着 AI 需要考虑到重力、浮力、碰撞以及船体结构在动态环境中的行为。那么问题来了,Sora… |

|

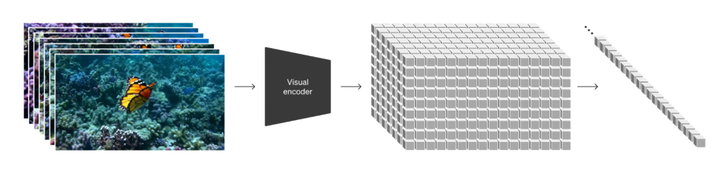

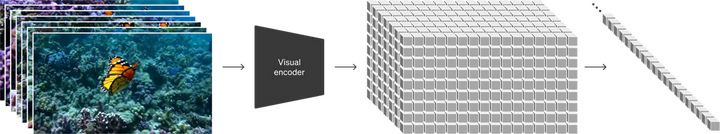

丘成桐先生的弟子, 纽约大学石溪分校教授, 计算机图形学专家顾险峰从数学角度给出了很精到的分析: 顾险峰教授在文中列举了Sora生成视频的物理问题,总结如下: 首先,用概率统计的相关性无法精确表达物理定律的因果性,自然语言的上下文相关无法达到偏微分方程的精密程度;其次,Sora无法判断全局的合理性。虽然Transformer可以学习临近时空令牌间的连接概率,但是整体的合理性需要更高层次的数学理论观点、或者更为隐蔽而深厚的自然科学和人文科学的背景,目前的Transformer无法真正悟出这些全局观点;另外,Sora忽略了物理过程中最为关键的临界态。一方面因为临界态样本的稀缺,另一方面因为扩散模型将稳恒态数据流形的边界模糊化,消弭了临界态的存在,生成的视频出现了不同稳恒态之间的跳跃。Sora的基本原理[1] Sora的训练集为短视频集,每个样本是一个短视频,Sora将其编码到数据空间进行降维,然后在隐空间中将特征向量切割成补丁,加上时间顺序,构成时空补丁,亦即时空令牌(time-space token);每个令牌在短视频的帧序列号(时间),在当前帧的行列序号(空间)都被记录在令牌里。 |

|

|

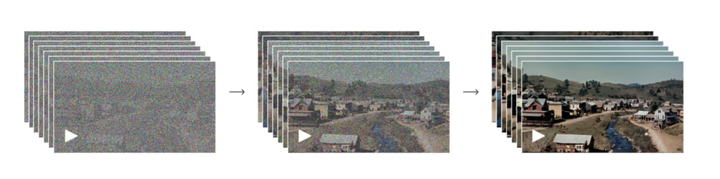

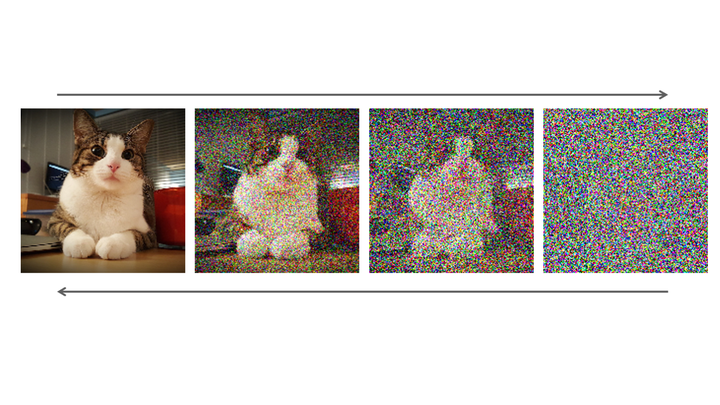

Sora 将视频编码映射到隐空间,再切割成时空补丁,被称为时空令牌(time-space token) 进一步地,Sora在数据空间将数据令牌的概率分布通过扩散过程传输变换成高斯分布,再通过传输变换的逆变换将隐空间中的白噪声令牌变成隐数据令牌。对于有些标题过于简短,字幕缺少的视频,Sora采用了Dall-E的重新标题技术。 |

|

|

Sora用扩散模型从白噪声时空令牌生成数据时空令牌Sora 的问题和不足 然而,Sora在如下方面存在着不足: 相关性与因果性 Sora无法精确表达不同令牌间时空的因果关系。如下展示的吹蜡烛过程中,每一帧都异常逼真,但是当老奶奶吹了生日蜡烛的时候,蜡烛的火苗纹丝不动。如果我们将视野缩小到每一个令牌的区域,我们看到美轮美奂的真实画面,令牌之间的衔接也非常平滑自然,但是当相距较远的令牌之间有因果联系的时候,即吹出的空气影响火苗的跳动时,两个令牌之间的物理因果没有体现出来。 这意味着:Transformer可以表达令牌之间的统计相关性,无法精确表达物理因果律。虽然transformer可以在一定程度上操纵自然语言,但自然语言无法准确表达物理定律,而物理定律目前只有偏微分方程才能精密表达。这反应了基于概率的世界模型的某种局限性。 |

|

|

0 局部合理与整体荒谬 Sora可以合理拼接相邻令牌,但整体视频可能出现悖谬,缺乏全局的合理性:观察下面的“幽灵椅子”视频:如果我们将视野限制在屏幕中间的一个局部区域,则视频非常合理。仔细检测不同令牌区间直接的连接,也非常连续光滑。但是整个椅子如鬼魅般悬空,这与日常经验相悖。 这种“局部合理,整体荒谬”的生成视频,意味着Transformer学会了Token间局部的连接概率,但是缺乏时空上下文的大范围整体观念。在这个视频中,整体观念来自于物理中的重力场,虽然局部看不出来,但是整体上无时不在。 |

|

|

0 常识的缺失 目前的Transformer虽然可以学习局部的上下文,但无法学习更加全局的上下文,这里的全局可能是物理中的重力场,也可以是人体工程学,或者生物中的物种分类。这种全局观点,恰是朱松纯教授提出的AI世界中的暗物质思想。 虽然每个训练样本视频都隐含地表达了全局的观念,但是令牌化的过程却割裂了全局的观念,有限地保留了临近令牌间的连接概率,从而导致局部合理,整体荒谬的结果。 比如,Soar生成的“南辕北辙跑步机”视频,如果我们观察每一个局部区域,看到的视频都是合理的,视频令牌间的连接也是自然的,但是整体视频却是荒谬的,跑步机与跑步者的方向相反。这个视频的全局观与来自于人体工程学的事实相悖。 |

|

|

0 再如Sora生成的“四足蚂蚁”的视频,蚂蚁的动作栩栩如生,宛如行云流水;但是地球的自然界并没有四足蚂蚁。局部的合理无法保证整体的合理,这里的全局观念来自于生物学事实: |

|

|

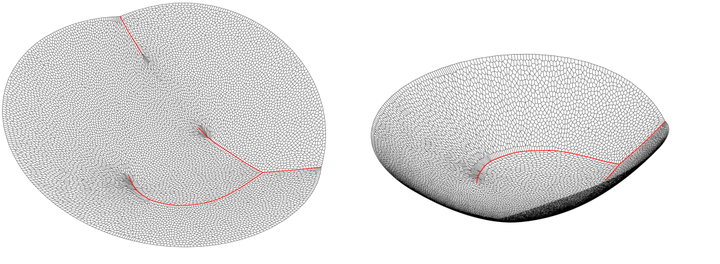

0 数据光滑化对临界信息的缺失 尽管临界事件在物理系统中出现的概率几乎为零,但是却极端重要;Sora倾向于生成平滑的变化过程,忽略了物理过程中关键的临界和相变现象,如杯子的倾倒。 |

|

|

0 下图中的小狗一会变成三个,一会变成四个;Sora的扩散模型没有识别出数据的边界,而是冲破边界,在3只小狗图片的流形和4只小狗图片的流形间跨越。 正确的做法应该是先识别数据边界,然后在物理无法跨越的情形下(如3只变成4只),在边界处返折回原来的模型。 |

|

|

0 |

|

|

Sora生成的物理视频直接冲破了数据空间的边界,而没有在边界处折返。 参考^摘编自顾老师的博文 |

|

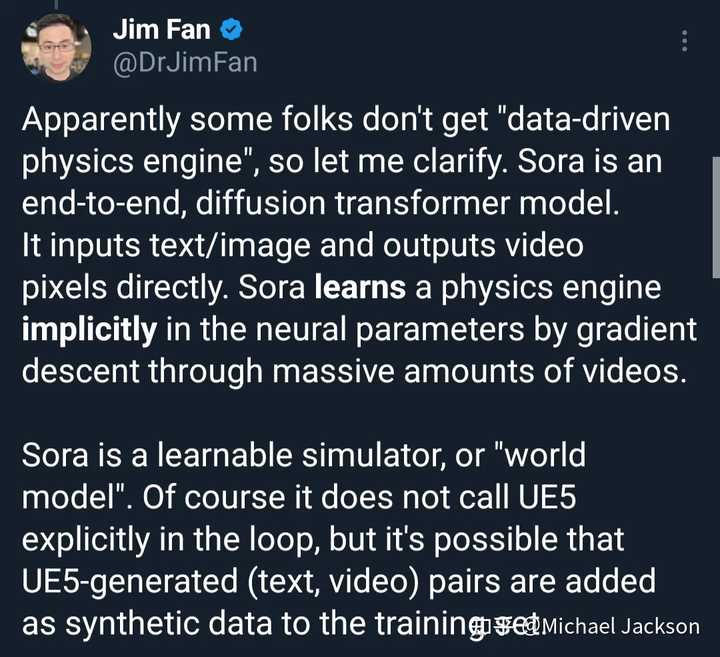

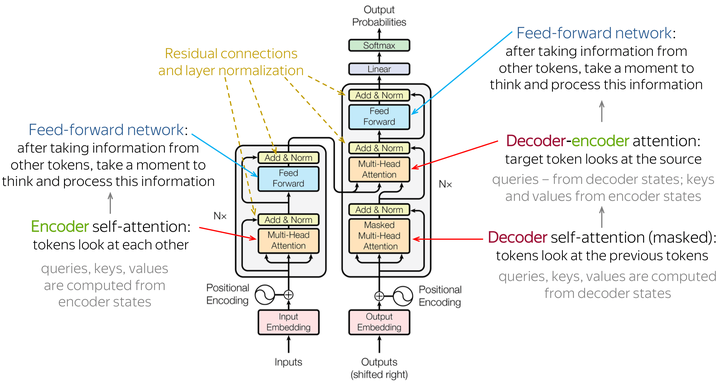

非常好的问题。 这个问题换一种表述就是:基于diffusion model的transformer架构(DiTs),能否实现对于现实场景的泛化预测? 这里首先说一下个人的意见。我觉得这得看要求预测到什么程度:如果是大范围、粗粒度的、小时间范围的,那这种方法能达到非常好的效果;如果是小尺度、细粒度、长时间范围的,那估计会有偏差,甚至会差得比较远。然而不可否认,这种方式已经体现出了惊人的潜力和可能性。 为什么这么说?这是由diffusion model背后的物理图像决定的。diffusion model解决了一个信息丢失还原的问题。拿Sora为例,是根据特定随机数种子,在时空隐空间上根据prompt信息sample出来几个点,再使用diffsion model,尝试在近邻的时空中把相邻点进行还原,再通过decoder还原到pixel级别。 这个过程就像是作家在写小说,先构思几个核心桥段,再根据常识和人物关系、人物特性把它们串起来,输出成一个完整的、跌宕起伏的故事。当然,串起来的过程是否自然,整个故事是否精彩,是由作家的能力来保证的。在Sora中,这部分就是通过训练diffusion model的还原过程。这个过程是通过大量的特征序列来完成,这些特征序列又是通过transformer架构来构建的。transformer的原理这里不再赘述,可以认为它是基于一定长度的tokens/patches从pixel空间映射到不同的latent space 维度上,本质上是一种信息压缩和分解映射。 问题来了: Transformer的分解映射是否能够形成和真实世界的有效对应?从数学角度上说,这种映射是同态映射还是同构?考虑到时空和变化特性,这种映射是否保持了对称性?在拓扑角度是否能保证同胚,是否保证同痕?我觉得这要打一个大大的问号。 要知道,统计上保持一致容易,在精细结构上保持一致是很难的(当然这也有可能是后续的研究方向)。 其次,diffusion model有一个前提假设,就是信息的丢失和弥散是符合高斯型噪音加入的马尔科夫过程。然而,自然状态的高斯分布和马尔科夫性都是不存在的。前者是大数极限下的近似,后者是忽略长程时序路径关联。这件事情之所以重要,是因为物理恰恰要考虑因果、考虑路径。比如磁滞回线、比热、相变等等,而一旦到了微观过程,统计意义上的定律可能就不具有很强的指导性了,更何况因为存在“幸存者悖论”,AI学习的数据本身就是通过人类的喜好筛选过的,这就和真实相差更远了。 不过我们也可以从另一个角度去想这件事。人类所谓“理解物理”,从某种意义上仅仅只是人类有个能work的world model。正所谓“所有的数学理论都是对的,只不过一些是有用的。所有的物理模型都是错的,只不过一些是有用的”。从这个角度上来说,即使Sora的world model有问题,也只不过因为它现在的模型不够好罢了。所以说Sora能够“理解物理”,也不能算完全错到没边。像lecun那样猛批,其实也只是因为政治正确罢了。 以上,欢迎大家在评论区批评指正! |

|

问题如果是Sora能不能像人类那样理解,那肯定是不能;但问题如果是Sora能不能根据自然界的输入给出具有一定程度的可预测的输出,答案是可以。 所以问题的关键就在于,懂应该怎么定义。 对于人类,天然是有一套认知结构的,我们做的说穿了是把现象放进我们的认知框架内得到一套模型,其中需要数学,逻辑,因果等等要素。物理学干的就是这么一件事,最后我们拿着模型(比如BCS理论,金兹堡-朗道理论,比如SM)去和实验对照或者做一些预测,结果也许在一定范围内不错,也许会离大谱。归根结底,我们其实也不是懂自然界,而是用我们的框架去框那个世界。 假设Sora也有认知结构,那么它的认知结构显然和我们是不一样的,它的认知结构说白了就是ai的算法框架。给它一个输入,它也能输出,至于中间是怎么回事,是由它的算法框架决定的,或者说是它的认知结构决定的。 需要注意的是,显然我们和它的认识自然的方式是不太一样的。因此,即便AI能成功计算或者预测到什么现象,也不代表我们懂了,我们还是需要根据它的一些结果去用我们能理解的模型去理解物理世界,当然这个会显著提高我们研究的效率。 总之,AI懂不懂物理世界不重要,但是在AI的辅助下,我们可以更懂物理世界一些。 |

|

做一个不恰当的比喻,现阶段的AI有点类似于还未发展出现代科学的人类,靠经验规律在干活。 通过大量前人的经验统计,人们知道太阳每天会升起、落下,也知道持续加热水会沸腾,也能简单预测天气很冷时会下雪结冰,但不会知道引力、电磁相互作用力、强相互作用、弱相互作用力、相变这些基本物理规律,因而无法理解物理世界的本质。 知乎上的日经问题:href="https://http://www.zhihu.com/question/19696294">为什么华夏有五千年文明,却没有发展出体系化的现代科学? 因此,现阶段AI理解的物理世界与真实物理世界存在本质的差异。 这种差别主要源于AI的理解是基于数据和统计模型的,而不是基于对物理定律的直接认知或感知。 这意味着AI的"理解"更多地依赖于它所训练的数据集中的模式,而不是物理世界的基本原理。 我们举几个简单的例子来看看这种差别: 例子1:物理互动预测真实物理世界:在真实世界中,如果一个人看到一个塔楼正在倾斜,他们会基于对重力的直觉理解预测塔楼最终会倒下。这种预测是基于人类对物理定律(如重力)的基本理解。AI的理解:一个基于数据训练的AI模型,如使用diffusion models和transformer架构的模型,可能能够预测塔楼会倒下,但这是因为它在训练数据中看到了类似的倾斜物体最终倒下的模式,而不是因为它理解重力的概念。例子2:图像中的遮挡问题真实物理世界:人类可以很容易地推理出被遮挡物体的形状或是后面景物的样貌,因为这种推理是建立在我们对物理世界连续性和物体属性的基本理解上。AI的理解:AI模型在处理遮挡问题时,其表现依赖于它所训练的数据。如果模型训练数据中包含了足够多的遮挡情况及其解决方式,它可能能够正确"推理"出被遮挡物的信息。然而,这种推理是基于统计关联,而不是对遮挡背后的物理原理的理解。例子3:机器人感知与操作真实物理世界:人类可以通过触觉感知物体的质地、重量和温度,并据此以适当的力度和方式互动,如捡起或移动物体。AI的理解:一个机器人,即使装备了传感器和基于AI的处理系统,它对物体的"理解"也是基于其传感器数据与预先训练的数据模型。机器人可能能够模拟出适当的互动方式,但这种能力来源于数据驱动的模式识别,而非对物理感知的真正理解。 这些例子揭示了一个重要的观点:尽管AI可以展现出对物理世界的高度适应性和预测能力,但它们的"理解"本质上是基于数据的统计模型。它们缺乏人类那种基于直觉和内在物理定律理解的能力。这种差别在处理未见过的情况或需要深入理解物理原理的任务时尤为明显。 |

|

根据目前Sora的成果来看,它还不懂物理世界。 这个结论不是我说的,是Sora的研发者OpenAI在发布Sora的网站上自己说的: The current model has weaknesses. It may struggle with accurately simulating the physics of a complex scene, and may not understand specific instances of cause and effect. For example, a person might take a bite out of a cookie, but afterward, the cookie may not have a bite mark. (目前的模型有弱点。它可能难以准确模拟复杂场景的物理特性,并且可能无法理解因果关系的具体实例。例如,一个人可能会咬一口饼干,但之后,饼干可能没有咬痕。) The model may also confuse spatial details of a prompt, for example, mixing up left and right, and may struggle with precise descriptions of events that take place over time, like following a specific camera trajectory. (该模型还可能混淆提示的空间细节,例如,左右混淆,并且可能难以精确描述随时间推移发生的事件,例如遵循特定的相机轨迹。) 我们所处的物理世界的本质是什么? 是因果关系。 在我们所处的世界里,时间是一个单箭头的,永远向前的物理量。一切物理定律,描述的都是基于时间均匀向前的前提下,物质的演化过程。换句话说,物理定律就是用来描述因果关系的。 比如,我们用牛顿的运动定律去描述一个滚动的小球,这一秒,小球出现在这里,下一秒,小球就会出现在它运动轨迹上的下一个位置。如果小球突然消失了,那一定是有一个“原因”,要么是掉进了洞里,要么是被人拿走了。事情永远不会无缘无故的发生,有“果”就一定有“因”。 而Sora的训练方法跟我们通过物理规律去认识世界完全不同。 实际上,Sora依然走的是OpenAI的传统路线,使用降噪潜伏扩散模型,通过给3D“降噪”的方式生成视频。通俗点说,我们都知道视频其实是由一帧一帧的静止图片连起来组成的,Sora生成视频的逻辑本质,是去判断在下一帧图片中,前一帧图片中元素出现的概率,进而生成下一帧图片。通过海量的训练,它判断的正确性越来越高,连续帧的图片的变化就会变得越来越平滑,整体看来,视频就越来越逼真。 这种生成视频的方式,就跟我们理解的物理世界的规律完全不一样了。比如,在物理世界里,三只狗永远不会突然变成四只,这不符合物理逻辑。但在Sora的逻辑里,一旦某一帧图片出现了错误偏移,凭空出现了第四只狗,那么它就有可能会将这只狗继续渲染下去,于是,三只狗就变成了四只。 Sora只能通过概率去规避这样的错误,但它无法理解“三只狗不能凭空变成四只”这种最简单的物理逻辑。 这也是机器学习与人脑最本质的区别。 |

|

|

0 按照我个人的理解,Sora描述的,更像是“梦境”,而不是真实的物理世界。 想想我们做过各种奇奇怪怪的梦,有些非常真实,有些则十分怪诞。在梦中我们无法分辨真伪,是由于睡眠时丘脑中的前额叶被抑制,我们的逻辑判断能力在梦中被显著降低,“梦”其实是掉帧非常严重的,充满了不合逻辑的种种细节和奇怪的走向。而往往要等到我们醒来了,逻辑思维上线了,才能分析出梦里种种不合理之处。 而Sora的成品,也是由于缺少“物理逻辑”的支撑,仅仅靠经验堆积出来的连续的画面,自然就容易出现不符合逻辑的走向了。 |

|

|

0 |

|

对于“物理世界”,我认为人类的理解通常指的是对自然界运作规律的深入认识,包括对物质、能量、空间、时间以及它们之间相互作用的本质和原理的理解。 这种理解不仅限于观察和实验获取的经验知识,还包括能够通过理论和数学模型来描述、预测和解释这些现象的能力。 人类对于“物理世界”的这种理解能力使我们能够提出假设,进行科学实验,验证理论,最终形成能够被广泛接受的科学理论,比如牛顿运动定律、热力学定律、相对论、量子力学等等,这些理论能够帮助我们深入理解物理世界的基本结构和运作机制。 但是Sora这类视频生成模型的所谓“理解”,却是一种截然不同的理解。 比如伽利略通过实际的物理实验,观察不同质量的小球从比萨斜塔落下的过程,发现所有小球几乎同时触地,从而推翻了当时广泛认为的更重的物体下落更快的常识,提出了重力加速度对所有物体作用相同的原理。 随后他又不断进行实验,比如他让小球沿着斜面滚下,测量小球通过不同长度的距离所需的时间。通过实验,他发现小球下滚的距离与时间的平方成正比;随后他又进一步推导出,下落物体的速度与时间成正比,且不依赖于物体的重量。 总之就是作为人类,我们会倾向于通过实验验证假设,并以此推导和建立物理定律。 但是Sora认识“物理世界”的过程却是完全不同的。 Sora通过分析大量包含物体自由下落的视频数据,利用机器学习算法识别这一物理过程。Sora的"学习"过程主要依靠从数据中提取相应模式,比如它可能会识别出物体下落速度随时间增加而加快,而且“发现”这一过程与物体的质量无关。但是Sora缺乏对于重力加速度背后物理原理的深入洞察,其"知识"仅限于数据中呈现的规律。 通过学习同一类型视频呈现出的“规律”,Sora能够模拟甚至“预测”物体下落的行为。只是虽然Sora能够准确模拟重力加速度的“表征”,但与伽利略通过实验和逻辑推理获得的深刻理解相比,Sora的理解更像是对现象的模拟,而非对物理原理的真正把握。 不过其实我觉得这也是人类与AI“算力”的巨大差距造成的后果,AI学习到的“物理表征”与人类“抽象”出的物理规律,孰优孰劣,谁能更好的反映物理世界的规律,随着AI的不断完善,恐怕越来越难以评判。 |

|

这个要看什么叫懂物理世界,如何去定义懂物理世界。 我们人类对于物理世界的的理解,就是通过从出生开始,通过触觉、视觉、听觉、嗅觉、味觉等各种感觉来接收物理世界的信号,并通过神经系统传入大脑,不断调整神经元之间的连接方式,从而形成了我们认知理解物理世界的大脑神经结构。我们懂了一个物理规律,就是知道这了一个物理现象发生的原因,产生的结果,由此去推演得到对未发生的现象的预测。 神经网络是大语言模型实现的技术基础,大语言模型是神经网络在自然语言处理领域的具体应用之一。通过不断优化和扩大模型规模,大语言模型能够更好地理解和生成自然语言,为机器翻译、文本生成、智能问答、对话系统等应用提供技术支持。 计算机的神经网络也是类似的一个过程,只不过这是一个由计算机芯片里的变量存储运算构成的神经网络系统,通过大量的学习,也就是输入输出变量,自动调整神经网络的众多参数,从而形成了一个最终的神经网络结构。而最终的结果就是这个神经网络可以模拟它学习过的这些例子,你再给它一个没有学过的输入信号,它就会返回一个符合已经学习的规律的输出结果。 神经网络这种存在于计算机中的计算模型,是受人脑工作原理的启发,通过模拟神经元和突触的结构与功能来进行信息处理。在机器学习和人工智能领域,我们通常说的神经网络“理解”是指它能够从数据中学习到复杂的模式和关系,并在特定任务上表现出人类级别的性能,例如图像识别、语言处理等。 这种“理解”指算法对数据的一种表征和加工能力,那么人类真正的认知或意识到底什么,这是一个很深奥的哲学问题。 在我看来,神经网络通过大量数据训练,可以提取特征、做出预测、生成新的内容,虽然它并不具备自我意识、情感、主观体验或对世界的深层次洞察,但它可以完成基于统计模式和算法的“理解”,与人类的区别在于这不是基于意义和意识的,不过从结果上看是一致的。我相信,如果给计算机神经网络像自然环境中人类一样的进化条件,完全可以产生和人类同样级别的“意识”。 |

|

Sora 不懂物理世界,听我的没有错。 Sora 从它的公开技术文档上看,自己取名是 “Video generation models as world simulators”, 如果直译就是“像世界模拟器那样的视频生成模型”! https://openai.com/research/video-generation-models-as-world-simulators 我不知道是不是这个名字让大家误会了。至少在它提供的技术细节里,我没有看到世界模拟器。 它的技术实现我认为是 ViT + Diffusion 。 视觉数据处理 ViT 类似的技术放在了它们技术报告的第一位,说明它们认为这是最重要的。 |

|

|

这张图清晰的揭示了一个操作,所有的视频是多帧数据一起 用类似切成 3D 块的方式做成 Token 的。你可以理解一下是几帧图像一起切,这样一个 3D 块里既有 2 维的物体信息,又有 3维的时间信息。也就是一个 Token 里有了 Space 与 Time 信息,这样如果做 Transformer 的大模型训练,是对生成连续的为图像是有极大帮助的。现阶段的那些估计训练的时候都是 ViT的生成关键帧,再插值的方式,稳定性上肯定没有这个好。 但是因为这个 Token 本身大小其实是会影响到数据质量的,所以对齐这个操作就极为关键,而这恰巧是 OpenAI 搞的风声水起,自己又没有公开过任何细节的技术 KnowHow 。 图像与视频生成 这个明显是一个 nosy patches 到 Diffusion Model 生成图的技术。 |

|

|

你可以看到,同样也是多帧的图像的 Noise 一起输出,然后从 Noise 到图像的过程。 |

|

|

在这个双向的 Diffusion 说明中我们可以清晰的看到从 Diffusion 生成一帧图像的技术有多成熟,而多帧一起生成,它的连续性肯定就有多少。 可以说把视频的 Space 与 Time 一并打包成 Patch 信息,做为 Transformer 的输入,然后再输出成 Noise 数据这件事确实是一个天才的想法,但是这个实现就要有这样一个 AI 成功三要素: 人才、数据、算力。 很庆幸的是 OpenAI 三者都不缺。 但是有一个问题,数据是怎么来的,就决定了它的模型表现。 之所有能满足物理学规律,我觉得是数据里天生就有的,就像 2D 的图像里人手通过慢慢对齐,生成的人的图像就足够的好。 数据里有了 3D 的空间与时间数据,自然在对齐后就表现出了符合物理世界的规律。而不是它懂了! |

|

OpenAI 在推出 SORA 时候就放出了 「鬼畜」视频。所以,在现阶段,SORA 应该是不能精确理解物理规则的。 等 SORA 公测了,要测试它是否真正理解物理规则也不难。我们只需要拍一个真实的物理实验,把前半段喂给 SORA,让它生成一个「合理」的视频延续。然后我们再去分析它的生成的延续是否符合物理规则即可。 不过,我认为短期内 AI 应该都很难完全掌握物理规则。最主要,Transformer 的 Q-K-V 抽象核心还是针对自然语言处理的:动态关注长序列中的不同部分。更直白的说,Transformer 解决的问题「如果 A 位置出现了 XXX」那么 「B 位置最有可能是 YYY」的问题。而物理问题推演的思路是:抽象问题 -> 带入公式 -> 确定关键参数 -> 计算推演。这个思考模式的复杂程度和 IF A THEN B 还是有鸿沟的,比如关键的抽象能力到底应该用什么神经网络结构去承载。 基于 Q-K-V 的抽象,Transformer 确实也能够把视频处理得足够平滑,但很难捕捉到物理规律。 其实,SORA 目前真正带来的震撼还是图形学上的,通过演示视频我们不难发现,在视频镜头发生转换的时候,视频主体不会发生预期外的畸变,十分平滑,仍然保持着它原有的几何结构。丝滑处理序列正是 Transformer 的强项。这也是 Pika 或 Runway 之前都没做到的工作,而 SORA 证实了 AI 生成视频是可以或者说是极大概率下保持几何结构连贯的。 这个应用范围可就非常广了。比如,未来视频创作者可以只关心非常少量的关键帧进行创作,而关键帧之间大量的补帧无脑使用大模型渲染就好了,甚至还可以加入文字描述去让 AI 服从特定的需求;比如,未来拼接视屏素材,无脑让 AI 去实现就好了,我们只需要告诉它我们的需求即可,不用再在视频软件上做繁琐的操作了,还可以微调几个专场风格的 LORA,即拿即用。 市场也验证了这一点,SORA 也影响了 Adobe 等创意工具公司在二级市场的股价。 最后,我觉得 AI 目前擅长的问题还是在一些「存在既定重复模式」但控制论和符号学又无法简单描述清楚的场景。至于传统的因果推论,物理问题方面,AI 仍旧表现不足,网络结构层面仍需理论突破,不过未来可期。 |

|

Sora懂不懂物理我不知道。流体神经网络是能学会的,比如天气预报,pinn这些例子 |

|

懂又不懂。 懂是因为Sora是经过大量的视频数据训练过的,它能够从海量数据学习到一定的范式,具有比较的好泛化能力,能够生成和真实物理世界一致的视频。 不懂是因为Sora并没有经过显式的监督来学习物理规律,它能够生成符合物理规律的视频可能只是模仿学习,但是实际上不懂物理规律,所以有可能生成的视频会出现违背物理规律的错误。 |

|

|

其实Sora懂不懂物理世界这个问题,本质上还是问AI模型是不是有可解释性,虽然有些关于AI模型的可解释性研究工作,但是大部分认为目前基于深度学习的AI模型是不可解释的,这其实也是目前AI最大的诟病。 就算目前比较强大的GPT-4模型其实也是黑箱,你并不知道它为什么有时候能正确给出答案,但是又有时候做出比较离谱的回答。但是能够确信的一点是,随着模型能力变大变强,出错的概率会越来越低,或许有一天当Sora模型不再生成违背物理规律的视频,这个模型说它是世界模型懂物理规律也不为过。但是如果那一天真的来临,我们的命运又会怎样呢?想想就有点害怕。。 |

|

Sora是【数据驱动的端到端物理引擎】,类似于对虚幻引擎5和真实世界的视频数据“拟合”。 既然是端到端和数据驱动,结论就是,sora不懂物理世界了,题主提到的重力、浮力、碰撞都没有显式的参数和模型,全都是隐含在无数神经网络参数里的。 更像是大脑睡眠阶段产生的梦境,也就是对白天数据的一种“拟合”。 |

|

|

|

|

价值三百篇ACL,ACL的神音就由你来传达 |

|

第一它有自己物理世界的理解方式,目前还不够; 第二它建立的目标,其实比起生成视频来,更重要的就是要作为一个“模拟真实世界”的工具!思想工具和计算验证的工具。这点最近其实有些帖子,例如奥特曼与马斯克的对话。我是很认同的。 当然,仍然是一些基于大数据的方法,好处是它保留了很多“抽头”去与理性方法沟通,例如计算机图形学里面如何渲染色彩光影和建模良好透视这些,原本是单纯几何公式的,现在用了大数据去反推!这个还是比较强大的、人类较新的思维和工作方式! |

|

Sora怎么可能懂物理世界呢。。 他是一个程序。输入是一堆图片。。它和真实世界根本就没有接触。。。 你要是输入一堆西游记电视剧图片,Sora就会认为这个世界上有孙悟空。。 |

|

啥叫懂?啥叫不懂? 所谓的懂都是建立在语言基础上的懂! 只要理解了语言,就没有不懂物理世界的问题。 Sora目前存在的问题,也许只是重点暂时还没有放在物理世界的理解方面。 等着看吧,很快,Sora就能“发现”物理规律了。 |

|

答案是不懂,资料投喂出来的ai采用的是相似性逻辑,即看起来像,那么就是,这种逻辑有其优点,但也有致命缺陷。 一个优点在于拟合程度很高,可以以假乱真,只要资料库足够大,拟合程度有可能越来越高,以至于人眼无法分辨。 另一个优点则是所需算力很小,一个复杂物理系统的完全状态空间规模极大,可以轻易抵达10^100程度,对所有参数取所有可能值获得的所有状态。ai不需要获取所有状态,只需要较少的典型状态就能进行上下文推理,降低了计算负担。 缺点在于,ai给出的是统计规律,这种规律很糟糕,一方面依赖于数据集的质量,要全面,准确,但是又要足够专一,简单,前者是为了反映现实,后者则是为了保证精确性,因为统计学习复杂规律失败的可能性极大,而且难以找寻原因。另一方面依赖于统计模型的偏好,所有的ai设计都是在确定统计模型的选择方式,对于何种现象选择各种模型,从而可以精确拟合,落于实际就是各种评价函数,误差分析,无论是事前估计还是事后估计,目的都在于给统计模型族编序,无非是参数足够大的ai模型的选择余地要更大,所谓的单参拟合与多参拟合的区别,深度学习神经网络属于极多参数拟合,失去了可理解性,但本身并没有脱离统计学习框架,即使发展到了大模型的地步,依然摆脱不了这个限制。 与之对比,科学研究是通过对现象的有限次取值,推理可能的规律,然后对规律进行验证与评价,获得拟合精度。所以,物理规律总会给出一个精度范围,在这个精度下是精确的。 所以,通过ai获得复杂系统的精确规律,无异于大海捞针。 不过,这是站在人类科学角度的观点,认为一个物理规律必须给出数值上的精确度才有意义。 如果能摆脱精确科学的观点,选择统计科学观点,即一个物理规律给出了拟合精度(物理模型族与最优模型的距离)就有意义,那么,ai已经做的相当好了。这种对物理规律认知上的差异就是人类与ai的区别。人类与ai是不同的智能体,随着ai技术的发展,这种不同会越来越显著。排斥或者同化都是不现实的,最合适的方式为接受不同,选择合作。这也是很有趣的事情,既然人类找不到宇宙中的非人智能体,那就自己发展一个非人智能体。相比于外来文明接触,影响会更小一些。 |

|

Sora是一种基于Transfomer架构的神经网络模型,可以实现“端到端”的数据拟合及预测,在内容生成领域有很好的效果,尤其是现在可以生成长达1分钟的逼真视频内容,让相关行业的从业者为之震惊。 但是,目前的Sora不懂得物理规律,能依靠的依旧只有基于数据的经验总结。 |

|

|

本质上,Sora依旧是一种神经网络模型,通过输入大量的数据驱动来总结和学习其中事物发展的时空规律,并对未来一段时间内的变化做出预测。其背后就是数以亿计的超参数,通过梯度计算和参数的迭代更新等方法来更新模型,从而能够逼近所见过的数据,可以模拟一些复杂的计算过程。 |

|

|

Transformer架构的神经网络模型 因此,某种程度上来说,神经网络模型本身存在的问题在Sora中也存在,只不过它由于有一些巧妙的网络结构的设计,对数据的理解可能更好,在大多数场景下没有表现出问题。但是在个别场景下,尤其是它见得少或者没有见过的场景中,可能就会闹出笑话来。 比如这个从沙里“抽出”了一把椅子的操作就让人很摸不着头脑,这把椅子随后还在空中飘来飘去,做出了一些完全不符合物理运动规律的动作。这类视频内容生成的技巧用来进行影视化的“魔幻”操作是可以的,但是不符合现实的物理世界。 再比如,在这个给老奶奶过生日的视频中,现场气氛很热烈,大家都很开心,老奶奶也在表达着对大家的感谢,这些我们都能感受到。但是,老奶奶对着生日蛋糕吹气的时候,蜡烛不仅没灭,连晃动都没有,这就很不符合物理世界的常识了。 老奶奶左边的第一个女士的手在空中乱舞,并且跟后面男士的手交织在了一起,很显然Sora是想模仿大家鼓掌的高兴场面,但是仅仅从视频内容的角度来模仿是还不够的,这些都不符合生物和物理常识,它只是在数据层面在模拟这些画面。 再比如,在下面的这个视频中,Sora想要展现的是杯子倒了以后,杯中的酒水流出洒在桌子上摊成一片的状态。在酒水洒出来之前和酒水洒出来之后的状态都比较符合现实情况,但是很明显的是,Sora并不能正确地理解先有杯子倒了,后有液体流出,随后才是铺开的状态,它可以把最开始的状态和最终的状态渲染出来,但是中间的这个物理过程却不能正确渲染。 当然,就视频内容的生成方面,Sora已经是行业翘楚了,可以取得很好的视觉效果,十分逼真,它已经在尝试去理解人类的世界。但是对于物理世界的许多规律,目前的Sora还理解得不到位,或者说它目前还不具备这种“理解”的能力。 虽然人类的学习也是通过总结规律来实现的,但是人的学习并不是完全依靠数据,其中有一种非常重要的能力就是抽象和联想能力,能够将结构相似的东西联系起来提升学习的效率,并能够通过书本、视频、甚至是语音等数据将各种见过的、没见过的东西都联合起来,可以大大降低学习的难度。 抽象思考的能力也赋予了人类丰富的想象力,使得我们甚至可以想象出自己没有见过的东西,并通过经验大致猜测出其基本的运行和发展规律,这也是人类的数学和物理可以很好的发展的前提。 也许将来的数据量更大了,各种场景更丰富了,又或者可以在神经网络模型纯数据学习的基础上增加数学和物理约束,那么Sora的后继者们经过长时间的学习和经验提取,有可能对物理世界的规律理解得比较好,从而能够生成更加符合物理直觉的内容。 |

|

Sora 还没准确学到物理规律,还不是真正的world simulator(世界模型)。 Sora没有达到超越数据本身,进行反事实推理的地步。OpenAI 也表示Sora 是一个基于扩散模型的“Diffusion Transformer”,理解起来,类似于从巨大的视频数据库中提取碎片样本之间的关联与演化的动态过程,构造甲方会最为满意的作品。 素材库这些“视频”学习资料符合物理世界样式,作品也就合理,各种采样毕竟都是真实时空映画与缩影。同时我们注意到:Sora摒弃其他文生视频“调整视频大小、裁剪或修剪到标准大小”的做法。个人觉得这使样本更贴近同一个具有时空逻辑的真实世界。 但表象之间的联系和统计规律,不等于这世界内在物理规律。她也不会写出一串力学公式,以此来约束生成的内容。于是时空推展开来,就有局部合理但全局不合理,因果逻辑跑偏等问题... 这SORA宇宙有点像某个孩子梦境世界、由经验表象堆砌而成,尽量看来真实可感、满足联想但会依旧天马行空。 |

|

|

|

|

一、【Sora的过人之处】 “现实”与“虚拟”差距正不断缩小;我们知道,Sora能按用户提示词生成视频,并不是首创,Fliki可以、Pictory可以、剪映也可以。?而比较意外的,其能保持场景和人物稳定性和连续性,感受和之前大有不同。没有怪异的变化,没有主人公多出的手脚,也没有面颊之上的恐怖谷。即便是超现实文案也会栩栩如生、不敢跑偏。 你在这会发现“不同物体三维空间运动一致性”,“人物风景长时间保持稳定”,“事物互动相对合理”。 |

|

|

|

|

OpenAI认为持续扩大视频模型的规模,可以用来模拟整个物理和数字世界,they are purely phenomena of scale。 Sora 不是一个简单的视频生成器,它是一个数据驱动的物理引擎,其对于虚拟和现实世界进行模拟。 这个过程中,模拟器通过一些去噪和梯度数学方法来学习复杂的视觉渲染,构建出「直观」的物理效果,以及进行长期推理和语义基础。 Sora采用到OpenAI模型、及DALL-E 3的强大技术,可将简短文本描述转化成60秒一镜到底的高清视频。至少在短视频领域,这是一颗重量级炸弹。如同核能之于战争,作为改变游戏规则的应用技术,对于影视从业者也必然构成一种威慑。而随着技术演进、这种创作方式日趋成熟,剧本直通视频,那一部电影的成本上直接抹个“0”的话,投资人是不可能不心动的。一个剧组只剩编剧、导演、后期...而演员、服化道、摄影、灯光、布景、场记这波人是不可能不害怕的。 当然下岗了可能也没什么,大家可以赛博人生,到Sora创作的虚拟宇宙中满足种种诉求。 ----------------- Sora为我们指明方向,生成模型终有一天是可成就地球Online滴。 二、【世界是个生成模型么】? 不过Sora确是惊艳,被称作伪装成「视频生成模型」的虚拟宇宙并不为过。反过来在想,宇宙会不会也是个生成模型,不过算力、规模强大许多 。 |

|

|

看来世界也是个生成模型 Video generation models as world simulators Sora来了,现实不存在了?看到这问题确实会浮想联翩... 从0到1,世界如何涌现,可能Sora已给出个很好演示。 从ChatGPT到Dall-E,大语言模型触及生活方方面面。发展到今天这地步,几乎是将视频生成模型泛化成物理引擎。或许,距离他创作虚拟现实,只有一步之遥。 我猜当Sora相应技术应用在游戏领域,当生成模型入驻开放世界冒险,又会再次发挥出不可思议的力量吧。 |

|

|

|

|

|

量子引力与人工智能已不期而遇“我们的世界也来自生成模型么”这还真未必天方夜谭。 如同,《流浪地球2》图恒宇台词“你们没有资格定义什么才是真实!”,确有道理。谁也不能确定自我不是“数字生命”,没有生活于550W创作的虚拟世界之中。 |

|

|

?怎么确信自己的周遭不是LLM大模型的创作? 从骇客帝国到缸中大脑,再到马斯克马首富的99.9%暴论-「虚拟现实论」不再是一种非主流文化。 ----- 计算机领域,最基本计算单元是数据“0”和“1”及她们之间与非门计算,千姿百态的虚拟世界由此而来。而真实世界可能也类似...but it from Qubit。 |

|

|

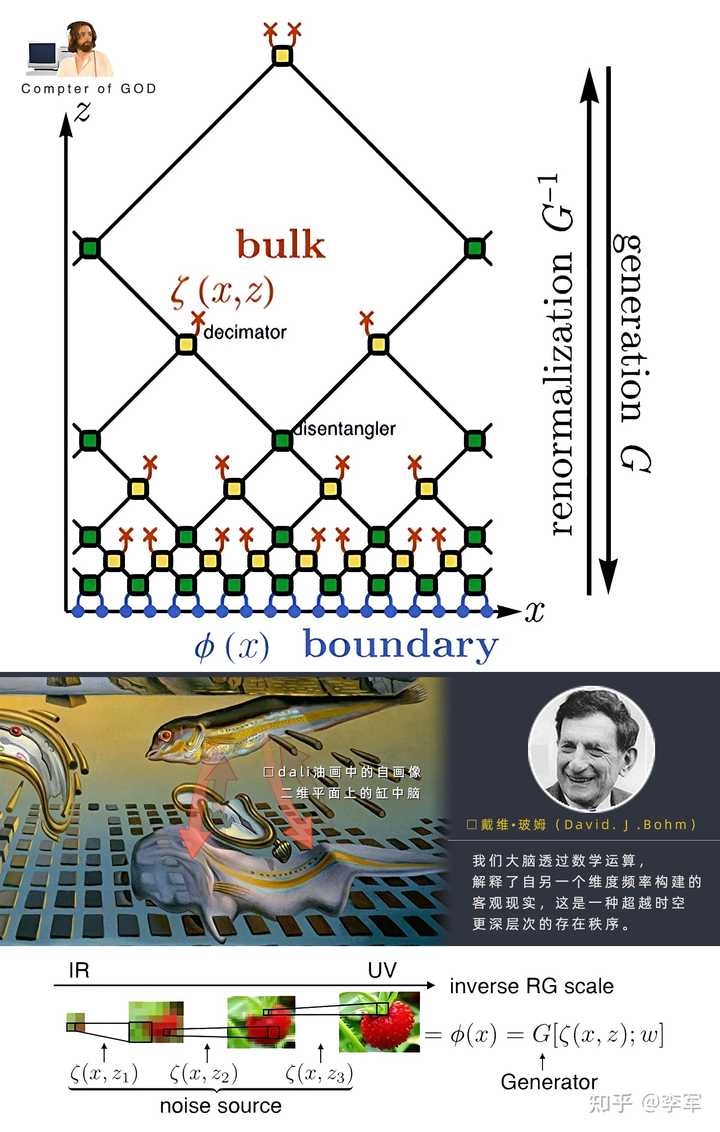

多年前“深度学习”和“重整化群”(renormaliztion groups)可建立严格映射结论(DL→RG)如同开启一扇天窗;量子引力研究中的种种观点,更让人畅想连连。 物理学家David Bohm当年说过:「我们的大脑透过数学运算,解释了来自另一个维度的频率构建的客观现实,这是一种超越时空的更深层次的存在秩序』 抑或简单理解为“宇宙是虚拟滴,你把握不住”。 “宇宙是个大号计算机,我是里面的梦一场”第一次这样想,还在小学时代,当时正好看了正大剧场播的《神通情人梦》,也叫《电脑狂想曲》。屏幕上涌现出来银色像素小人,翩翩起舞。我也浮想联翩,自己会不会跟她一样、生活在某个巨大的电脑~ |

|

|

这句话现在可以说成:一个演化着的量子比特集合创造了你的世界。所见所闻暨计算结果 也许,真如文教授所言“宇宙就是台超级计算机”!人生在计算中衍生。熟悉的世界不过一场地球online,以平直时空样式展现在显示器上。而这一切则要归功于其中精致的生成模型。 以下内容相对玄学,如喜欢咱再聊5毛钱的,或当科幻看就好: 三.【一花一世界,一叶一菩提】 ? 从0到1,世界如何涌现,可能Sora已给出个很好演示。OPENAI的宏伟蓝图是,视频生成模型变成“世界模拟器”,但有人似乎抢先一步了。 |

|

|

你猜 ?有了LLM的方便,那谁不用呢? 如今有些孩子会把头疼的作业,丢给ChatGPT等大模型处理,忙里偷闲游戏开黑。 如何创作繁华世界?造物主没准会说:地球Online,不要怂 就是GAN ,余下时间扔扔骰子。 没准宇宙间某个Loss函数正指导世界,由概率走进你的真实 …将当下的美好雕刻进你虚幻人生的存档。 全息原理之下,此类脑洞似乎正一点点变成现实,我们隐约看到宇宙计算机硬件构成,也是宇宙Online的创作环境: |

|

|

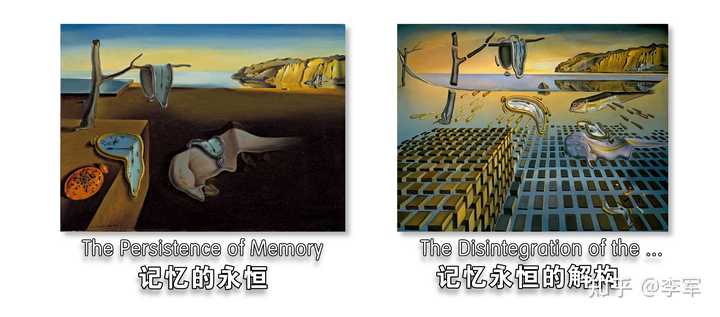

宇宙一台“超级计算机”磁盘加显卡 勉强接受宇宙像台计算机的设定,那上帝的骰子咋就化作了大千世界呢。 关于这软件《宇宙Online生成模型》,用个比较有意思方式来作比: 艺术大师dali有幅油画叫《记忆永恒的解体》。《the Disintegration of the Persistence of Memory》in 1954;如把这些趣味图形放一起,你会发现: 在那悬浮海洋之中、量子化平面上,覆盖了薄纱般的达利自画像 一张面颊标志着自我所在...如同雕刻于磁盘上的“二维缸中大脑”或你的“角色源代码”。 |

|

|

两幅记忆的永恒油画 这两幅画似乎能很好地演示全息原理:在其诠释下,时空内部(bulk)的量子引力理论与时空边界(boundary)上的非引力量子场论相对应。展现出一个N+1维宇宙与N维宇宙不可思议的对偶。(油画的神预言) 而场论各自由度间的纠缠关联,代表更高维度的时空几何。这幅蓝图最后被神经网络美妙的展现出来。从内部到边界、从隐藏层到显层... 也是宇宙来自生成模型思潮的起点。 |

|

|

此处二维平面上呈现丰富信息,“扭曲的人面”与空中“悬浮的鱼儿”其实是同形异构,From bulk to boundary 似乎在倾诉:在边界信息平面上的“你”,与空间中立体映像彼此呼应,相映成趣过程才是故事正确打开方式... 那飘起的时钟、毫无重力悬浮物件,似乎暗示时空不过幻觉一场,我们所在量子比特海洋的浪花与涌现; it from Qubit, 一切都是记忆之上的自觉,…属于这个缸中大脑世界~~ 躺平的妳我如二维缸中脑,在量子比特海洋中拾取人生细节。别忘了量子地板上躺平的达利自画像,便表征我们存在;或许,现实只在宇宙边界的二维平面上,那里才是应许之地; 咱们这些“二维缸中脑”日常:便于量子比特海洋中拾取细节,在赛博人生中补齐自己的人生全景图像。 |

|

|

宇宙间某个Loss函数正指导着世界,由概率走进你的真实 …将当下的美好雕刻进你虚幻人生的存档中。 基于GAN和深度学习运用,原本二维画布,也有了演绎3D剧情大电影的可能。而我们这些二位小人儿正是带着3D眼镜,欣赏一部名为《你的名字》的新剧。 Are We living in the Simulation ?? in the Ads/CFT Correspondence,Deep Learning Relies on Renormalization Group. in "Bulk"we see the Organizational form of “Simulation”. as to the Emergent Universal mind…in the sight of God,just something like the description in dalis painting “The Disintegration of the Persistence of Memory” : ) Time ,space, gravity are just a dream in this quantum-ocean! 水平不足,就当成脑洞吧 |

|

|

时间难题: 还记得惠勒德维特公式按时我们:时间并不存在么! Page Wooters理论认为:对内部观察者来说,时间是纠缠的涌现;而对外部观察者而言,时间是不存在的。宇宙内部的观察者测量纠缠粒子对中的一个之后,会立即观察到两者之间的差异。外界观察者可能认为宇宙是静止而无变化的,但纠缠对象实际上却经历了极度混乱的变化。 或许,造物主面前世界就是静止全息的。但对我们,世界却生动涌现而来;我们到来正是“变量”本身,把“概率现实”撺成人生的剧情大电影... 回到今天的话题「宇宙」或是这样一张生成式网络,当我们到来,便给予她一系列“描述关键词”,继而繁花似锦的世界在你面前铺展到来。 跟随你步伐,世界的边界还在不停拓展…现实,以你为原点,过去未来种种细节不断描绘补完,终于在无尽可能的海洋涌现。 我相信Sora不只是个视频工具...有一天我们人类能创作虚拟宇宙以致文明时,回顾技术历程,大概率也会想起这个名字。 不过当下~地球 Online会对Sora说:姐妹妳这方面差的还挺远呢。 |

|

|

从全息原理到生成模型,脑洞先行,欢迎有兴趣的伙伴一起聊聊: |

|

“物理定律的表现”和“物理定律本身”,这两者是有明确区别的。任何动不动贬低人类智能,把“你怎么知道人不是这样实现的”挂在嘴边的人,大多是混淆了这两个东西。 更进一步的,AIGC的各种模型学到的只能是“物理定律的视觉表现”。从Sora发布的视频和技术报告来看,它学习到的更多是一种时空上的语义。这种语义是对于2d图像蕴含的语义的扩展。如果说以往的模型知道什么是船,什么是水流。Sora学到的就是什么是行驶,什么是旋涡,什么是碰撞。 当语义空间从2d扩展到2d+1d之后,视频的连续性和合理性自然吊打以往模型。这也是它值得惊叹的地方。比起以往的模型,Sora当然是更懂物理世界了,但是它真的能理解语义表象下的规律吗?目前看起来并没有。 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |