| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> OpenAI 发布文生视频模型 Sora,AI 能理解运动中的物理世界,这是世界模型吗?意味着什么? -> 正文阅读 |

|

|

[科技知识]OpenAI 发布文生视频模型 Sora,AI 能理解运动中的物理世界,这是世界模型吗?意味着什么? |

| [收藏本文] 【下载本文】 |

|

OpenAI,发他们的文生视频大模型,Sora了。。。 而且,是强到,能震惊我一万年的程度。。。 https://openai.com/sora 如果… |

|

转载一下推上AI大V Jim Fan的观点, 如果您认为 OpenAI Sora 是像 DALLE 一样的创意玩具,...再想一想。 Sora 是一个数据驱动的物理引擎。它是对许多世界的模拟,无论是真实的还是幻想的。模拟器通过一些去噪和梯度数学来学习复杂的渲染、“直观”物理、长期推理和语义基础。 如果 Sora 使用虚幻引擎 5 对大量合成数据进行训练,我不会感到惊讶。它必须如此! 我们来分解一下下面的视频。提示:“两艘海盗船在一杯咖啡内航行时互相战斗的逼真特写视频。” |

|

|

0 - 模拟器实例化了两种精美的3D资产:具有不同装饰的海盗船。 Sora 必须在其潜在空间中隐式地解决文本到 3D 的问题 - 3D 对象在航行并避开彼此路径时始终保持动画效果。 - 咖啡的流体动力学,甚至是船舶周围形成的泡沫。流体模拟是计算机图形学的一个完整子领域,传统上需要非常复杂的算法和方程。 - 照片写实主义,几乎就像光线追踪渲染一样。 - 模拟器考虑到杯子与海洋相比尺寸较小,并应用移轴摄影来营造“微小”的氛围。 - 场景的语义在现实世界中并不存在,但引擎仍然实现了我们期望的正确物理规则。 接下来:添加更多模式和条件,然后我们就有了一个完整的数据驱动的 Unreal Engine,它将取代所有手工设计的图形管道。 也就是说Sora有可能是看做是一个神经版的UE物理模拟引擎。所以期待一下后续论文更多细节放出 最近整理了Sora全网资料提示词视频项目拆解,想要的可以私信加我 |

|

|

|

|

|

|

|

|

|

|

|

|

|

我第一次看到Sora这个视频生成的效果真的是被彻底震惊到了。我是猜到视频生成这几年会有快速的发展,但是没有想到居然会不到一年的时间就已经做到这个地步,实在是太厉害了。 厉害的地方就不分析了,其他的博主已经已经说过很多。即使是研究人员,自然也要看看还有哪些不足的地方,这样之后的研究才有方向。这里就鸡蛋里面挑骨头,看看哪些细节还没有做到完全真实。先迭个甲,这里不是要攻击Sora的结果,反而正因为视频生成做到如此真实,我们才能够有机会去分析那些细微的不真实的点。 首先是光影,这里就把OpenAI放出来的第一段做例子。这个结果非常让人震撼,整个图片光影很漂亮,尤其是地面水的反射。但仔细观察,就会发现很多地方的反射有错误,例如左下角黄色框出来的反光是两个细灯箱,一个粗灯箱,但是上面实际的广告牌却是三个细灯箱。又如右下角红色框出的橙色反光,其实上面是没有对应的橙色灯箱的。 |

|

|

https://openai.com/sora 然后细节,这里用这个猛犸象的视频做例子。这个例子中OpenAI着重炫技的就是猛犸象的毛发,无论是光影还是细节几乎都无可挑剔,但是美中不足的是猛犸象走路时溅起的雪花。滑过雪的都知道,雪地上的溅起的雪一般不会起的太高,而且会呈现明显颗粒状,而视频中的雪花则像雾一样飘起来。下面放一个真实的滑翔机在雪地的图片做对比就一目了然了。 |

|

|

上图:https://openai.com/sora。下图:https://generalaviationnews.com/2021/01/10/flying-with-skis/ 然后交互,这里用这个各大平台转载的海盗船在咖啡中的例子。这里无论时咖啡的飞剑还是海盗船的风帆都非常真实,但是船在海中漂流的却偶尔有些失真,尤其这一小段,注意右侧的船似乎是悬浮在空中漂移,而不是真的在海上漂流。还是作为对比,用著名动画"各国是如何打仗的"里面的船在海上漂流的视频,就可以看出区别。 |

|

|

https://openai.com/sora |

|

|

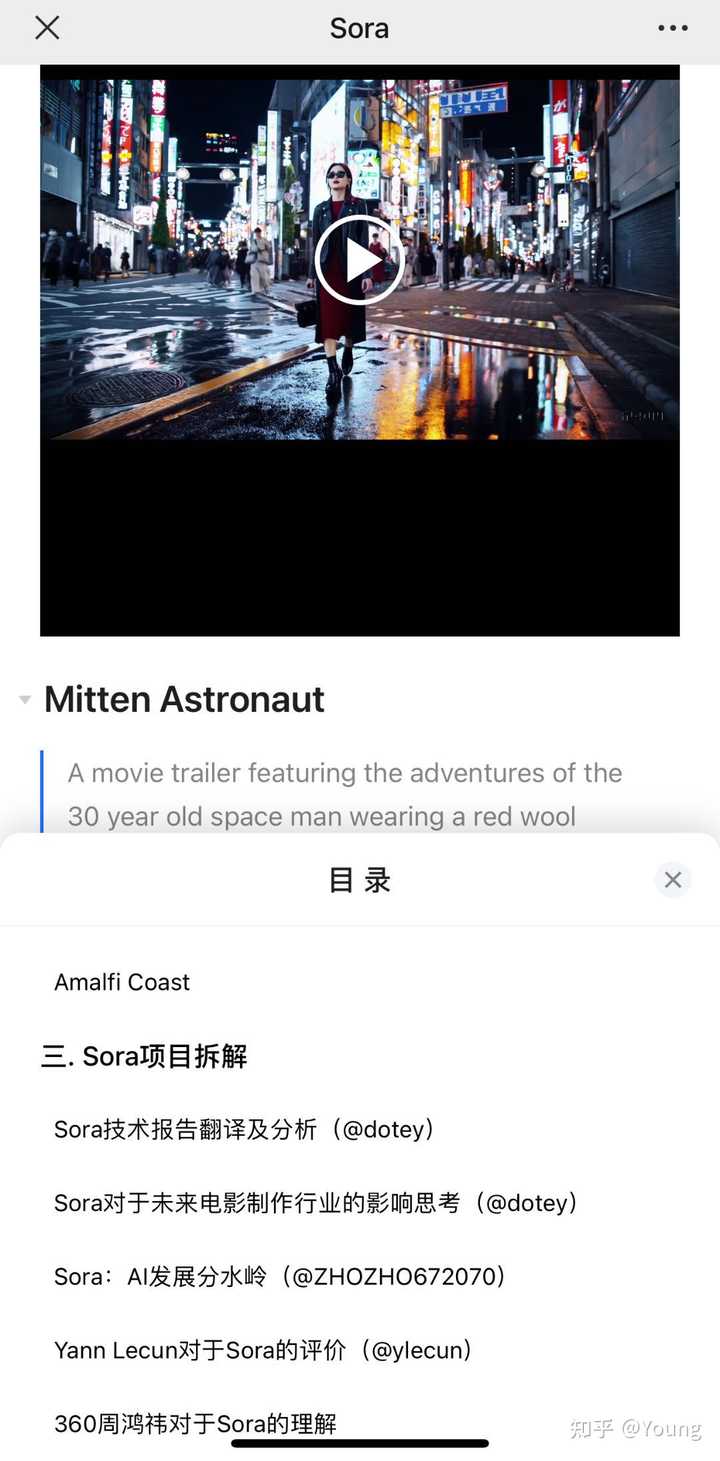

短片:《各国是如何打仗的》 还有三维一致性,这里用这一段非常漂亮的日本街头视频,能够把这么复杂的城市场景三维结构仅仅通过视频信息建模出来实属不易。但左侧的樱花在某些帧可以明显看出有一些是悬浮在空中,这也是因为单单二维视频并没有真正的三维结构,所以从某些角度看上去就容易比较奇怪。还是作为对比,放一个真正三维游戏中的森林场景的渲染。 |

|

|

https://openai.com/sora |

|

|

来源:最后的生还者 最后就是复杂的运动。这段视频中这只可爱的猫在逗主人的时候,明显突然间多变出了一个爪子。 |

|

|

说了这么多,但还是最开头的说的,即使如此,这个结果也是非常让人震惊,让人感受到了视频生成的无限潜力,未来也许很多的短视频,动画,电影,还有游戏,各种各样内容生成,都是可以由AI辅助完成。 最后也是一点私活。大家可能觉得我说这么多有点吹毛求疵了,这些细节的区别谁会在意呢?但我却不这么觉得。如今各行各业都在卷,内容制作这一块也是卷的非常厉害。头几年一个手机一个三脚架就可以录视频做博主,而如今博主们都是各种专业录影。电影电视剧短视频游戏更是如此,当年非常牛逼的特效在现在看来都是5毛钱特效了。例如这里对比一下同是星球大战系,99年出的魅影危机和19年出的天行者崛起。 |

|

|

两部星球大战对比,上:魅影危机,下:天行者崛起 而为让提升效果,大家也在拼命抠细节,例如就是游戏里面打光,就这么一张机甲图,为了看上去好看,看里面放了多少个光源。也正是因为效果越做越好,观众们的眼睛也会被养的越来越刁,对于品质追求也越来越高。而内容创作又是一个赢者通吃的游戏,最好的内容获取了绝大部分的流量,会逼迫大家都想尽办法去卷内容中的每一个细节。 |

|

|

By Peter Tran. https://www.artstation.com/artwork/L352gk 但这种内容细节的极(nei)致(juan)追求,对于做内容生成的研究员来说反而是一个难得得机遇。因为上面说的每一个细节,光影,细节,动作,交互,三维,都需要一个一个仔细研究逐个击破,反而会鼓励更多差异化得工作出现,毕竟在每一个维度上的进步,都可能比别人做出质量更高一点的内容。今天看到朋友圈很多做内容生成研究的研究员在哀嚎,说OpenAI又把大家卷死了,其实感觉大可不必。 |

|

不是。在训练数据的基础上从文本生成视频,不能证明“AI 能理解运动中的物理世界”,更不会意味着某个大模型“是”世界模型。 你可以注意到,ClosedAI 发布的演示视频包括失真的物体构造与运动方式,主要是动物腿的移动速度过于缓慢、动物运动过程中身体不协调、部分结构以不符合现实的方式移动,在显微镜与培养皿旁奔跑的小熊猫全都缺失肢体,海盗船在咖啡杯里对战时一条弯曲的波浪流畅地变成了杯子口——经典的“人工智能特有的错误”。演示视频的流畅度比市面上的同类模型好,但细节的完成度并不值得网络上的溢美之词。 惨变残疾的小熊猫们蹦跶着,你可以顺便注意到背景里各种器具的形态扭曲、倒影与上面的东西形态不同,这两个显微镜大概都不能用: |

|

|

咖啡里冒出一条陶瓷: |

|

|

咖啡杯的形象起初是有杯口的 |

|

|

海盗船周围的波浪出现了弧形模式 |

|

|

模式放大 |

|

|

模式放大到不自然的程度 |

|

|

弧形波浪向杯口边缘变化 |

|

|

冒出新的杯口 |

|

|

占据了起初杯口的位置 “世界模型”是对世界的空间维度·时间维度的抽象表示,是人可能具有、大型语言模型可能“有”或“没有”的一项能力,可以讨论大型语言模型能否获得足够好的世界模型、在多种世界模型间切换。AI 大模型在定义上不能“是”世界模型。 从 Sora 对动物结构与运动方式的表现看,它的训练数据缺少经过良好标注的、描述非人生物的结构与运动的内容。我认为下一步人工智能需要使用物理身体充分地与物理世界互动,而不是靠训练数据装成了解物理世界的样子。 |

|

虽然Sora的案例视频和技术文档看得我兴奋不已,但是我觉得说Sora能够理解“运动中的物理世界”还是过于夸张了。 举一个简单的例子: 把一杯水倒进另一个杯子里。 如果想要详细的模拟计算以及理解这个过程,需要通过计算流体动力学模型来实现。模拟液体流动、表面张力、以及液体与容器互动的物理行为。这个过程首先需要定义液体的初始状态,包括体积、形状和速度。然后,用模型计算液体流动的路径,包括液体如何从一个容器转移到另一个容器,液体在流动过程中的速度变化和方向变化等等。同时,模型还需要考虑到液体与杯子内外表面的相互作用,如粘附力和表面张力对流动路径的影响。 但是视频生成模型显然不是把这个复杂无比、专业无比的过程耦合进生成模型中,实现“运动过程”的生成,而是通过“学习”大量的“倒水”视频数据,学习液体动态、相互作用和其他物理现象的视觉模式。 也就是说Sora这类模型主要侧重于从数据中学习物理世界的“表征”,而不是直接在模型中进行物理定律的编码。 这样基于“大力出奇迹”学习到的“物理表征”,使得视频生成模型能够生成“看起来”符合物理规律的动态场景,却又无需直接解决其中涉及到的复杂物理计算。 不过很显然,这样仅学习“表征”,而不学习“原理”的做法,可能导致很多问题。 比如,模型可能不能准确“预测”未见过的新场景,因为它们依赖于训练数据中“见过”的那些模式,而那些模式不足以覆盖所有可能的物理交互,一些对于模型来说“陌生”的物理过程,可能生成一些看起来违反客观规律的结果; 比如,Sora虽然能够从“视觉”上生成让我们觉得震撼和信服的场景,但是如果仔细观察其物理细节的话,其实在对动态场景的细微物理过程理解方面可能存在着很多bug; 比如,模型可能对于复杂场景的预测能力有限,如果给出的指令涉及到的物理过程过于复杂的话,很可能在衔接及过渡方面产生“幻觉”,对于一些“未曾学过”的细节,模型很可能进行“编造”。 真实世界的物理交互远比可获取的训练数据中能够捕获的动作要复杂得多,仅仅依靠学习“视觉表征”进行预测的模型,不太可能完美“理解”物理世界。 但是之前看多了runway和pika的4s视频,Sora的59s流畅视频还是足够令人震撼的。而且虽然目前的模型仍然不足以“理解”世界,不过未来到底会达到怎样的程度,谁又知道呢…… |

|

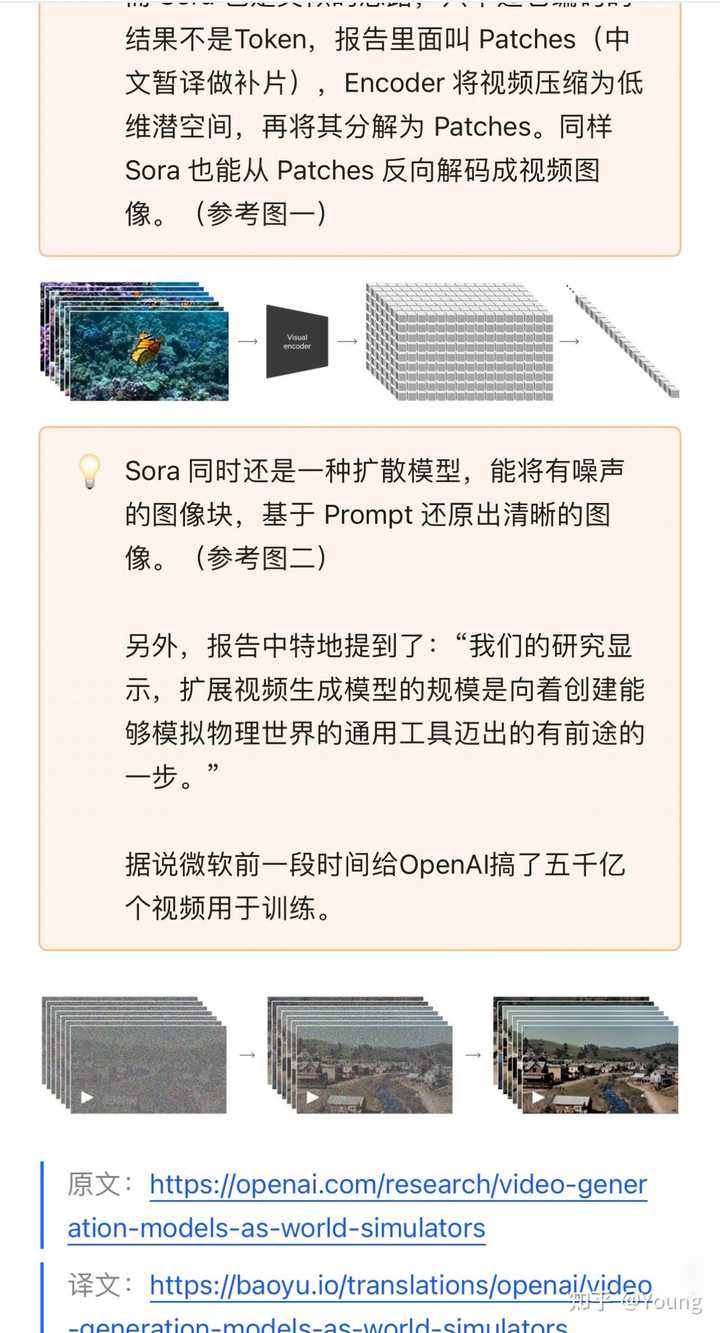

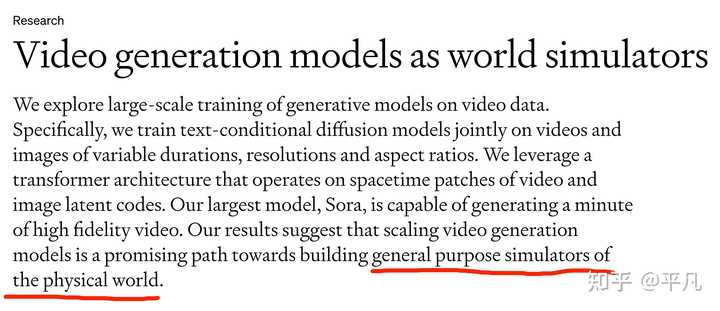

这一部分在 Sora 的技术报告的标题和最后一部分「涌现」里有所体现。这次的技术报告,题目直接就是「视频生成模型作为世界模拟器」,而且把 Scaling video generation 称为走向通用物理世界模拟器的 promising path。 |

|

|

在后面的技术报告里,我们看到了一个熟悉的词语:Emerging。按照这一段话的描述,从这一部分开始,Sora 所展现出的能力是超出原有预期的,属于「智能涌现」。 这些能力使得Sora能够模拟出一些来自物理世界的人、动物和环境的某些方面。 同时,OpenAI 也在强调,这些能力完全来自于 Scale。Scale Law 还在上分! |

|

|

具体来说,OpenAI 阐述了 Sora 的几项能力: 3D一致性。Sora可以生成具有动态摄像机运动的视频。随着摄像机的移动和旋转,人物和场景元素在三维空间中保持一致移动。长程一致性和物体永久性。对于视频生成系统来说,一个重要的挑战是在采样长视频时保持时间上的一致性。我们发现,Sora通常能够有效地建模短程和长程的依赖关系,尽管并非总是如此。例如,我们的模型可以在人、动物和物体被遮挡或离开画面时仍然保持它们的存在。同样,它可以在一个样本中生成同一角色的多个镜头,并在整个视频中保持它们的外观。与世界互动。索拉有时可以模拟对世界产生简单影响的动作。例如,画家可以在画布上留下持续存在的新笔触,或者一个人可以吃掉一个汉堡并留下咬痕。模拟数字世界。Sora还能够模拟人工过程,一个例子是视频游戏。Sora可以同时使用基本策略控制Minecraft中的玩家,同时以高保真度渲染世界及其动态。通过提示Sora提到“Minecraft”的标题,可以激发这些能力。 结论就是: 这些能力表明,继续扩展视频模型是发展高能力物理和数字世界以及其中的物体、动物和人类的模拟器的有希望的途径。 至于说这个能力,或者说这个发现的意义和重要性,我觉得从两个方面理解,一是数字孪生(空间计算、空间视频),二是世界模型。 去年,NVIDIA 花了蛮大力气宣传他们的 Omniverse,也就是数字孪生的概念。然后就是苹果的 Vision Pro,主推一个空间计算。现在我觉得这些东西都能串联起来了。 数字孪生就是是物理对象、过程或系统在虚拟世界的副本。它不仅仅是一个3D模型,使用传感器不断更新真实世界的数据。提供了一个实时的、虚拟的环境,用于测试变化、培训人员,并在影响真实世界对应物之前识别潜在问题。数字孪生有望改变制造业、工程学,甚至城市规划等领,用于简化流程、预测故障,并根据模拟结果做出更好的决策。 NVIDIA Omniverse是一个专为实时3D协作和模拟设计的平台。Omniverse可以轻松地整合设计工具、大型数据集和先进的人工智能。不同学科的团队可以在共享的虚拟空间中无缝合作。它具有超强的逼真物理模拟,创建出非常精确和响应迅速的数字孪生。公司可以建立虚拟工厂来优化生产、设计更安全、更高效的机器人,或者模拟整个城市的交通模式。改善运营、培训和规划的可能性确实是无限的。 至于世界模型,则可以看我之前的回答: 麻省理工重磅论文引围观,证实大型语言模型是「世界模型」,甚至有独立的时间和空间神经元,真实性如何?1163 赞同 · 132 评论回答 |

|

|

世界模型主要强调的就是不需要专门训练学习而自发认知到的那些「常识」,这些常识可能来自于基因深处,来自于生物体对世界的天然的感知,比如重力,比如色彩,这些天然的常识往往与文字无关,甚至无法用语言准确描述,而与感官感受有关。 |

|

|

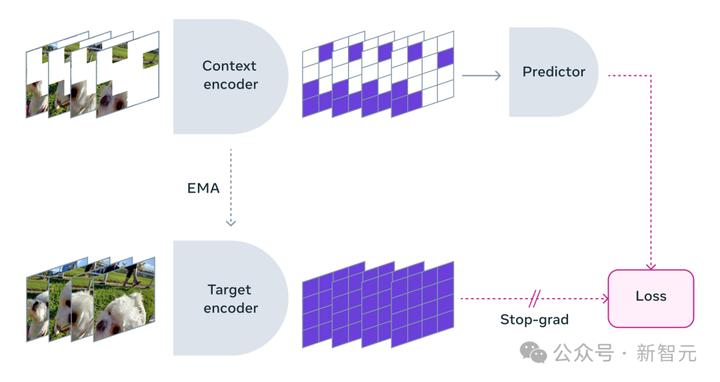

世界模型更像是一个概念游戏,因为世界模型强调感官、直觉、常识。换句话说,世界模型对人或者生物来说是不言而喻的从感官习得的常识,但对机器来说就是无法逾越的意识限制,毕竟机器没有生命,不能自主地去感受世界,不能靠直觉在未经训练的情况下自主决策。 之前,很多人质疑大语言模型不是世界模型,原因就在于 那么,世界模型和视频有什么关系?看看 Meta 是怎么做的就好了。提出世界模型概念的 Yann LeCun 在 Meta 于去年 6 月发布了 I-JEPA[1],被看做是 AI 迈向世界模型的探索。无独有偶,在 Sora 发布的同一天,Meta 端出了V-JEPA[2]: |

|

|

要理解物理世界,是不能缺少图像和运动画面的,类似于一些只可意会不可言传的感觉,这些感觉不能用语言准确描述或定义,但通过大规模的画面、视频训练,AI 可以自己总结、发现其中的 3D、碰撞等物理规律。 挺有趣的,LeCun 经常喷 ChatGPT,没想到 Sora 在视频理解和生成领域和他的世界模型理念又殊途同归、不谋而合了。 时间仓促,先写这么多,有新想法再来补。 以上。 参考^https://arxiv.org/abs/2301.08243^https://ai.meta.com/blog/v-jepa-yann-lecun-ai-model-video-joint-embedding-predictive-architecture/ |

|

Sora生成视频的效果确实惊艳,但是我觉得Sora本质上也只是类似GPT这样的暴力AI(大模型+大数据)在视频生成领域的一个成功应用,还称不上世界模型,所谓AI能理解运动中的物理世界也只是暴力AI所展现出的足够强的泛化能力而已。 |

|

在去上班的路上,来简单的回答一下这个问题。 Video generation models as world simulators (openai.com)?openai.com/research/video-generation-models-as-world-simulators 首先大家都对Sora的仿真能力感到吃惊,但是这种吃惊和颠覆的程度其实仅在于Video generate上,而并不是World Model,但是说World simulaors是完全没有问题的。 首先Sora理论上没有加入啥physis的bound,从tech report上看是这样的。所以通过data-drivern+model scale-up在运动逻辑,物理规则上有明显的漏洞这是完全可以理解的。毕竟各种流体的模型,运动的模型其实仅仅是通过一大部分的高质量数据就可以完成完整的learning,这其实还是不太可能的。但是这部分的缺陷的解决,显然已经有了一些ai4phy的方案可以解决,基于DALLE3的思路,要想引入一部分的physical规则,这并不是很难迭代出来的事情。 其实Sora可以提供的最大优点就是快速的场景框架搭建可以能够直接解决大部分real2sim的问题,此外因为最大60s的视频,可以为整个sense提供足够长的视距,为之前sim缺失的场景丰富度补足了优势! 只能说,从多元的Video Data中学习到的强大涌现能力,不仅在某种层面上盘活了diffusion-transformer,也会是2024年Human robotic的一道曙光! 我们后续可以做的事情 其实很多做video的伙伴们今天都破大防了,但是我们还不能倒下,我一口气帮大家想了很多条可以走下去的路!我么一起努力,目标:活下去!!!!! 卖课变现,参考李一舟老板汉化,参考国内大厂接下来的动作。继续提供访问OpenAI的服务,参考知识星球那些还完房贷的哥们儿Special Domain Adapt,医疗领域,反正Nerf的事情他也计划能干了,我直接建一个体内手术地图不就得了!Prompt engineer (这种估计蹦跶不了多久了)Multi-Modality Function 视频没声咋玩啊!interaction,参考一些inpaint的工作,视频编辑,但是估计还是要等把Sora解构了之后才能后续研究Embodied AI的real2sim各种Indoor环境的场景地图搭建,足够你RL变着花样学!World Model,直接替换Dreamxxx的diffusion的部分,换Sora来!你或许可以获得long horizon的manipulation |

|

首先,对于世界模型,现在并没有一个所谓的已经成为共识的定义。 我们姑且拿Yann LeCun在论文《A Path Towards Autonomous Machine Intelligence》提出模型来作为例子。 |

|

|

根据他的论文,世界模型也就是World Model的定义如下。 世界模型是用于模拟和预测智能体所处环境动态的概念框架。它们使得智能体能够有效地理解和与周围环境互动,是人工智能特别是在自主系统和机器人技术中的一个基本组成部分。一个典型的世界模型包括几个部分: 感知模型 Perception Module:处理环境感官数据,估计世界当前状态。预测或前向模型 Prediction or Forward Model:基于观察和潜在行动,模拟未来状态。规划和决策 Planning and Decision Making:用前向模型预测选择实现目标的行动。学习机制 Learning Mechanism:根据新观察和结果更新模型,提高预测能力。记忆 Memory:存储经验,用于更好的预测和决策。奖励系统或目标函数 Reward System or Objective Function:提供行动结果反馈,指导学习。 这其实就跟人一样了,就像人类通过感知来收集信息,利用记忆和经验来预测未来事件,通过规划和决策来选择行动,以及通过学习机制来不断适应和改进,世界模型也采用类似的机制来使机器或软件智能体能够在其环境中自主地行动和适应。这种相似性是人工智能领域试图达到的一种高级形式的智能,目的就是创造出能够更自然地与复杂世界互动的系统。 也就是所谓的更高级的人工智能。 根据他的定义,很明显的,一个世界模型起码得有一个跟外面世界交互方式,可以是看,可以是听,也可以是闻等等。 Sora这个模型本质是一个text-to-video的模型,也就是根据你提供的描述来生成视频,除了没有感知模型,我觉得学习机制也没有提到,所以说远远还不能称得上是世界模型。 OpenAI也说了,这个Sora可能是一个物理世界模拟器的路径。 |

|

|

物理世界中包含了非常多的法则,比如重力,比如摩擦力,比如气体的扩散等等,你要说Sora可以完美的模拟这些东西,那肯定是吹牛。 但是你要问Sora可不可以理解这些东西,我觉得是可以的。 比如说这个猫,在走路的时候前面有片树叶,按理说碰到后弯折,可能还会隐去一部分,然后再恢复原状。 |

|

|

但是你看在实际的视频中,它没有弯折,而是变得模糊。 |

|

|

但是在下一刻,猫的脚又完整显现出来了。 |

|

|

这能说明什么,Sora是可以理解一个物体在移动过程中,某一时刻可能会有阻拦物,这个时候自身会有一定的部位被阻挡,但是之后会重新完整展现出来。 Sora在没遇到障碍物和越过障碍物后理解是没问题的,但是在处理跟物理接触的时候有问题。 因为这个时候叶子应该是弯折的,但是仔细看视频那几帧是模糊的。 我觉得,主要还是因为算力不够,就相当于采用了一种剪辑手法,中间的步骤用模糊不清的图像或者视频替代,最开始和最后面保持正确之后,人类可以脑补出差的那几帧。 就跟其他的视频中的问题一样,主要问题就在于训练的数据以及算力还是不够,还得搞芯片,把scaling law搞到极致才知道到底能不能成为真正的世界模型。 人类世界的物理规律也是通过观察然后总结出来的,Sora或者说OpenAI的构造方式也是类似的,大量的数据扔进去,总的也是从观察中进行模仿,涌现可能就是掌握了规律或者定律的表现。 |

|

我越来越觉得transformer压根就不是一个序列模型。它是一个图模型,它可以学习不同信息之间的联系(attention matrix)。这些信息可以是各种不一样的token。而这样一种机制甚至可以很好的表示各种时空关系。如果说模型不能理解我们生活的动态世界,又怎么生成光影和物理运动都合理的视频呢?按照openAI的说法有模拟世界的能力,那transformer可以跻身人类最伟大的发明之一了。 |

|

1. 还是使用的是Transformer 架构,建立在 DALL·E 3 和 GPT 模型之上。 重大的突破在于一分钟,多机位。 2. 同样的, Sora有世界模型的特质。 这里需要解释一下,我们在使用GPT这类的模型时经常会遇到复读机的情况,又或者AI不能很好的画手的问题。 这是因为多数的LLM是运行在『自回归』这个框架下的: 文字模型用上文预测下文,反卷积很多是以图像像素作为输入输出的。 这就导致了出现了很多反常识的情况的存在,比如你可以问之前很多大模型这样的一个问题: 鲁迅为什么暴打周树人 回答的内容看起来很正确,说了鲁迅和周树人是谁,也提到了打人是不对的,但是他就是没有意识到,鲁迅就是周树人。 |

|

|

而且目前很多的AI视频生成,其实就是静态主题在动态的背景,画面十分单调,除了推拉之外,几乎没有什么复杂的运镜。 所谓世界模型,就是要让AI像人类一样,对世界形成一个全面的认知,人类的思考能力其实是有层级的,通过不同的层级去理解这个世界。 所以世界模型,具有抽象,预测,模拟,和交互的能力。 在Sora上,不仅运镜手段更加丰富,多机位也给你添上了。 |

|

|

0 3. 当然,目前的 Sora 还是存在很多的问题: 比如处理不好碰撞,有一些反常识的情况出现,就像魔术一样。 也很难理解因果。 |

|

|

但是他就是这么流畅,一点都没有闪烁。 4. 毫无疑问,还在AI视频生成这个赛道上的公司,如果生成能力还停留在4s左右的,那么现在基本上已经可以宣告死刑,凉透了。 这个赛道的投资逻辑也会发生大的变化,有可能昨天还有投资人计划继续给你打钱,今天一条邮件过来,我们不打算投了。所谓的明星企业,不管是之前的Pika、Runway,必将也会成为一个短命企业,而且这个短命在之前几乎是无法预料的。 所谓的降维打击。 5. 对于影视行业,其实也是一个较大的打击。 因为之前需要的美术布景,布光摄影,剪辑调色,这些以前需要很多人完成的工作,现在只需要一个人,外加一点电费和订阅费用。 6. 要知道,这只是第一版。 |

|

理解运动中的物理世界?真是好笑,Sora的展示完全可以作为反面教材来用,充分说明AI的能力只不过是不懂装懂的水平罢了。 今天早些时候我就做过一个挑刺的内容,告诉大家这些看起来很惊艳的展示到底有多少水分,没看过的可以看下面的链接 如果AI真的能理解物理世界,那么它最起码应该懂得物理规律的均匀性,也就是一条定律不可能在一个地方有效,换了一个地方就无效。 然而,下面这个展示就充分说明AI不理解物理均匀性 仔细看下图红圈与黄圈标注的两处礁石 |

|

|

当海面的波浪卷起之下,下图红圈内的区域就开始失真了 |

|

|

波浪经过礁石的过程是完全不符合物理规律的,失真也非常利害,而经过之后红圈内的礁石消失了,仅剩下黄圈内的礁石 |

|

|

从这个短片我们就可以看到AI对物理规律的理解是不均匀的,但是怎么个不均匀法却不知道,这就有点精分了。 换句话来说,既然AI的物理观是不均匀的,那么它就肯定没有理解什么物理概念。 另外,从这个如此失真的波浪也可以看出AI根本就没有作物理模拟,它也不知道什么是海浪,它只是从其它数据上抄一个看起来差不多的答案出来而已。 我觉得更正确的看法就是Sora直接照抄虚幻5引擎的数据,而不是真正有分析理解过这些数据,所以它根本不存在理解物理世界的能力。 总结来说,Sora是很惊艳,但是千万别细看,不然你会逐渐看出复制粘贴的痕迹,至于说要搞出世界模型,估计还是很遥远的事。 |

|

至少意味着 transformer 的潜力仍旧未被挖掘干。 sora pr 的原文中提到了 sora 的网络模型中也使用了 transformer: Similar to GPT models, Sora uses a transformer architecture, unlocking superior scaling performance. 很显然,从效果上,sora 已经有了一定程度的物理理解,而这有可能是 transformer 网络捕获到的特征。已经有种万事万物都能套 transformer 的感觉了。 那么一个关键的问题是,如果用足够多的仿真数据,是否可以单独训练 transformer 去模拟物理规则?如果 ai 能「模拟」出以假乱真的物理效果,那这就又抛出了另一个有意思的问题:未来游戏物理引擎是否可以靠 ai 模拟去减少运算量,提高用户体验呢? 这就类似于目前 dlss 可以优化光追计算带来的性能瓶颈一样。同理,仿真物理计算也是十分消耗计算资源的。如果未来 ai 能模拟出真实的物理效果,那么玩家可以在消费级电脑上体验到更加真实的爆炸效果、子弹轨迹、水体交互等等。届时游戏的沉浸式体验能更上一层楼。 总之,sora 虽然目前只是 demo,但它确实也再一次的拓宽了人们对于 ai 的想象空间,未来可期! |

|

初步看下来,Sora 给人的感觉可以用震撼来形容。但是似乎也称不上是世界模型。 作为AI行业的佼佼者,OpenAI 的每一个动作都会引起全行业的关注,这次Sora在没有任何预告的情况下突然登场,同样会给行业带来不小的震动。 我注意到OpenAI在介绍Sora的博文中,第一句话是这么写的: We’re teaching AI to understand and simulate the physical world in motion, with the goal of training models that help people solve problems that require real-world interaction. 我们正在教人工智能理解和模拟运动中的物理世界,目标是训练模型来帮助人们解决需要现实世界交互的问题。 也就是说,在OpenAI眼里,Sora并不仅仅是一个文生视频模型这么简单,而是他们把这个技术当成了构建AGI(通用人工智能)系统一个重要环节。AGI与世界的交互不仅体现在文字、图片和语音等信息形式上,还有更直接的视觉视频,这也是我们人类认知和理解世界最重要的方式。所以生成视频、理解视频和理解物理世界,是未来AGI必备能力之一。 的确,我们离AGI又近了一步。 至于Sora算不算世界模型(world models),个人认为还算不上。 世界模型强调构建一个环境的内部表示,并使用它来模拟该环境中未来的事件。到目前为止,世界模型的研究主要集中在非常有限和受控的设置上,要么是在玩具模拟世界中(如视频游戏中的那些),要么是在狭窄的上下文中(如为驾驶开发世界模型)。 通用世界模型的目标将是代表和模拟各种情况和交互,如同在现实世界中遇到的那样。[1] Sora能通过文本生成高质量的视频,证明了它在理解物理世界的能力上相当的提升,但是这种提升依然基于大量的训练,而不是内发的对物理世界的理解,并且Sora对视频的处理依旧是有很多局限的,其中也包括很基本的事实错误。 但不管怎么说,现在来看Sora让文生视频技术上升了一个台阶。 参考^https://research.runwayml.com/introducing-general-world-models |

|

OpenAI技术报告中透露,Sora能够深刻地理解运动中的物理世界,堪称为真正的「世界模型」。 而一直将「世界模型」作为研究重心的图灵巨头LeCun,也卷入了这场论战。 起因是,网友挖出前几天LeCun参加WGS峰会上发表的观点:「在AI视频方面,我们不知道该怎么做」。 在他看来,「仅根据文字提示生成逼真的视频,并不代表模型理解了物理世界。生成视频的过程与基于世界模型的因果预测完全不同」。 |

|

|

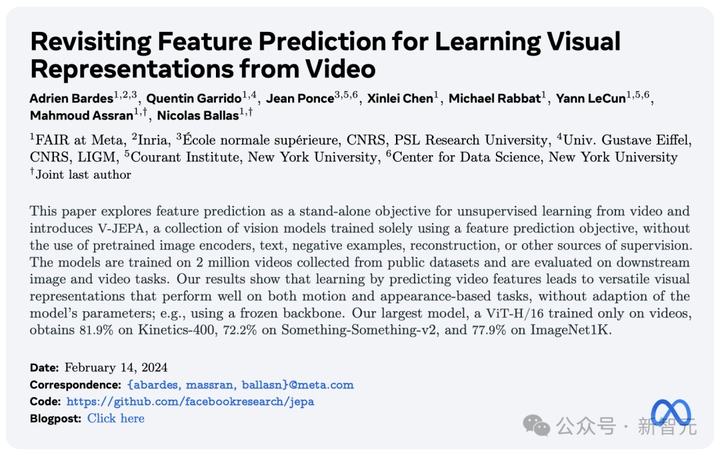

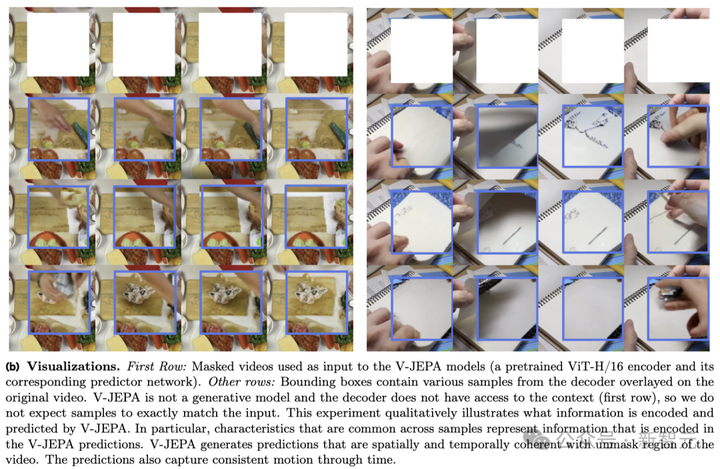

接下来,LeCun更详细地解释道: 虽然可以想象出的视频种类繁多,但视频生成系统只需创造出「一个」合理的样本就算成功。 而对于一个真实视频,其合理的后续发展路径就相对较少,生成这些可能性中的具代表性部分,尤其是在特定动作条件下,难度大得多。 此外,生成这些视频后续内容不仅成本高昂,实际上也毫无意义。 更理想的做法是生成那些后续内容的「抽象表示」,去除与我们可能采取的行动无关的场景细节。 这正是JEPA(联合嵌入预测架构)的核心思想,它并非生成式的,而是在表示空间中进行预测。 然后,他用自家的研究VICReg、I-JEPA、V-JEPA以及他人的工作证明: 与重建像素的生成型架构,如变分自编码器(Variational AE)、掩码自编码器(Masked AE)、去噪自编码器(Denoising AE)等相比,「联合嵌入架构」能够产生更优秀的视觉输入表达。 当使用学习到的表示作为下游任务中受监督头部的输入(无需对主干进行微调),联合嵌入架构在效果上超过了生成式架构。 也就是在Sora模型发布的当天,Meta重磅推出一个全新的无监督「视频预测模型」——V-JEPA。 自2022年LeCun首提JEPA之后,I-JEPA和V-JEPA分别基于图像、视频拥有强大的预测能力。 号称能够以「人类的理解方式」看世界,通过抽象性的高效预测,生成被遮挡的部分。 |

|

|

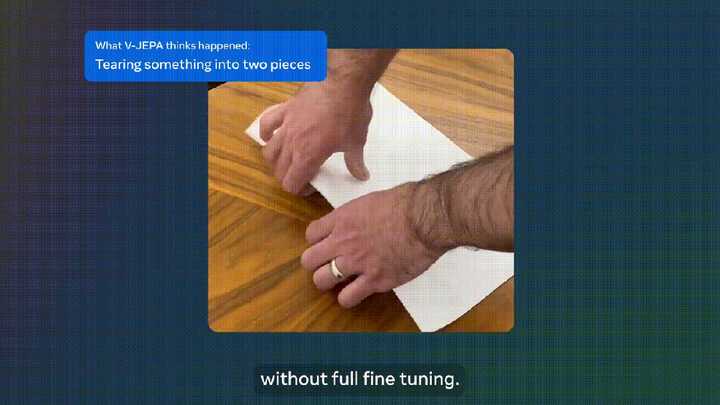

论文地址:https://ai.meta.com/research/publications/revisiting-feature-prediction-for-learning-visual-representations-from-video/ V-JEPA看到下面视频中的动作时,会说「将纸撕成两半」。 |

|

|

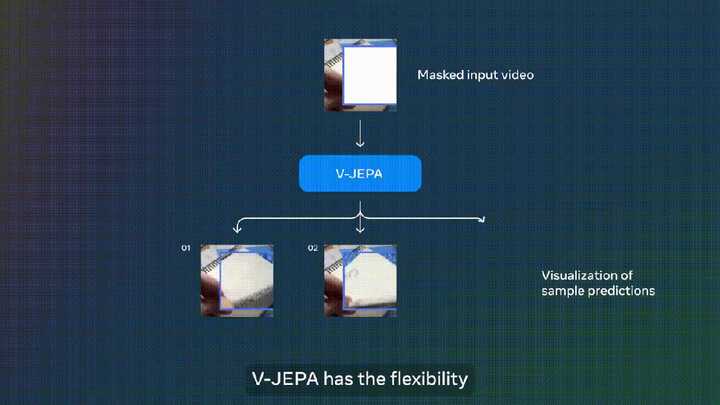

再比如,翻看笔记本的视频被遮挡了一部分,V-JEPA便能够对笔记本上的内容做出不同的预测。 |

|

|

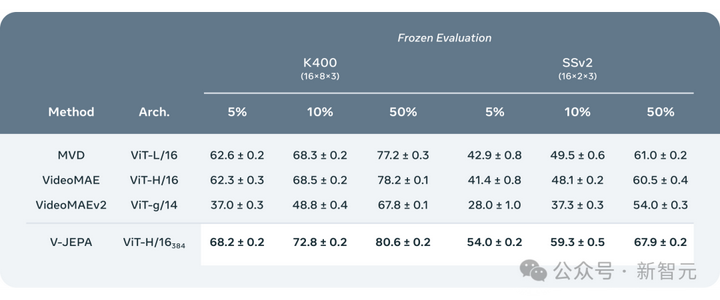

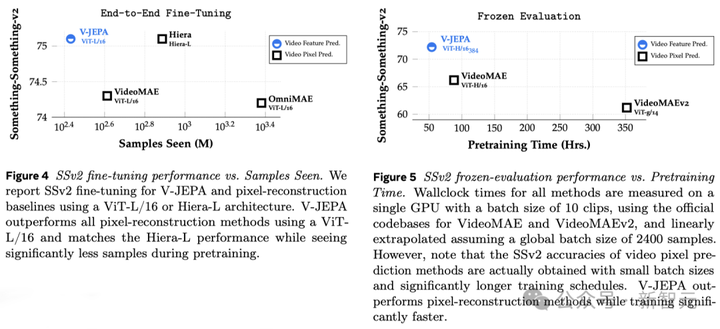

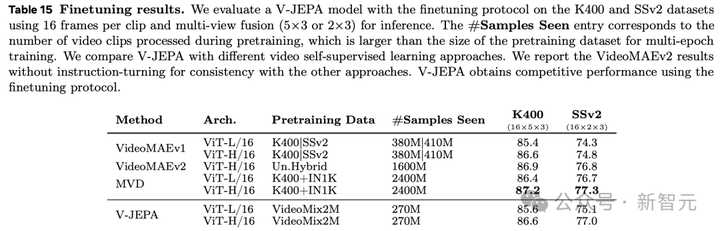

值得一提的是,这是V-JEPA在观看200万个视频后,才获取的超能力。 实验结果表明,仅通过视频特征预测学习,就能够得到广泛适用于各类基于动作和外观判断的任务的「高效视觉表示」,而且不需要对模型参数进行任何调整。 基于V-JEPA训练的ViT-H/16,在Kinetics-400、SSv2、ImageNet1K 基准上分别取得了81.9%、72.2%和77.9%的高分。 |

|

|

看完200万个视频后,V-JEPA理解世界了 人类对于周遭世界的认识,特别是在生命的早期,很大程度上是通过「观察」获得的。 就拿牛顿的「运动第三定律」来说,即便是婴儿,或者猫,在多次把东西从桌上推下并观察结果,也能自然而然地领悟到:凡是在高处的任何物体,终将掉落。 |

|

|

这种认识,并不需要经过长时间的指导,或阅读海量的书籍就能得出。 可以看出,你的内在世界模型——一种基于心智对世界的理解所建立的情景理解——能够预见这些结果,并且极其高效。 Yann LeCun表示,V-JEPA正是我们向着对世界有更深刻理解迈出的关键一步,目的是让机器能够更为广泛的推理和规划。 |

|

|

2022年,他曾首次提出联合嵌入预测架构(JEPA)。 我们的目标是打造出能够像人类那样学习的先进机器智能(AMI),通过构建对周遭世界的内在模型来学习、适应和高效规划,以解决复杂的任务。 |

|

|

V-JEPA:非生成式模型 与生成式AI模型Sora完全不同,V-JEPA是一种「非生成式模型」。 它通过预测视频中被隐藏或缺失部分,在一种抽象空间的表示来进行学习。 这与图像联合嵌入预测架构(I-JEPA)类似,后者通过比较图像的抽象表示进行学习,而不是直接比较「像素」。 不同于那些尝试重建每一个缺失像素的生成式方法,V-JEPA能够舍弃那些难以预测的信息,这种做法使得在训练和样本效率上实现了1.5-6倍的提升。 |

|

|

V-JEPA采用了自监督的学习方式,完全依靠未标记的数据进行预训练。 仅在预训练之后,它便可以通过标记数据微调模型,以适应特定的任务。 因此,这种架构比以往的模型更为高效,无论是在需要的标记样本数量上,还是在对未标记数据的学习投入上。 在使用V-JEPA时,研究人员将视频的大部分内容遮挡,仅展示极小部分的「上下文」。 然后请求预测器补全所缺失的内容——不是通过具体的像素,而是以一种更为抽象的描述形式在这个表示空间中填充内容。 |

|

|

V-JEPA通过预测学习潜空间中被隐藏的时空区域来训练视觉编码器 掩码方法 V-JEPA并不是为了理解特定类型的动作而设计的。 相反,它通过在各种视频上应用自监督学习,掌握了许多关于世界运作方式的知识。 Meta研究人员还精心设计了掩码(masking)策略: 如果不遮挡视频的大部分区域,而只是随机选取一些小片段,这会让学习任务变得过于简单,导致模型无法学习到关于世界的复杂信息。 同样,需要注意的是,大多数视频中,事物随着时间的推移而逐渐演变。 如果只在短时间内掩码视频的一小部分,让模型能看到前后发生的事,同样会降低学习难度,让模型难以学到有趣的内容。 因此,研究人员采取了同时在空间和时间上掩码视频部分区域的方法,迫使模型学习并理解场景。 高效预测,无需微调 在抽象的表示空间中进行预测非常关键,因为它让模型专注于视频内容的高层概念,而不必担心通常对完成任务无关紧要的细节。 毕竟,如果一段视频展示了一棵树,你可能不会关心每一片树叶的微小运动。 而真正让Meta研究人员兴奋的是,V-JEPA是首个在「冻结评估」上表现出色的视频模型。 冻结,是指在编码器和预测器上完成所有自监督预训练后,就不再对其进行修改。 当我们需要模型学习新技能时,只需在其上添加一个小型的、专门的层或网络,这种方式既高效又快速。 |

|

|

以往的研究还需要进行全面的微调,即在预训练模型后,为了让模型在细粒度动作识别等任务上表现出色,需要微调模型的所有参数或权重。 直白讲,微调后的模型只能专注于某个任务,而无法适应其他任务。 如果想让模型学习不同的任务,就必须更换数据,并对整个模型进行专门化调整。 V-JEPA的研究表明,就可以一次性预训练模型,不依赖任何标记数据,然后将模型用于多个不同的任务,如动作分类、细粒度物体交互识别和活动定位,开辟了全新的可能。 |

|

|

- 少样本冻结评估 研究人员将V-JEPA与其他视频处理模型进行了对比,特别关注在数据标注较少的情况下的表现。 它们选取了Kinetics-400和Something-Something-v2两个数据集,通过调整用于训练的标注样本比例(分别为5%,10%和50%),观察模型在处理视频时的效能。 为了确保结果的可靠性,在每种比例下进行了3次独立的测试,并计算出了平均值和标准偏差。 结果显示,V-JEPA在标注使用效率上优于其他模型,尤其是当每个类别可用的标注样本减少时,V-JEPA与其他模型之间的性能差距更加明显。 |

|

|

未来研究新方向:视觉+音频同预测 虽然V-JEPA的「V」代表视频,但迄今为止,它主要集中于分析视频的「视觉元素」。 显然,Meta下一步是研究方向是,推出一种能同时处理视频中的「视觉和音频信息」的多模态方法。 作为一个验证概念的模型,V-JEPA在识别视频中细微的物体互动方面表现出色。 比如,能够区分出某人是在放下笔、拿起笔,还是假装放下笔但实际上没有放下。 不过,这种高级别的动作识别对于短视频片段(几秒到10秒钟)效果很好。 因此,下一步研究另一个重点是,如何让模型在更长的时间跨度上进行规划和预测。 「世界模型」又进一步 到目前为止,Meta研究人员使用V-JEPA主要关注于的是「感知」——通过分析视频流来理解周围世界的即时情况。 在这个联合嵌入预测架构中,预测器充当了一个初步的「物理世界模型」,能够概括性地告诉我们视频中正在发生的事情。 |

|

|

Meta的下一步目标是展示,如何利用这种预测器或世界模型来进行规划和连续决策。 我们已经知道,JEPA模型可以通过观察视频来进行训练,就像婴儿观察世界一样,无需强有力的监督就能学习很多。 通过这种方式,仅用少量标注数据,模型就能快速学习新任务和识别不同的动作。 从长远来看,在未来应用中,V-JEPA强大情境理解力,对开发具身AI技术以及未来增强现实(AR)眼镜有着重大意义。 现在想想,如果苹果Vision Pro能够得到「世界模型」的加持,更加无敌了。 网友讨论 显然,LeCun对生成式AI并不看好。 |

|

|

「听听一个一直在试图训练用于演示和规划的「世界模型」过来人的建议」。 |

|

|

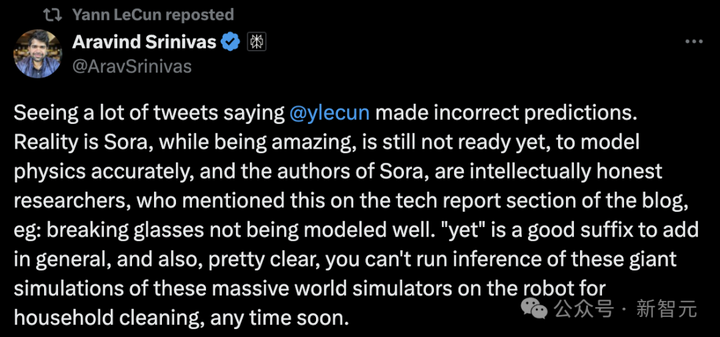

Perplexity AI的首席执行官表示: Sora虽然令人惊叹,但还没有准备好对物理进行准确的建模。并且Sora的作者非常机智,在博客的技术报告部分提到了这一点,比如打碎的玻璃无法很好地建模。 很明显短期内,基于这样复杂的世界仿真的推理,是无法在家用机器人上立即运行的。 |

|

|

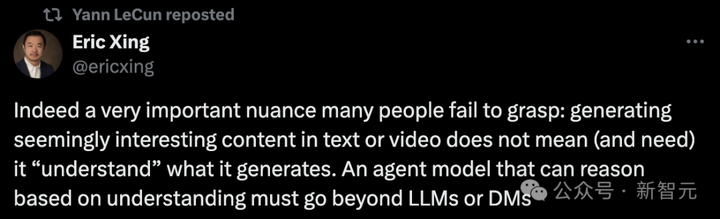

事实上,许多人未能理解的一个非常重要的细微差别是: 在文本或视频中生成看似有趣的内容并不意味着(也不需要)它「理解」自己生成的内容。一个能够基于理解进行推理的智能体模型必须,绝对是在大模型或扩散模型之外。 |

|

|

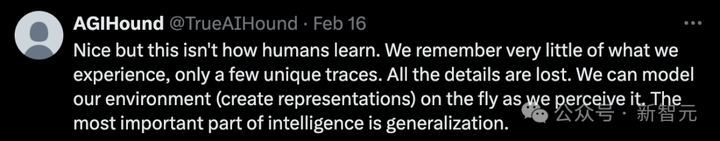

但也有网友表示,「这并不是人类学习的方式」。 「我们对以往经历的只记得一些独特的,丢掉了所有的细节。我们还可以随时随地为环境建模(创建表示法),因为我们感知到了它。智能最重要的部分是泛化」。 |

|

|

还有人称,它仍然是插值潜在空间的嵌入,到目前为止你还不能以这种方式构建「世界模型」。 |

|

|

Sora,以及V-JEPA真的能够理解世界吗?你怎么看? 参考资料: https://ai.meta.com/blog/v-jepa |

|

我们能从视频中学到高质量的世界模型吗?我们能光看视频就学会游泳吗? https://www.zhihu.com/zvideo/1742667808507457536 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |