| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> OpenAI 全新发布文生视频模型 Sora,支持 60s 超长长度,有哪些突破?将带来哪些影响? -> 正文阅读 |

|

|

[科技知识]OpenAI 全新发布文生视频模型 Sora,支持 60s 超长长度,有哪些突破?将带来哪些影响? |

| [收藏本文] 【下载本文】 |

|

OpenAI,发他们的文生视频大模型,Sora了。。。 而且,是强到,能震惊我一万年的程度。。。 https://openai.com/sora 如果… |

|

我请教了英伟达的科研小哥哥,他说技术上主要的突破点,在于 Sora 证明了 diffusion + ViT 的有效性,并把这两家的长处结合了一下。 以此为线索,本炼丹师决定写一篇技术笔记。 以往视频生成的方法Recurrent networks (RNNs)Generative adversarial networks (GANs)Autoregressive transformersDiffusion models 以前的方法通常只能生成特定的视觉类别或更短的、固定分辨率的视频。RNN 和 GAN 的方法由于效果过差,基本可无视。 LLM for Videos? Sora官宣后不久,OpenAI 紧接着发表了一篇技术文章说,受到大语言模型的启发,Sora 采用了类似的视觉补丁(patches)啥啥啥的。 篇幅所限,他们的文章是大大简化了的,没有提到学术届的很多上下文。使用视觉 transformer 处理视频以及分词器的想法并不是新的创意。 |

|

|

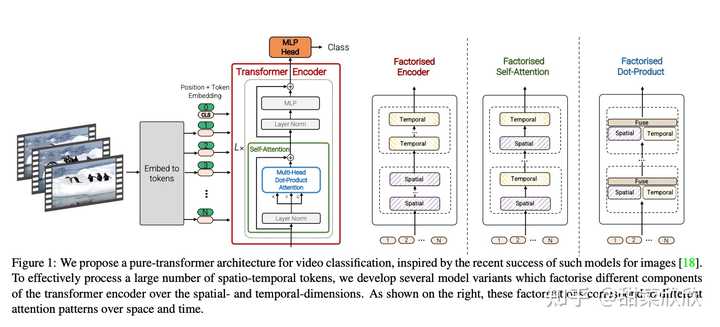

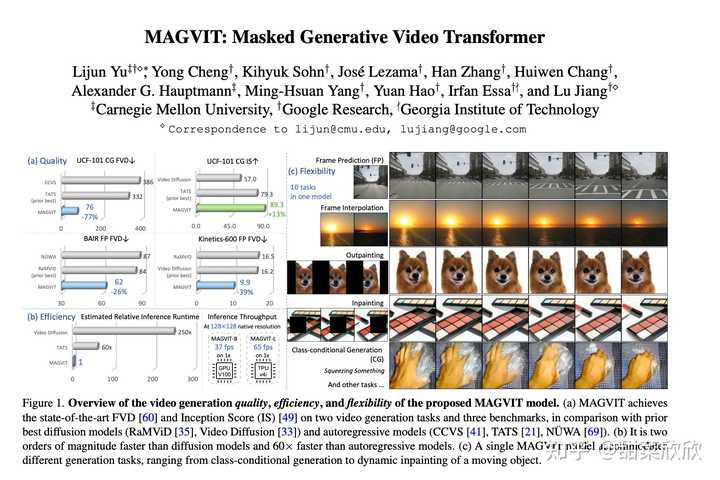

谷歌在2021年提出的 ViViT,就是一种基于视觉 transformer 的视频分类模型。 因此,我向英伟达的 AI 研究员询问了 Sora 的新颖之处。他说在学术界,科研人员一直在争论 ViT 和 UNet 架构在文生视频方面谁更好。近年来,ViT 似乎成为主流视觉架构的模型,不过 UNet 仍然在扩散模型领域占据主导地位。从 DALL·E 2 到 Stable Diffusion,UNet 广泛应用于文生视觉模型。 2023 年,谷歌提出了 MAGVIT,使用通用标记词汇为视频和图像生成简洁且富有表现力的编码。 |

|

|

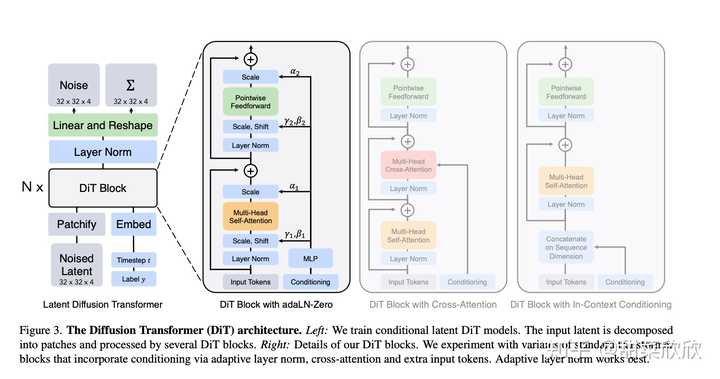

谷歌的 MAGVIT 论文,花花绿绿的我学懂了再跟你们说 MAGVIT v2 论文名为 《Language Model Beats Diffusion: Tokenizer is Key to Visual Generation》,翻译过来就是《大语言模型打败扩散模型:分词器是视觉生成的关键》。标题就体现了“战争”的实况。这个模型后来被集成到谷歌的 VideoPoet 中,这是一种用于零镜头视频生成的大模型。 从这个角度来说,Sora 证明了 DiT 的技术路径,创新点还是非常大的。接下来讲一讲,DiT 是啥。 网络结构 论文《Scalable Diffusion Models with Transformers》中提出了一种叫 DiT 的神经网络结构,结合了视觉 transformer 和 diffusion 模型优点。 DiT = VAE encoder + ViT + DDPM + VAE decoder |

|

|

ICCV 2023 paper proposes a diffusion model with a transformer Backbone. (https://arxiv.org/pdf/2212.09748.pdf) 对于 DiT 在 Sora 中的应用,DiT 作者之一 Saining Xie 在推文中提到: 由 batch size 大小相关的计算推导,Sora 可能有大约 30 亿个参数。 “训练 Sora 模型可能不需要像人们预期的那样多的 GPU;我预计未来会有非常快的迭代。”Sora“可能还使用了谷歌的 Patch n’ Pack (NaViT) 论文成果,使其能够适应可变的分辨率/持续时间/长宽比。”视频压缩 根据 Sora 官博,视频训练的时候被压缩为紧凑的时空编码;然后有一个解码器模型可以将生成的编码反向生成为用像素表示的格式。 |

|

|

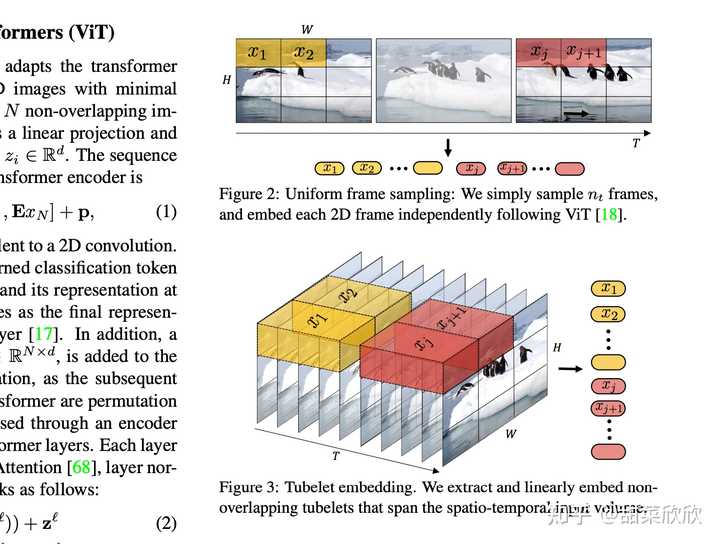

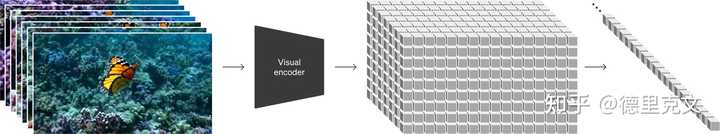

从谷歌的 ViViT 论文里偷个图,感受一下到底啥是时空编码 Saining 大佬评论:“看起来这就是一个 VAE 结构,加上用原始视频数据进行训练。” 文字理解Sora 官博透露,他们训练了一个模型来生成视频对应的字幕,这个模型最早在 DALL·E 3 的论文中提出。这大大提高了 Sora 对用户输入文本的理解能力和整体视频的质量。团队还利用 GPT 将用户的短文本提示转换为详细的标题。重写提示几乎是当今 AI 产品的标准做法,以弥合用户指令和模型行为之间的隔阂。训练数据人们猜测 Sora 的训练涉及用 3d 引擎额外渲染出的视频。合成数据的广泛使用一定在 Sora 的训练中发挥了重要作用。Sora 将视频在原始长宽比训练,以获得更好的构图和取景。Takeaways Sora 证明了大力出奇迹的规律也适用于视频生成,使用 DiT 模型和 token 编码的理念,实现了惊人的生成结果。我们看到,Sora 能平稳地移动摄像机,也能保持物体前后一致的模样,记住物体在哪里,并使视频中的物体互动。 Sora 的一个重大进步是它能够创建很长的视频;制作 5 秒钟的视频和 1 分钟的视频,两者的技术路径非常不同。在 Sora 之前研究人员想知道,长视频生成是否需要针对特定??类别甚至复杂的物理模拟器。 Sora 告诉我们,端到端的通用模型训练就能做到长视频的生成。 视频生成的突破还将助力 3D 生成、自动驾驶和机器人技术等许多其他领域,最终能够模拟物理世界。 |

|

|

GAIA-1 模型能合成各种道路的视觉信息,帮助自动驾驶领域的模型训练。 (https://arxiv.org/pdf/2309.17080.pdf) 视频生成的下一个挑战于是变成,如何解决错误累积问题,随着时间的推移还能保证视频质量和一致性。 等Sora 正式上线,期待能亲手测试一下,得到更多结论~ |

|

我感觉就是炫技+打脸,你们不是很多人说自己的多模态是 SOTA 了吗,那拉出来生成个 60s 的稳定视频试试?没病?没病走两步。 Runway 是 18s(20s 以内),Pika 最开始是 3 秒,Sora 抬手就是 60s,见面就贴脸放大招。 简单过一下 Sora 的技术报告吧[1],干货很多。我觉得重点: Scaling Law 依然存在不只是文生图,可以拼接视频,完美插帧,作为视频编辑使用更好理解物理世界,世界模型?视频生成模型作为世界模拟器 我们对如何在视频数据上进行大规模的生成模型训练进行了探索。具体而言,我们对持续时间、分辨率和宽高比各不相同的视频和图像进行了文本条件下的扩散模型联合训练。我们采用了一种变压器架构,这种架构能够处理视频和图像潜在编码的时空补丁。我们最强大的模型,Sora,能够生成长达一分钟的高清视频。我们的结果表明,扩展视频生成模型是构建通用物理世界模拟器的有希望的路径。 本技术报告主要关注以下两个方面:(1)我们将各种类型的视觉数据转化为统一的表示方法,以便进行大规模生成模型的训练;(2)对Sora的能力和限制进行定性评估。模型和实现细节不包含在本报告中。 许多先前的研究都使用了各种方法对视频数据进行生成建模,包括循环网络、生成对抗网络、自回归变换器和扩散模型。这些研究通常专注于特定类型的视觉数据、较短的视频或固定尺寸的视频。Sora是一种对视觉数据进行广义建模的模型,它可以生成跨越不同持续时间、宽高比和分辨率的视频和图像,高清视频的长度可达一分钟。 将视觉数据转化为 patch 我们从大型语言模型中汲取灵感,这些模型通过在互联网规模的数据上进行训练获得了通用能力。成功的LLM范式在一定程度上得益于使用了能够优雅地统一文本、代码、数学和各种自然语言的标记。在这项工作中,我们考虑了生成视觉数据模型如何继承这些好处。而LLMs具有文本标记,Sora具有视觉补丁。先前已经证明patch是一种有效的视觉数据模型表示方法。我们发现,patch是一种高度可扩展且有效的表示方法,适用于训练各种类型的视频和图像的生成模型。 |

|

|

在高层次上,我们通过首先将视频压缩成低维潜空间,然后将表示分解成时空patch来处理视频。 视频压缩网络 我们训练一个网络,降低视觉数据的维度。这个网络以原始视频作为输入,并输出一个在时间和空间上都被压缩的潜在表示。Sora在这个压缩的潜在空间中进行训练,并生成视频。我们还训练了一个相应的解码器模型,将生成的潜在表示映射回像素空间。 时空潜在补丁 给定一个压缩的输入视频,我们提取一系列时空补丁,它们充当变换器令牌。这个方案也适用于图像,因为图像只是具有单个帧的视频。我们基于补丁的表示使得Sora能够在分辨率、持续时间和宽高比可变的视频和图像上进行训练。在推理时,我们可以通过将随机初始化的补丁排列在适当大小的网格中来控制生成的视频的大小。 视频生成的 Scaling transformer Sora是一个扩散模型,给定输入的噪声补丁(以及像文本提示这样的条件信息),它被训练成预测原始的“干净”补丁。重要的是,Sora是一个diffusion transformer。transformer 在各个领域展示了显著的扩展性能,包括语言建模、计算机视觉、图像处理和图像生成。 |

|

|

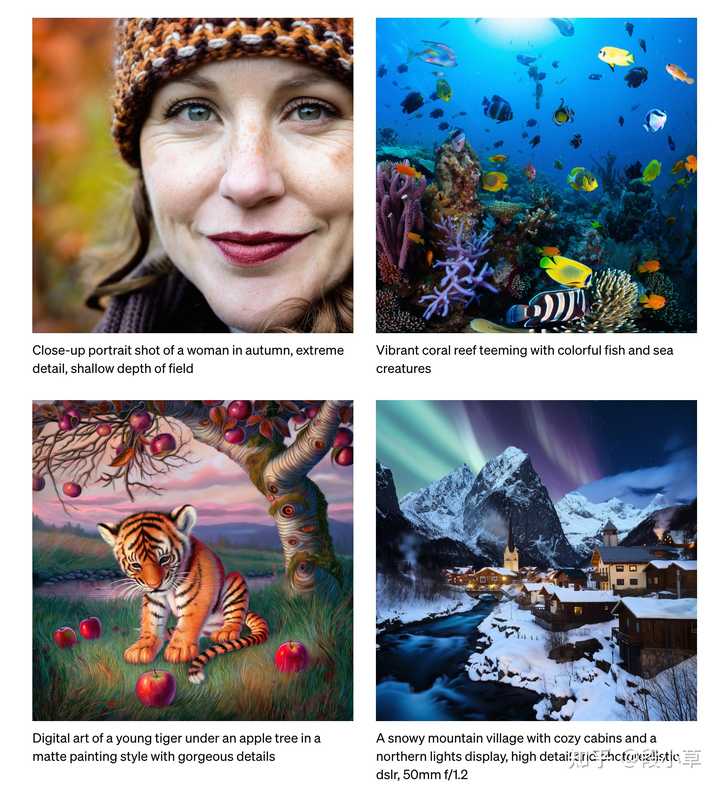

在这项工作中,我们发现diffusion transformer在视频模型中也能有效地进行扩展。下面,我们展示了在训练过程中使用固定种子和输入的视频样本的比较。随着训练计算的增加,样本质量显著提高。 可变的持续时间,分辨率,画面比例 过去生成图像和视频的方法通常是将视频调整大小、裁剪或修剪到标准尺寸 - 例如,256x256分辨率的4秒视频。我们发现,相反,使用原始尺寸的数据进行训练有几个好处。 采样灵活性 Sora可以采样宽屏1920x1080p视频、竖屏1080x1920视频以及两者之间的所有内容。这使得Sora可以直接以原生宽高比为不同设备创建内容。它还可以让我们在生成全分辨率内容之前,快速原型化较低尺寸的内容 - 所有这些都使用同一模型。 改善的构图和布局 我们经验性地发现,在其原生宽高比上训练视频可以提高构图和布局的质量。我们将Sora与另一个版本的模型进行比较,后者将所有训练视频裁剪为正方形,这是训练生成模型时的常见做法。相比之下,Sora生成的视频在构图上有所改善。 语言理解 训练从文本到视频的生成系统需要大量配有文本标题的视频。我们采用了在DALL·E 3中引入的重新标注技术,应用于视频。我们首先训练一个高度描述性的标题生成模型,然后用它为我们训练集中的所有视频生成文本标题。我们发现,在高度描述性的视频标题上进行训练,可以提高文本的准确性以及视频的整体质量。 类似于DALL·E 3,我们还利用GPT将简短的用户提示转换成更长、更详细的标题,这些标题随后被送往视频模型。这使得Sora能够生成高质量的视频,精确地根据用户的提示进行创作。 图像和视频作为prompt 以上所有结果和我们的页面都展示了文本到视频的示例。但是Sora也可以接受其他输入,比如现有的图片或视频。这种能力使得Sora能够执行各种图像和视频编辑任务,比如创建完美循环的视频,给静态图像添加动画效果,将视频向前或向后延长等等。 DALL·E图像动画化 Sora能够根据输入的图像和提示生成视频。 扩展生成的视频 Sora还可以将视频向前或向后延长时间。 视频到视频编辑 扩散模型已经为从文本提示编辑图像和视频提供了大量的方法。下面我们将其中一种方法,SDEdit,应用于Sora。这种技术使得Sora能够零样本地转换输入视频的风格和环境。 拼接视频 我们还可以使用Sora逐渐插值两个输入视频,从而在完全不同的主题和场景构图之间创建无缝过渡。 图像生成能力 Sora还能够生成图像。我们通过在一个帧的时间范围内,将高斯噪声的补丁排列在一个空间网格中来实现这一点。该模型可以生成不同尺寸的图像,最高分辨率可达2048x2048。 |

|

|

涌现的模拟能力 我们发现,当视频模型在大规模训练时,它们展现出一些有趣的新兴能力。这些能力使得Sora能够模拟出一些来自物理世界的人、动物和环境的某些方面。这些特性并没有任何明确的归纳偏见,比如对于3D、物体等等,它们纯粹是规模效应的现象。 3D一致性。Sora可以生成具有动态摄像机运动的视频。随着摄像机的移动和旋转,人物和场景元素在三维空间中保持一致移动。 长程一致性和物体永久性。对于视频生成系统来说,一个重要的挑战是在采样长视频时保持时间上的一致性。我们发现,Sora通常能够有效地建模短程和长程的依赖关系,尽管并非总是如此。例如,我们的模型可以在人、动物和物体被遮挡或离开画面时仍然保持它们的存在。同样,它可以在一个样本中生成同一角色的多个镜头,并在整个视频中保持它们的外观。 与世界互动。索拉有时可以模拟对世界产生简单影响的动作。例如,画家可以在画布上留下持续存在的新笔触,或者一个人可以吃掉一个汉堡并留下咬痕。 模拟数字世界。Sora还能够模拟人工过程,一个例子是视频游戏。Sora可以同时使用基本策略控制Minecraft中的玩家,同时以高保真度渲染世界及其动态。通过提示Sora提到“Minecraft”的标题,可以激发这些能力。 这些能力表明,继续扩展视频模型是发展高能力物理和数字世界以及其中的物体、动物和人类的模拟器的有希望的途径。 结论 Sora目前作为模拟器存在许多限制。例如,它无法准确模拟许多基本交互的物理效应,比如玻璃破碎。其他交互,比如吃东西,也不总是能正确地改变物体状态。我们在我们的首页上列举了模型的其他常见故障模式,比如在长时间样本中出现的不连贯性或物体的突然出现。 我们相信Sora今天所具备的能力表明,继续扩展视频模型是发展能够模拟物理世界、数字世界以及其中的物体、动物和人类的有希望的路径。 参考^https://openai.com/research/video-generation-models-as-world-simulators |

|

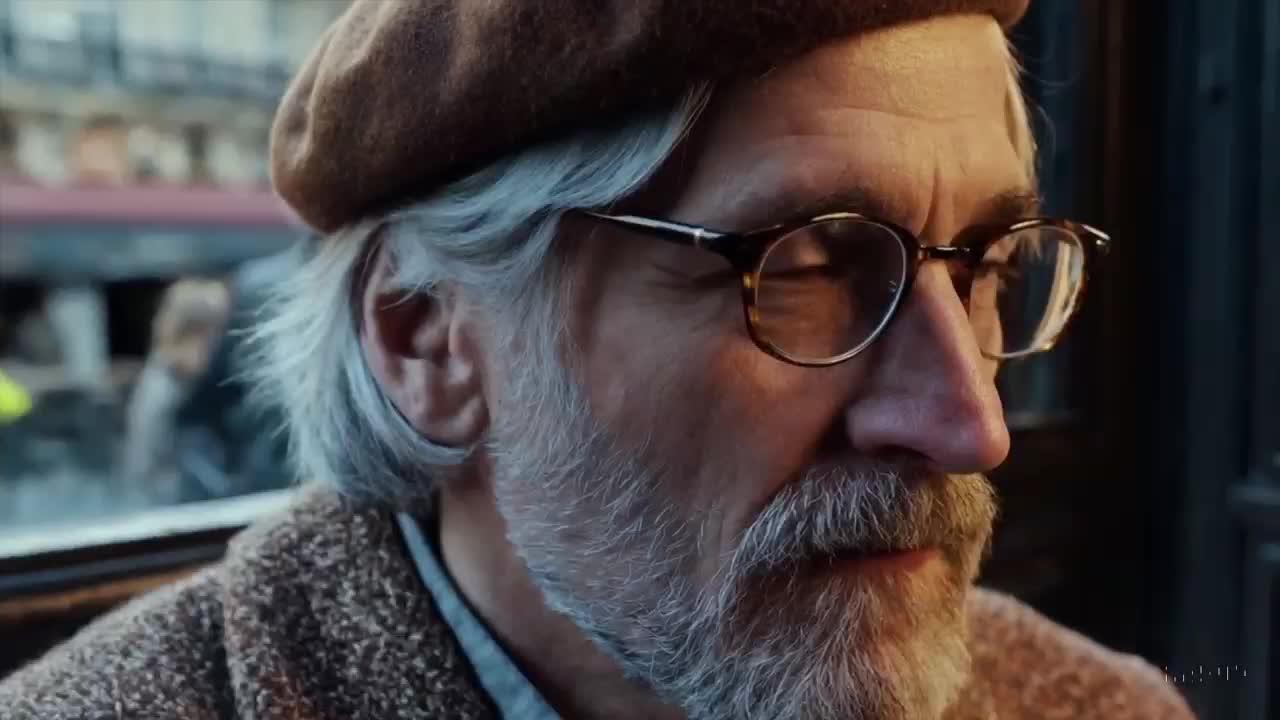

直接给大家看视频和对应的Prompt吧,这样有比较直观的体验: 视频①:东京街头散步,时长1分钟 |

|

|

0 Prompt: A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about. 上一个视频主打一个「真实」,我们看看这个视频,主打一个「历史再现」 视频②,猛犸象再现,时长10秒 |

|

|

0 Prompt: “Several giant wooly mammoths approach treading through a snowy meadow, their long wooly fur lightly blows in the wind as they walk, snow covered trees and dramatic snow capped mountains in the distance, mid afternoon light with wispy clouds and a sun high in the distance creates a warm glow, the low camera view is stunning capturing the large furry mammal with beautiful photography, depth of field.” 对于动画片段的制作,Sora也可以给出惊人的质感,我们看看这个小恶魔的视频: 视频③:小恶魔玩蜡烛,时长9秒 |

|

|

0 Prmopt: “Animated scene features a close-up of a short fluffy monster kneeling beside a melting red candle. the art style is 3d and realistic, with a focus on lighting and texture. the mood of the painting is one of wonder and curiosity, as the monster gazes at the flame with wide eyes and open mouth. its pose and expression convey a sense of innocence and playfulness, as if it is exploring the world around it for the first time. the use of warm colors and dramatic lighting further enhances the cozy atmosphere of the image.” 再来看看电影级的片段生成,这个片段的特点是多镜头切换 视频④,红帽子宇航员,时长17秒 |

|

|

0 Prompt: “A movie trailer featuring the adventures of the 30 year old space man wearing a red wool knitted motorcycle helmet, blue sky, salt desert, cinematic style, shot on 35mm film, vivid colors.” (备注,从prompt看不出有镜头切换的语言,不清楚是否OpenAI给出的Prompt是否有所省略) 再来看一个折纸的海底世界,有一点像折纸动画片的感觉: 视频⑤:折纸的海底世界,时长20秒 |

|

|

0 Prmopt: “A gorgeously rendered papercraft world of a coral reef, rife with colorful fish and sea creatures.” 最后看看这几个可爱的小金毛,毛发的柔软和雪的蓬松感 视频⑥,雪中小金毛,时长20秒, |

|

|

0 Prompt: A litter of golden retriever puppies playing in the snow. Their heads pop out of the snow, covered in. 目前,OpenAI还没有开放测试,我们只能从这个官网[1]上看到这些视频,还有OpenAI在X上的账号[2]。 OpenAI在官网上明确说明:这些视频都是直接生成,没有经过编辑修改的。 All videos on this page were generated directly by Sora without modification. 等OpenAI正式开放了Sora试用,我们才能有真正的直观体会。 不过,很显然,我们已经被AI拽入了『文生视频』的时代。 在这个时代生存的第一要义是:掌握好自然语言,把语文和英语都要学好。 『好好思考,把话说好,剩下的事情交给AI』,这句话可能是未来的学校里,老师们的口头禅了。 生成式视频的到来,这是个双刃剑,意味着虚假信息会真到无以复加。 当然,AI生成视频要大规模应用,所需要的算力和能源开销还是瓶颈,因此短期内无法大批量铺开。 高质量的文生视频app,未来的价格也不会太便宜。 目前最大的问题是成本。 ChatGPT Plus账号每天最多生成50张图片,这相当于50帧,也就是两秒的视频。 每天两秒视频,这是不可能商业化的。 如果一个付费账号每天可以生成10分钟左右的视频,将会有一定的吸引力。 这是600秒,相当于现阶段300个Plus账号的最大图片生成量。 这300个Plus账号一个月的费用是6000美元。 所以,OpenAI还有很长的路要走,我们不应该仅仅关注『样片』质量,更要关注成本问题。 这个问题要解决起来,并不容易。 参考^Sora - OpenAI https://openai.com/sora^OpenAI - X https://twitter.com/OpenAI |

|

60秒超长本来就是一个特别大的突破,更别提还有“单视频多角度镜头” ,超强的语义理解,以及真实世界物理规则的复现。 |

|

|

0 让我感到震撼的原因并不仅仅是因为文生视频的时长和稳定性,而是在视频中展示的语义理解和对于真实世界物理规律的再现! 一、直接影响 就在昨晚,Google刚刚公布了Gemni Pro1.5,OpenAI就在几个小时后发布了Sora。 |

|

|

Gemini1.5具有100万token的上下文理解能力,具有跨模态理解和推理,能够对文本、代码图像、音频和视频进行高度复杂的理解和推理。 允许分析1小时视频、11小时音频、超过30,000行代码或超过700,000字的文本, 这都是令人惊叹的成绩。 但是,OPENAI抢了头条,Sora 的公布过于炸裂,以至于聚光灯完全聚焦在OPENAI上。 二、Sora视频震撼 我再来上一些Sora视频的震撼效果。 |

|

|

0 |

|

|

0 |

|

|

0 |

|

|

0 |

|

|

0 |

|

|

0 |

|

|

0 |

|

|

0 我看完的感觉只有一个,变天了! 三、突破还是积累 而当我们深入分析Sora今天展现出的炸裂效果,其实这个效果成功并非毫无踪迹。 而更加可怕的是,这可能只是OPENAI目前拥有武器库里面想让世人知道的部分。 |

|

|

Sora模型之所以能够展现出卓越的性能,很大程度上得益于OpenAI这个公司,过往在人工智能领域的深耕细作,包括ChatGPT、DALL·E等各种类型的人工智能产品的创新技术。 这些技术不仅被直接应用,其背后的思路和方法也被这次Sora进行巧妙借鉴和融入。 OpenAI先塑造了一个别人仰望的高塔,随后又在这个高塔的平台上再次搭建起新的高度,从而成为领域内一个可望也不可及的高度。 |

|

|

这种自我超越和创新的能力,才是OpenAI能够在人工智能领域持续领先的关键。 相比之下,无论是国内还是国际上的其他竞争对手,在文本生成文本、文本生成图像等技术上可能存在差距。这种差距可能会导致他们在未来的竞争中落后更多。 因此,所谓的“差距只有X个月”可能只是一种自我安慰的说法,而所谓的“弯道超车”在现实中可能难以实现。 三、影响1.能力 让我们先来看看根据OPENAI公布的文档,Sora能干些啥: 大规模视频数据训练:Sora模型通过在不同时长、分辨率和宽高比的视频和图像上进行训练,展示了在大规模数据集上训练生成模型的能力。 |

|

|

视觉数据的统一表示:Sora采用了类似于大型语言模型(LLM)的方法,将视觉数据转换为空间-时间(spacetime)补丁(patches),这些补丁作为模型的“视觉标记”(visual tokens),使得模型能够处理多样化的视频和图像。 |

|

|

A Shiba Inu dog wearing a beret and black turtleneck. 视频压缩网络:Sora使用了一个视频压缩网络,将原始视频压缩到一个低维潜在空间,并将其分解为空间-时间补丁。这使得模型能够在压缩的潜在空间中训练和生成视频。 |

|

|

扩散模型:Sora是一个扩散模型,它通过预测输入的噪声补丁(noisy patches)来生成清晰的视频。这种模型在语言建模、计算机视觉和图像生成等领域已经显示出了显著的扩展性。 |

|

|

视频生成的灵活性:Sora能够生成不同分辨率、宽高比的视频,并且可以直接为不同设备生成内容,提高了内容创作的灵活性。 语言理解与文本提示:Sora通过训练高度描述性的字幕模型,提高了视频生成的文本准确性和整体质量。它还能够根据用户的简短提示生成详细的字幕,从而生成高质量的视频。 |

|

|

图像和视频编辑:Sora不仅能够基于文本提示生成视频,还能够基于现有图像或视频进行编辑,执行如循环视频创建、静态图像动画化、视频前后延伸等任务。 |

|

|

2.模拟 Sora可以用简单的方式实现真实世界物理状态模拟。 例如在画面中,一个画家可以在画布上留下新的笔触,并随着时间的推移而持续。又或者是一个男人可以吃汉堡并留下咬痕。 Sora还能够模拟人工过程,例如电子游戏。Sora可以用一个基本策略同时控制《我的世界》中的玩家,同时也可以高保真地渲染世界及其动态。 |

|

|

0 目前已有一些视觉艺术家、设计师和电影制作人(以及OpenAI员工)获得了Sora访问权限。 3.局限 不过Sora依然还存在一些局限性。 它不能准确地模拟许多基本相互作用的物理过程,比如玻璃破碎;而其他相互作用,比如吃食物这个动作,Sora并不总是能产生物体状态的正确变化。 |

|

|

OPENAI也在文章中列举了该模型的其他常见故障模式,如长时间样本中出现的不相干或对象的自发出现。 Sora今天的能力表明,视频模型的持续扩展是开发物理和数字世界以及生活在其中的物体、动物和人的强大模拟器的一条很有前途的道路。 4.未来 我认为在未来,以Sora为代表的文生视频模型,可能在以下方向对各行业进行影响: 内容创作的革新:生成多样化的视频内容能够为电影、游戏、广告等行业提供新的内容创作工具。 交互式媒体:Sora的能力可以用于创建交互式媒体体验,如根据用户输入实时生成或修改视频。 |

|

|

教育和培训:在教育领域,Sora可以用于模拟复杂场景,提供更加生动的学习材料。 娱乐产业:Sora可以用于创造新的娱乐形式,如虚拟现实和增强现实体验。 科学研究:在模拟物理现象和环境方面,Sora可以辅助科学家进行研究和预测。 结语 AGI的未来或许真的不远了! 我是德里克文,一个对AI绘画,人工智能有强烈兴趣,从业多年的 设计师!如果对我的文章内容感兴趣,请帮忙关注点赞收藏,谢谢! |

|

Sora 生成视频长度能达到分钟级别,的确令人感到震撼。 有多震感,看看下面这张图(来源)就能体会到了,这是过去一年比较主要的 AI 生成视频模型,其中包括之前就大火的RunWay、Pika 以及 Stability 的 SAD 等。 这些模型或工具所生成的视频长度最长不过十几秒。 |

|

|

从十几秒到一分钟,其难度并不是简单的倍数的相乘。 限制 AI 视频长度的因素大体上可以分为几个方面。 1、计算资源。大家都知道,在AI领域,生成或处理二维的图像数据已经要比处理文本数据需要更多的计算资源,而视频是由连续的多帧图像组成的,生成视频所需要的计算资源又会几何级数的增加。生成几秒钟的视频就已经需要消耗大量计算资源,而生成更长的视频则需要更大规模的计算资源来支持。 但是这还不是最难的,毕竟计算资源还能通过钱来解决,小公司玩不起,还是大厂呢。 2、内容连贯性和逻辑性。 对于文生视频技术,比计算资源更关键的是生成视频的时间连续性和逻辑性的维护。 也就说如何准确地理解和预测物体的运动和变化,既要时间上连贯,又要符合物理世界规律,这才能保证生成的视频是逼真的。比如台球,不能上一帧还在桌上滚动,下一帧就飞到天上去了。否则,“物理学就不存在了”。 |

|

|

开发能够理解复杂叙述结构和逻辑关系的文生视频模型是非常困难的,而且时间越长,维持这种连贯性和逻辑性就会越难,不光体现在对未来视频帧内容的预测上,还体现在对于错误的修正上。 OpenAI 在 Sora 的技术报告(链接)中介绍了Sora所采用的技术路线,大的思路跟目前其他采用的方法看起来没有本质区别。 也就是把图像数据看成多个patches(类似于LLM中的tokens),基于patches的表征是可扩展性和表征能力方面都很有效,可用于在不同类型的视频和视频上训练生成模型图片。 |

|

|

Sora是一个基于Transformer的扩散模型,类似于其他扩散模型的工作过程,给定噪声 patches 以及文本提示等调节信息作为输入,模型通过去噪声过程预测原始的patches(图像)。 |

|

|

OpenAI在技术报告中提到了一种扩展生成视频(Extending generated videos)技术,使得 Sora 具备一项独特的能力——可以让视频在时间线上向前或向后扩展。比如在官方演示的一个例子中,有几段不同的视频,都是从一个生成的视频片段开始向后延展的。这四个视频的开始各不相同,但都导致了相同的结尾。 |

|

|

|

|

|

利用此方法向前和向后扩展视频以产生无缝的无限循环。 (待更。。。 相关内容: |

|

对互联网用户来说 Sora一时间风头无两,相似时间发布的Google Gemini1.5,可以处理100万个token的牛逼东西,溅起的水花比起Sora差的太多。 大部分的吸引力都被Sora吸引了过去,不过短时间内不能使用上,所以关注会逐渐降低,直到放开使用后会产生第二波狂潮。 |

|

|

对其他的视频生成同行来说 OpenAI简直是AI届的同行杀手,别家还是努力在生成的4秒钟视频中保持一致性的时候,Sora直接给你干到1分钟。 比如Runway,Pika等等,但是一旦拿出来比较的话,从放出来的资料里面看,Sora要远远强于其他的主流视频生成工具,无论是60s的长度,单视频多角度以及各种物理规则的理解。 SoraPikaRunway焦点文本到视频,专注于真实的、以人为中心的结果图像到视频,带有动画和风格迁移广泛的视频编辑,包括AI驱动的生成工具持续时间长达60秒3秒4秒功能性非常强大不太强大相当强大输入模态主要是文本提示图像,有时伴有文本指导图像、视频、文本输出风格多样化输出,旨在实现现实主义更加风格化和艺术化的动画广泛的范围,从风格化到照片级真实,取决于使用的工具限制尚未公开可用在处理复杂或抽象概念时可能不太成功可能很复杂,需要一些视频编辑知识主要优势现实主义,理解人类行为和复杂场景创造性的动画静态图像,风格化效果多功能性,全面的视频编辑器具备AI功能对于AI从业者来说 AI热度会继续保持,在一定时间内,视频生成这类型的工作机会会变多,同时薪资水平也会很不错。短期内是好事。 我知道有朋友做视频生成领域,年薪非常非常的让人羡慕。 对于AI创业者来说 有人欢喜有人忧 Sora的效果可能会引起更多人对于视频生成领域的关注与投资,在总体投资变大的前提下,肯定会有几家公司也会获得一定的投资,短期内不算坏现象。 但是Sora的效果似乎有点儿太好,很可能会导致别家怎么追也追不上,完了被淘汰。 对想要做AI相关产品的人来说 普遍觉得OpenAI像神出鬼没的压路机,不知道什么时候会放一个大招,然后把某条路线上的同行全部都碾死。 对于普通人来说 短期内是好事,意味着我们可以用AI生成文字和图像之后,也可以用AI来生成不错的视频了。 你要是有想法有行动力,自己做一部纯AI生成的电影也不是不可能。 AI大舞台,你胆你就来。 |

|

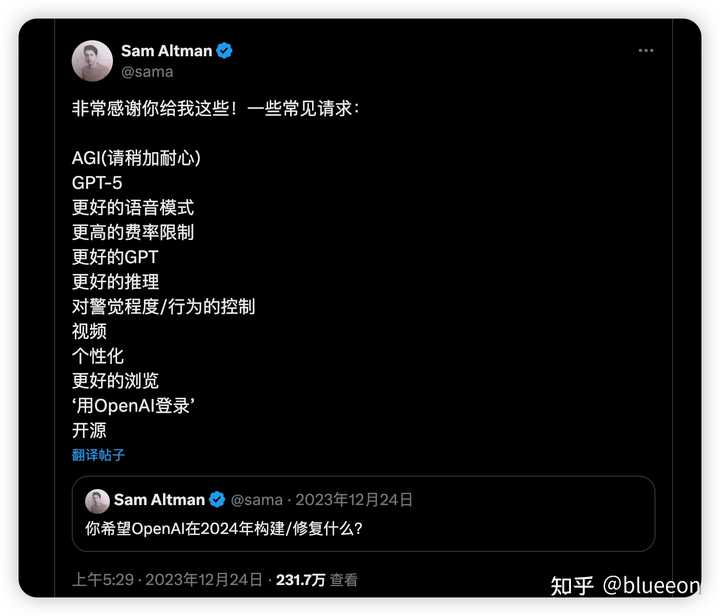

一觉起来,被OpenAI 的 Sora刷屏了。看了官网的演示视频,效果太令人震惊了,它值得被刷屏! sora的突破 官网的那些演示视频,值得反复琢磨。演示视频中最令人印象深刻的有几点: 视频的长度:演示视频最长1分钟,从此视频生成领域,告别秒时代,跑步进入分钟时代。 视频的尺寸:视频的尺寸非常多样,宽屏的竖屏应有尽有。连续性和一直性:很多视频具有多个分镜,每个分镜里的细节依然得到了很好的保持。最神奇的是A movie trailer 这个短片,用“A movie trailer”这一个Prompt,生成的17秒视频里,塞下了整整10个分镜啊,还能继续保持画面一致性。太震惊了! 以及视频的质量:生成的视频的分辨率高达1920?×?1080,不再是pika那种256x256分辨率,pika之类的直接原地去世意味着什么? 对普通人和创作者,有人甚至惊呼(也可能是自媒体的标题党): Sora一出,所有的视频人、电影人都下岗! 这个世界上,AI真的分两种,OpenAI 和其他AI。普通人想了解AI最新进展,完全不需要订阅其他AI,最省力策略就是:保持专注,紧跟OpenAI。 对从业者: 如果在创业做的项目跟openai有可能重叠,尽早避让,打不过完全打不过。。 视频生成甚至只是下面这个列表里面排名不那么靠前的一个常见请求!! |

|

|

山姆奥特曼去年年底在推上收集的用户期望,回避!!! 早上一个朋友在群里感叹: 很多老算法科学家几十年的经验积累,在大力出奇迹的算力加数据的暴力美学面前,都成了暂时的投机取巧。昨日还是红花一样鲜艳的明星,被技术的洪流淹没窒息而死时候,连点预兆都没有。sora的实现 快速看了下Tenical Report,sora背后技术的一些点: sora定义了视频训练和推理的基本单元是Patches,就像语言模型用的tokens能统一自然语言/代码和数学一样,sora训练过程用的 patches 也统一了视频和图片,图片就=单帧的视频。从此图片和视频被统一了,以前OpenAI Dalle-3海量的图片数据都可以被用来训练基本思路框架还是transformer+diffusion:首先训练一个encoder,将视频从时间和空间2个维度上压缩到低维隐空间里,接着从隐空间里提取出一系列时空patches进行单次训练没有明确提到Unreal engine等game engine,但是不排除隐空间里用到了NeRf或者Gaussian splatting等3D表征用来更高效地表达物体、环境、镜头之间的关系。目前推测效果好的2个原因至少是大量标注好的图片数据+scaling law过去的pika们通常会把视频尺寸调小,例如 256x256 分辨率的 4 秒视频,这样训练更快。但sora用的都是原尺寸视频,比如1920x1080p 视频或者垂直 1080x1920p的60s视频。好处在于采样更灵活,构图更好。相信这很快也会成为视频生成的新范式如何体验? 现在官方正在进行对齐工作,只邀请了少量的视觉艺术家、设计师和电影制作人访问,进行安全测试。现在唯一有可能体验到sora的方式,就是去奥特曼的推下面留言,CEO在线当代理人,帮你生成视频。。。 |

|

|

奥特曼在线邀请写prompt生成视频 |

|

事先声明,本人并非ai从业者,只从用户角度谈谈我的感受。 先来看一下ai作画发展到什么程度了。 |

|

|

在这个软件里,有个词条叫ai作画。 现在已经能做到生成连续性的小故事了。 就以苦主回忆录为例。有足足96w次观看,6500小红心。(2月13号上传的作品。) |

|

|

|

|

|

|

|

|

上传者发出了这样的感叹。 现在ai已经发展到这种程度了吗? 一个普通人+一台4090显卡的电脑一天起码能筛选50张能用的图出来。 12天就能制造搜590页的超长本子。 如果是人工画,以朝凪大师为例。590页是他两年的产量。 同理,现在sora单次能生成60s的视频,只要多次生成,人工筛选组合。就能组合出24 30分钟的视频。相当于未来动漫里番,科幻大片,都有可能逐步被ai制造替代。 比如说跳舞写的小说,足足几百万字,可能以后只需要一张显卡,几个人,就能完成动漫化。 像上面的这个苦主回忆录,3天达到现在这个成绩,如果给它几个月,可能会是10万心的名作。 哪怕是很多大手子,10万心的名作也是不多的。 也就是说,目前的ai作画已经发展到了,可以匹敌头部作者质量的程度了。 可以预见的是,未来视频生成也会从60s变成120s 240s,甚至是十几分钟。这种情况下,只要人工筛选筛选,ai就能带来海量的优质作品。 一年一万部科幻大片也不是不可能。 |

|

2月16日凌晨,OpenAI重磅消息,发布了首个文生视频模型 Sora。 据介绍,Sora 可以直接输出长达60秒的视频,并且包含高度细致的背景、复杂的多角度镜头,以及富有情感的多个角色。 比如下面的例子: 在东京街头,一位时髦的女士穿梭在充满温暖霓虹灯光和动感城市标志的街道上。 |

|

|

|

|

在 Sora 生成的视频里,一位女士身穿黑色皮衣、红色裙子在霓虹街头行走,不仅视频连贯稳定,还有多镜头。从大街的景色,慢慢切入到女士的面部特写,潮湿的街道地面反射霓虹灯的光影效果。 目前在OpenAI官网上已经更新了48个视频,在这些demo中,Sora不但能够准确呈现文字描述的细节,而且能够根据理解,生成具有丰富情感的角色。Sora 还可以根据prompt填补现有视频中的缺失帧来生成视频。 根据 OpenAI 的介绍,Sora 是一个扩散模型,反向去噪过程中,从类似于随机噪声的视频开始,通过多个步骤逐渐去噪,视频也从最初的随机像素转化为清晰的图像场景。Sora 使用了Transformer架构。 在数据处理方面,OpenAI 将视频和图像表示统一为patch,类似于GPT中的token。 通过这种统一的输入,可以在比以前更广泛的cv数据上训练模型。 接下来,对那些动画师、视频制作者将会有很大的冲击,素材网站也将变得无关紧要,任何人都可以生成难以置信的短视频。现在是网上充斥着大量AI写作,未来就是大量AI短视频。 |

|

真的太强了。文生视频一直是 AI 落地比较酷炫的一个应用场景,但在 OpenAI 的 SORA 之前,感觉都还有明显的短板。 例如之前爆火的 pika,虽然效果也很不错,但是只有 3 秒钟。3 秒钟的视频用处是比较受限的,要拼接成长视频还需要创作者花很多的功夫,而且多个短视频的一致性其实并不是那么好保证。这次 OpenAI 直接把时长拉到了 60 秒,已经可以 cover 非常多商业视频的时长范围了,这么长的时长让使用者的角色直接从拼接者变成了剪辑者。就像 OpenAI 自己发的一些例子,在整段视频中还会有出现错乱的情况,但毕竟长度在那,可以进行剪辑,这就有了更大得多的创作自由度。 第二是效果实在是太牛逼了。最惊艳我的两个片段是火车外景和东京街头漫步。火车窗外那个视频当竟然有一段是火车进隧道的场景,随着火车进入隧道,画面逐渐全暗,然后车窗的光学特性从透射快速变为反光,从窗外景色开始过渡到车内的景象。这个过程对人类来说非常自然,但我还是第一次看到有 AI 生成的视频刻画出这个细腻的变化。东京街头漫步那个视频,地面的积水倒影的光影异彩纷呈,非常逼真,让我感觉乱入了英伟达光追的宣传片。 还有一些对世界模型的分析网上已经写了很多了,总结起来就两个字,牛逼。 从 22 年的文字,到 23 年的图片,再到 24 年的视频,(其实音频生成也已经很厉害了),AI 真的已经进化了太多。感觉多年前看上去不切实际的元宇宙很快就要迎来落地了。 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |