| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> 如何看待openai最新发布的sora? -> 正文阅读 |

|

|

[科技知识]如何看待openai最新发布的sora? |

| [收藏本文] 【下载本文】 |

|

|

OpenAI Sora 的新文本到视频模型可以生成与真实视频没有区别的视频,这种新技术普及后会带来什么影响? [视频] |

|

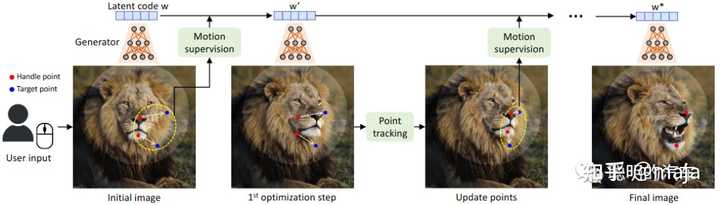

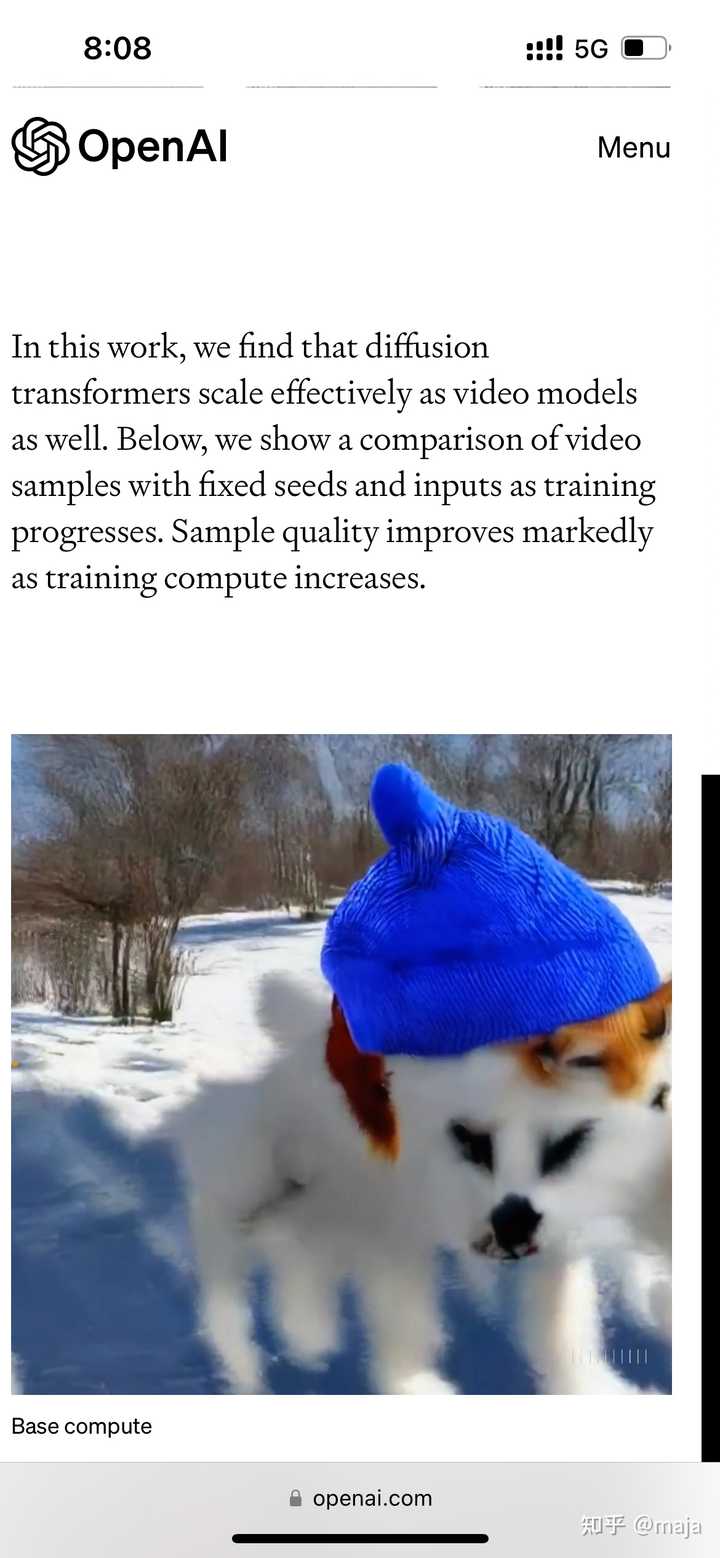

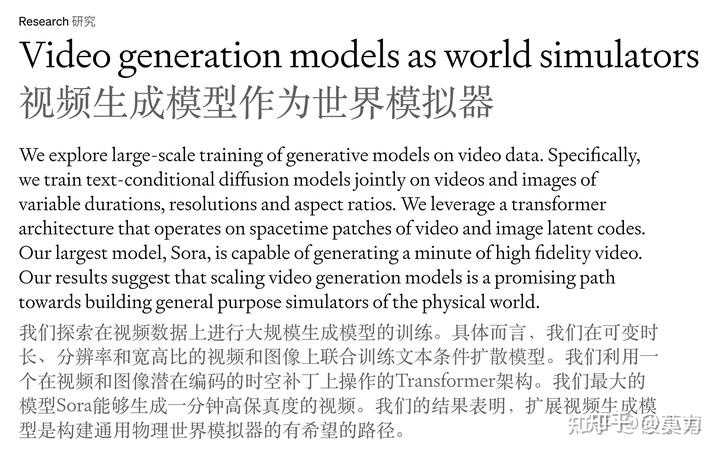

Sora多么牛逼多么真实之类的就不多谈了,只用一句话就能概括:随便拿视频中的一帧出来,效果都不亚于Dalle-3精心生成一张图片,而且这些图片放在一起可以构成基本符合真实世界物理逻辑的视频。而且Sora本身其实也可以做图片生成,只是大材小用了。 这篇文章着重分析一下Sora背后的技术,希望能给大家带来启示。 OpenAI的宏大愿景 Sora不止步于视频生成工具,它的背后是OpenAI的宏大愿景:开发出能够让计算机理解我们世界的算法和技术,而OpenAI认为最有可能的技术之一是生成模型 (generative model)。OpenAI的blog中对Sora的定位正是“作为世界模拟器的视频生成模型”。这里是OpenAI 2016 (!) 年的一篇文章的原话 (https://openai.com/research/generative-models): 我们常常会忽略自己对世界的深刻理解:比如,你知道这个世界由三维空间构成,里面的物体能够移动、相撞、互动;人们可以行走、交谈、思考;动物能够觅食、飞翔、奔跑或吠叫;显示屏上能展示用语言编码的信息,比如天气状况、篮球比赛的胜者,或者1970年发生的事件。 这样庞大的信息量就摆在那里,而且很大程度上容易获得——不论是在由原子构成的物理世界,还是由数字构成的虚拟世界。挑战在于,我们需要开发出能够分析并理解这些海量数据的模型和算法。 生成模型是朝向这个目标迈进的最有希望的方法之一。要训练一个生成模型,我们首先会在某个领域收集大量的数据(想象一下,数以百万计的图片、文本或声音等),然后训练这个模型去创造类似的数据。这个方法的灵感来自于理查德·费曼的一句名言: “我所无法创造的,我也不能理解。”(即:要真正理解一个事物,你需要去创造它) 这个方法的妙处在于,我们使用的神经网络作为生成模型,其参数的数量远远少于训练它们的数据量,这迫使模型必须发现并有效地吸收数据的精髓,以便能够创造出新的数据。 当年最先进的生成模型止步于DCGAN,2016年文章中的附图展示了当时的最先进效果: |

|

|

而8年后的今天: |

|

|

0 这确实让人不得不相信AGI也许在21世纪确实可以实现。而对于OpenAI,实现AGI的一个途径便是开发出能够让计算机理解我们世界的算法和技术(生成模型),Sora是非常重要的一步,即作为世界模拟器的视频生成模型。 对Sora的分析 如果限制必须用一个词来展现OpenAI的最核心的技术,我觉得便是 scaling law - 即怎么样保证模型越大,数据越多,效果就越好。Sora也不例外。一句话概括Sora的贡献,便是:在足量的数据,优质的标注,灵活的编码下,scaling law 在 transformer + diffusion model 的架构上继续成立。在Sora的技术报告中(https://openai.com/research/video-generation-models-as-world-simulators)可以看出,OpenAI实现scaling law的想法其实很大程度上沿袭了大语言模型的经验。 足量的数据 训练Sora用了多少数据?不出意外,OpenAI在整个技术分析中一点都没有提数据的事情,这可太CloseAI了。但是鉴于内容的丰富性(比如甚至可以生成相当连贯一致的Minecraft游戏视频),我猜测很可能是大量的youtube视频,同时也不排除有合成数据(比如3D渲染等)。未来可能用整个youtube上的视频来训练视频生成模型,就和大家用Common Crawl训练大语言模型一样。 灵活的编码(visual patches) 在大语言模型的构建中,一个非常重要的部分便是它的tokenizer。tokenizer使得任何长度和内容的文本都能编码成语言模型可以直接处理(输入/输出)的对象,即embeddings。embeddings在Sora中的对应物称为 visual patches,tokenizer对应的是 video compression network,应该是某种 convolutional VAEs (文章没有说明是不是VQ-VAE)。 |

|

|

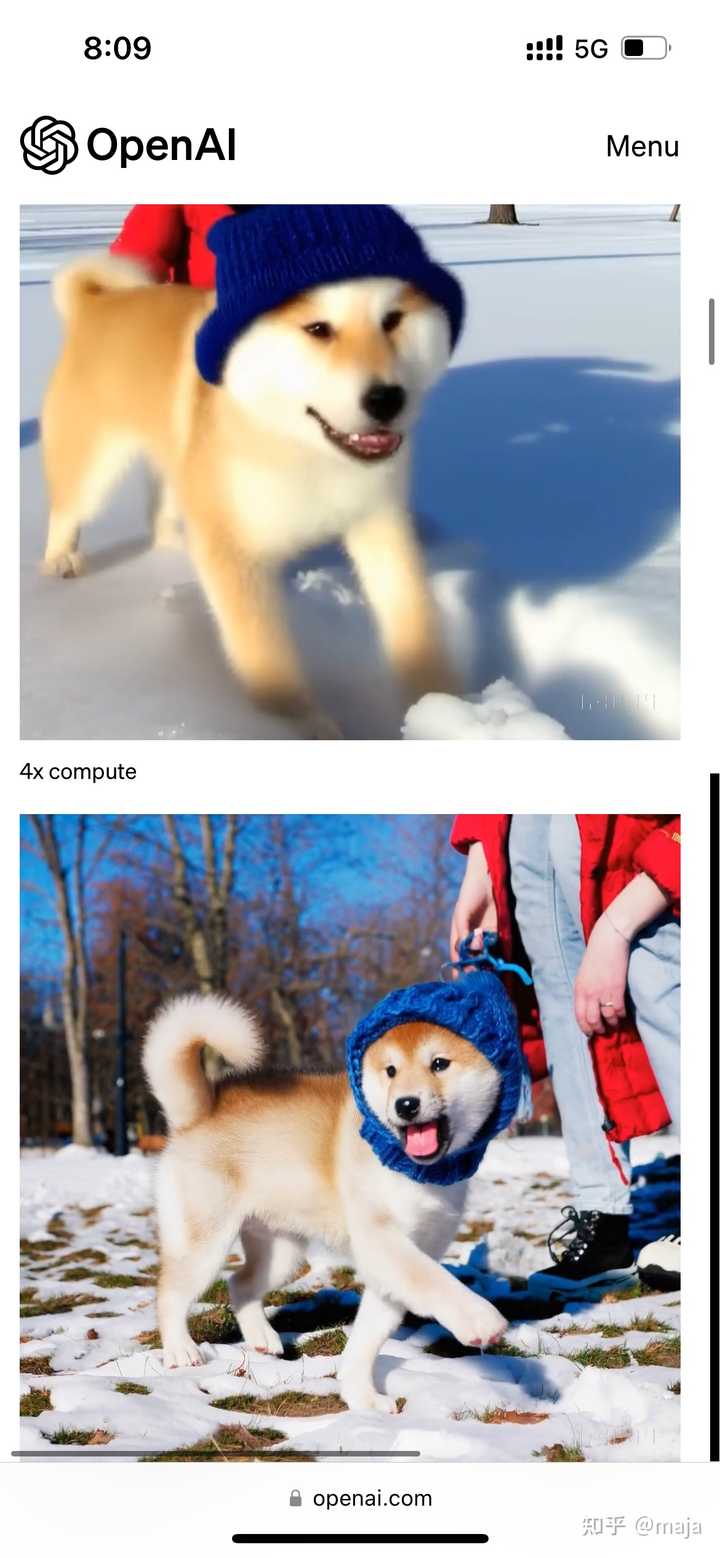

具体做法是用 video compression network (visual encoder) 首先将输入视频的时间和空间维度同时进行压缩,编码成一个和视频大小成正比的3D visual patch array,然后再将它按照某种顺序展开成1D array of patches,送入到transformer model中(具体方式应该是参考了https://arxiv.org/abs/2212.09748)。这样带来了不少好处: 灵活的分辨率。Sora可以生成1920x1080p(横屏) - 1080x1920p (竖屏)之间任何形状的视频。这也让OpenAI可以在早期使用低分辨率的视频来试错。生成的视频的边框更加合理。OpenAI试过使用固定分辨率,这样带来一个很显然的问题——需要裁剪视频。这种数据的bias会被带入到模型中,促使模型生成很多内容在框外的视频。优质的标注 和DALL·E 3一样,OpenAI用内部工具(很可能基于GPT4-v)给视频详尽的描述,提升了模型服从prompt的能力,以及视频的质量(还有视频中正确显示文本的能力)。我认为这是非常关键的一点,是OpenAI的杀手锏,对于视频尤其重要。原因很简单,可以从两个角度解释:(1)神经网络是个单射函数,拟合的是文本到视频的映射。视频的动态性非常高,也就是有很大的值域,为了把这个函数学好,需要定义域也很大很丰富,这就需要复杂的prompt了。(2)详细的文本也迫使神经网络学习文本到视频内容的映射,加强对于prompt的理解和服从。 另外一个细节:这种详尽的描述会导致在使用时的bias——用户的描述都相对较短。和DALL·E 3一样,OpenAI用GPT来扩充用户的描述来改善这个问题,并提高使用体验和视频生成的多样性。 除了文本以外,Sora也支持图像或者视频作为prompt,支持SDEdit,并且可以向前或者向后生成视频,因此可以进行多样的视频的编辑和继续创作,比如生成一个首尾相连重复循环的视频: |

|

|

0 甚至可以连接两个截然不同的视频: |

|

|

0 Transformer + diffusion model 的架构 不算特别意外,OpenAI使用了transformer作为主要架构,结合diffusion model,幸好还不是端到端的autoregressive模型,否则太吓人了(不过这样一来,transformer在自然语言处理,图像视频生成,语音合成(最近amazon的工作BASE TTS: Lessons from building a billion-parameter Text-to-Speech model on 100K hours of data),科学计算(AlphaFold,GraphCast)等最困难的领域都孤独求败了。transformer架构在图像分类等领域还没有占领绝对优势很难说是不是因为任务太简单了或者数据太少了)。我觉得使用diffusion model的主要原因是diffusion model能够生成非常精细的细节,且可以玩出各种有趣的操作(比如SDEdit)。 架构上大概率参考了 Scalable Diffusion Models with Transformers,这是Sora技术分析中引用的文章,Sora部分透露出的细节和这篇文章比较吻合。Sora这次再次验证了Transformer架构能够胜任scaling law。 涌现现象 OpenAI每次提到scaling law时几乎都会伴随着emerging properties,这次也不例外,有以下几点(其实这里放的视频才是真正和目前视频生成区别开的,具体什么意思不用多说一看便知): 保证良好的 3D 空间性质(视角变换,物体遮挡等的合理性) |

|

|

0 2. 时间上物体的连贯性(不会因为遮挡或者时间流逝改变物体原有状态) |

|

|

0 3. 模拟现实物理的交互 |

|

|

0 |

|

|

0 4. 连数字世界都可以模拟(这个生成的Minecraft视频真的惊到我了,一开始我还以为是参考视频,没想到是生成的) |

|

|

0 然后让我们看看Sora之前的很多视频生成模型的水平(因为太糟甚至成了梗),高下立判 (声音和古怪内容警告): |

|

|

0 Sora的缺陷 一句话:还不足以完全模拟所有现实中的物理过程,比如流体动力学(不过如果这个可以看视频就准确模拟出来就太可怕了,都让人怀疑世界是虚拟的了): |

|

|

0 一个真正的物理世界模型,估计给它放一段卫星云图视频,它就能把下面几天的气候变化给模拟出来,实现用视频生成模型预测天气,看股市曲线变化预测股价 lol,这样来说,OpenAI要走的路还有很长啊。 |

|

各种对Sora的赞美之词溢于言表。但我对Sora的观点是中立偏保守 :) 毫无疑问Sora是AI的又一次类GPT时刻,人类有85%的信息来自于视觉,文本和语言都可能需要人脑补一些东西,但所见即所得是绝大多数人信仰的观念。但现在所有可见的都可以是被制造的了,有那么一瞬间,你甚至可以怀疑你抬头看到的宇宙星空,是不是某个无上意志创造给你看的 :) 但是,Sora并不那么纯粹,很明显Sora的发布带着浓重的商业色彩,是Sam Altman的7万亿剧本中间的一个小剧场,就差一句话“我,Altman,打钱”。 我不是说Altman有问题,如果AI真的是一个规模效应的东西,只要足够大(足够多的算力设施)就能涌现出奇迹,那么Altman是对的,即使他不那么纯粹。 但是,回到Sora,就不是一个纯粹技术发布了,它必然会掩盖一些东西,就像它发布的视频中,有意地发了几个存在破绽的视频,这是一种宣传的手法,蓄意的瑕不掩瑜但可掩瑕,我也会,是让你放下戒心打钱的 :) 个人观点:Sora很棒,但没那么好,还有些问题。 当然,这些问题都是我猜的 :) 至少我脸皮厚敢猜而不只捧不是 :) ——————————————————————————————— Sora的基本原理发出来了,这也藏不住。 |

|

|

Diffusion Transformer的机理有很多介绍了,还是很让人耳目一新。哇,我们都明白Token的向量化是NLP的关键,但是图像用Patch的方式向量化,然后也通过向量的各种距离计算,得到下一个时隙最大概率Patch向量,想一想还真是Reasonable的路径。 但是,Transformer是一个巨大的概率机,如果说NLP中蕴含的Knowledge是有概率分布的,毕竟大家说话总不能太绝对不是,但物理世界,微观层面确实有人说上帝丢骰子,在宏观层面物理是具有绝对性的,就像1+1不存在99.99999%是2这种概率分布。 概率不是物理,所以,Sora不是世界模型,没有逼近AGI,也没有理解到物理定律,只能说他学到了大多数物理定律的一个概率分布。 所以Sora的“understand and simulate the physical world”,不能说假,但不真实。 |

|

|

上图这个视频,存在非常明显的穿模效应,而看完所有的视频,你会发现都在有意地减少物理碰撞,包括那两艘船,运动,但相互之间各自安好。 Sora有基于当前状态的下一步物理预测,但是不能产生符合物理的衍生变化。 —————————————————————————————— 再不负责任的进一步猜测的话,Sora是先生成了图,像素化的图。 然后为每个像素点在RBG之外还标注了一个深度信息,然后预测每个像素点在Timestamp上的概率分布,即产生下一帧。 我做过自动驾驶,所以特别好奇其他有没有同学有类似的感觉,Sora所有大场景的生成,都有种激光雷达点云成像的感觉,上面那张图也是,像点云。 有个技术和Sora挺像,http://www.bimant.com/blog/3d-gaussian-splatting/,高斯泼溅。 抛开那些我搞不懂的细节化人脸不谈,Sora发布的大场景有特别多视角旋转和远近变化。 就像LOD点云 :) ———————————————————————— 很多人都应该有一个疑问,Sora有没有调用图形引擎? 应该是调用了。 它放出来的主Video,这个妹纸的周边,地上的水,有明显的镜面反射特征,阴影是可以用NN猜出来的,但是光的镜面反射,是一个物理特征,而前一节推导Sora是没有学到物理的。 |

|

|

所以镜像应该是调用了Ray Tracing,但是前一节又猜测Sora只有点云信息,没有Triangle,没有Texture,咋做光追? 盲猜一个,点云是可以用NN反推Triangle的,我记得国内就有一家startup公司做,叫生数科技,硅谷肯定也有。只是这样反推的Triangle非常粗糙,只能产生粗模,但没问题,粗模带上Object和Texture,就可以做出相对粗糙的镜反射了。Sora是可以吃图吃视频的,我猜测UE在Sora执行后调用了一波,然后sora把光场信息吃进去再做了二次加工? 所以我猜Sora调用了UE引擎 :) 其实图像引擎有非常多现成的素材可用,包括波浪、石材,也许不需要用Transformer生成。 ———————————————————————— Sora如前的猜测,如果是基于图做的点云,那么它就没有mesh triangle(精模)。 没有Mesh Triangle重要吗? 重要! 必须有Mesh Triangle,整个场景才是Human Control的,你才能控制其变化,主导二次优化,这才是利用AI加速原有的工作的路径。否则你只能反复地Prompt,祈祷Sora能输出一个符合意愿的Video,嗯,那你是AI的奴隶,而不是AI的主人。 而无论是游戏还是电影,如果没有Mesh Triangle,做不到Human Control,是无法进行替代的。 广告视频用Sora倒是可以 :) 时间长度也合适。但视频制作感觉不是广告的关键瓶颈啊。 想一想,可能还有个机会是交互型游戏(电影),让用户在每一个片段都有选择下一段剧情的选项,然后二次生成后续的剧本 :) 但这些,商业闭环吗? 如果能闭环,还需要再加七万亿吗? 如果再要七万亿,那是否已经说明当前还不足以闭环? |

|

我们能从视频中学到高质量的世界模型吗?我们能光看视频就学会游泳吗? https://www.zhihu.com/zvideo/1742667808507457536 |

|

满屏写着先进生产力的发展方向 以下是案例纯享 |

|

|

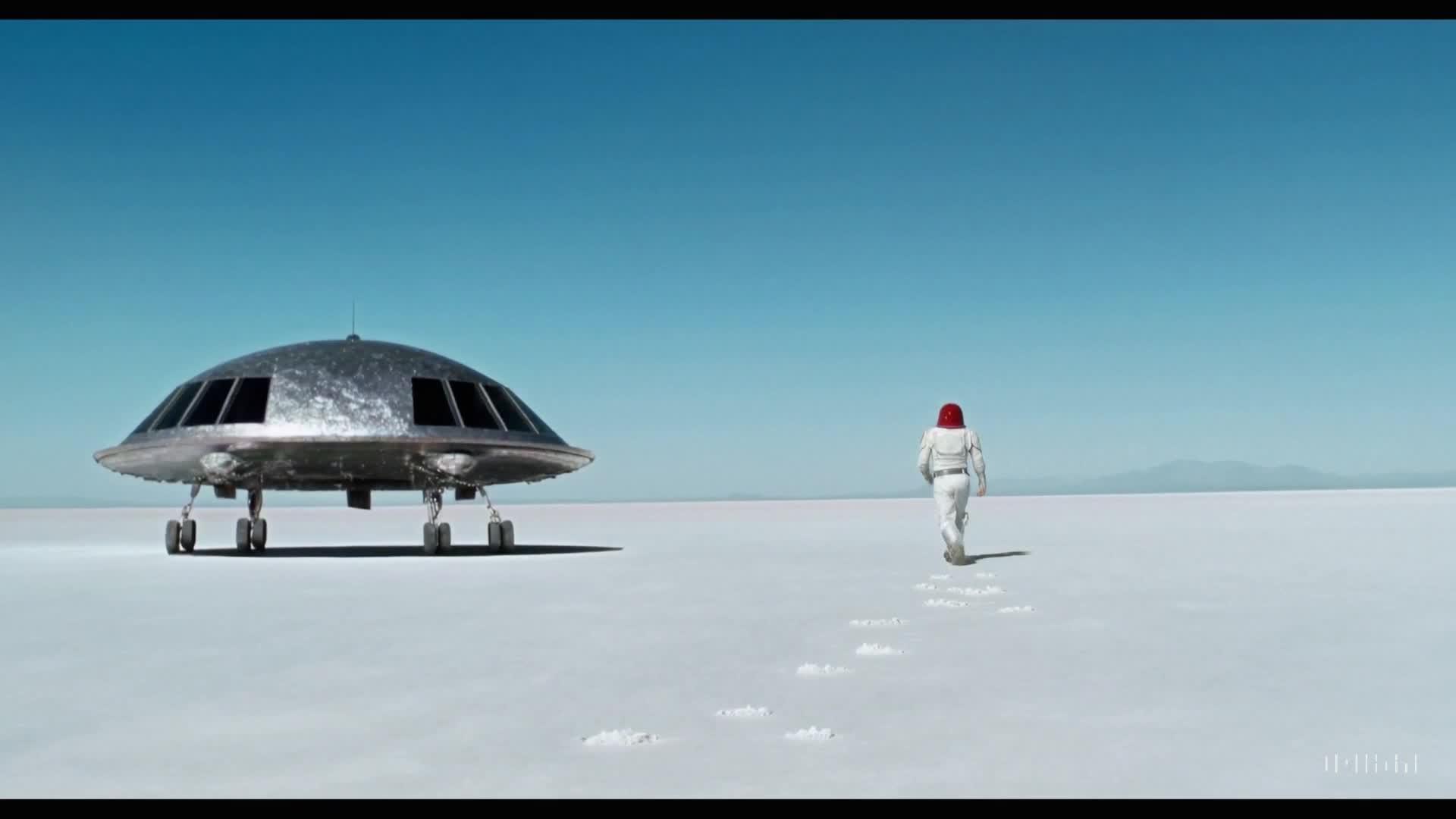

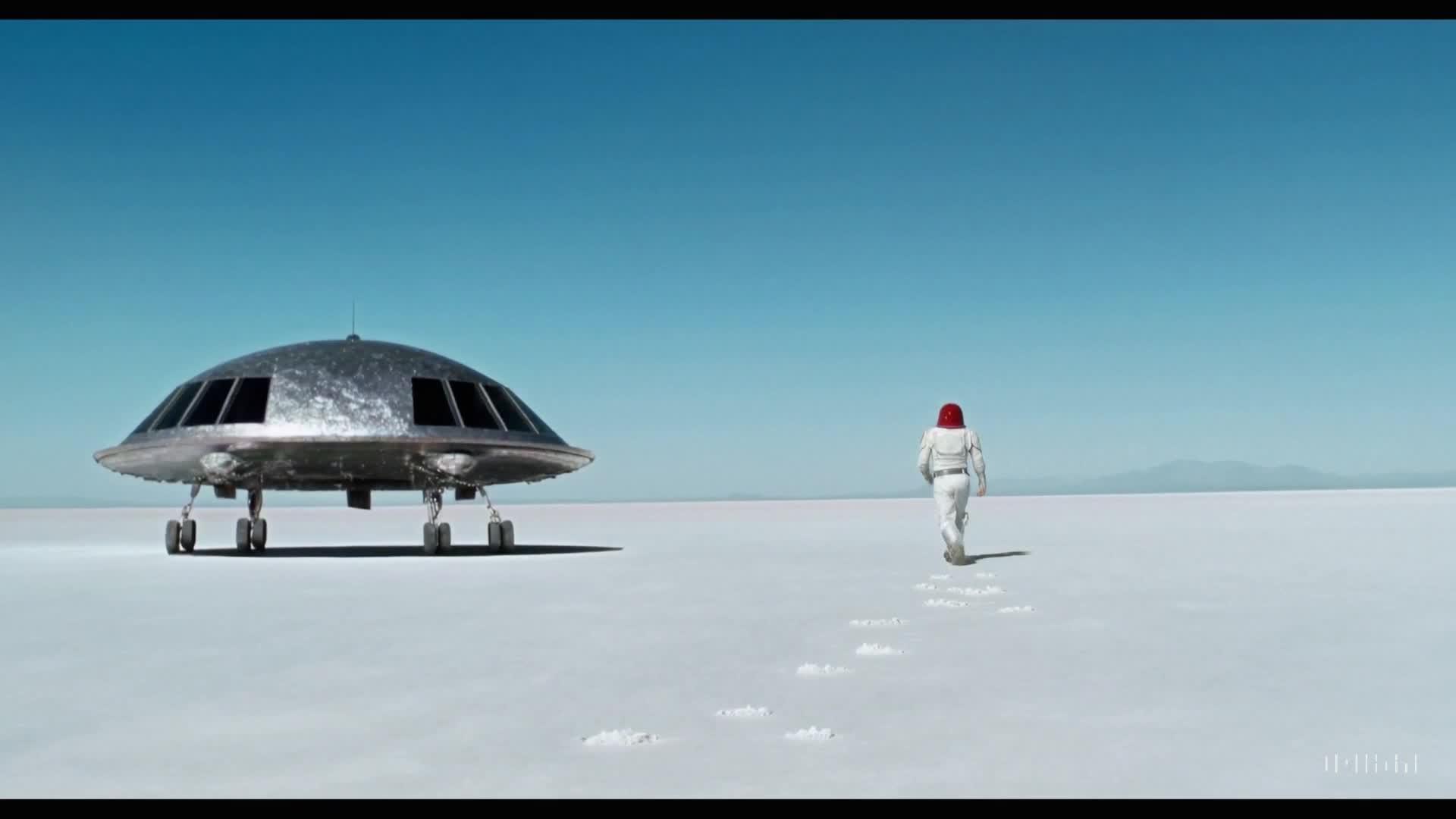

0 Prompt: A movie trailer featuring the adventures of the 30 year old space man wearing a red wool knitted motorcycle helmet, blue sky, salt desert, cinematic style, shot on 35mm film, vivid colors. |

|

|

0 Prompt: Extreme close up of a 24 year old woman’s eye blinking, standing in Marrakech during magic hour, cinematic film shot in 70mm, depth of field, vivid colors, cinematic |

|

|

0 Prompt: Several giant wooly mammoths approach treading through a snowy meadow, their long wooly fur lightly blows in the wind as they walk, snow covered trees and dramatic snow capped mountains in the distance, mid afternoon light with wispy clouds and a sun high in the distance creates a warm glow, the low camera view is stunning capturing the large furry mammal with beautiful photography, depth of field. |

|

|

0 Prompt: Drone view of waves crashing against the rugged cliffs along Big Sur’s garay point beach. The crashing blue waters create white-tipped waves, while the golden light of the setting sun illuminates the rocky shore. A small island with a lighthouse sits in the distance, and green shrubbery covers the cliff’s edge. The steep drop from the road down to the beach is a dramatic feat, with the cliff’s edges jutting out over the sea. This is a view that captures the raw beauty of the coast and the rugged landscape of the Pacific Coast Highway. 目前OpenAI展示的缺陷视频也很有意思,也许艺术就是一种对现实的错位再现 |

|

|

0 |

|

|

0 |

|

|

0 2019年的时候曾经写过“人类的极限之所以存在,便是用于总结前人经验的花费太大,在此基础上再谈进步,鲜有人能够做到,似无解决良策。” 还是naive了。 AI已经展示出能将人类社会这么多年的多模态信息进行压缩的潜力了,设想如果人类大部分知识可以变成一个等差数列,我们只需知道很少的基础信息(第一项,公差)和推导公式(prompt),借助AI就能很快找出所需的特定知识...... 这样的未来只在脑海中想想都令人兴奋,更不用说隐约已见到冰山一角了。 |

|

Sora技术报告包含要点如下: 1.参考语言模型的patches输入方式 2.视频压缩技术 3.重标注技术(训练一个高度描述性的字幕模型,然后使用它为我们的训练集中的所有视频生成文本字幕) 4.借助DALL·E 2 和DALL·E 3的图像生成技术 5.涌现出来的模拟能力(能够模拟物理世界中的人、动物和环境) 跟OpenAI以前的发布的技术报告一样,依旧没有公开重要的大规模训练技术、各类网络设计细节(比如视频压缩模型网络设计细节)。 章鱼小丸子:Sora技术报告-完整中文版翻译 |

|

一觉起来,被OpenAI 的 Sora刷屏了。看了官网的演示视频,效果太令人震惊了,它值得被刷屏! sora的突破 官网的那些演示视频,值得反复琢磨。演示视频中最令人印象深刻的有几点: 视频的长度:演示视频最长1分钟,从此视频生成领域,告别秒时代,跑步进入分钟时代。 |

|

|

0 视频的尺寸:视频的尺寸非常多样,宽屏的竖屏应有尽有。连续性和一直性:很多视频具有多个分镜,每个分镜里的细节依然得到了很好的保持。最神奇的是A movie trailer 这个短片,用“A movie trailer”这一个Prompt,生成的17秒视频里,塞下了整整10个分镜啊,还能继续保持画面一致性。太震惊了! |

|

|

0 以及视频的质量:生成的视频的分辨率高达1920?×?1080,不再是pika那种256x256分辨率,pika之类的直接原地去世意味着什么? 对普通人和创作者,有人甚至惊呼(也可能是自媒体的标题党): Sora一出,所有的视频人、电影人都下岗! 这个世界上,AI真的分两种,OpenAI 和其他AI。普通人想了解AI最新进展,完全不需要订阅其他AI,最省力策略就是:保持专注,紧跟OpenAI。 对从业者: 如果在创业做的项目跟openai有可能重叠,尽早避让,打不过完全打不过。。 视频生成甚至只是下面这个列表里面排名不那么靠前的一个常见请求!! |

|

|

山姆奥特曼去年年底在推上收集的用户期望,回避!!! 早上一个朋友在群里感叹: 很多老算法科学家几十年的经验积累,在大力出奇迹的算力加数据的暴力美学面前,都成了暂时的投机取巧。昨日还是红花一样鲜艳的明星,被技术的洪流淹没窒息而死时候,连点预兆都没有。sora的实现 快速看了下Tenical Report,sora背后技术的一些点: sora定义了视频训练和推理的基本单元是Patches,就像语言模型用的tokens能统一自然语言/代码和数学一样,sora训练过程用的 patches 也统一了视频和图片,图片就=单帧的视频。从此图片和视频被统一了,以前OpenAI Dalle-3海量的图片数据都可以被用来训练基本思路框架还是transformer+diffusion:首先训练一个encoder,将视频从时间和空间2个维度上压缩到低维隐空间里,接着从隐空间里提取出一系列时空patches进行单次训练没有明确提到Unreal engine等game engine,但是不排除隐空间里用到了NeRf或者Gaussian splatting等3D表征用来更高效地表达物体、环境、镜头之间的关系。目前推测效果好的2个原因至少是大量标注好的图片数据+scaling law过去的pika们通常会把视频尺寸调小,例如 256x256 分辨率的 4 秒视频,这样训练更快。但sora用的都是原尺寸视频,比如1920x1080p 视频或者垂直 1080x1920p的60s视频。好处在于采样更灵活,构图更好。相信这很快也会成为视频生成的新范式如何体验? 现在官方正在进行对齐工作,只邀请了少量的视觉艺术家、设计师和电影制作人访问,进行安全测试。现在唯一有可能体验到sora的方式,就是去奥特曼的推下面留言,CEO在线当代理人,帮你生成视频。。。 |

|

|

奥特曼在线邀请写prompt生成视频 |

|

读了sora的technical report Video generation models as world simulators 几个有趣的地方: Sora is also capable of extending videos, either forward or backward in time. Below are four videos that were all extended backward in time starting from a segment of a generated video. As a result, each of the four videos starts different from the others, yet all four videos lead to the same ending. 1)模型可以向前和向后生成,这么看来sora的tranformer架构依然采用的是和SD一样的双向non-autoregressive的。不知道为什么不上ar模式,明显ar模型的scale能力更强,这点在llm领域已经明显验证过了。 Sora currently exhibits numerous limitations as a simulator. For example, it does not accurately model the physics of many basic interactions, like glass shattering. Other interactions, like eating food, do not always yield correct changes in object state. We enumerate other common failure modes of the model—such as incoherencies that develop in long duration samples or spontaneous appearances of objects—in ourlanding page. 2)模型没有开源但是如果1成立的话。我怀疑目前的failuer case(物理规律失效)很可能是上述双向transformer导致的问题。一个能看到过去的模型明显是一个learning shortcut。因为因果律,时序保护猜想才是我们这个现实世界(real world simulator)的基础物理定律。 3)再次下一个暴论,暴力上模型参数数据(人类文本数据量很大但是终归是有限的,真实世界的视频感知是无限的数据)可能真的是AGI的最终道路。 |

|

刚下飞机,赶紧看了下初始文章: |

|

|

但是我要说一个让大家意外的结论,其实这个结果并不意外! |

|

|

早在2023年4月 潘博 证明了,将图像patches训练得到的latent vector 进行插值,就会生成目标图片中注意力对象的不同位姿态,这说明latent space 是可以连续变化并进行训练的! |

|

|

|

|

|

|

|

|

但是那个时候大部分是SFT任务,且需要特定图片的360度环视拍照,制作成一个向量查询数据库。那么回到SD pre train,SD一直是一个适合非常小的团队运作的模型:一个普通的8G 手机串联就可以将SD模型加载进去。 由于生成式模型不需要图片解码加速,(这是区别于传统图像任务的关键环节),非常有利于用计算卡进行大规模pretrain , 强化latent space的数值表征。 那么按照open AI scaling rule 就必然会想办法去迁移NLP的经验,研究在更大的数据集下有没有足够的外推能力。 |

|

|

|

|

|

基本上我们从报告中,可以看到 open AI 进一步加强latent space vector的训练,将视频图像大规模,按时序塞入到模型训练样本里,学习latent space 在正常相机模型下的隐函数函数。 |

|

|

不过文生图在更精巧的投影几个度量下,有非常大,但人眼无法分辨的误差。在Twitter上,人们已经开始讨论这个问题,如果你学过绘画和透视原理,会发现生成的图片几乎每张都有问题。 这可能是未来可以去解决一个问题方向:完全没有相机参数,只需要文子就可以勾勒出比较精细的画面。 |

|

2月16日凌晨,OpenAI 推出了一项惊艳的人工智能技术Sora。该技术可以根据用户的文字描述,生成逼真的视频,为创意产业和视频制作领域带来了无限可能。从演示效果看,Sora 的表现非常出色。 Sora 凭借其卓越的能力,只需根据用户的文字描述,即可快速生成长达 60 秒的视频。这些视频中,场景细腻精致、角色表情栩栩如生,镜头运动也极为复杂。这无疑使视频制作变得更为高效、便捷,不禁让人们对文生视频的未来充满了期待。 目前Sora还没有开放使用。AIGC最本质的问题:算力资源一直没有有效解决。在GPT4.0文字生成都存在使用频率限制的情况下,将高质量文生视频的能力赋予千万级别以上的用户,这一目标在当前算力资源有限的情况下显得遥不可及。目前,我们的计算能力还无法满足大规模生成高质量视频的需求,因此,实现这一愿景需要我们进一步突破技术瓶颈,提升算力水平。 商业宣传是有目的性的,大胆猜测,openAI通过Sora的发布,目的是为了说服资本投钱。归根结底,技术上的进步,已经树立了信心,剩下的就是钱的事情了。 我对文生视频充满了浓厚的兴趣,坚信在未来的算力资源得到有效解决后,每个人都能释放出自己的想象力,创造出独特的视频画面。这一愿景预示着AI技术将惠及千家万户,这是一个非常美好的未来憧憬。 当然,也有人借此吹嘘文生视频在未来会颠覆电影产业、视频产业等等,其实没必要杞人忧天,但凡对电影产业稍微有点常识,都没必要焦虑。电影产业本质上是创意主导的产业。AIGC高级人工智能,从用户体验上来说,总结为:一流的逻辑,二流的内容,三流的文采。你问他问题,回答更加简明流畅,概括性极强,然后它能够抓住问题的要点。如果你就某个细节追问的话,它也能对答如流,所以它的上下文理解能力,已经和自然人是不相上下,但是在创意型问题上,其内容表达以及想象力空间,是不尽如人意的。 本质上分析,我们回归三个世界理论。第一个世界是我们接触到的物理世界,五官能够感知的。第二世界,人的心理世界,这个心理世界包括思想、意识、情感、主观体验,第二世界是一定和人的主体性是不能分离的。第三世界,第三世界是一个抽象的世界,这个抽象的世界,各种符号系统,就是今天世界上已经存在的各种知识、语言、逻辑,这个知识是独立于人的,它具有另外一种知识的客观性,全世界所有人能理解。AI所拥有的知识是第三世界的知识,它对第三世界的理解掌握,现在已经远远超过人类了。但是它对第一世界的直观感受和第二世界的心理活动。 所以AI再怎么强,它只有理性,它就是一个超级大学霸,但是它缺乏我们人类所具有的直觉、悟性、想象力。 |

|

原文发表在:距离虚拟世界的一步之遥 先说结论:人类距离虚拟世界,只有一步之遥 2月16日,在距离ChatGPT发布后的一年多之后,openAI再次扔出重磅炸弹。 Sora的发布如同2023年GPT store发布端了一众创业公司的饭碗一样,相较同类竞品的水平,sora在视频内容连续性和高保真的效果上,都把它的前一代们秒成了渣渣。 |

|

|

12月的时候我试用runway,基于梵高的星空做了18s视频(下面的视频是用剪映放慢速度拉长到30s的效果),runway在4s基础上的提供增加4s的扩展,但是即使是高度抽象的动画,也能看到在8s之后图片的变形情况就比较严重了。 对于人物形象的图片转视频,runway的效果就更差一些,尤其是人物连续性上。可能训练的样本多是欧美外表,因此对于中国人的形象拟合的效果过差,在第2秒就出现了严重的人种变形。这里不放展示,如果有想要对比的,可以注册之后自己放照片试试。 从openAI的官网上,能够看到Sora生成的视频在人物和场景的连续性上基本看不到明显的变形,流畅度和逼真度几乎可以做到以假乱真的地步。 更重要的是,在很多展示出来的视频上,能够看到物理规律在视频中的呈现,也就是说,生成的图片不仅仅是连续图片的快速拼接,而是真实的模拟出来了文字所想表达的场景细节,这个突破不亚于ChatGPT之于其前一代的AI对话能力。 按照openAI之前发布的风格,在效果方面openAI基本上吹水的概率不高,大概率实际成品和宣传的效果差距不会很大。 没想到还没有等到GPT-5,就先等到了Sora。 接下来说说,Sora的发布到底意味着什么。 |

|

|

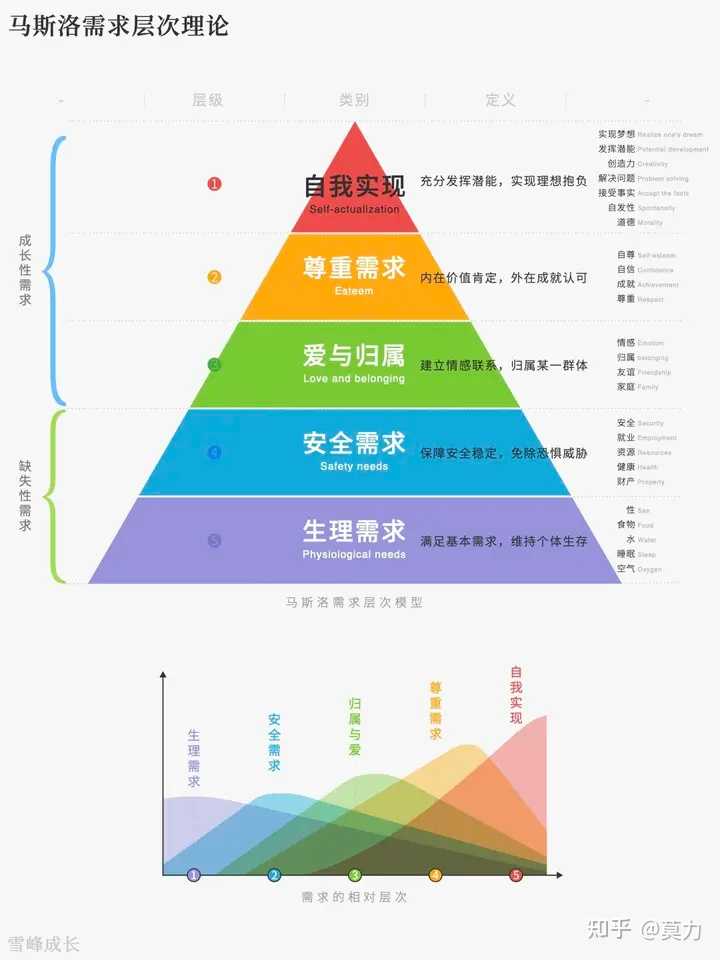

1、虚拟世界的建设成为可能。随着vision pro的发布,未来构建虚拟世界的智能设备和智能应用技术基础已经具备。如果将vision pro类比为手机,那么sora和openAI就是支持人类在虚拟世界构建更加真实的生存环境的软件技术基础。 2、更丰富、更廉价的虚拟世界会在未来等着人类进入。相比于真实世界,虚拟世界的生活成本更低,为人类提供满足感的路径更短,人类在现实世界很难满足的愿望,未来可能会在虚拟世界被满足。这种直接刺激多巴胺的虚拟世界,可能会直接争夺人类停留在现实世界中的时间。 3、虚拟世界的开拓将带动新一代生产力和工业革命。现实世界的开拓已经接近饱和,肉眼可见的经济衰退和失业潮,当前现实世界面临的是先进的生产力和日渐减少的需求之间的矛盾,社会中的工作机会进一步减少,曾经奏效的消费主义洗脑也在逐渐被免疫,大家不花钱,但是也不挣钱,全社会都在瓜分这个日渐缩小的蛋糕,社会变成了一个零和的老鼠游戏。相比现实世界的衰落,虚拟世界还是刚刚发现的新大陆,还有大量的机会和建设需求,通过虚拟世界,吸纳现实世界的剩余劳动力,用虚拟解决现实世界的温饱问题,可能能够解决当前紧迫的经济问题(但是是否会带来新的问题,还未可知)。 4、所有的职业和公司架构会被重新洗牌。大浪袭来一定有幸存者,但是不要幻想自己会是那个幸运儿,永远做好职业被颠覆的准备。下一个被替代的是不是编剧和导演,不得而知,我们都在被替代的路上,只是时间问题。长期来看,所有基础工作最终被AI替代,应该是一种必然。只是路径会是什么,不知道。是agent?还是更强大的AI?当公司里都是AI员工的时候,旧有的公司制度也会一并消失在历史的长河里。 5、那么AI时代什么工作可能还会存在,我猜测,可能是那些决定做什么工作的那些工作。至于什么人什么职业,能够决定做什么工作,那就是那些能够知道,做什么能够赚到钱并且赚到钱的人。比如,把控和拥有资源和关系的,提供满足人类生存必要物资的,提供满足人类精神需求的。而人类,回归到本质,就是衣食住行的需求,当然随着经济的进一步衰退,对于品牌、材质、口味的需求,可以被牺牲,但是也能够通过营销和品牌宣传进行收割。因此,这些基于原本基础需求,添加品牌和营销的附加值,可能是仅剩的一些赚钱机会。 6、在基础能力层,能够和openAI对标的公司会越来越少。英伟达可能会崛起成为能够制约openAI的唯一对手。所谓pika这类工具型的创业公司会像昙花一现一样涌现-替代-消失。创业公司不要幻想在没有家底的情况下,和openAI在工具层进行pk。留给创业者的机会在openAI顾及不到的垂直领域,而不是在基础层和工具层。所有没有雄厚资本支持的大模型和工具类创业公司,仅仅是给openAI的战略提供了方向,投石问路,他们用自己的真金白银给openAI找到了发展路径,自己却只能一无所获成为openAI前进的绊脚石。 7、技术的发展必然遵循指数发展定律。AI席卷狂潮只会比预期来的更快,大部分人还活在旧时代的节奏里,新技术的发展速度会让所有人跌破眼镜。2023年openAI和创业公司已经用实际行为宣告了AI时代的到来,第四次工业革命不是在即,而是正在发生。你,我,都是这个新时代的亲历者,象征旧世界的泰坦尼克已经在沉没了,我们坐在甲板上看风景,只是不知道船底已经陷落。 8、创意不重要,AI比人类更擅长想象。能力不重要,AI比人类更擅长学习。体力不重要,AI结合机器人只是时间问题,人类需要吃饭休息心理按摩,而机器只需要充电。只是AI还不是世界规则的制定者,所以AI无法替代的,是对于世界规则、人类规则、社会规则的制定权利。对的,是权力,而不是能力。试着做个类比,远古时代,人类和动物一样需要捕猎觅食;现代生活,大家有了其他获取食物烹饪食物的方式,在新的生产力环境下,你会让你家的猫猫狗狗替你做饭吗?不会,因为猫猫狗狗不会使用新时代的工具做饭。当未来人类和AI的差距大到超过了物种之间的差异,AI会让人类替他们工作吗?不会,因为人类已经无法操作更新时代的工具了。 9、我一直在思考的问题是,当人类失去作为生产工具的价值之后,人类的命运该要何去何从。但是想想,在工业革命之前,其实大部分人都不是当前的工作上班模式。有人务农、有人经商、有人教书提供知识技能、有人拉皮条做中介生意。回归到本质,以价值交换满足需求,在新时代,旧的模式被改变,一定还会有新的社会模式涌现。毕竟,人还得活着,总是有办法的。而人类作为生产工具提供价值,由资本进行按劳支付的时代,可能会在不久之后成为历史。 10、变化是永恒不变的,不变的是人性。如果说人类真的活在虚拟世界,那马斯洛的需求理论大概就是编写在人类DNA里不变的密码。我们不得不,也别无选择的,活在被需求支配的肉身里。不论是否有命运,是否唯心,我们终只能等待命运和时代的大潮,看他们能把我们,吹到哪里去。 |

|

|

原文可见:距离虚拟世界的一步之遥 欢迎关注交流。 |

|

1. 引言 生成式人工智能彻底改变了我们创建数字内容和与数字内容交互的方式。生成式人工智能的一个难题是根据文本描述生成引人入胜的视频。 本文将探讨OpenAI在文本生成视频领域最新的工作SORA,以及该工作给相关领域的研究人员和开发人员所带来的机遇与挑战。 闲话少说,我们直接开始吧! 2. SORA是什么? 生成式人工智能(Generative AI)是一类机器学习模型,可以基于现有数据生成新的内容。这些模型从训练数据中学习相应的模式,然后使用这些模式来创建新的输出。文本到视频生成是生成式人工智能的一个特定领域,以文本描述作为输入,视频是所需的输出。 什么是SORA模型?从上面视频中我们知道它是一个文本到视频的模型,可以生成长达60秒的视频,同时保持视觉质量并遵循用户的输入文本提示。SORA可以用多个角色、不同的动作和准确的背景来创建详细的场景。该模型知道用户想要什么以及现实生活中的情况。虽然SORA并不是第一个通过文本提示生成视频的模型,但Runway ML的Gen-2、谷歌的Lumiere等相关技术为SORA的产生铺平了道路。 3. 技术亮点 通过前文,我们已经知道了SORA是文本生成视频的生成式模型,它的核心技术亮点归纳如下: Capabilities:SORA可以根据文本指令创造逼真和富有想象力的场景。SORA生成的所有视频都保持视觉质量并遵守用户输入的文本提示。Foresight and Consistency:SORA采用了一个扩散模型,该模型从类似静态噪声的视频开始。在多个步骤中,它通过逐渐去噪并进行变换。同时通过多帧一致性预测,OpenAI确保了视频主题风格的连续性,即使角色瞬间从视图中消失。Resolution:SORA可以生成分辨率高达1920x1080和1080x1920的视频。4. SORA中的扩散模型 由OpenAI开发的开创性文本到视频模型Sora采用了类似于Midtravel的扩散模型技术。让我们深入了解具体情况: Diffusion Model:扩散模型从类似于静态噪声的视频开始。在多个步骤中,该模型通过逐渐去除噪声来逐步细化生成的视频。这个迭代过程产生了充满想象力、内容连贯的场景,这些场景来自最初的噪声。Architecture:Sora构建在一个类似于GPT模型中使用的transformer架构。这种架构具有显著的可扩展性和效率,使Sora能够处理复杂的文本到视频任务。 Sora中的扩散模型将噪声转化为引人入胜的视觉视频,减小了文本和视频运动之间的差距。 5. SORA样例 我们接下来看几个OpenAI官网给出的示例吧,不得不感慨技术的飞速发展。 Prompt: A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about. 生成动画的效果也很赞,如下: Prompt: A cartoon kangaroo disco dances. SORA还可以在一个生成的视频中创建多个镜头,准确地保持角色和视觉风格,我们来看个例子: Prompt: Beautiful, snowy Tokyo city is bustling. The camera moves through the bustling city street, following several people enjoying the beautiful snowy weather and shopping at nearby stalls. Gorgeous sakura petals are flying through the wind along with snowflakes.6. 相关应用 SORA模型在未来可以应用的地方,大概可以总结为以下几点: Content Creation: 用于营销、讲故事和娱乐的自动化视频制作。为电影制作人和动画师提供快速原型制作。Education and Training: 基于文本描述的交互式教育视频,用于教育培训板块。Personalized Content: 为社交媒体、广告和个性化消息定制生成视频。7. 总结 尽管围绕这一突破令人兴奋,但很明显,OpenAI致力于负责任地开发和部署Sora。随着全世界热切期待生成视频技术的未来,OpenAI的Sora为可能的内容生成设立了一个新的标准,随着研究的继续,我们可以期待更真实和上下文感知的视频生成。 |

|

搞动画的今天都挺兴奋的,在看openai放出来的视频,谈看法。 先说一下适用场景。openai表示sora生成的东西不许是色情暴力、有IP等等的,这当然了,色情暴力不说了有的视频真的很恶心的那种。有IP的东西主要是版权问题,从粉丝角度来说生成视频如果被拿去整烂活我也觉得挺烦的。 其次,纯生成“原创”的东西是没有版权的,所以你生成的东西别人也是可以用的。当然也不侵权,所以单纯使用是安全的。这个可能是技术算法的原理决定的。 古生物爱好者的我很喜欢那个猛犸象的视频,另外就是那个蓝色的鸟也很可爱。 这东西不知道能不能加上虚拟现实搞全息游戏啥的,期待。 但如果是表演层面可能还是达不到,因为具体的表演细节还是差一些,高水平的动画制作者应该不用担心,水平比较低的也可以利用它。但对工作机会可能造成一些冲击,就看人类能不能更有创意,在它出现之后制造更多就业机会而不是只会裁员。看人类能不能干过AI的时代已经到了。 |

|

文本生成视频本身不重要,我一直觉得这玩意没什么用。 但是重要的是:生成视频代表程序(一大堆浮点数矩阵)对现实世界的理解,如果程序能完美的生成世界视频,基本上AGI就实现了,很可能各方面智力都超过了人类。 只能说期待GPT5吧。 |

|

|

OpenAI Sora 概述 OpenAI最新的创新,Sora,在人工智能领域开辟了新的天地。Sora是一个文本到视频的扩散模型,可以将文本描述转化为逼真的视频内容。它解决了一个重大的技术挑战,即在视频中保持主体的一致性,即使它们暂时移出画面。 Sora利用先进的技术将静态噪音转化为清晰连贯的一分钟视频。它能够提前预测多个帧,实现视频形式中的无缝过渡和稳定叙事。 技术信息: 类型:生成式人工智能主要功能:将文本转换为视频生成内容时长:最长60秒分辨率:力求高清(HD)质量真实感:致力于逼真和照片般的输出 |

|

|

Sora的独特之处之一在于其扩散过程。它从被认为是视觉混乱的开始,逐步将其精炼成结构化且可观看的视频。这种渐进式转变对于创造不仅富有创意而且保持原始文本输入线索的视频至关重要。 OpenAI,ChatGPT和Dall-E背后的大脑,不断推动AI在媒体制作中的成就。Sora代表着又一次飞跃,暗示着一个未来,强大的AI工具可能会普遍用于从简单的文本描述中创建引人入胜且复杂的视频内容。 |

|

|

技术见解与发展 OpenAI最近发布的Sora标志着AI视频生成技术的重大飞跃。本节深入探讨了Sora背后的核心技术进步和复杂的开发过程,突显了使其与众不同的精密机制和创新功能。 文本到视频生成机制 Sora利用文本到视频模型将文本提示转换为动态视频内容。这涉及到语言理解和视觉表现之间的复杂互动。通过利用扩散模型,Sora处理文本并生成具有准确细节和动态效果的视频,密切遵循给定的提示。 人工智能技术的进步 生成式人工智能是Sora的核心,反映了OpenAI对人工智能技术的深度投入。研究人员在创建模型方面取得了进展,这些模型不仅能够理解和预测静止图像,还能理解视频序列中的运动和物理现象,使人工智能系统更接近于通用人工智能(AGI)。 与创意工作流的整合 艺术家、设计师和电影制作人发现Sora是他们工具包中的一项尖端技术。通过提供一种快速生成复杂场景和多个角色的方式,它与创意工作流融合得很好。这有助于创意专业人士以前所未有的速度将他们的想法可视化并进行迭代。 Sora的独特功能和能力 Sora以其能够从具体的文本描述中描绘生动情感、多个镜头和因果关系而脱颖而出。它巧妙处理摄像机轨迹和空间细节,使得能够创建高度定制的视频内容成为可能。 伦理考虑和安全措施 OpenAI,在首席执行官Sam Altman的领导下,将安全和伦理放在首位。因此,Sora包括内置的保障措施,以解决版权、错误信息和伤害问题。模型的训练包括红队人员进行这些风险测试,确保负责任的使用。 未来前景和OpenAI的方向 OpenAI不断完善其技术。公众的反馈和随时间积累的见解对塑造Sora和其他OpenAI项目的未来至关重要。目标是朝着更复杂、更微妙的AI生成内容前进,同时关注伦理影响。 竞争技术和市场比较 Sora并不孤单;像谷歌的视频AI以及Meta和Runway等公司的工具也在探索这一领域。然而,Sora对处理精确描述的精细调校能力,以及它在各种专业创意流程中的整合,使其具有显著优势。 应用和案例研究 OpenAI的Sora的出现在各个领域产生了重大影响,展示了人工智能在从简单文本描述生成高质量视频方面的动态应用。 赋能视觉叙事 视觉叙事者,如电影制作人和视觉艺术家,现在能够快速有效地将他们生动的想象力呈现出来。Sora的文本到视频模型将描述性文本转换为视频序列,完整呈现出电影般的灯光和图像,从东京霓虹灯闪烁的街道到亚洲宁静的山脉,多种场景应有尽有。 协助创意专业人士 设计师和创意专业人士正在利用Sora轻松创建多个镜头和复杂场景。曾经花费数小时创作单个画面的艺术家现在可以将他们的愿景转化为动画序列,提高了生产力和创造力。 在各个领域的创新应用 从丰富媒体内容到将博客文章转化为引人入胜的视频叙事,Sora的应用广泛而多样。将技术报告转化为详细的视频讲解有助于阐明复杂的观点,使信息能够被更广泛的受众理解。 真实案例和演示 无论是一个祖母社交媒体影响者展示一个乡村风情的托斯卡纳厨房,还是一场关于如何制作自制马铃薯丸子的烹饪指导会话,Sora都为各种叙事提供了平台。这种人工智能技术的现实演示让人们能够一窥其在日常生活中的实际用途。 解决业界关注的主要问题 Sora不仅仅是关于生成视频;它还涉及负责任地进行生成。OpenAI意识到潜在的问题,如版权侵权和安全问题。采取步骤,如为偏见引入检测分类器并开发预防措施以防止误导性内容,是Sora在公众和政策制定者中使用的关键组成部分。 常见问题解答 OpenAI Sora视频生成器因其创新的文本提示生成视频的方法而引起了相当大的关注。以下是一些最紧迫的问题及其答案。 我如何获取OpenAI Sora视频生成器的访问权限? 目前,OpenAI Sora的访问权限仅向特定用户提供,并且可能需要申请或邀请流程。请密切关注OpenAI的官方通讯,以获取更广泛的可用性更新。 OpenAI Sora具有哪些视频生成功能? OpenAI Sora可以生成长达60秒的视频,将书文本提示转化为具有指定风格和内容的创意和逼真场景。 OpenAI Sora是否已经宣布发布日期? 截至目前,OpenAI尚未公布Sora的公开发布日期。官方公告将在工具准备好面向更广泛的受众时提供详细信息。 使用文本到视频AI技术创建视频的步骤是什么? 要使用Sora创建视频,您需要输入描述性文本,AI将使用这些信息生成符合给定说明的视频。随着工具的发展,具体的过程可能会有所不同。 我在哪里可以找到有关OpenAI Sora的文档或研究论文? 一旦工具正式发布或发表,有关Sora的文档和研究论文应该可以在OpenAI的网站或学术数据库中找到。 参考资料 [1] https://gadgetmates.com/openai-sora-video-generator |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |