| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> 如何评价OpenAi发布的视频生成模型Sora? -> 正文阅读 |

|

|

[科技知识]如何评价OpenAi发布的视频生成模型Sora? |

| [收藏本文] 【下载本文】 |

|

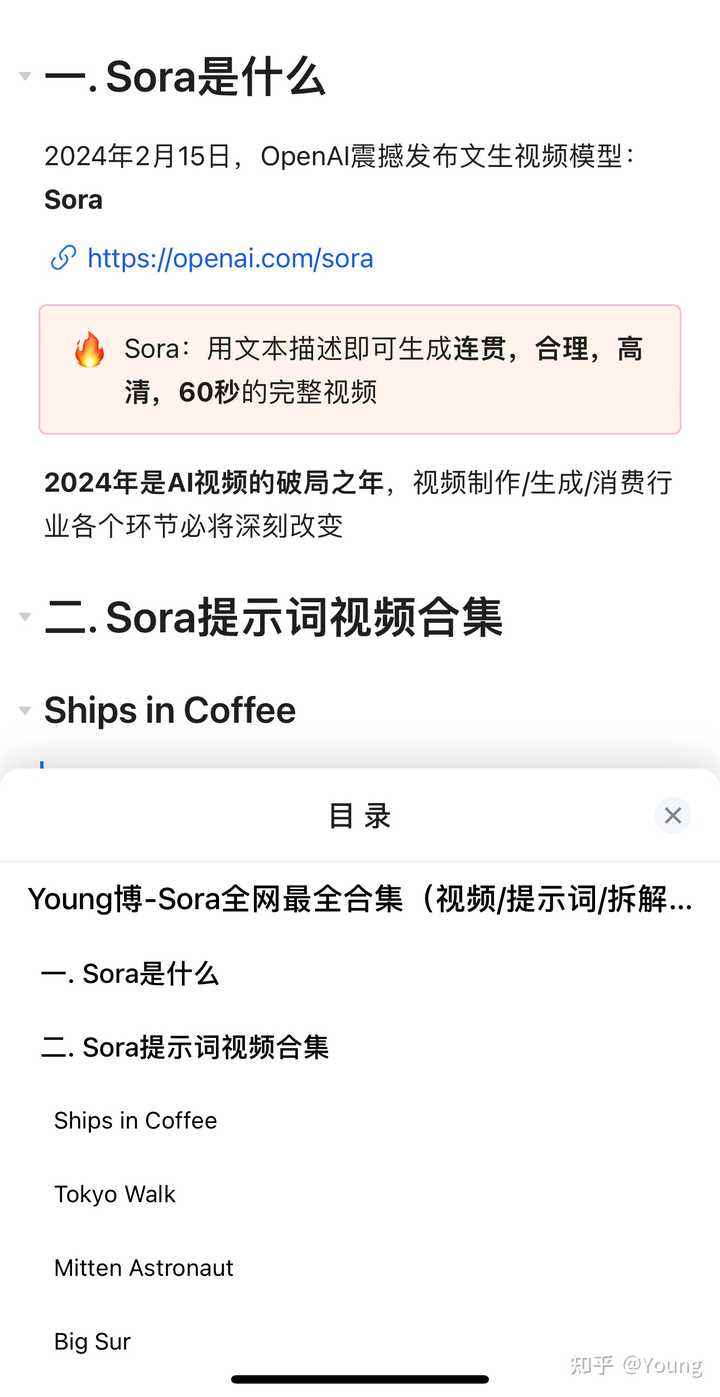

Text2Vid: Sora: Creating video from text |

|

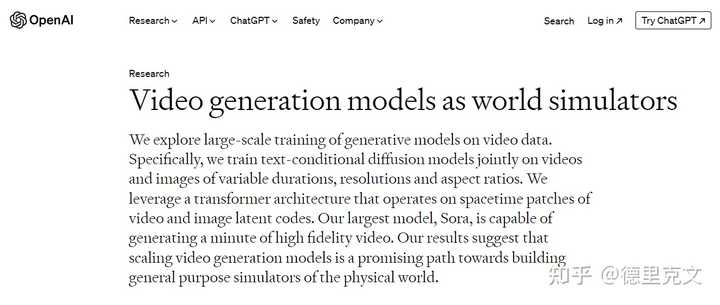

Sora的技术报告已经出来了:Video generation models as world simulators OpenAI没有发布GPT-5,反而进军了新的领域:文生视频。OpenAI新发布的文生视频模型Sora不仅像DALLE-3有很好的长文本理解能力,而且可以生成长达分钟级别的高质量视频,从官方示例上看,生成的视频效果确实惊艳。Sora可以生成宽屏 1920x1080 视频、垂直 1080x1920 视频以及介于两者之间的所有视频。 |

|

|

0 |

|

|

0 |

|

|

0 |

|

|

0 |

|

|

0 |

|

|

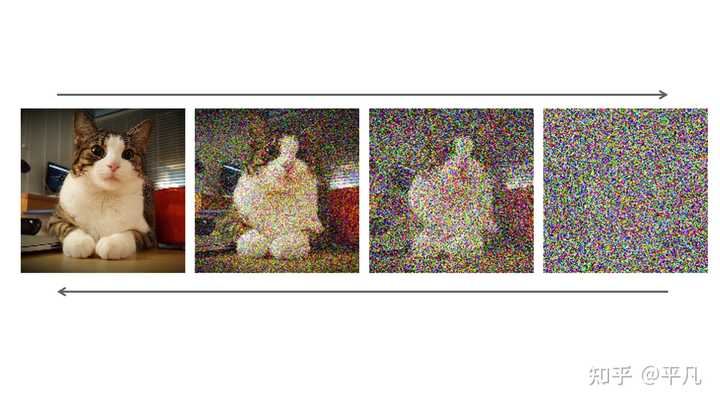

0 从技术上看,Sora和DALLE-3一样都是采用扩散模型架构,即从一个随机噪音开始逐步去噪生成一个视频,这个一个比较成熟的技术方案。不过最近谷歌的几个视频生成工作如VideoPoet是采用基于Transformer的自回归方案。在文生图领域,扩散模型是主导,那么在视频生成领域自回归会不会更胜一筹,这个还有待未来的验证。 |

|

|

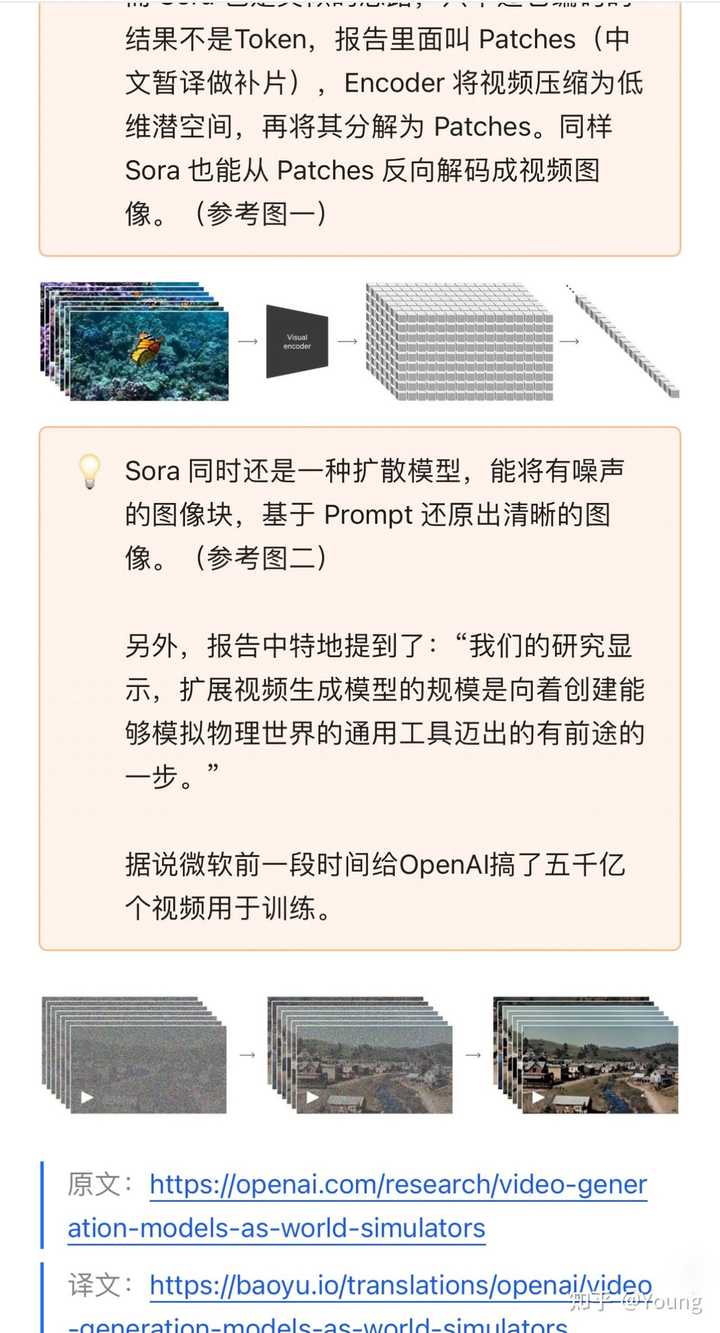

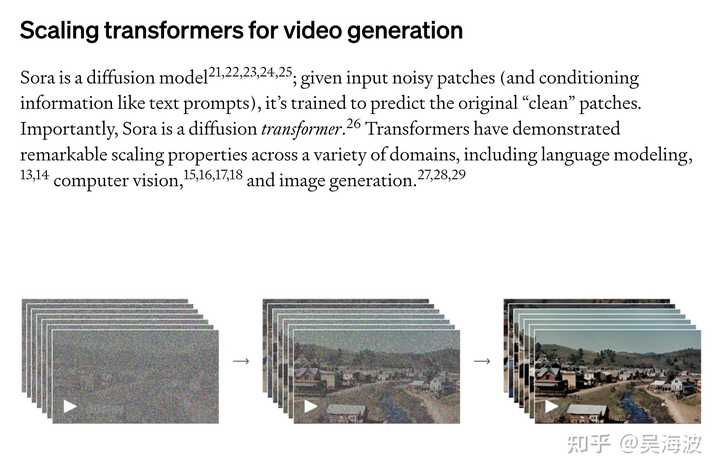

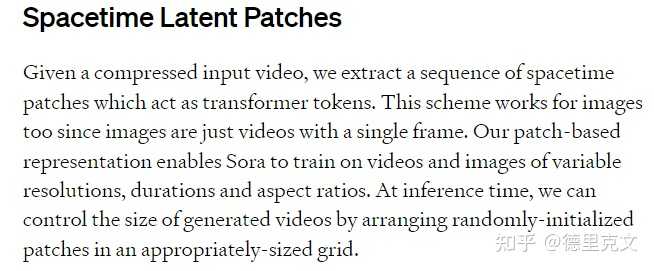

同时Sora的模型采用Transformer,像ViT一样将图像或者视频转成patches(类似文本tokens)送入Transformer模型。采用Transformer的一个优势是有很好的scaling性能。我估计这里为了减少计算量,还可能会采用latent diffusion,类似Meta之前的DiT。从最新的技术报告上看,确实是先用Visual Encoder将视频转到latent空间,然后再分解成patches: |

|

|

扩散模型之DiT:纯Transformer架构139 赞同 · 5 评论文章 |

|

|

Sora在训练过程中采用视频的原始分辨率进行训练,而不是像通常那样裁剪成正方形图片训练。这样训练的好处是可以避免裁剪效应。 |

|

|

0 |

|

|

0 而且这也让Sora支持生成变分辨率的视频(1920x1080和1080x1920 视频以及介于两者之间的所有视频)。在推理时,只需要重新组织随机初始化的noisy patches的grid大小(估计是通过位置编码来控制)就可以控制生成视频的的分辨率和时长。 |

|

|

0 |

|

|

0 |

|

|

0 Sora还使用 DALL·E 3 的recaption技巧,即为视觉训练数据生成高度描述性的caption,这让Sora能够更忠实地遵循生成视频中用户的文本指令,而且会支持长文本,这个应该是OpenAI独有的优势。 DALL-E 3技术报告阅读笔记155 赞同 · 19 评论文章 |

|

|

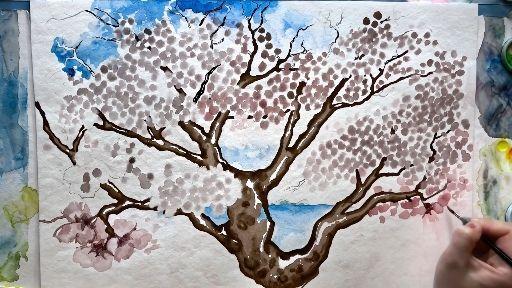

此外,从OpenAI公布的细节看,Sora不单单支持文生视频,还支持图生视频,即用一张图片生成生成视频,准确地动画图像的内容并关注小细节。Sora还可以获取现有视频并对其进行扩展或填充缺失的帧。 比如你可以先用DALLE-3生成一张图像,然后用Sora转成视频: |

|

|

|

|

|

0 |

|

|

|

|

|

0 Sora支持对已有的视频进行扩展,无论是向前还是向后(图生视频本质上属于视频扩展,只不过是单帧视频的扩展)。 |

|

|

0 |

|

|

0 |

|

|

0 按理说Sora是一个文生视频的模型,这里的视频扩展如果不是重新微调了模型,就是采用视频inpainting的方式来实现(类似文生图的inpainting)。 类似文生图的图生图,你也可以通过类似的视频转视频方案实现视频的编辑: |

|

|

0 |

|

|

0 你可以通过在两个视频间插帧来连接两个视频: |

|

|

0 |

|

|

0 |

|

|

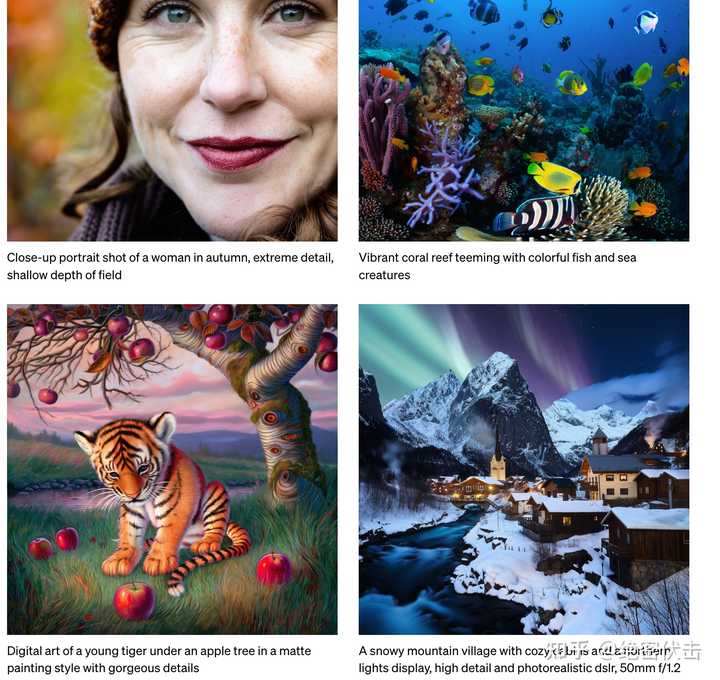

0 特别地,Sora还可以生成分辨率高达2048x2048的图像,因为图像可以看成只有一帧的图像: |

|

|

Close-up portrait shot of a woman in autumn, extreme detail, shallow depth of field |

|

|

Vibrant coral reef teeming with colorful fish and sea creatures 最后,祝贺OpenAI,距离AGI又近了一步: Sora serves as a foundation for models that can understand and simulate the real world, a capability we believe will be an important milestone for achieving AGI. OpenAI认为Sora可以称为物理世界的模拟器(world simulators),主要是因为视频生成模型在大规模训练时表现出许多有趣的新功能,这些功能使 Sora 能够模拟现实世界中人、动物和环境的某些方面。 3D consistency:Sora可以生成带有动态摄像机运动的视频。随着摄像机的移动和旋转,人和场景元素在三维空间中一致移动。 |

|

|

0 Long-range coherence and object permanence:Sora能够有效地对短期和长期依赖关系进行建模。例如,模型可以保留人、动物和物体的一致性,即使它们被遮挡或离开框架。同样,它可以在单个样本中生成同一角色的多个镜头,并在整个视频中保持其外观。 |

|

|

0 Interacting with the world:Sora可以用简单的方式模拟影响世界状况的动作。例如,画家可以在画布上留下新的笔触,并随着时间的推移而持续存在。 |

|

|

0 Simulating digital worlds:Sora 还能够模拟人工过程,一个例子是视频游戏。 Sora 可以通过基本策略控制《我的世界》中的玩家,同时以高保真度渲染世界及其动态。 |

|

|

0 这些能力说明Sora的强大,有希望模拟真实物理世界: These capabilities suggest that continued scaling of video models is a promising path towards the development of highly-capable simulators of the physical and digital world, and the objects, animals and people that live within them. OpenAI亲自下场,视频生成这个赛道将越来越卷,估计对Runway和Pika等公司有比较大的冲击。未来AIGC说到底还是算力的PK! |

|

|

|

|

非常同情做AI视频这个赛道的创业公司,OPENAI像一台高速飞奔的火车一样把这条赛道上的初创全部创死了。 如果 OPENAI在X上放出的视频是可信的,那么Sora生成视频的水平实在是太强了,各种创业公司搞的AI视频和它相比,就像别人还在用刀剑互砍时,OPENAI突然掏出了冲锋枪抵在了所有人的脑门上。 这种感觉就像前年ChatGPT横空出世一样,一出手就直接引爆了一个时代。2024年才过了2个月,OPENAI就端上来硬菜了,很期待今年将发布的GPT-5。 |

|

两个月前NeurIPS开会时,还围观了不少做cv和生成模型的小伙伴,激烈讨论LLM+video 的挑战和可能路径,但大家的共识基本还是「难」——特别是对长时间、高分辨率,和保证像素和语义的逻辑和连续性。一个月前pika 刷了一波屏,但争议更多。在视频领域超车openai 仿佛也成了诸多aigc 大小厂屈指可数的救命稻草。 而今sora 既出,什么学术前沿,什么open problem ,什么弯道超车… 一剑而已,碾压众生。 |

|

之前pika被各路媒体吹爆,结果OpenAI一出手就被干趴了。 这个例子告诉我们,创业最重要的不是创意,而是实力和现金流。 短视频行业要开始爆破了,等算力上去,ai会创作出大量短视频。 字节现在最好的策略就是立刻上市吸钱,不然万一哪天OpenAI自己出一个短视频app,专门播放ai视频,短视频从头到尾整个产业链都会被替代掉。 AI能更好的理解人类大脑的成瘾机制,如果OpenAI想做这个产业,很快就能把整个产业变成OpenAI的一个项目。 再多吃掉几个产业,没准靠净利润就能开始整合半导体产业。 |

|

我愿称为是视频生成领域的iPhone moment |

|

|

0 目前放出的demo视频来看,流畅度,稳定性,合理性,甚至是视频时长都是绝对完爆目前任何现有ai视频生成工具。runway,pika,pixverse这些公司可以关门了,完全没有竞争力。 其震惊程度我觉得比去年ChatGPT出来更猛。因为ChatGPT出来时发布blog,大家还能顺藤摸瓜理出头绪,gpt+alignment能理出个大概来,这回Sora推出就好比我们都还在怎么研究改进传统弓箭,市面最好的也就是复合弓,OpenAI直接开着航空母舰开大怼脸输出了。你就是完全想不出他怎么做到的。(OpenAI保密工作做的也是太好了,前两天Sam还在声东击西,放出一些gpt5的小消息,原来骗了所有人,搁着憋大招呢) 目前介绍里只提了使用世界模型,能够理解模拟物体的运动并作出预测。所以从目前放出demo来看,这个应该是领先一众现有模型的主要改进。但是肯定没有silver bullet,这个工作原作者也说了做了一年,其中的数据搜集/模型架构/炼丹秘方,肯定不是简单就能概括的。 Sora的推出应当变革了整个视频生产领域 |

|

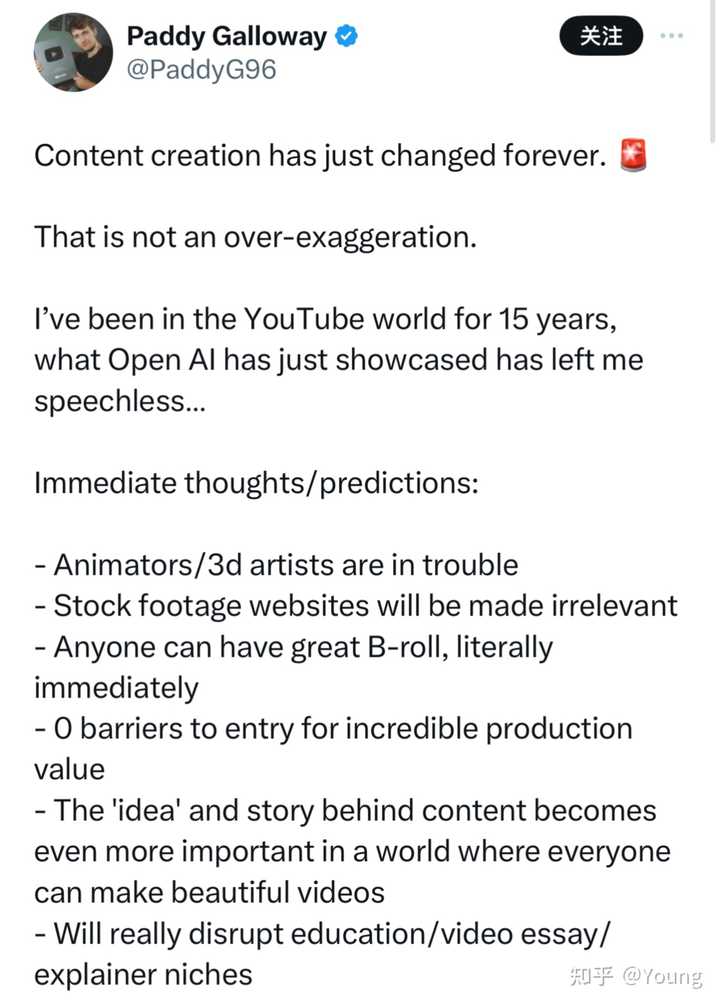

|

内容创作已经永远改变了。 这并不夸张。 我进入 YouTube 世界已经 15 年了,Open AI 刚刚展示的内容让我无语…… 即时想法/预测: - 动画师/3D 艺术家有麻烦了 - 素材网站将变得无关紧要 - 任何人都可以立即获得精彩的幕后花絮 - 零进入壁垒,实现令人难以置信的产值 - 在每个人都可以制作精美视频的世界中,内容背后的“想法”和故事变得更加重要 - 将会真正扰乱教育/视频论文/解释者的利基市场 所以接下来应该国内也反应过来了,还什么LLM大模型,赶紧做AI视频创业公司了。(不得不吐槽又一次要开始追赶,希望到年底能达到95%的水平……) 最近整理了Sora全网资料提示词视频项目拆解,想要的可以私信加我 |

|

|

|

|

|

|

|

|

|

|

我有个预感,Sora正式上线ChatGPT的那一天,也是GPT5发布的那一天。 官方发布链接:Sora: Creating video from text 说实话视频生成模型我用过,还不少,比如之前大火的Runway。 请问有什么软件能够AI自动生成视频?106 赞同 · 2 评论回答 |

|

|

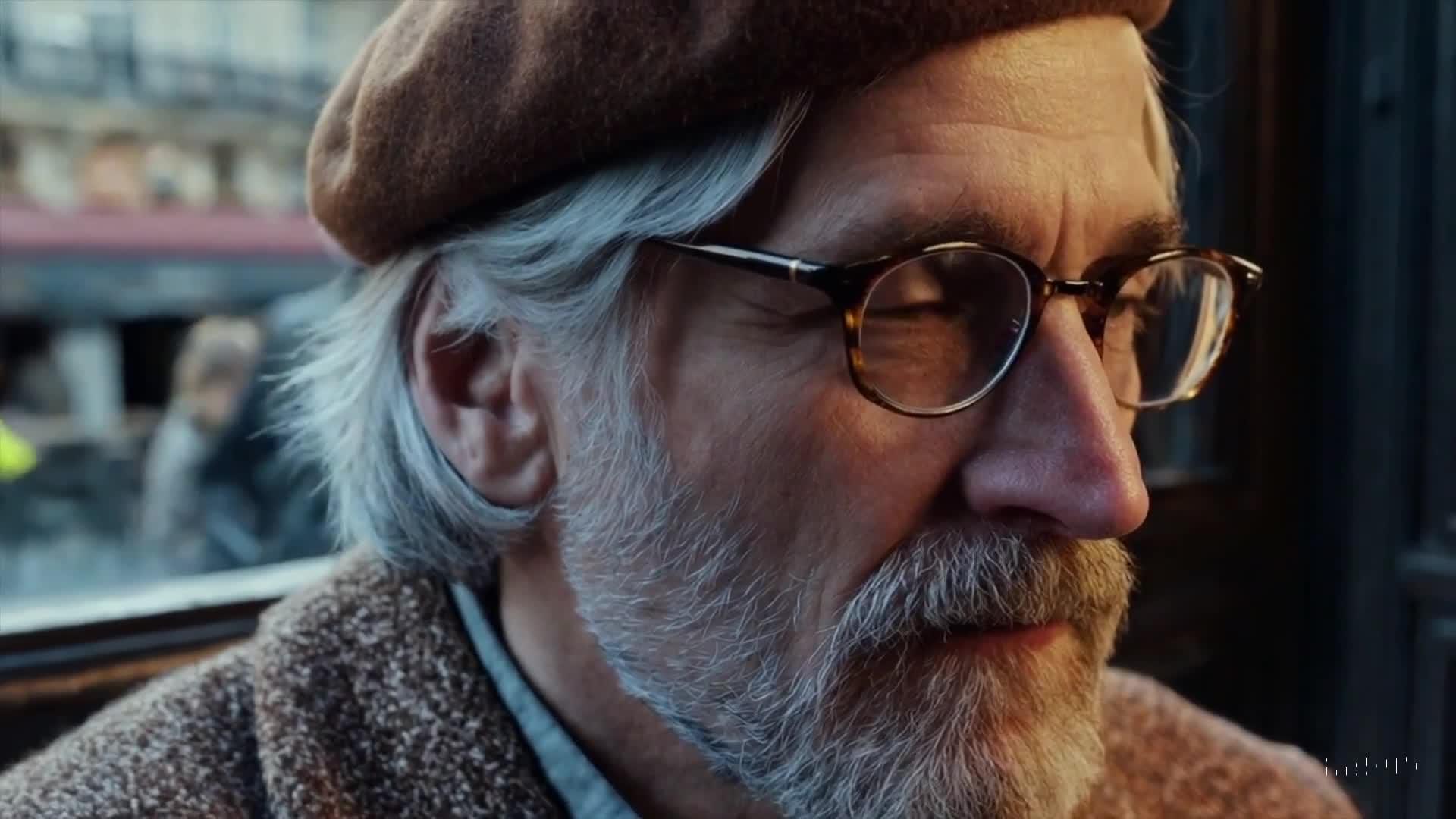

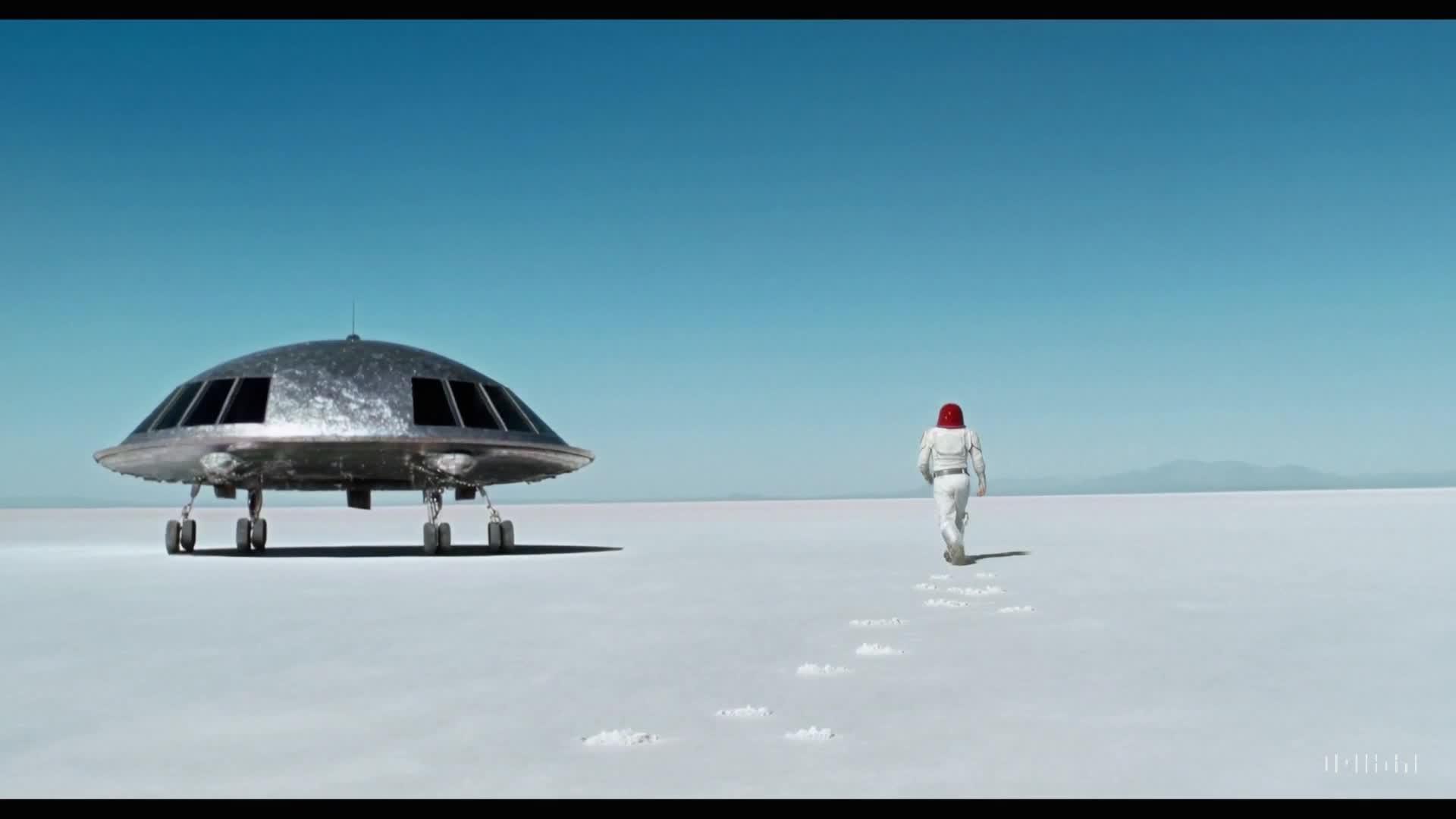

但是OpenAI这个大模型一出来,说实话就有点儿惊为天人了,下面这个动图是Sora的封面视频。 |

|

|

你看,这玩意像不像梦境? |

|

|

虽然说大家在做产品宣发的时候都会拿最好的结果出来,这无可厚非,但是其他家的视频生成宣传图是真的不如Sora。 案例解释 并且这玩意有几个点非常的强,你看下面这个例子。 |

|

|

|

|

|

0 |

|

|

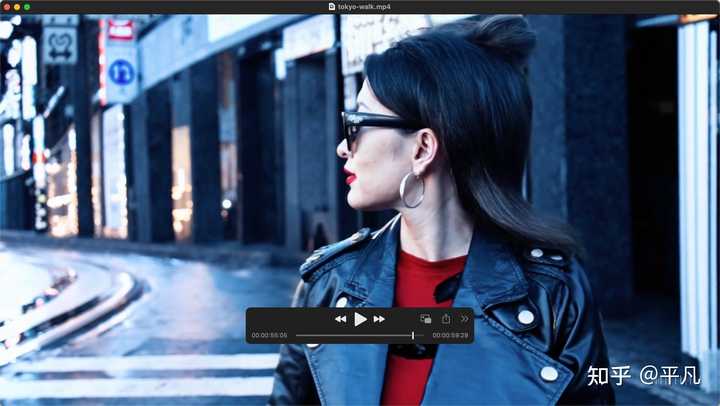

1 它对于复杂Prompt的理解能力 这是上面这个视频的Prompt,很复杂的一个Prompt。 Prompt: A stylish woman walks down a Tokyo street filled with warm glowing neon and animated city signage. She wears a black leather jacket, a long red dress, and black boots, and carries a black purse. She wears sunglasses and red lipstick. She walks confidently and casually. The street is damp and reflective, creating a mirror effect of the colorful lights. Many pedestrians walk about. 提示:一位时尚的女人走在东京的街道上,街道上到处都是温暖的发光霓虹灯和动画城市标志。她身穿黑色皮夹克,红色长裙,黑色靴子,背着一个黑色钱包。她戴着墨镜,涂着红色口红。她自信而随意地走路。街道潮湿而反光,营造出五颜六色的灯光的镜面效果。许多行人四处走动。 你如果用过AI绘画的话就知道,这个prompt含有的元素其实有很多,AI绘画不一定能完美的复现,但是你看视频中呈现出来的元素,东京街道、各种霓虹灯,穿着打扮,都非常的契合。 更重要的是,连「自信而随意」这种东西都似乎非常的贴合,如果这是Sora的正常水平,我会觉得这个东西太恐怖了。 2 时长 这个视频足足有59秒,你可能会觉得一个不到1分钟的视频而已。 但是我跟你说,现在主流的视频生成模型一般的生成时长在10秒钟之内,并不是不想生成长的,而是短短几秒能控制得住,一旦时间长了,就不知道会生成什么奇形怪状的东西出来了。 这个视频长度和大语言模型的输入输出长度一样,其实也是黄金标准。 一个大模型能处理10万字,另一个只能1万字,这水平不言而喻了。 3 画面的精细度 你看我圈出来的,这个人的脸部细节有多少,什么雀斑,各种色素什么的,是不是很多,这其实没什么。 |

|

|

|

|

|

但是下面这个就很恐怖了,这是一个镜头远一些的视频片段,你仔细看看她的脸。 |

|

|

是不是发现她脸上的那些细节基本上都还在,特别是左脸中间的那个雀斑? |

|

|

还是那句话,别的视频生成模型,我也用过,但是像细节保存的这么好的,Sora现在是Top1。 技术概要 这个其实没有太多可以解释的,因为它的技术报告还没有放出来。 确定是它也是用Diffusion model做的,简单点说,就是给一张图片加上雪花一样的噪音,然后再还原回去的过程,它的本质是物理上的扩散模型。 |

|

|

它原先是用来生成单张图片的,但是视频本身就是由图片组成的,比如一秒=24帧,每一张就是一张图片。 |

|

|

Sora生成10秒视频,说白了就是生成10*24 = 240张图片,然后组合起来,就是一个视频。 原理就是这么的简单,别家也是用的差不多的算法,但是它的效果好,估计是训练数据好,以及由OpenAI的独家训练方法。 总结一下?? 技术核心: Sora是一种扩散模型,通过逐步去除初始静态噪声视频中的噪声来生成清晰视频。 功能特点: 一次性生成整个视频或对现有视频进行扩展,使其更长。通过同时预测多帧,解决了保持视频中主体一致性的挑战。使用transformer架构,提供了优秀的扩展性能。 数据处理方式: 视频和图像被分解为“补丁”(小数据单元),类似于GPT模型中的令牌。这种数据表示方法扩展了模型处理不同持续时间、分辨率和纵横比视觉数据的能力。 技术创新: 结合了DALL·E和GPT模型的研究成果。引入DALL·E 3的重新标题技术,为视觉训练数据生成描述性标题,以更准确地遵循用户的文本指令。 应用场景: 根据文本指令生成视频。从静止图像生成动态视频,精确动画化图像内容。扩展现有视频或填充缺失帧。特性 1 能够生成具有多个角色、特定类型的运动以及主题和背景的准确细节的复杂场景。该模型不仅了解用户在提示中要求的内容,还了解这些东西在物理世界中的存在方式。 比如下面这个视频截图 |

|

|

Prompt: A close up view of a glass sphere that has a zen garden within it. There is a small dwarf in the sphere who is raking the zen garden and creating patterns in the sand. 提示:一个玻璃球的特写视图,里面有一个禅宗花园。球体中有一个小矮人,他正在禅宗花园里耙地,在沙子上创造图案。 生成出来的视频,考虑到了透过玻璃的画面会产生反射和折射,非常的精确了还原了Prompt。 2 可以生成具有多个角色、特定类型的运动以及主题和背景的准确细节的复杂场景。该模型不仅了解用户在提示中要求的内容,还了解这些东西在物理世界中的存在方式。 比如这个庆祝春节的视频,里面不仅有舞龙,还有乌泱泱的人,非常精确的还原了prompt的内容, Prompt: A Chinese Lunar New Year celebration video with Chinese Dragon. 提示:中国龙的中国农历新年庆祝视频。 |

|

|

缺点 难以准确模拟复杂场景的物理特性,并且可能无法理解因果关系的具体实例。例如,一个人可能会咬一口饼干,但之后,饼干可能没有咬痕。 该模型还可能混淆提示的空间细节,例如,左右混淆,并且可能难以精确描述随时间推移发生的事件,例如遵循特定的相机轨迹。 你看下面的这些狗子,会凭空的出现。 |

|

|

一些例子 |

|

|

0 |

|

|

0 |

|

|

0 |

|

一觉醒来,大家又炸了。 Sora的生成效果太好了,快速过了下官方的技术报告。 我关心2个点, Scaling transformers for video generation具体指什么,文中提到Sora还是diffusion的,用了transformer的结构,可以scaling。报告里面没有看到一条scaling的曲线,出现类似涌现的现象了吗? |

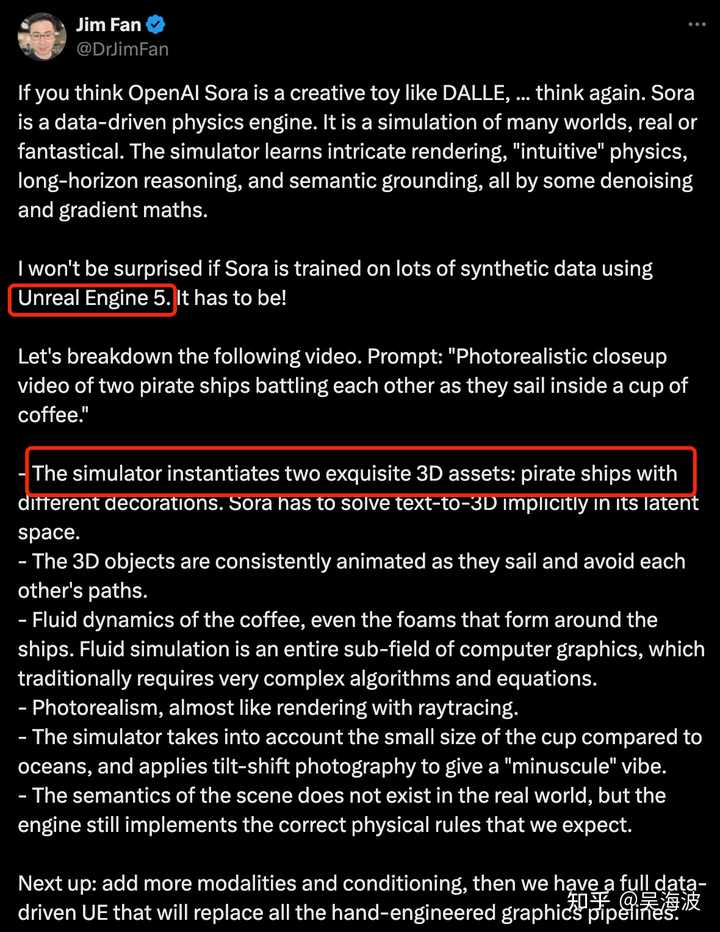

|

|

是不是像大家猜测的在生成过程中用了unreal的引擎去生成一些物体? |

|

|

最后,Openai到底领先行业几年? |

|

发一下我在另外一个地方发的回答(再一次被知乎不支持合并问题坑了):如何看待openai最新发布的sora? |

|

当年NLPer被ChatGPT杀死比赛的恐惧 现在轮到CVer体会了 |

|

今天凌晨父亲心梗摔倒去世,今晚刷到这个问题,希望ai继续发展,可以做出爸爸平日样子的视频 |

|

想起 Sam Altman 说的话,不要站在 OpenAI 前面,去搞应用吧! 想想好多创业者对投资人的话,我们比 ChatGPT 强的地方的没有它好! Sora: Creating video from text 如果你有耐心,请看完下面的这个视频,我把官方的49 个视频合并在一起了,差不多 10 秒到 1 分钟的视频,没有像其它别的 AI 工具那样短的! 优点简直对所有 AI 生成工具是碾压式的:时长超过所有的生成工具帧间过滤极其稳定,没有发生人物或物体的变形及异化镜头流畅能够生成具有多个角色、特定类型的运动以及主体和背景的准确细节的复杂场景。该模型不仅了解用户在提示中提出的要求,还了解这些东西在物理世界中的存在方式。可以在单??个生成的视频中创建多个镜头,准确地保留角色和视觉风格。缺点:它可能难以准确模拟复杂场景的物理原理,并且可能无法理解因果关系的具体实例。例如,一个人可能咬了一口饼干,但之后饼干可能没有咬痕。 该模型还可能会混淆提示的空间细节,例如混淆左右,并且可能难以精确描述随着时间推移发生的事件,例如遵循特定的相机轨迹。技术介绍:Sora 是一种扩散模型,本质上跟 StableDiffusion 并没有差太多,是从静态噪声的视频开始生成视频,然后通过多个步骤消除噪声来逐渐对其进行转换。Sora 能够一次生成整个视频或扩展生成的视频以使其更长。原理是通过一次为模型提供多个预测关键帧,解决了一个具有挑战性的问题,即确保主题即使暂时离开视野也保持不变。与 GPT 模型类似,Sora 使用【变换器/Transformer】架构。我们将视频和图像表示为称为【补丁/Patch】的较小数据单元的集合,每个Patch类似于 GPT 中的Token。通过统一我们表示数据的方式,我们可以在比以前更广泛的视觉数据上【变换器/Transformer】,涵盖不同的持续时间、分辨率和纵横比。我想它应该是一个初始类似 ViT 的架构,但是很明显这个模型的训练的算力大到无以复加,没有几个公司或者机构有能力重现。Sora 建立在过去对 DALL·E 和 GPT 模型的研究之上。它使用 DALL·E 3 的recaptioning技术,该技术涉及为视觉训练数据生成高度描述性的标题。因此,该模型能够更忠实地遵循生成视频中用户的文本指令。除了能够仅根据文本指令生成视频之外,该模型还能够获取现有的静态图像并从中生成视频,准确地动画图像的内容并关注小细节。该模型还可以获取现有视频并对其进行扩展或填充缺失的帧。 Sora 是能够理解和模拟现实世界的模型的基础,我们相信这一功能将成为实现 AGI 的重要里程碑。 也就是从结果上看这个技术可能不仅是生成,更像是一个对于真实世界的“孪生”,同时它还提到了“世界”,是不是更像 Yann LeCun 的世界模型的未来呢? 我不知道 ,但是我知道 所有做视频生成的工具厂商被埋了,而且这个可能是去年的东西!!!! |

|

|

OpenAI 可能是 AGI 的未来,但是是所有人工智能创业公司的噩梦! |

|

|

|

|

连央视都被惊动报道了! |

|

|

在我看来Sora展示了OpenAI想要做一个世界模型的一个企图和野心,AGI真的不远了。 |

|

|

我用AI绘画生成的图片 先让我们了解下Sora都做了什么吧! 一、效果展示 先看看长达59秒全部由文字生成的效果。 提示词:一位时尚的女士走过东京的一条街道,街道上充满了温暖发光的霓虹灯和动画城市标志。她穿着一件黑色皮夹克,一条长红色连衣裙,黑色靴子,并携带一个黑色手提包。她戴着太阳镜,涂着红色口红。她自信而随意地走着。街道潮湿且反光,创造出彩色灯光的镜像效果。许多行人走在街上。 这是一镜到底的手法,而且包括了多机位。 无论是还是视频中前景人物的女主角、还是背景中的人物标识牌,都达到了惊人的一致性。而且各种镜头语言随意切换,人物都是保持了非同一般的稳定性。 这对比原来Runway 和 Pika的图片,完全是降维打击。 让我们再看看其他视频。 这些视频都有一个共同特点,图片的精度和稳定性让你无法相信这不是现实拍摄的。 二、如何评价 Sora本次展示的是技术思路不同所带来的完全碾压。 从关注二维像素的变化,变成关注语义理解的变化,从视频画面的生成,变成故事逻辑的生成。 |

|

|

之前无论是Runway、Pika、SVD等等文生图、文生视频都是在二维平面上对图像进行调整和组合,但是Sora的视频,显示它能像人一样理解一些基础的物理规律,这是 OpenAl利用它的大语言模型优势进行的超强语义理解,是真正层面的世界模型。 只有实现对现实世界的理解和对真实世界的模拟,这样产生的图像和视频才是更加真实的效果。 这次Sora带来的震撼或许不仅仅是影视行业,而是未来可能扩展到其他行业,视频展示的是对真实世界物理规律的再现! 英伟达的高级科学家Jim Fan认为 Sora 的实现原理,这不仅仅是一个视频生成模型这么简单,还是一个基于数据驱动的虚幻 5 引擎。 可以把 Sora 看作是一种可学习的模拟器,或者说是一个能模拟现实世界的“世界模型”。 这种方法可以让 Sora 更好地理解和模拟现实世界的物理现象。 而在今日OpenAI发布首款文生视频大模型Sora后,360集团创始人、董事长兼CEO周鸿祎分享一些观点。 他认为“今天Sora可能给广告业、电影预告片、短视频行业带来巨大颠覆,但它不一定那么快击败TikTok,更可能成为TikTok的创作工具”。 他谈到Sora的技术思路完全不一样,通过把大语言模型和扩散模型结合,实现了对现实世界的理解和对世界的模拟两层能力,这样产生的视频才是真实的。 一旦AI接上摄像头,把所有电影、YouTube和TikTok上的视频看一遍,对世界的理解将远远超过文字学习,“这就离AGI真的就不远了,不是10年20年的问题,可能一两年很快就可以实现”。 周鸿祎相信OpenAI手里还藏有一些秘密武器。 |

|

|

而我认为作为直接冲击的行业,对影视行业来说,未来的电影创作、拍摄、后期制作的形态都可能因AI而发生变革。 AI角色可以以大语言模型为基础,在虚拟世界中实时进行对话演出。这种方式可以显著提高生成内容的效率,使AI成为独立的创作工具,完成故事、角色、对白的创作,最终实现人人都可以通过AI视频工具来创作自己电影的效果。 三、原理解读 |

|

|

首先我附上OPENAI的论文链接,感兴趣的可以直接阅读: 接下来说下我对文章的理解: 1、世界模拟器 OpenAI目前开发的Sora视频生成模型技术,将完全超越现有的视频生生成模型,如Runway和Pika。 这项技术的核心是一个创新的“世界模拟器”,它是一个基于文本条件的扩散模型,通过从大量的视频中学习,这些视频涵盖了不同的时长、宽高比和分辨率。 这个模拟器的训练过程涉及吸收和处理海量的视觉数据,使其能够根据文本描述生成相应的视频内容。 例如,当输入“太空人的冒险故事,他戴着一顶红色羊毛编织的摩托车头盔”这样的描述时,模型能够理解含义,并且生成与之相符的视频画面。 |

|

|

该模型还具备生成视频的灵活性和多样性,支持不同的时长和分辨率设置,其最大输出规格可达1920*1080的分辨率和30帧/秒的帧率。 2、视觉数据转换 简单来说,OpenAI在视觉数据处理领域,将视觉数据转换为“patch”这一个个单元体,它可以将图像和视频帧分割成“补丁”状的小块。 这些“补丁”作为视觉模型的基本输入单元,使得模型能够学习和理解如何表示以及重建视觉场景。在此基础上,模型能够在特定条件,如文本描述的引导下,生成新的图像或视频内容。 |

|

|

这种处理方式与大型语言模型中的“token”概念相似,token是文本数据的基本处理单元。 在语言模型中,文本被分解为较小的片段以实现语言的理解和生成。同样地,视觉模型的训练过程涉及将不同类型的视频和图片转换成patch,作为模型输入的基本单位。 这个过程可以理解成首先将视频压缩到一个较低维的潜在空间,然后将视频转换为patch,并进一步分解为“spacetime patches”(时空补丁)。 3、视频压缩 研究者开发出一种专门的视频压缩网络。 该网络的核心是一个经过训练的神经网络,其设计宗旨在于降低视觉数据的多维度复杂性。 而所谓的“降低维度”,指的是将数据从高维空间——例如原始视频数据,包含了海量的像素信息——转换到低维空间。这一过程的目的是对数据进行简化,提取关键特征,同时减少后续处理所需的计算资源。 |

|

|

这个神经网络接受原始视频作为输入,并输出一个在时间和空间上都经过压缩的潜在表示(latent representation)。 时间上的压缩意味着减少了表示视频动态变化所需的信息量; 空间上的压缩则意味着减少了表示视频中每一帧图像所需的信息量。 在这个压缩的潜在空间中,Sora模型首先进行训练,学习如何理解和控制这种形式的数据。经过训练,Sora能够在这个潜在空间内生成新的视频数据。 为了将Sora生成的潜在表示转换回原始的像素空间,研究者还训练了一个解码器模型。 解码器的作用是将压缩的视频数据还原成可以直接观看的视频格式。 4、时空补丁(Spacetime Laten Patches) 在视频数据压缩完成后,接下来的关键步骤是提取一系列的“Spacetime Latent Patches”,这些Patches包含了视频在特定时间和空间范围内的信息。 这些Patches在transformer模型中扮演的角色类似于自然语言处理中的单词token。 这种方法不仅适用于视频数据,也适用于图形数据,使得不同分辨率、时间和宽高比的视频和图像能够作为Sora模型的训练集。 |

|

|

在模型推理,即生成新的视频内容时,可以通过在适当大小的网格中排列随机初始化的Patches来控制生成视频的大小。 这个过程类似于在自然语言处理中,模型根据给定的token生成新的文本内容。通过这种方式,Sora模型能够根据需要生成不同大小和格式的视频,为视频生成和编辑提供了更大的灵活性和多样性。 5、视频生成扩展变压器 Sora模型的根基是建立在Transformer架构之上的扩散模型。 该模型通过接收输入的噪声Patches和文本提示等调节信息,能够有效地预测出“干净”的Patch。 |

|

|

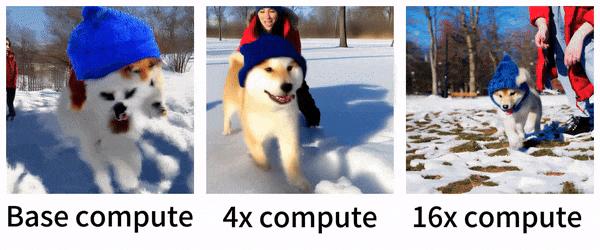

这种架构在大型语言模型、计算机视觉和图像生成等领域都有着广泛的应用。 在训练过程中,使用固定的种子和输入,随着计算量的增加,生成样本的质量会显著提高。 这种训练方式使得Sora模型能够逐步学习并优化其生成能力,从而在处理视频和图像数据时,能够输出更加精细和逼真的结果。 结语 Sora带给我的震撼实在太大,需要好好消化,后续有想法再与大家分享 我是德里克文,一个对AI绘画,人工智能有强烈兴趣,从业多年的 设计师!如果对我的文章内容感兴趣,请帮忙关注点赞收藏,谢谢! |

|

几个月前我有一篇关于大模型时代创业路线的回答,简单概括就是: 卷私有数据,卷私有数据,卷私有数据。 其他的都靠不住。 |

|

对于机器人来说,这是一个非常好的数据来源。现在做机器人多模态任务的难点就在于缺乏高质量视频-语言对齐的数据集。也许很快我们就能看到基于Sora生成数据训练的机器人操作基础模型了! |

|

昨天白天,「现实不存在了」开始全网刷屏。很多人感叹:我们这么快就步入下一个时代了?Sora 简直太炸裂了。这就是电影制作的未来! 谷歌的 Gemini Pro 1.5 还没出几个小时的风头,天一亮,全世界的聚光灯就集中在了 OpenAI 的 Sora 身上。Sora一出,以前的视频生成模型只有臣服。 |

|

|

根据介绍,Sora 通过简短或详细的 prompt,或一张静态图片,就能生成类似电影的逼真场景,最高能生成1分钟左右的 1080P 高清视频。 我们来感受一下: 输入 prompt(提示词):一朵巨大、高耸的人形云笼罩着大地。云人向大地射出闪电。 |

|

|

|

|

效果拉满! 就在几小时后,OpenAI Sora 的技术报告也发布了。其中,「里程碑」也成为报告中的关键词。 不过遗憾的是,报告不包括模型和实现细节。OpenAI 还是那个 Close AI。不过虽然没有模型细节,但是我们从技术报告中还是能大概了解 Sora 的工作原理,解下来我们就来解读一下这篇技术报告。 技术报告关键信息 视觉数据的统一表示:受到大型语言模型(LLM)的启发,这些模型通过在互联网规模的数据上训练,使用tokens来统一不同模态的文本。Sora 模型采用了视觉块(visual patches)作为其视觉数据的表示,这些块(patches)在训练和生成视频时都非常有效。 视频压缩网络:OpenAI 训练了一个网络来降低视觉数据的维度,这个网络将原始视频压缩到一个时空潜在空间中,Sora 在这个压缩的潜在空间中训练和生成视频。同时,还训练了一个相应的解码器模型,将生成的潜在表示映射回像素空间。 空间时间块(spacetime patches):通过将压缩后的视频分解为一系列 spacetime patches,这些 patches 作为 transformer 的 token。这种基于 patches 的表示允许 Sora 在不同分辨率、时长和宽高比的视频和图像上进行训练 diffusion-transformer:Sora 是一个扩散模型,它通过预测原始的“干净”patches来训练,这些 patches 在输入时带有噪声。diffusion-transformer 在视频模型中也显示出了有效的扩展性。 可变时长、分辨率和宽高比:与以往通常将视频调整到标准尺寸的方法不同,OpenAI 发现在原始尺寸上训练数据提供了多种好处,包括采样灵活性和改进的构图。 语言理解:为了训练文本到视频的生成系统,需要大量带有对应文本标题的视频。OpenAI 应用了 DALL·E 3 中引入的重新标题技术(re-captioning technique),首先训练一个高度描述性的标题生成模型,然后为训练集中的所有视频生成文本标题。 图像和视频 prompt:Sora 不仅可以通过文本提示生成视频,还可以通过预先存在的图像或视频作为输入。这使得 Sora 能够执行广泛的图像和视频编辑任务。 生成视频的能力:Sora 还能够生成图像,通过在空间网格中排列高斯噪声的 patches,这些 patches 具有一帧的时间范围。模型可以生成不同大小的图像,分辨率高达 2048×2048。 模拟能力:当视频模型在大规模训练时,展现出一些有趣的新兴能力,例如 3D 一致性和物体持久性,以及与世界互动的能力。Sora 甚至能够模拟数字世界,例如在 Minecraft 中同时控制玩家和渲染世界。 解下来详介绍下技术报告的细节。 视频生成模型作为世界模型 OpenAI 探索了视频数据生成模型的大规模训练。具体来说,具体来说,研究人员在可变持续时间、分辨率和宽高比的视频和图像上联合训练了一个文本条件扩散模型(text-conditional diffusion models)。利用一种transformer架构,处理视频和图像的空间时间块(spacetime patches)。其最大的模型 Sora 能够生成长达一分钟的高质量视频。 OpenAI 认为,扩展视频生成模型是构建物理世界通用模拟器的一条有效途径。 技术报告重点 技术报告主要关注两个方面: (1)将所有类型的视觉数据转化为统一的表示形式,以便进行大规模的生成模型训练。 (2)对 Sora 模型的能力和局限性进行定性评估。 在以往的研究中,已经有许多工作使用各种方法对视频数据进行生成建模,包括循环网络(RNN)、生成对抗网络(GAN)、自回归 transformer 和扩散模型(diffusion models)。这些研究通常集中在特定类别的视觉数据、较短的视频或固定大小的视频上。 相比之下,Sora 是一个通用的视觉数据模型,它可以生成跨越不同时长、宽高比和分辨率的视频和图像,甚至能够生成长达一分钟的高清视频。 视觉数据转为 Patches 大型语言模型(LLM)通过在互联网规模的数据上进行训练,获得了出色的通用能力中,OpenAI 从这一点汲取了灵感。LLM 得以确立新范式,部分得益于创新了 token 使用的方法。研究人员巧妙地将文本的多种模态 —— 代码、数学和各种自然语言统一了起来。 在这项工作中,OpenAI 考虑视觉数据的生成模型如何继承这些好处。与 LLM 拥有文本 token 不同,Sora 拥有视觉块(visual patches)。块(patches)已经被证明是视觉数据模型的有效表示。OpenAI 发现 patches 是训练视频和图像生成模型的有效表示。 |

|

|

在更高层面上,OpenAI 首先将视频压缩到较低维的潜在空间,然后将表示分解为时空 patches,从而将视频转换为 patches。视频压缩网络 OpenAI 训练了一个网络来降低视觉数据的维度。这个网络以原始视频为输入,输出一个在时间和空间上都被压缩的潜在表示。Sora 在压缩的潜在空间上训练并生成视频。OpenAI 还训练了一个相应的解码器模型,将生成的潜在表示映射回像素空间。 时空潜在 patches 给定一个压缩的输入视频,OpenAI 提取一系列时空 patches,充当 Transformer 的 tokens。该方案也适用于图像,因为图像可视为单帧视频。OpenAI 基于 patches 的表示使 Sora 能够对不同分辨率、持续时间和长宽比的视频和图像进行训练。在推理时,OpenAI 可以通过在适当大小的网格中排列随机初始化的 patches 来控制生成视频的大小。 用于视频生成的缩放 Transformer Sora 是一个扩散模型,给定输入噪声 patches(以及文本提示这样的条件信息),训练出的模型来预测原始的“干净” patches。重要的是,Sora 还是一个扩散 Transformer。Transformer 在包括语言建模、计算机视觉和图像生成在内的多个领域展示了显著的扩展属性。 |

|

|

在这项工作中,OpenAI 发现扩散 Transformers 也可以有效地缩放为视频模型。下面,OpenAI 展示了训练过程中随着训练计算量的增加,视频样本的质量显著提高。 |

|

|

|

|

可变的持续时间,分辨率,宽高比 过去的图像和视频生成方法通常需要调整大小、进行裁剪或者是将视频剪切到标准尺寸,例如 4 秒的视频分辨率为 256x256。相反,在原始大小的数据上进行训练,可以提供以下几个好处。 采样灵活性 Sora 可以采样宽屏视频 1920x1080p、垂直视频 1920x1080p 以及两者之间的视频。这使 Sora 能够直接以其天然纵横比为不同设备创建内容。Sora 还允许在生成全分辨率的内容之前,以较小的尺寸快速创建内容原型 —— 所有内容都使用相同的模型。 |

|

|

|

|

提高了构图和布局 研究者通过实验发现,使用视频的原始长宽比进行训练可以改善内容和布局。将 Sora 与其他模型的比较中,后者将所有训练视频裁剪成正方形,这是训练生成模型时的常见做法。经过正方形裁剪训练的模型(左侧)生成的视频,其中的视频主题只是部分可见。相比之下,Sora 生成的视频(右侧)具有更好的构图。 |

|

|

|

|

语言理解 训练文本到视频生成系统需要大量带有对应文本标题的视频。研究团队将 DALL?E 3 中的重新标题(re-captioning technique)技术应用于视频。 具体来说,研究团队首先训练一个高度描述性的标题生成模型,然后使用它为训练集中所有视频生成文本标题。研究团队发现,对高度描述性视频标题进行训练可以提高文本保真度以及视频的整体质量。 与 DALL?E 3 类似,研究团队还利用 GPT 将简短的用户 prompt 转换为较长的详细描述,然后输入到视频模型。这使得 Sora 能够生成准确遵循用户 prompt 的高质量视频。 使用图像和视频作为提示 我们已经看到了文本到视频的诸多生成示例。实际上,Sora 还可以使用其他输入,如已有的图像或视频。这使 Sora 能够执行各种图像和视频编辑任务 — 创建完美的循环视频、静态图像动画、向前或向后延长视频时间等。 为 DALL-E 图像制作动画 Sora 能够根据图像和提示生成视频。下面我们展示了基于 DALL·E 2 和 DALL·E 3 图像生成的视频示例。 |

|

|

|

|

输入图片+一只戴着贝雷帽和黑色高领毛衣的柴犬 |

|

|

|

|

输入图片+写有“SORA”的云图像扩展生成的视频 Sora还能够扩展视频,无论是开头还是结尾。可以使用这种方法无限延长视频的内容,实现「视频制作永动机」。 |

|

|

|

|

视频到视频编辑 扩散模型激发了多种根据文本 prompt 编辑图像和视频的方法。OpenAI 的研究团队将其中一种方法 ——SDEdit 应用于 Sora,使得 Sora 能够在零样本(zero-shot)条件下改变输入视频的风格和环境。 输入视频如下: |

|

|

|

|

输出结果: |

|

|

|

|

连接视频 我们还可以使用 Sora 在两个输入视频之间逐渐进行转场,创建两个完全不同主题和场景构图视频之间的无缝过渡。 图像生成能力 Sora 也能够生成图像。为此,OpenAI 将高斯噪声 patches 排列在空间网格中,时间范围为一帧。模型可以生成不同大小的图像,最高分辨率可达 2048x2048。 |

|

|

涌现模拟能力 OpenAI 发现,视频模型在经过大规模训练后,会表现出许多有趣的新能力。这些能力使 Sora 能够模拟物理世界中的人、动物和环境的某些方面。这些能力在没有对3D、物体等的任何显式归纳偏差的情况下出现 —— 它们纯粹是规模现象。 3D 一致性 Sora 可以生成带有动态摄像机运动的视频。随着摄像机的移动和旋转,人和场景元素在三维空间中一致移动。 |

|

|

|

|

长序列连贯性和目标持久性 视频生成系统面临的一个重大挑战是在对长视频进行采样时保持时间一致性。OpenAI 发现,虽然 Sora 并不总是能有效地模拟短距离和长距离的依赖关系,但它在很多时候仍然能做到这一点。例如,即使人、动物和物体被遮挡或离开画面,Sora 模型也能保持它们的存在。同样,它还能在单个样本中生成同一角色的多个镜头,并在整个视频中保持其外观。 |

|

|

|

|

与世界互动 Sora 有时可以模拟以简单方式影响世界状态的动作。例如,画家可以在画布上留下新的笔触,这些笔触会随着时间的推移而持续,或者一个人可以吃汉堡并留下咬痕。 |

|

|

|

|

模拟数字世界 Sora 还能模拟人工过程,视频游戏就是一个例子。Sora 可以通过基本策略同时控制 Minecraft 中的玩家,同时高保真地呈现世界及其动态。只需在 Sora 的 prompt 中提及 「Minecraft」,就能零样本激发这些功能。 |

|

|

|

|

这些功能表明,视频模型的持续扩展是开发物理和数字世界以及其中的物体、动物和人的高能力模拟器的一条大有可为的道路。 局限性 作为一款模拟器,Sora 目前还存在许多局限性。例如,它不能准确模拟许多基本交互的物理现象,如玻璃碎裂。其他交互,如吃食物,并不总能产生正确的物体状态变化。报告中列举了 Sora 模型的其他常见失效模式,例如长时间样本中出现的不连贯性或物体的自发出现。 |

|

|

|

|

|

|

|

|

|

不过,Sora 目前所展现的能力证明了持续扩大视频模型的规模是一个充满希望的方向。 总结 OpenAI 的技术报告看起来就像是炫技,没什么干货,反正就是我很牛,为什么很牛,你自己去理解。最后来了一句扩大模型规模很有效果! 参考 Video generation models as world simulators SORA:OpenAI最新文本驱动视频生成大模型技术报告解读-CSDN博客 OpenAI王炸模型引爆科技圈,官方技术报告说了什么? 谷歌发布新一代多模态大模型 Gemini 1.5,有哪些能力提升? 我在模拟世界!OpenAI刚刚公布Sora技术细节:是数据驱动物理引擎 华尔街见闻 强化学徒:SORA技术报告全文翻译-作为世界模拟器的视频生成模型 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |