| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> 有一说一,真有人用paddlepaddle (飞桨) 吗? -> 正文阅读 |

|

|

[科技知识]有一说一,真有人用paddlepaddle (飞桨) 吗? |

| [收藏本文] 【下载本文】 |

|

如果不是百度员工或者利益相关,真有人会用它来工作吗?pytorch都1.3了啊,tensorflow都动态图了。要说硬件部署,现在哪个都是硬件挑框架,… |

|

最近项目经历有感而发,再一次感觉百度这个烧钱+kpi做国产开源的模式走不远。 确实,paddle的其他的配套库做的功能看起来非常强大。加上为了推广框架大量买卡,学colab免费给用户用。这两点极大程度地降低了中文社区使用ai训练模型的门槛,但是也仅限于门槛了。你若继续深度使用的时候就会出现各种蛋疼的问题,流畅程度完全比不上隔壁的pytorch。 拿最近的一个项目举例,做3d的ct影像分割,发现paddleseg的套件中的医疗分割就比较容易上手,美滋滋地下载了官方训练好的一个vnet模型,想着把部署的那块先写了。然后用paddle2onnx导出的时候提示conv3d_transpose算子不支持。 我一开始还以为模型很新,新算子不支持很正常。但是隐隐觉得不对,上arxiv一看模型都是2016年的上古老模型了。再去paddle2onnx官方库一查,2021年有人提了相同的issue,官方打了个新特性的标记就没有下文了。然后翻遍整个仓库,发现似乎团队在忙一个fastdeploy的项目,大概是今年的主要kpi吧,还把整个paddle2onnx再那里复制了一份。我跑去那里提了个issue,依旧没人搭理,这个fastdeploy项目粗眼一瞅还是个beta版本,使用编译贼复杂。行吧,求助飞桨官方这条路宣布基本放弃。 然而第二天贼心不死,突发奇想在github上搜其他的方案,让我搜到了这么一个野生库,叫paddleocr2pytorch,基本的做法就是把相同的模型在pytorch里搭出来,然后将飞桨的模型权重读到pytorch模型里面。 我抱着死马当活马医的想法这么一试,您猜怎么着,真的就是import paddle as torch。这两者最顶层的api不能说完全一样,但也基本就是安卓跟鸿蒙的区别,把paddle的模型文件拿过来关键字替换就把模型搭好了。 接着琢磨权重的问题,我寻思到这里了肯定得卡很久,您再怎么抄,也不能做到完全一致吧。我把权重的字典key的名称替换了一下,读入权重后准备一层层核对输入输出,然而我很快发现连这一步都省了,拼装模型输出跟paddlepaddle一模一样。 接着就是丝滑流畅的torch.onnx.export加trtexec大法,去翻pytorch的issue,发现确实也有导出算子不支持的问题,但基本都是官方回复加入版本更新计划or最新版已解决。反观国产这边,paddle2onnx的open issue,怎一个呵呵得了,我推测是这个项目已经移除百度公司kpi考核任务了。遇到类似问题的小伙伴们,不想放弃训练好的模型的话就别傻等官方更新了,按照我这个方法来吧,顺滑程度超过你想象。 感谢paddlepaddle让我对国产开源的领悟又更上一层,怎么评价呢,一言难尽+尊重祝福吧。 |

|

我在用。 和pytorch区别不大,很容易上手;而且自带一套服务器和移动端推理部署引擎,性能感觉还可以。 paddle的模型库做的不错(比如paddleocr),比openmmlab的可读性强一点,也方便diy;还有很多本科毕设级别的小项目分享,对工作党项目前期快速开发比较合适。 缺点就是,文档烂的一笔,demo里很多接口文档找不到。。。越看越想打人。。。。。。 还有很多bug,比如训练停止进程不释放;训练结束自己从头又开始训练;训练过程中莫名卡住不动,也没有报错;推理时显存分配问题,占用过得显存不会释放;部分接口功能并没有实现,只是装装样子。。。。 |

|

最近两次使用paddle的经历让我不想使用这个框架了。 第一次是22年4月份,参加paddle的论文复现赛,把一个官方开源pytorch版本的骨骼点行为识别模型改成paddle就可以,修改代码确实没有什么难的,但跑出来结果就是比原pytorch版本结果低0.5%~0.8%。做精度对齐检查,发现前向过程结果一致,paddle的Momentum优化器跟pytorch的SGD优化器超参设置相同的情况下反向传播计算出来的梯度就不同了。后来因为其他事情没有再花时间调试这个比赛了,没深入分析是什么原因导致的。 第二次是22年11月下旬使用的,安装的是当时最新的paddle-gpu 2.3版本,写代码时遇到了切切实实的bug。paddle用于消除维度的inplace操作函数squeeze_(),会出现错误提示,导致代码停止,但是,操作的变量反而还正确把维度消除了!看代码: 以上代码运行正确,squeeze()操作是可以正常使用的,继续: 这里使用squeeze_(2)就报错了,错误提示维度参数2超过了最大维度?! 但是,再来看看aa的维度: 变量的维度反而是正确的结果,把原来下标2的维度消除了! 既然说超过最大维度下标,那要是用-1来指明最后一个维度呢?继续看: 这次没有报错,把最后一个维度消除了。 这个bug只出现在参数为最后一个维度下标的情况下,如果维度是[3, 1, 2]然后用squeeze_(1)就是正常的。 我在pytorch里经常使用类似的inplace操作,没有出现过这种bug,但是paddle里连这么常用的函数都会出这么严重的错误,发展了这么多年,真的不应该了。难道之前就没人发现这个bug吗?于是我去github上看了看paddle仓库的issues,找到了两个已经提过此bug的issues: 2021年2月,paddle 2.0.0 https://github.com/PaddlePaddle/Paddle/issues/30935 2021年8月,paddle2.1.0 https://github.com/PaddlePaddle/Paddle/issues/34589 回复都说近期修复,但是一年多了都没有修。刚才看了一下最近更新的paddle 2.4更新日志,貌似也没有提到修复此bug。 以前喜欢倒腾代码,后来做实验发现还是怎么方便简单稳定怎么来最省事,把时间放在调试这些不知名的小bug上不值当的。曾经我还想着好好学一学paddle支持支持国产框架,但现在被劝退了。Paddle我当前和未来的一段时间是不会再用了,至少在修复这个bug之前我是不碰了。 更新: 在paddle的AI Studio上试了试,2.5版本已经修复了squeeze_()的bug。感谢评论区大佬给飞浆的反馈。 |

|

更新一下之前OCR竞赛成果 单人参赛的(还撞了期末ddl),结果挺满意了 轻量级文字识别技术创新大赛 - 百度AI Studio - 人工智能学习与实训社区?aistudio.baidu.com/aistudio/competition/detail/75 |

|

|

|

|

|

去年(2020)11月开始用paddlepaddle,起因是百度的PaddleOCR PaddlePaddle/PaddleOCR?github.com/PaddlePaddle/PaddleOCR |

|

|

集成了基于two-stage(其实还有方向检测)的OCR模型,训练评估导出部署各种脚本都已经写好,准备好数据就可以直接用。而且代码风格很规范,可以较容易地修改一些模型和代码 这里证明一下,这个仓库是我后来开源的,但最近没怎么关注PaddleOCR更新所以仓库一直没更新新的功能,之后放假有空应该会更新一下 caopulan/PaddleOCR_Utils?github.com/caopulan/PaddleOCR_Utils |

|

|

刚上手的时候还是paddlepaddle1.8,现在都已经2.1了,代码风格基本和pytorch一致 后来看paddle文档的时候,发现有一个模型库: 模型库_飞桨-源于产业实践的开源深度学习平台?www.paddlepaddle.org.cn/modelbase |

|

|

但进去发现没什么模型,当时还想着肯定是paddle的开源环境不如一些主流框架,更新会慢很多,新一点的模型都没有得自己写。后来发现了这个: PaddlePaddle/PaddleClas?github.com/PaddlePaddle/PaddleClas |

|

|

才发现Github上PaddlePaddle这个账户下开源了好多基于Paddle的东西,内容非常全,而且得益于是国内的公司,所有仓库在Gitee上都有,只是可能更新不同步,但是同版本对应内容是一致的 而且用PaddleOCR的时候,我发现更新速度非常快,Issue的应答时间也有保证(得益于是百度自己官方的小组负责维护,如果是个人开发者的话一般Issue应答会慢一些) 最近也在做一些其他的项目,backbone部分采用了PaddleClas的代码,整体体验还可以 下面大概总结一下paddlepaddle的体验 写在最前:百度绝对对paddle是有野心的,并且下了血本 一、。生态环境 我认为paddle的生态和主流框架(以pytorch和TF为例)是不太一样的。 主流框架的生态是开发者主导的 生态环境得益于使用者数量大,比如一些新的作者没有给代码的paper有时候会有开发者在GitHub上进行开源 paddle的生态是百度自身主导 目前的状态还是基本由百度自己进行复现开源,比如我上面提到的PaddleClas,是百度自己的团队并且通过比如兴趣小组或者PPDE来吸纳一些个人开发者,但是主要地还是百度官方的团队(或者与百度有关的团队比如AgentMaker,这个组开始好像是基于兴趣组建的,但是现在应该跟百度是有合作的,百度也进行了一些推广) 两者我认为各有好坏 开发者主导的生态会更加“多”,一些可能没那么牛逼或者小一点领域的paper也会有开发者进行复现研究,毕竟百度不可能对所有论文进行复现 而百度自己开源的好处是代码风格稳定标准,代码几乎是没有bug的,至少是没有严重地结构逻辑bug(个人开发者在开源地最初版本有时候是有一些模型结构的bug),并且几乎都会给出预训练权重。但坏处也显而易见,基本只对一些热门的方向以及牛逼的论文进行复现。 二、使用感受 paddle和pytorch的代码逻辑是很相似的,百度在最初构建paddle应该也是大量参考了pytorch,我认为这一点非常好,极大减少了上手难度。 并且paddle1.x和paddle2.x没有像TF那样的及其明显的断档(我这里一定要吐槽一下TF,在2.x环境运行1.x代码简直是灾难级,改代码能改一年,你永远不知道一个函数在不同版本下的api是什么。至于为什么要在2.x运行1.x代码,因为30系显卡只适配cuda11+,而TF1.x不支持cuda11+,如果有小伙伴知道有什么办法可以在30系显卡环境下运行TF1.x请一定告诉我。30系显卡应该是装不了cuda10及其docker) 说到30系显卡和cuda11,这里还要强调下,paddlepaddle从我开始用以来,就没操心过cuda11这个环境 鬼知道我当初想要跑TF付出了多少努力 三、其他 免费算力真的很香,V100+32G显存,就是最近有时候需要排队(目前我最长没排队超过1天)。平常运行环境or参加一些比赛还送算力,不行还可以拿同学、家人的账号(嘘,我没有 doge) 前面基本都在夸paddle,这里也说一下我的担忧 开源的AI框架最后一定是要有活跃的社区,不能只靠百度本身的努力。说最简单的,想要paddle称为主流框架,你至少得有researcher在搞实验发paper的时候用paddle这个框架,而不只是百度跟在后面复现别人的论文。 简单点说,框架要想成为主流,要么占住学术市场,要么占住工业市场。现在paddle在学术这块可以说完全没有份额,在工业这一方面它完全只是依靠百度自己开源的一些项目来占住一定份额,但这肯定是不够的。而且paddle目前仅在国内占有一定市场,如果想要真的成为主流框架,必须要赢得全世界的开发者的青睐。 只能说拭目以待吧,据我了解paddle比起其他国内的框架算是比较优秀的,未来可期 (我都这么夸了百度能不能给我结一下钱,或者帮我认证下PPDE呗) |

|

最近被安利了,百度确实想把飞桨做成中国的安卓,很多配套任务的star都上千了,加上百度工业技术的积累,性能和稳定性都还好。如果百度持续投入个两年,个人觉得未来可期,感觉除了tf,掌握pp是不亏的。 |

|

23.08.29 更新 都散了吧,开始收钱了,我才是小丑。 |

|

|

原来16G的是每小时1点 |

|

|

现在开通付费服务,原来这几张卡都可以通过虚拟点卡兑换 |

|

|

我是小丑 跟实验室导师产生矛盾, 导师阴阳怪气用他服务器。 得, 自谋生路。 选择Baidu AI Studio, 免费算力。 之前会PyTorch, Paddle 驾轻就熟。 Github 上还有 常用模型的 Paddle 实现, 根本不存在问题。 效果和我在服务器上用PyTorch跑的效果不能说有偏差吧, 只能说一模一样。 |

|

飞桨做的很好,不过现在大多科研论文的开源代码是 pytorch 的,所以 pytorch 比较流行 如果大多论文代码是飞桨的,估计会很流行 |

|

求求了,paddle能不能把一些基础问题好好处理一下,数据集加载的dataloader内存泄漏,这么严重的问题竟然存在于稳定版本中,2.2.2.post111,不信可以去测一下,最新的稳定版,内存会一点一点泄露,直到oom。 paddle官网那么多的issue,希望官方引起重视吧,不要拿什么降低num of worker数量这种自欺欺人的方式修改。亲测,worker设置为1和设置为8差距大概是6倍左右。 因为这些比较基础的问题,不知道会劝退多少人呢。。。 |

|

有。 自从paddlehub上了stable diffusion之后,用户量猛增。 你知道我在说什么。 |

|

麻烦各位在公司用paddle的报一下公司名字,以后用产品尽量避开。生产上肯定一堆一堆的so依赖问题和内存泄漏问题。 |

|

不知道为什么大家对paddle这么大的恶意。 百度和百度研发团队是两个东西。 开源产品本来就会有很多问题,但是人家是开源的啊。 如果你不用,不提bug怎么迭代。 torch是好用,但是torch就没有bug吗? 上来就说拉黑这家拉黑哪家,搞的自己用torch就高人一等一样。 那我用paddle。用tf。用openmmlab 是不是搞你好几等。 工具就是工具 真拉黑建议把下面的企业拉黑。 应用案例_企业案例_飞桨-源于产业实践的开源深度学习平台 就是我,我已经准备逐步把我们小公司算法,全部用paddlenlp改了 无他,paddle要用就要用一套。 这一套用下来还是比较舒服的。 反正paddle就是莆田pytorch用起来也差不多 |

|

cpp运行不起来,paddle inference demo没有能运行的,文档和代码完全脱节。github上的issue无人问津,有很多甚至没有答复就给close了。加了个官方群聊,问个问题官方没人解答还理直气壮怼我,我反怼一句就被提出了群聊。。。 |

|

我用过paddle的ocr,整体效果还不错。另外我不知道这几几年的问题,paddle是支持pytorch新版本的,我可以用新版本跑。 |

|

都说paddle2.0抄torch的,其实很明显是抄tf2.0的(毕竟tf2.0也是抄torch的)。 为什么这么说呢?因为torch没有乱改API这个缺点,那谁有呢? |

|

在可自由选择的情况下谁会用? |

|

很多国产AI芯片跟PyTorch和TF不兼容。但是Paddle可以,至少可以兼容百度自家的AI芯片。有些地方可能只能用国产芯片,那么Paddle恐怕是唯一的选择。 |

|

都是冲着免费的V100和A100去的 前段时间不是一直看到新闻,PP框架已经是全球第一大了吗,用户全球第一。。。还有各种第一 如果是真的,那么你的问题就有答案了。 |

|

有一次准备分享DETR,读过其pytorch的源码,然后发现百度paddlepaddle里面的例子居然是一模一样的,就torch换了而已。 |

|

|

|

|

|

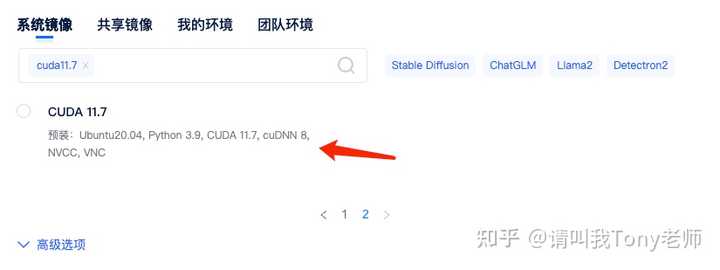

在安装 PaddleHub 导入的时候我们常常会遇到各种错误,不是这个包没这个模块,就是哪个包没这个属性,每次遇到都会很头痛,网上也没有 PaddleHub 和 PaddlePaddle 对应的版本,只能自己慢慢尝试,通过不断查错误找到最终能跑通的方案。以下是我们在进行尝试中的一些经验,希望对大家有所帮助。 安装 PaddlePaddle 和 PaddleHub 目前测试下来,最新兼容版本是:paddlehub 2.3.1、paddlepaddle-gpu 2.4.2 兼容版本所使用的环境是矩池云 CUDA 11.7 环境,预装:Ubuntu20.04, Python 3.9, CUDA 11.7, cuDNN 8, NVCC, VNC等。 |

|

|

租用机器的时候还可以在高级选项-自定义端口里添加一个自定义端口,用于部署 hub serving 服务。 |

|

|

启动机器后,打开 Jupyterlab,新建一个 Terminal,依次输入下面指令安装环境. |

|

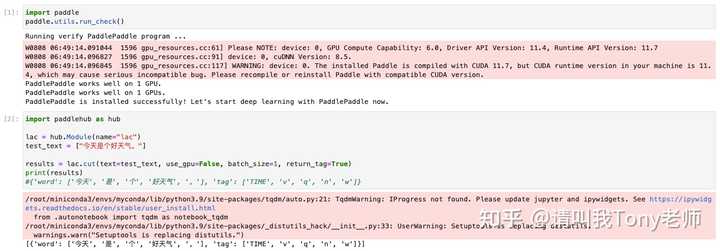

按以上步骤安装后 Paddle 相关包版本: 然后新建一个notebook,就可以正常使用了。 测试环境 |

|

|

部署 lac 服务并测试 Terminal 里输入以下指令启动 hub serving 服务,其中参数含义如下: -m 指定模型,测试使用的是 lac-p 指定服务启动端口,测试使用的是 5000 |

|

|

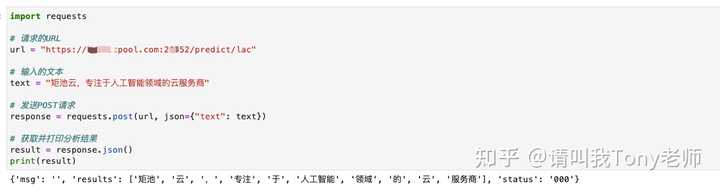

启动成功后,我们即可在本地使用代码调用云端部署好的服务了,测试案例如下: 其中请求的URL需要替换成你自己的租用页面的5000端口对应链接(token部分可以不要) 测试运行结果如下: |

|

|

更多疑问欢迎和矩池云小助手交流。 |

|

有一说一,好用。我是学生,而且是机电系的,和计算机的大佬相比是门外汉,我就说一些自己的体验。 我用过TensorFlow和Pytorch,目睹了tf从1.x到2.x的进步,明明在进步,但是用的人却越来越少了,pytorch在我刚上研一的时候没多少人用,到最后毕业的时候全是pytorch。一开始我是受了实验室师兄的影响,学习了TensorFlow,刚学没多久,他更新到了2.0,而且1.13版本和2.0版本根本不是一个东西,以前的代码全废了,我当时第一感觉是计算机的东西不都是高版本兼容低版本吗,谷歌也太差劲了。后来用了一段时间2.0,发现还真不错。我是一个面向github编程的菜鸟,GitHub上论文的代码实现都是pytorch,逼得我又学习了pytorch,因为我只会用tf实现u-net这样简单的网络,复杂点的实现起来总是出问题。pytorch的资源真的很多,API确实做的比tf好,tf的API有点乱,很多功能在Keras里有,在别的里面还有。不过我喜欢tf的原因很简单,第一,tf是初恋,真的是tf让我了解到深度学习,我一个菜鸡也能实现深度学习,真的很有成就感。第二,说出来很丢人,因为tf的卷积操作padding参数里可以选择‘same’,pytorch却不行,我一个门外汉就喜欢傻瓜式的东西,哈哈。 和paddle结缘是因为自己小创新了一个网络,在tf和pytorch都能实现,但是训练一直出问题,我是真的找不到解决方案,后来实验室师弟给我说paddle有专门的群,你出问题去群里问有人回答,我就用了一天把tf的代码重新写成paddle的代码。说实话,有了tf和pytorch的学习经历,几乎能裸上手paddle,paddle和pytorch很像。结果问题就解决了,后来为了做对比实验,我了解到了paddle竟然有可视化的训练界面paddlex,真就初中生都能训练网络了,真把深度学习这种高深的东西带入寻常百姓家,所有人都能训练网络,都能享受实现深度学习解决问题带来的快乐。 后来了解的更多,paddle的产品确实很丰富,覆盖很全,极大缩短开发使用时间,而且文档都是中文的,例子也有,很容易看懂。不瞒大家说,我是个985的硕士,但是英语水平可能还没有上海这种发达地区高中生的水平高。 我还记得我在github上提交过问题,paddle团队很快有人就回答了,解决问题之后,我给他们回复了一句话,paddle团队在做一件伟大的事情。今天我依然是这个观点,百度这个公司确实有很多黑点,但是paddle团队却在做伟大的事情,美国人有tf、pytorch,中国人有paddle。 |

|

最近刚写完毕设,可以来好好的回答一下这个问题。其实最开始的代码框架用的pytorch,后面发现自己的机子跑模型实在是太慢了,然后就改成了paddlepaddle(可以白嫖GPU,前后用了大概700个小时的GPU吧,也没仔细算,香爆了)。刚开始上手其实还算可以,每次遇到想用的函数去paddle文档查一查就可以得到了。但是paddle还是有一个很大的问题,就是生态不是特别好(使用的人不是特别多,导致有些问题无法通过浏览器查到,而且paddle的模型库不是特别完善,像一些densenet,efficientnet之类的都得通过别人项目去实现)。不过,毕竟可以白嫖GPU,还是挺爽的。特别是把舍友不用的号一起拿来跑模型,出结果也快特别多。 |

|

“高算力+先进算法”创新模式将为下游芯片及应用开发商创造全面优化的解决方案 中国北京,2022年5月20日 – Imagination Technologies在今日隆重举行的“Wave Summit 2022”大会上宣布:携手百度飞桨(PaddlePaddle)及多家合作伙伴共同发起“硬件生态共创计划”,利用自身的优势技术和市场应用经验共同构建高效的软硬一体平台方案,将百度飞桨软件的先进算法和灵活性与Imagination异构计算IP技术相结合,支持下游芯片及应用开发商在此基础上快速创建全面优化的解决方案。 随着人工智能技术在各行业的广泛应用及快速发展,业界已从各自独立的硬件算力驱动和算法创新驱动进入到算法和硬件协同创新阶段。在硬件生态共创计划中,双方基于百度飞桨(PaddlePaddle)对未来硬件计算平台的需求,结合Imagination (GPU, CPU, AI)异构计算IP技术,从算法模型到计算框架再到半导体IP技术通过联合优化的方法,构建高效灵活的软件栈方案,为芯片厂商提供设计指导和Benchmark参考。 面向行业应用共建Model Zoo,为平台和终端客户提供参考方案。这种全新的生态合作模式将为双方的客户及合作伙伴带来更多价值。未来,双方将面向使用Imagination NC-SDK的飞桨开发者共同开发培训课程,进行联合培训认证。 |

|

|

Imagination计算业务副总裁Shreyas Derashri表示:“很高兴能够与百度飞桨及众多合作伙伴再次携手,发布‘硬件生态共创计划’,并为业界构建软硬一体的计算方案。2020年,Imagination加入百度飞桨硬件生态圈;2021年,Imagination和百度飞桨在全球人工智能(AI)生态系统方面开展合作。此次合作是双方良好合作的延续,在算力和算法方面优势的深度融合,可为行业提供更优化的解决方案。” 百度飞桨产品团队负责人赵乔说道:“Imagination作为全球领先处理器技术和IP供应商,对百度飞桨在技术和生态系统方面都给予了极大的支持。很高兴这次双方能够在众多AI应用领域进行合作,可进一步发挥百度在深度学习框架、算法、开放平台等方面的领先优势,并在这些领域更好地支持下游客户。” 关于Imagination TechnologiesImagination是一家总部位于英国的公司,致力于打造半导体和软件知识产权(IP),使客户在竞争激烈的全球技术市场中获得足够优势。公司的图形处理器(GPU)、中央处理器(CPU)和人工智能(AI)技术可以实现出众的PPA(功耗、性能和面积)指标、快速的上市时间和更低的总体拥有成本(TCO)。基于Imagination IP的产品被全球数十亿人用于他们的手机、汽车、住宅和工作场所。 更多信息,请访问:https://www.imaginationtech.com/。 关于百度飞桨飞桨(PaddlePaddle)以百度多年的深度学习技术研究和业务应用为基础,集深度学习核心训练和推理框架、基础模型库、端到端开发套件、丰富的工具组件于一体,是中国首个自主研发、功能丰富、开源开放的产业级深度学习平台。目前,飞桨已凝聚406万开发者,基于飞桨开源深度学习平台创建47.6万个模型,服务15.7万家企事业单位。飞桨助力开发者快速实现AI想法,创新AI应用,作为基础平台支撑越来越多行业实现产业智能化升级。 更多信息请访问:http://www.paddlepaddle.org.cn。 |

|

最近再用,作为知识储备,2.0之后,个人觉得还不错,虽然跟torch还有些距离,不过毕竟是国产,慢慢发展。 当中美开战的时候,paddle必将称王。 推一个自己开源的paddle项目吧,如下: |

|

首先,飞桨2的使用方法与pytorch非常像,上手容易,体验好 其次,飞桨提供免费的GPU,就凭这一点也要去学飞桨 最重要的是,飞桨官网的服务器是设在国内的,对于我这种不会科学上网的人来说简直不能拒绝,毕竟练到pytorch官网的网速实在感人 此外,飞桨的中文api文档做得肯定比国外的框架好,至少适合人类阅读 |

|

之前在百度,当时正在推飞桨,只记得强推了半年,大家还是用tf比较多,文档太匮乏,出了问题,很难排查…不过写飞桨的成员都很厉害 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |