| |

| 首页 淘股吧 股票涨跌实时统计 涨停板选股 股票入门 股票书籍 股票问答 分时图选股 跌停板选股 K线图选股 成交量选股 [平安银行] |

| 股市论谈 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 商业财经 科技知识 汽车百科 工程技术 自然科学 家居生活 设计艺术 财经视频 游戏-- |

| 天天财汇 -> 科技知识 -> 为什么显卡不用大小核?毕竟现在手机,平板,电脑,CPU都是大小核结构了? -> 正文阅读 |

|

|

[科技知识]为什么显卡不用大小核?毕竟现在手机,平板,电脑,CPU都是大小核结构了? |

| [收藏本文] 【下载本文】 |

|

为什么显卡不用大小核?毕竟现在手机,平板,电脑,CPU都是大小核结构了? 关注问题?写回答 [img_log] 手机 中央处理器 (CPU) 平板电脑 显卡 电脑显卡 为什么显卡不用大小核?毕竟现在手机,平板,电脑,CPU都是大小核结构了? 圆桌收录 数码盐究所 #生产力焕新指南 |

|

大概是因为显卡的流处理器已经够小了…… |

|

|

|

|

|

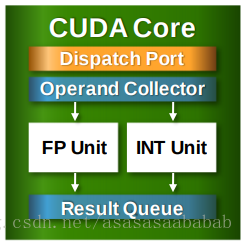

流处理器内部连缓存都没有,全是计算模块,所以饶了它吧 |

|

显卡的流处理器可以理解为一大堆的超级小核 |

|

|

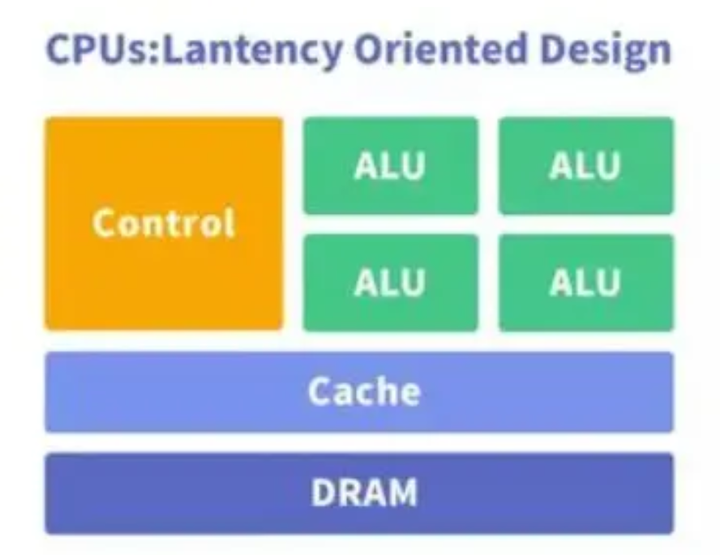

而CPU的一个核心规模要大很多 |

|

|

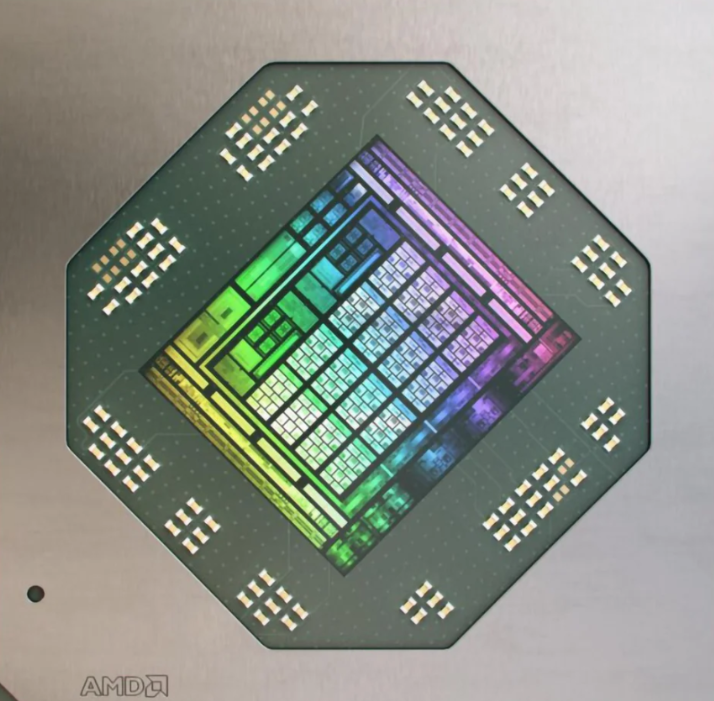

如果觉得这两张图不够明了,那就落实到实物,来看Zen4核心对比AD102核心的图,这两个都是台积电5nm节点的芯片 这是一张AD102核心的图: |

|

|

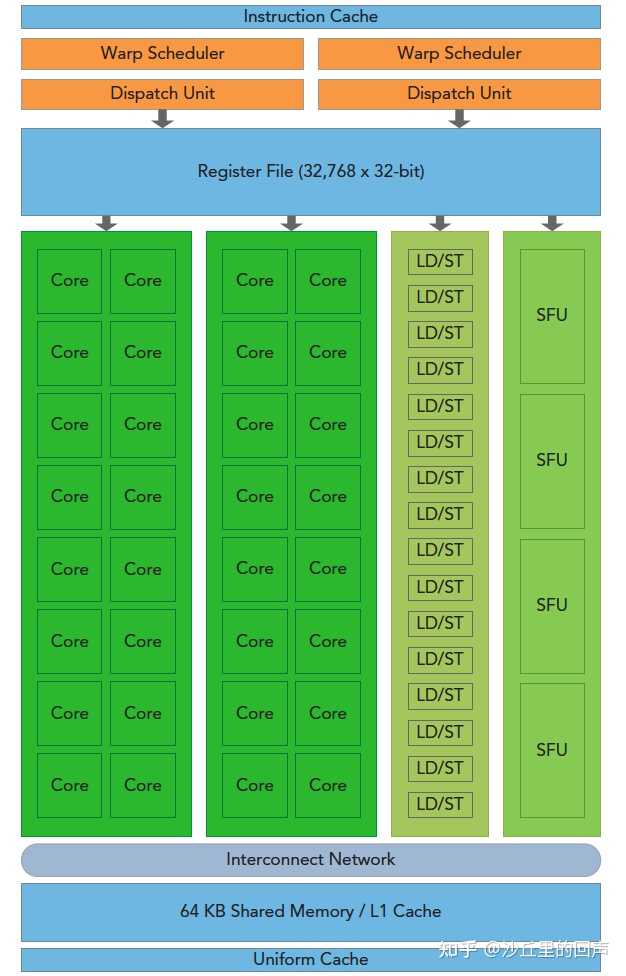

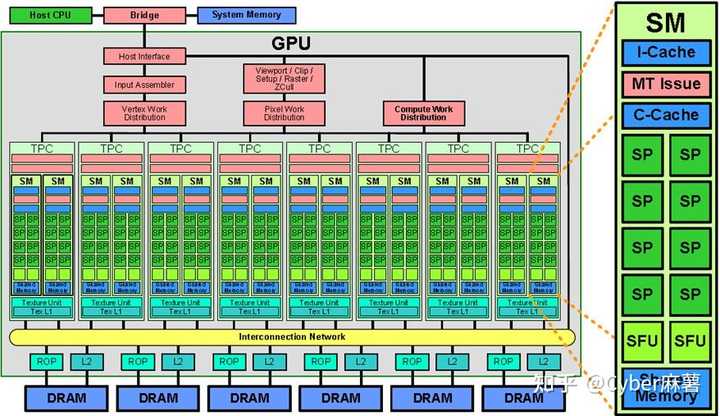

AD102核心面积为609mm2,拥有12个GPC,72个TPC,144组SM单元(4090仅开启128组) 而每组SM单元里是这样的: |

|

|

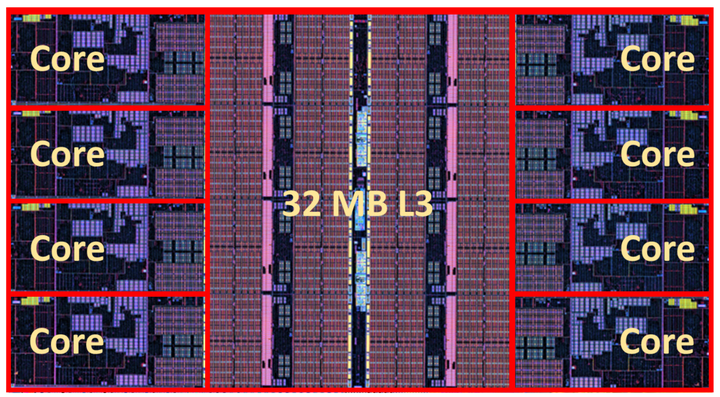

也就是说一组SM单元里有128个FP32单元,即128ALU,也可以叫128CUDA 所以我们平常说的显卡多少多少流处理器单元,基本上说的就是这种SM里面的单个ALU数量 单个ALU的面积大概是一组SM的2%左右的面积,而AD102核心拥有144组SM,总面积609mm2 算下来,一组SM单元的面积大概是1.1154mm2,而单个ALU的面积约为0.00218mm2 这面积非常非常小,而CPU呢? 这是Zen4单CCD的切片图: |

|

|

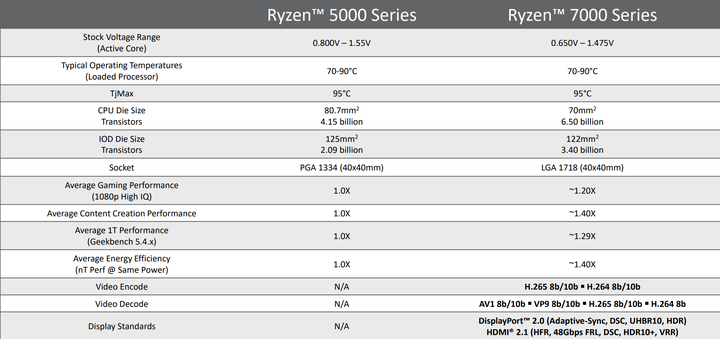

在AMD官方的文档里,Zen4单个CCD面积为70mm2 |

|

|

所以哪怕我们不看L3,单个核心的面积也差不多达到了4.79mm2 |

|

|

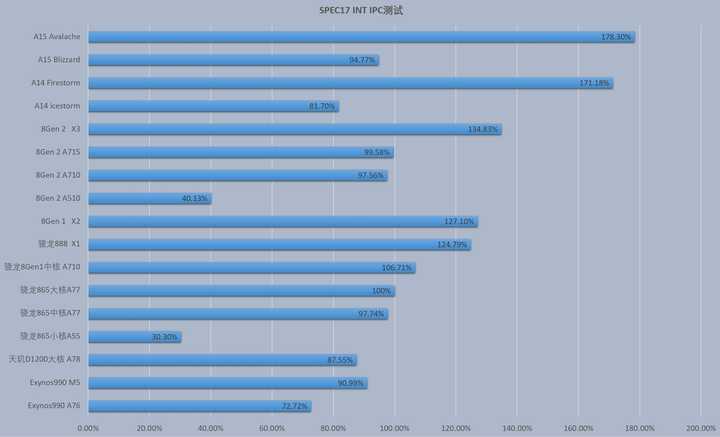

这样一比较起来,是不是很直接就能看得出来,一个CPU的核心面积要远比一个显卡所谓的流处理器大得多? 所以说显卡那庞大的流处理器规模如果单个来看,相较于CPU单个核心来说其实都是一堆性能极低的计算单元,跟它相比,A55都能算超巨核了,只不过GPU拥有极其庞大的流处理器规模,并行计算性能非常强悍 CPU内部的流水线复杂度远远超过GPU,在逻辑控制和缓存部位堆了很大的空间,CPU需要很强的通用性来处理各种不同的数据类型,同时逻辑判断又会引入大量的分支跳转和中断的处理 而GPU面对的则是类型高度统一的、相互无依赖的大规模数据和不需要被打断的纯净的计算环境 CPU什么都能做,但是规模小,GPU规模大,但是对处理问题的逻辑复杂度有要求,并且还要求数据对齐 CPU之所以会有大小核的架构设计,是因为要面向不同的使用场景,比如说手机端的大小核,大核负责高性能爆发,而小核则负责一些低功耗应用场景 因为手机、平板属于对功耗要求极其敏感的场景,要是持续功耗提升20%,那对续航的影响都是非常显著的 苹果和ARM公版的小核都属于功耗很低的存在,基本上跑满也都是零点几瓦的存在,只不过苹果的小核IPC是ARM公版小核的好几倍 |

|

|

整数IPC能接近公版的中核水平,ARM公版的小核就只有低功耗这一个可取之处 而Intel采用的大小核设计是为了提高单位面积的更强的多任务处理性能,现在大家基本都知道Intel这个小核其实算不上省电,但性能也比公版的强很多,可以达到大核的1/2左右水平 |

|

|

四个小核一起上综合性能要超过一个大核开超线程的性能,这就是Intel想要的效果 AMD的小核面向的用途也是类似,少核的用途都是频率更高的大核上,需要更多核心数的时候小核再来帮忙。 顺带一提,像苹果会把自己的GPU簇叫核 |

|

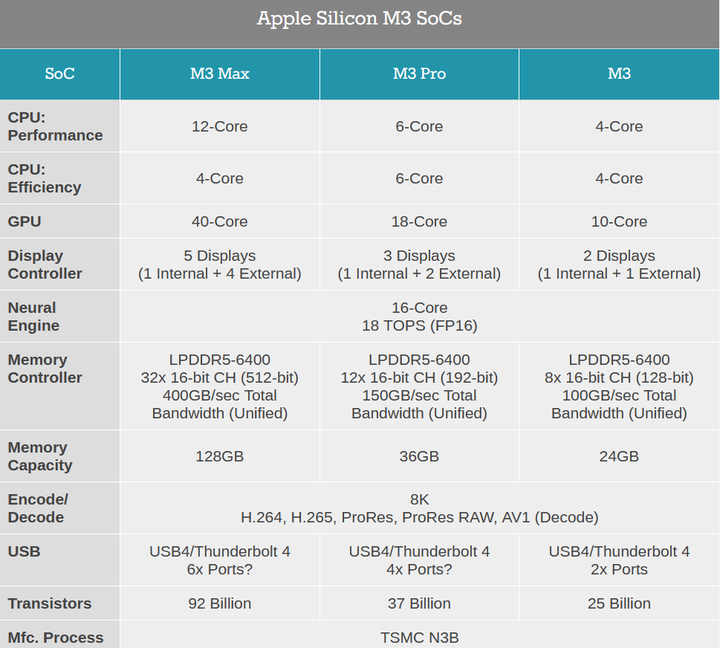

|

比如说M3 Max的GPU会说40核,其实这个“核”的说法类似于前面AD102里面的一组SM单元,和CPU的多少多少核是不一样的, M3 Max是40组GPU簇,共计5120ALU。 |

|

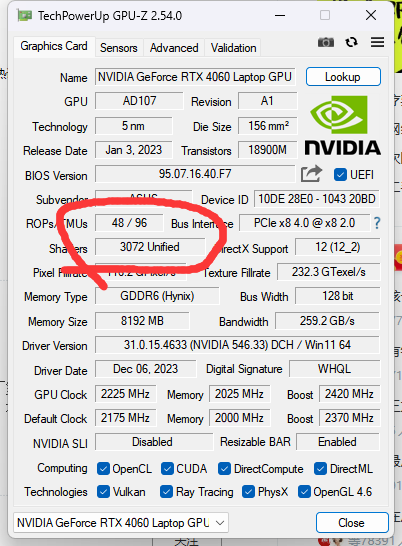

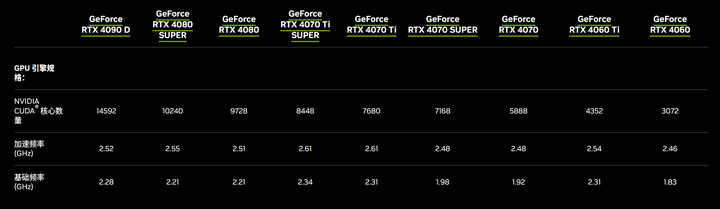

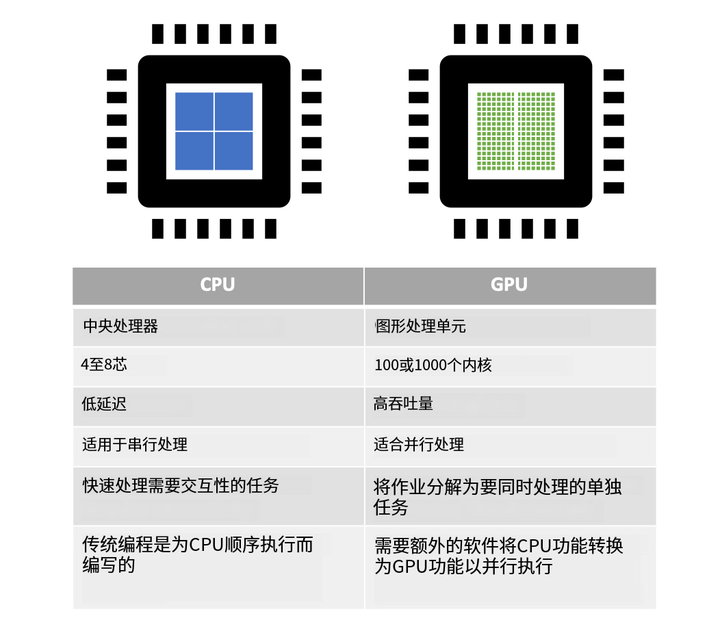

CPU和显卡的工作逻辑不同 CPU往往做的是比较复杂的逻辑运算,而显卡做的大多是通用计算。 曾经有一个比喻非常恰当: 让一个博士生做1+1=2 ,做上个1000道题 和让1000个小学生做1+1=2,每人一道提,你觉得哪个算的快: 这1000个小学生就好比显卡的工作逻辑。 显卡中一个最重要的指标就是流处理器的数量: |

|

|

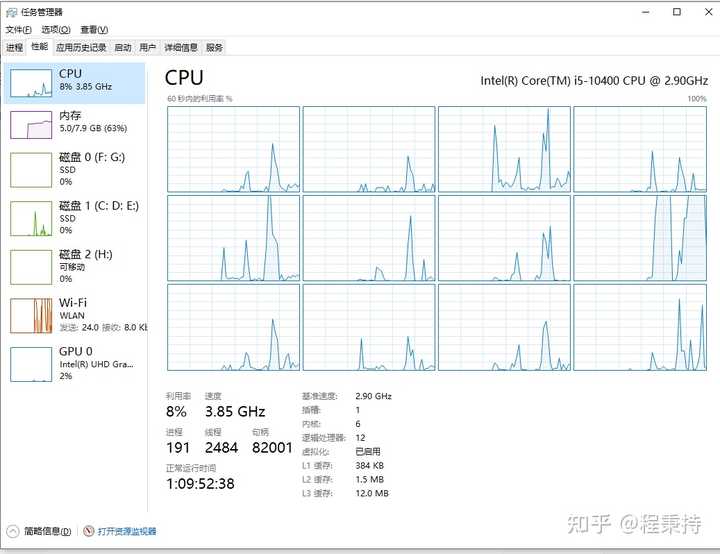

比如我这台4060 laptop就有3072个流处理器,你可以看作这全是小核。 在面对需要单精度计算并且大量的重复计算的过程,流处理越多的显卡计算能力就越强,而显卡处理这类任务的效率也要比CPU强的多。 CPU不同,CPU可能同一是时间内需要处理很多复杂的多任务,比如你的电脑开着,你一边看网页,一边挂着QQ微信和人扯淡,那边还听听着音乐。 |

|

|

这些任务的负载不尽相同,CPU采用大小核的设计,可以让多任务并行的时候,关键任务调用大核,小任务用小核类似的逻辑来优化能耗比和更好的发挥性能。 而显卡不需要,换句话说,显卡拿的是牛马剧本,就好比一个上万人的车间流水线,里边上万的工人一天到晚就干拧螺丝一件事,那么一天下来产出的量是惊人的,而这个时候也不需要这些工人会什么别的技能,你就把螺丝拧好,换句话说,你的脑子够拧螺丝不出错就行。 这种情况下,全小核堆数千个流处理器然后一起干活,现在单位时间内能输出更多的内容。 显卡的工作原理就是这样的。 再举个例子:显卡一般都是进行图形相关的输出运算的,那我们来拿图说事: 每一张电子图片呈现在现实设备上都是一个一个像素点组成的色块: |

|

|

显卡在生成这样的图像图片的时候,每一个流处理器负责生成这么一小个色块,最终渲染生成的越来越多: |

|

|

然后最终不同颜色的像素点生成一张图片: |

|

|

让每一个流处理器同时生成这种色块,那么数千个处理器一起生成加起来的色块就是一张图片了,画面最终就是这么渲染成功了。 给显卡用CPU大核那样的规模,属于大炮打蚊子,用不上,一台显卡也不可能有数千个大核,那就真成战术核显卡了。功耗上天。 |

|

因为计算的需求就不大一样导致的架构以及规模也不一样,大小核为的是什么?理想的大小核,调度有度的情况下应该是: 小核负责低负载工作,大核负责高负载工作在必要的时候大小核一起工作来增加多核性能 这样的好处一个是低功耗,因为小核功耗小,在台式机上其实这个功能并不是重点,只能算附加收益。所以PC端的“小核”并不是像手机那样小的小核。 真正的目的还是为了实现更多的核心可以同时参与计算。毕竟对于一颗芯片来说,面积可谓寸土寸金(甚至比字面意义的金还贵),所以如果小核多一些,就可以多放上去一些。比如下面的i9 13900K,1个P核就占用了接近4个E核的面积。 |

|

|

i9 13900K的布局图 在计算机系统里,CPU就像是一个全能的教授,他可以完成一些复杂的内容,比如复杂的控制逻辑、串行的计算任务等等,他都能够胜任,而GPU,就像是一大群高中生,他只能做简单的计算,比如做做浮点计算,虽然并不能实现CPU的解决问题的能力,但是如果你要算的东西是“重数量不重难度”,那么一群高中生就是会比一个教授算的快(8个教授vs.1000个高中生)。所以CPU只能是尽可能的增加一些小核心,增加绝对数量,一定程度上缓解大核心数量上的瓶颈。 如今的调度问题也只是暂时的,从AMD未来也会搞异构就知道这个东西它确实是有用的,甚至至关紧要的。(多吐槽一句,调度问题有一大半需要巨硬来背锅,毕竟硬件本身是被调度的一方,而巨硬重心都在Win12) 所以GPU恰恰最不缺的就是所谓“多核性能”。按照流处理器算,这就是GPU不需要采用大小核的核心原因。如果对比的话,别说价格高昂的RTX4090了,即便是和同代i9价格相近的RTX4070,CUDA核心也有5888个。 |

|

|

而且你也可以明显地看到,核心数量本来就是显卡区分高中低端的最主要因素之一。 延展一下话题,刚好AMD的例子可以近似的视为题主提到的“小核”,AMD和Nvidia在设计上就完全不同,过去AMD的老架构GCN是每4个核心一个逻辑控制单元,所以虽然数字很大,但其实两者不能完全直接对比(Nvidia的CUDA核心是每个核心都有一个逻辑控制单元)。到了如今的RDNA架构,虽然已经有了很大变化,但是这种“异构”依然得到了保留。 |

|

|

|

|

首先显卡主要是小核心流处理器,基于浮点FP32精度,而且这个小核心数量极其庞大: |

|

|

以40系列最低端的都包含了3072个,相比CPU的核心数量,不说遥遥领先那完全是压制。 可是为什么显卡要这么多核心数量呢? 而且看起来好像越多越厉害(也不是,有上限,带宽限制了),这个就需要了解显卡的工作原理了。我很久之前写过一篇回答,你可以参考扩展阅读下,能帮你理解原因: 显卡是什么,显卡怎样工作,显卡影响电脑的哪一项功能?470 赞同 · 35 评论回答 |

|

|

由于分辨率越高,像素密度也越大,需要处理的图形就更多了 |

|

|

上面这种是一张模糊的图,缩小以后反而可以更好的看清楚更多的内容,本质上这4张不同大小的图,对于显卡来说算力输出是一致的;但是要把最小的那张图放大且提升清晰度,那么算力就会越来越高。而且刷新率越高这种算力的需求更大,也需要更大的显存: |

|

|

可能这时候你还是不理解,我给你准备一张动图,当我们用显卡渲染的时候,它是一小块一小块的工作的,如果核心数量越多,就可以更多的并行计算,这样速度就更快: |

|

|

上面这种是C4D出血高精度渲染,所以精细度很高,所以很慢,因为慢也正好让你看到它的工作流程。而我们的图片就不需要这样的渲染,直接输出就完事了,所以这事CPU和集显都能做;但是如果我们玩游戏,那么这个需求就上来了,所以需要几千个小核并行工作,才能做到实时输出,高达60帧以上让画面看起来十分流程,甚至能达到2000帧以上的能力: |

|

|

比如上面这个微软纸牌能60FPS就行了,完全没有必要这种蛮力干到2065FPS,只会徒增功耗。这也可以看出来上千个小核的显卡是力大砖飞。 为什么力大砖飞呢? 因为GPU不做复杂的工作,它的工作极其单一,只是确保分辨率下的每一个像素输出颜色;能力越强支持的分辨率越高,越能感受到的渐变的差异;能力越强也能支持更高的刷新率。 所以啊,它就用小核心就够了,小核心不需要多高的频率。 你换成大核,它用不上啊 它只是用不上啊,用不上就等于是浪费了,但是CPU的工作正好相反,它就需要做极其复杂的工作,所以更多的追求主频越高越好,在能保证稳定工作的情况下,自然也是核心越多越好。 但是嘛,发展都会有上限和瓶颈,需要不断的突破,但是这个突破你得搞清楚原理。 否则就会有这种看起来很开智的想法,实际呢方向已经错了。 |

|

首先存在≠合理,至少对消费者来说 先说大小核的出现是为了什么。大小核首先是出现在移动端设备上的,也就是arm平台,这类平台有一个特点就是要求功耗要低,但是又有一定的性能需求,怎么办呢?所以有了大小核,有性能需求的任务交给大核跑,一般任务给小核跑 总的来说大小核的存在就是在一定性能要求下解决功耗问题而存在的 那为什么这玩意会被搬上电脑cpu呢?这里就不得不提到当年amd5000系和intel10代、11代cpu之间的神魔大战。下面开始岁月史书 intel在pc端cpu市场上面端坐了好多年嘚瑟了,8代开始就挤牙膏,每一代都只有一点性能提升,依然压着amd打。直到10代的时候,amd5000系出来了,全系暴打intel10代,5800x能直接干掉i9,多核性能上面intel输得一塌糊涂,只能靠单核的一点微弱优势撑撑场面 intel急了,于是重磅推出了11代处理器,然后依然被暴打,是牙膏挤多了导致的,跟不上amd大跨步。当年的5950x是pc端的天花板,5600x是性价比神u,intel全系都是依托答辩。不得不提的另一点就是amd的核显,居然有1060的水平,这段时间是a家打得i家找不着北,最扬眉吐气的一段时间 intel发现自己已经无法通过正常的军备竞赛战胜amd了,而刚好此时又恰逢手机cpu井喷式发展时代,前有骁龙870后有麒麟9000,此时intel想到了一个歪门邪道,既然你大小核是在一定性能下能做到降低功耗,那么我是不是也可以用大小核的架构,在一定功耗的情况下提高性能? 于是,人类cpu发展史上,最黄金的一坨答辩,大小核桌面端cpu,诞生了! 岁月史书到此为止,后面大小核架构就成了intel的主流架构持续至今。但这东西也有广为诟病的一点,那就是,你intel确实做到了,一定功耗下,依靠大小核,性能提升了,可是我干活不是跑分,你光跑分高有什么用?我在处理高性能任务的时候,肯定是cpu全核跑满的,然后你告诉我那几个拉后腿的小核是个什么玩意?光跑分有啥用? 大小核是强依赖于任务调度的。手机平板上面的任务调度很好解决,毕竟用户当前屏幕下的应用就是主任务,跑在大核上,后台应用就是不重要任务,跑在小核上。你电脑怎么解决这个问题?电脑一个大屏幕可以同时开多个应用,我一边逛知乎一边刷b站同时还有个前段html的测试在跑,我后台开了个网易云听歌开了个百度网盘在下载,同时开命令行跑了一个深度学习模型训练,那边还有一个vscode上面远程连了一台服务器在跑程序,这边开了个模拟器刷手游,我还挂了个星穹铁道刷材料本,你是什么顶级智能的调度算法,能分辨这些任务的轻重缓急? 大小核刚出的时候,这些问题都是灾难性质的,现在调度算法你别看他吹自己已经有多厉害了,但是这些问题是注定无法解决的,我上一秒觉得训练模型是重要任务你要分配大核去跑,下一秒我发现星穹铁道卡得不行了你也要分配大核去跑,什么调度算法能预测到我的心理活动?所以,我遇见的所有重度生产力用户,除了一些做量化交易的需要高性能单核用intel i9超频超成灰(直接把小核全部屏蔽掉,只用八个大核),其他的清一色amd全大核处理器 退一万步讲,你就是说笔记本电脑有个功耗需求,把大小核搬上去,也能理解,但是pc端,你跟我讲省电,你搞笑呢? 咳咳,上面讲这么多,主要是在回复一个问题,那就是,手机、平板、电脑,cpu都是大小核架构,这件事本身是一件不合理的事。对前两者是合理的,对后者是不合理的。或许现在很多普通用户已经感知不到大小核调度的问题了,但是对于生产力用户,这些问题就是存在,就是理论上没法解决,就是必须要纯大核才行 回到问题,为什么显卡不搞大小核?首先搞清楚显卡是什么架构,显卡是全小核架构,应用场景为超大规模的并行计算,而不是单个复杂任务,你可以理解为一万个小学生算加减乘除,显卡的压力来源于小学数学题太多了一万个小学生做得还不够快,而不是题目太复杂了小学生解不出来——那根本不是显卡的任务。限制功耗吗?不限制。任务复杂吗?不复杂。那为什么需要大小核的架构?大小核架构和显卡面临的任务场景可谓是风马牛不相及,答案显而易见了 |

|

显卡的功耗压力比手机,平板,电脑,CPU的功耗压力都大,目前的“全小核”设计,已经是目前情况下的最优解。 CPU的大小核结构理论上是不错,能够平衡处理器的性能和功耗,尽可能地降低、控制处理器的整体功耗。但实际情况用下来,也不一定最佳。在英特尔的12代酷睿处理器诞生后,其性能+效能核心的大小核设计看起来非常好,但实际上也有一种传闻,就是大小核设计在游戏中会存在大小核心分配任务翻车的情况。使得不少用户不得已在BIOS中关闭了小核心,据说游戏性能会更强更稳定。 |

|

|

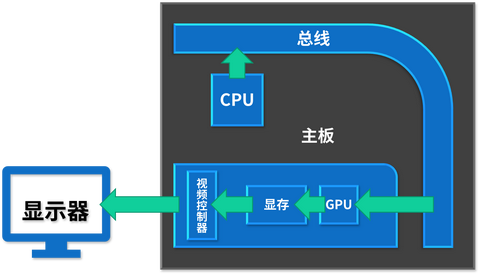

显卡的无论是玩游戏还是作图的时候,3D画面都是由一个又一个像素点组成的,而流处理器就负责这些像素点的渲染工作。当年,掌握计算机行业第一话语权的微软,首次在DX10的构建中提出了统一渲染的概念,作为图形处理器的制造厂商,无论AMD还是英伟达,势必要调整研发思路,由此出现了专门的统一的渲染计算单元,即SP流处理器。流处理器英文拼写为“stream processors”,缩写为SP,它还有很多个名字,比如渲染管、着色器等。 |

|

|

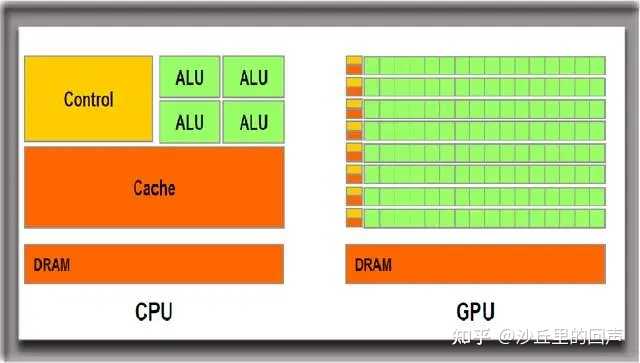

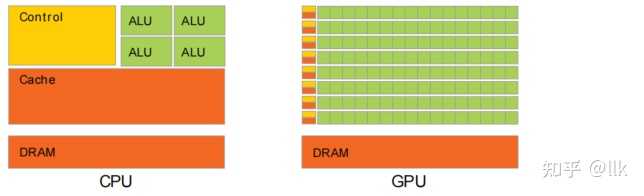

CPU是由专为顺序串行处理而优化的几个核心组成,而GPU则测试由几千个的更小、更高效的核心(专为同时处理多重任务而设计)组成的大规模并行计算架构。使得GPU更擅长对大数据进行简单重复操作。很多的小流处理器感觉就像蚂蚁在搬大象一样,数以千计流处理器的共同协作,合力来搬动一个大物体(大图像)。但它们只需要搬大象就行,并不需要去干别的什么事情,所以分配工作任务就很简单了(CPU就要面对更多的情况,分配任务更难),因此这样小而集群的工作方式,对他们来说是最好的。 |

|

|

GPU相比于CPU,GPU具备更多的计算核心和更高的并行计算能力,因此能够在同样时间内完成更多的计算任务。我们可以开启GPU加速利用了GPU的并行计算能力,将计算任务分配到多个计算核心上同时进行处理。与传统的CPU串行计算相比,GPU加速可以大幅提高计算和渲染的速度。尤其是在涉及到大规模的数据处理、复杂的图形染以及机器学习等领域,GPU加速更加显著。 |

|

|

GPU相比于CPU不同的工作方式,决定了他们采用不同的结构。 |

|

显卡这种玩并行计算的搞大核干啥?谁家软件对GPU有单核任务?都是大规模并行计算,要玩非并行的单线程任务为啥不交给CPU? |

|

传统游戏显卡是全小核处理器,传统游戏显卡是全小核处理器,传统游戏显卡是全小核处理器。 NVIDIA和AMD这两个显卡厂家正在给IDC专用的AI计算卡绑定ARM/ZEN4C核心,这样的IDC专用的AI计算卡计算卡变成了大小核处理器。 如何看待AMD发布Instinct MI300X GPU芯片?是否在大模型时代威胁Nvidia地位?254 关注 · 35 回答问题 |

|

|

|

|

|

|

|

首先,GPU能做的事情CPU都能做,倒过来就不行。 第一个GPU是NVIDIA 发明的,geforce 256问世之前显卡早就存在,只是没有明确的“图形处理器概念”而已。在GPU还没深入被拿来计算其他事情之前,他就是CPU的协处理器,用来辅助CPU进行浮点预算——浮点计算顶点和像素着色,这是实时渲染的3D游戏引擎最核心的任务。 如果没有显卡, 纯拿CPU计算,也是可以玩儿游戏的——事半功倍就是了,linus曾经尝试把孤岛危机初代完全放到threadripper 的5950x里运行,渲染速度甚至达到了“勉强能玩儿”的程度。 |

|

|

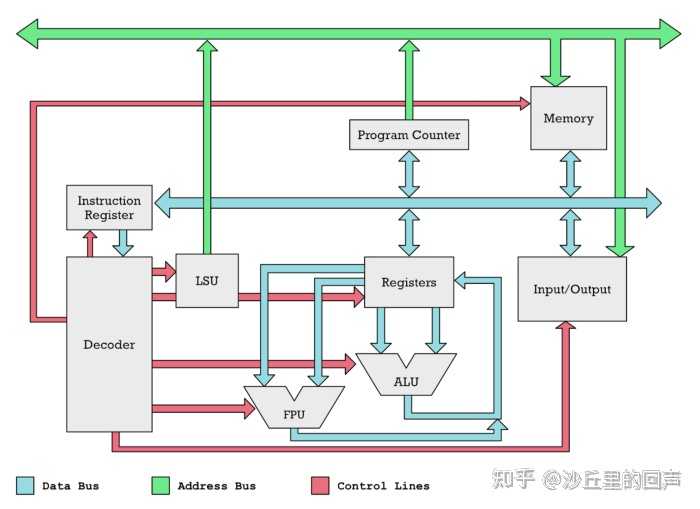

其次,CPU的注重逻辑计算,显卡注重并行的渲染。 CPU和GPU结构中都存在ALU和FPU(CPU内的FPU是486时代收纳进来的),分别计算整数和浮点,但GPU主要的任务是大规模的浮点计算并行,单一浮点单元只能处理特定精度的数据。 CPU的结构图画出来,是大量的缓存和控制器,用来协调ALU和FPU整体计算复杂维度的数据,数据主要是串行的(后来有乱序发射),负责整数的ALU面积没有浮点的FPU面积大。GPU的结构图画出来,清一色的简单FPU+简单ALU组成基础的流处理器(CUDA单元或者叫SP单元),负责控制的逻辑电路只有很小一部分,同时挂靠大量的流处理器。CPU核心对应的概念比流处理器要复杂很多,定位大概相当于一组流处理器(NVIDIA的SM单元,AMD的CU,苹果的多少图形核心)。 |

|

|

|

|

|

|

|

|

最后,CPU的大小核是两种核,出于能耗和面积进行妥协。 在目前的制程和架构限制下,Intel 的ring通讯总线下挂靠核心数量太多会导致效率下降;intel的mesh 通讯总线下,核心数量可以扩张得更多,但大核能耗比爆炸,非计算场合的性能也不够好。 所以Intel 引入削弱了逻辑控制和缓存的小核心,用来在消费级处理器上节省ring总线通讯节点,同时节省晶体管数量、降低绝对能耗,在总能耗固定的前提下提升整体多线程性能。 平板和手机都是同一套ARM体系,最早就是在为了限制功耗无所不用其极的嵌入式领域卷出来的,大小核一开始就是奔着在最低的功耗下提升整体的方向优化的。 GPU 不需要两种“流处理器集群”,因为他要的就是并行化,没有可以靠削弱“逻辑控制单元、缓存和分支预测所用的晶体管”来降低能耗、面积的余地。流处理器本身的结构都是非常迷你的,组成流处理器集群的架构天然就是简单粗暴的(对应CPU来说),砍无可砍,削无可削(也可以削FPU双精度的单元配比,这是游戏卡和计算卡的区别,但这两者不需要混在一起)。 |

|

前有珠玉,通过显卡和CPU的架构讲解了,那不妨用一些更简单更直白的语言让小白可以入门。 因此本文是科普向,不硬核,成人版十万个为什么。 以前有个特别好的比喻,来讲为什么GPU可以挖矿,而CPU不行,其实这个问题放在这里也很适用。 CPU面对的是复杂,多样化的问题,因此每一个核心可以理解为一位教授。 |

|

|

什么叫大小核心呢? 复杂问题交给教授,不那么复杂的交给研究生们处理。这就是性能核心(P核,大核),和能效核心(E核心,小核)。举个例子,英特尔13500F,现在非常主流的一个CPU,6P+8E,一共14个核心。 |

|

|

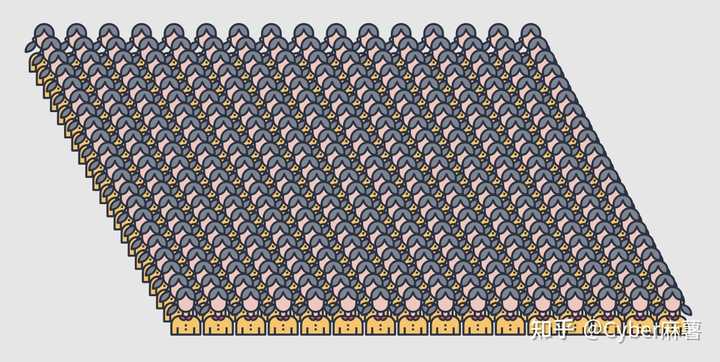

对于在前台,需要大量运算的,交给性能核心,也就是大核心来做,后台服务,或者是计算器这种小玩意,交给能效核心来做。 那么显卡的核心是什么? 密集恐惧症退散! |

|

|

茫茫多的小学生! 我们现在再来看GPU的架构图 |

|

|

我们现在把这个GPU想象成一个专门雇佣小学生童工的血汗工厂。 一个GPU(工厂)下面有很多TPC(车间),车间又分成了很多SM(班组),SM由一个个的SP单元(小学生)组成。 当然,中间还有各种缓存,控制单元等等,太复杂了不提。 工厂(GPU)接了个项目,分给各个车间(TPC)不同任务,车间(TPC)拆解后分发给班组(SM),班组(SM)最后把每项工作落实到干活的小学生(SP)手上,计算的内容不难,全是四则运算。 算完之后,再逐级汇总,最后完成了这个项目。 GPU这个血汗工厂一般接什么活呢? 画面渲染,比如一个3D结构,CPU告诉GPU“照着这个三位场景,你赶紧弄成一个从屏幕前看的视角的二位的画面出来”,GPU渲染完了交还给CPU,再接第二个活。 在没有GPU的时候,渲染工作由CPU自己完成,这是一个特别枯燥无聊没有技术含量的工作,让上面6教授8研究生的团队过来算四个运算很耽误事儿——慢,同时拖累CPU自己的复杂计算工作。 因此开发了图形处理芯片,专门负责渲染工作,这样CPU就可以从繁重的图形计算中解脱出来。 GPU为图形图像专门设计(专门负责运算量大不复杂的问题),在矩阵运算,数值计算方面具有独特优势,特别是浮点和并行计算上能优于CPU的数十数百倍的性能。 在GPU发展过程中,大家发现很多科学计算包含大量简单运算,让CPU干太慢了,于是有了一个接口,叫OpenCL(苹果提出,其他家跟进),最后成为了公开的接口规范。 换一句话说,就是当计算太简单,量还大的时候,CPU的小核心都不值得为此浪费时间,就会把计算工作交给显卡,因为没有比这更小的核心了。 对了,GPU这个雇佣小学生血汗工厂的上家甲方就是CPU里面几个教授 |

|

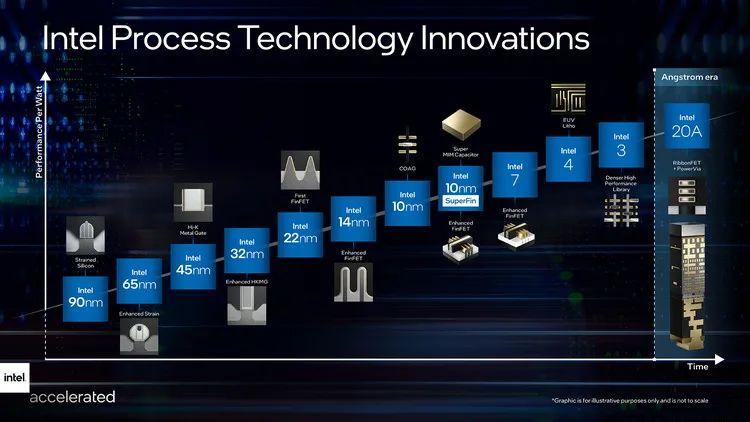

1 结论 先说结论,因为显卡或者说GPU上面的计算核心,相比CPU的核心,本来就已经足够小了,即使和CPU上的小核小比。下图是NVIDIA的CUDA编程指南里说明CPU和CPU区别的一张图,可以很容易看出差异: |

|

|

下面分别以NVIDIA的Volta GPU和龙芯的3A5000为例说明。 2 Volta Volta是NVDIA推出的第六代Tesla架构的GPU,其中CUDA core变成单独的整数和浮点运算单元了,并引入了Tensor Core。如下图所示: |

|

|

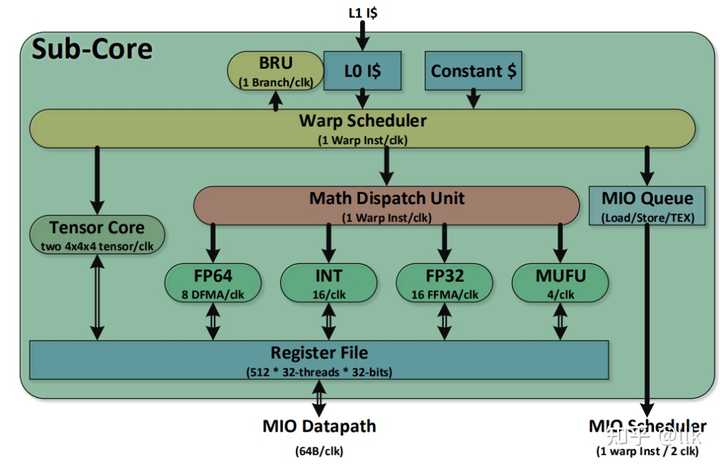

2.1 Sub Core 一个SM有4个Sub Core,每个Sub Core微架构如下图所示: |

|

|

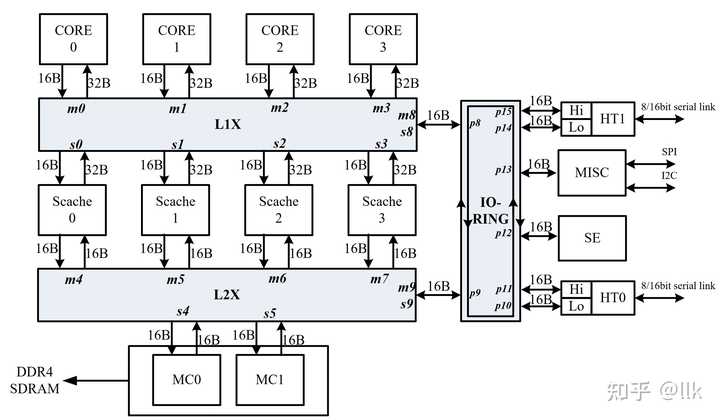

可以看到,Tensor Core可以看作一个协处理器,专门用来执行矩阵运算的,而双精度浮点,整数,单精度等标量运算都是Sub Core里的一个独立的执行单元了。这个时候已经没有cuda core了,而浮点和整数指令也可以同时执行了,可以看作一个超标量处理器了。只是这个发射宽度很宽,16个整数指令,16个单精度浮点乘加指令,8个双精度浮点指令。和通用处理器相比,缺少复杂的分支预测逻辑,指令预取逻辑,寄存器重命名逻辑,乱序执行等控制逻辑。 3 龙芯3A5000 龙芯3A5000采用和龙芯3A4000的处理器同样的GS464EV, 采用12nm工艺流片, 主频提升到2.5GHz。龙芯3A5000依然是4核处理器,而龙芯3C5000将是一款16核处理器。龙芯3A5000/3B5000是面向个人计算机、服务器等信息化领域的通用处理器,基于龙芯自主指令系统LoongArch的LA464微结构的四核处理器,在与龙芯3A4000处理器保持引脚兼容的基础上,频率提升至2.5GHz,功耗降低30%以上,性能提升50%以上。龙芯3B5000在龙芯3A5000的基础上在HT0接口上支持一致性互联以便支持多路互连。下图展示了其芯片架构: |

|

|

第一级互联采用5x5的交叉开关,用于4个处理器核,4个共享缓存模块和一个IO端口的连接。第二级互联采用5x3的交叉开关,连接4个共享的缓存模块,两个内存控制器和一个IO端口。IO环总线一共8个端口,分别连接4个HT控制器,慢速输入输出模块,安全模块以及两级交叉开关。两个HT控制器共用16条HT总线,可以作为两个8位HT或一个16位HT使用。 上述互联结构都采用读写分离的数据通道,位宽128比特,与处理器同频;处理器核和第一级交叉开关读通道是256比特。 3.1 LA464处理器核 LA464是一个4发射的超标量处理器,有4个定点单元,2个256位的向量单元和2个访存单元。每个向量单元支持8个单精度或4个双精度乘加运算;访存单元支持256位存储访问.下图展示了LA464处理器核的微架构: |

|

|

可以很容易看出来,LA464相比Volta 的Sub Core,执行单元很少,但是相应的控制逻辑很多,有复杂的分支预测逻辑,指令预取逻辑,寄存器重命名逻辑,乱序执行等控制逻辑。 参考文献CUDA C PROGRAMMING GUIDE J. Choquette, O. Giroux and D. Foley, "Volta: Performance and Programmability," in IEEE Micro, vol. 38, no. 2, pp. 42-52, Mar./Apr. 2018, doi: 10.1109/MM.2018.022071134.Loongson 3A5000/3B5000 Processor Reference Manual - Multicore Processor Architecture, Register Descriptions and System Software Programming Guide, n.d.Wang H., Wang W., Wu R., Hu W., 2015. 龙芯GS464E处理器核架构设计. Sci. Sin.-Inf. 45, 480–500. https://doi.org/10.1360/N112014-00292 |

|

谢邀。 本质显卡就是超多的小核,3060和12400的面积差别不大,密度也没有差特别多。 3060有3840个cuda核心,12400只有6个cpu核心。 对于显卡来说,更多的小核心比堆大核心更有性价比。 但从另外一个角度想,nv也在考虑做异构化,cuda现在本身就是异构计算核心。 N卡中,存在有int32、fp32、fp64的计算单元,呈一定比例构成cuda core核心,此外还有专用于矩阵计算的tensor core核心。 从这个角度讲,现在显卡中的异构化,比cpu大小核的异构化更为彻底,更为专用,更为高效。 |

|

先上结论:需求和架构决定的。 这问题算是个大命题,因为显卡主打的是迸发运算,工作内容比较单一,而cpu支持轻量且需要单核运算,既要照顾系统,还要照顾各种软件。 通俗来说,cpu的工作内容,相比显卡要复杂很多,cpu照顾的是一大家子,而显卡支持的是一个人。 就相当于,cpu是将军,显卡是小兵。 将军都冲锋陷阵的时候,你的整个电脑可能就会进入卡顿、失灵的状态了把。 cpu可以不要显卡,但显卡不能没有cpu,那就意味着,显卡可以一往无前地冲锋,压榨干性能,而cpu必须要保留余量,临阵指挥,让大家有最坚强的后盾。 CPU的大小核心就是为了对付重任务和轻任务。 而且这个逻辑最大的用处,是降低cpu能耗,提高设备的续航,手机作为移动使用最典范的代表,大小核心绝对属于刚需范畴,笔记本都还好点,大部分用户可以插电用。 CPU分多个核心和线程,一般如下图。 |

|

|

现在的cpu生产力是有裕度的: 日常商务办公,比如office三件套,大家开浏览器,或者看视频,往往单核可能都吃不满,多开的时候,会压力大点;我们的轻度设计,比如ps、cad画图,这些应用,也不会吃太多核心;另外,有些3d建模,比如revit、3dsmax这样的,加载程序甚至只吃一个核心.市面上主流的,也就PR输出视频,C4d输出图文,渲染贴皮类应用,或者matlab数据仿真输出结果,这个cpu才会吃满; 显卡呢?除了入门级的网游,比如LOL这样的,可能吃不满显卡,主流的3A大作,包括3d网游,上来就能把显卡吃透。 哦哦,我们在建模中特效、纹理展示的适合,显卡倒是一般也吃不满。 |

|

|

上面的硬件思维有了,但软件思维,我还可以补充点。 系统上的主流软件,尤其是windows系统作为平台,而显卡是平台的一个插件,显卡程序的运行是基于系统之上的,系统的逻辑在cpu上。 |

|

|

大小核心是将来,现在cpu这一块,AMD依然是老传统。 intel倒是大小核心架构改了,而且2024款ultra系列,特别还加了2个低功耗小核心,进一步照顾续航。 |

|

如今的“大小核”,存在着诸多固有缺憾 如果此前有关注过我们三易生活的相关内容,你可能会记得,我们对如今PC处理器上的“大小核”设计其实是颇有微词的。以至于不久前,我们还专门折腾出了一台没有“大小核”设计的11代酷睿+究极DDR4平台,并对其进行了大量测试,以展现其各方面的性能表现。 为什么我们不太喜欢目前PC处理器的“大小核”设计?这是因为综合已知的相关信息来看,“大小核”有着至少三个难以回避的缺陷。 首先,是由于主打高能效的“小核”不支持一些比较高级的浮点加速指令集(比如AVX-512、AMX等),所以导致采用了“大小核”设计的12代、13代酷睿,不得不在“大核”上也屏蔽对应的指令集。结果便是使得其在指令集兼容性方面,相比于以往的“纯大核”产品反而有所倒退。 |

|

|

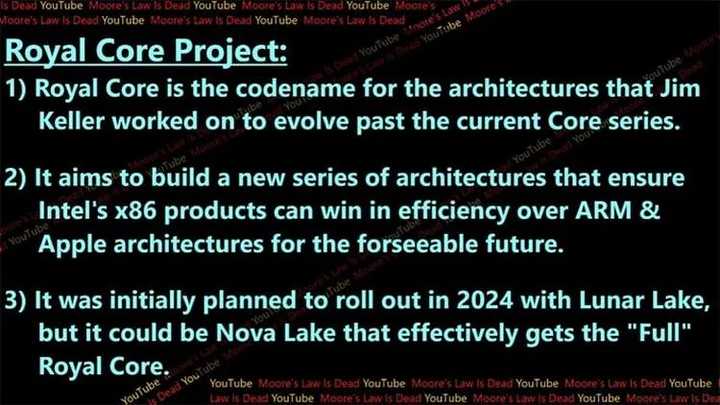

其次,由于“大核”和“小核”在设计思路上存在极大差异,所以导致它们的峰值性能差别甚大。换句话说,当某个大型程序同时需要“高单核性能+足够多核心数量”时,此时那些数量看似不少的“小核”,反而可能会因为单核性能不够强,从而成为制约运行效率的瓶颈(通俗来说,就是大核已经被占满,但小核又带不动多出来的、对单核性能需求极高的线程)。这一点,其实从许多高端主板如今都设置了强行关闭所有“小核”,只用大核运行程序的所谓“游戏模式”,就能看出端倪。 第三,因为这种架构差异,导致了“大核”在能效表现上远不及“小核”。换句话说,如果将上面的这类场景反过来,也就是“有大量程序在运行,但其实都不需要很强单核性能”时,一旦小核上的线程被占满,处理器自动“启用”大核时,功耗就必然会陡增、能效比会大幅下降。这对于重视发热、续航的轻薄型笔记本电脑来说,显然不是件好事。 “Royal Core”泄露,或彻底解决现有的各种问题 说了这么多,许多朋友可能已经发现问题了。对于目前PC处理器的“大小核”设计来说,它最大的短板其实就在于大核与小核之间存在过大的架构、技术,以及性能差异上。 |

|

|

说白了,厂商想到的,是如果消费者同时运行“大程序”和“小程序”(比如一边打游戏一边开直播,或是一边剪辑视频一边写文章),那么大小核各司其职、电脑就能兼顾性能与能效。但在实际使用场景中,这样的情况还真不见得就很多,所以到了“全重负载”或“全轻负载”的时候,大核与小核之间相互无法替代的短板便会展露无遗。 那么问题就来了,有没有办法让“大小核”之间实现真正的自由转化,让“大核”在需要能效比的时候可以变得与“小核”一样省电、一样发热量低,“小核”在需要性能时,可以真正与“大核”发挥相同或近似的性能呢? 其实还真有。而这便是很早前就被曝光,但近日才终于有了更详细架构信息的,Intel下下下下代(对你没看错)处理器“Royal Core”。 |

|

|

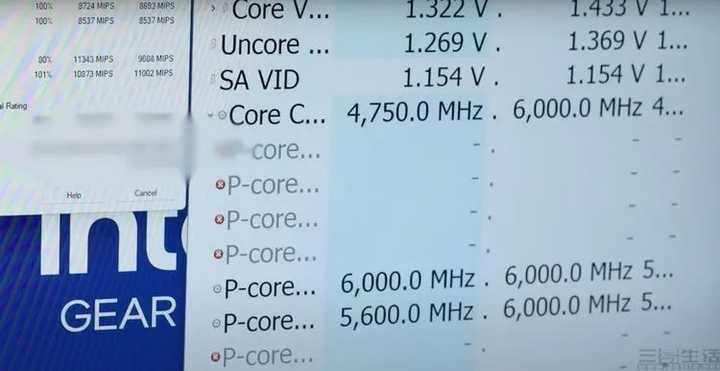

首先需要说明的是,“CPU tiles”并非17代酷睿的架构名称,而更像是项目代号。具体到处理器架构设计上,“Royal Core”将会使用一种非常特别的、被称为“CPU tiles”的内核构造。 在重负载场景下,其每一个“CPU tiles”都可以视作一个完整的“大核心”。它拥有足够高的并发数,能提供极高的执行效率,也就是超强的单核性能。 |

|

|

而到了轻负载场景,每一个“CPU tiles”又能被自动“拆分”成两颗“小核心”运作。此时它便能实现更高的能效比,同时还可以为软件提供更多的并行线程。 划时代的设计,或许在17年前就已埋下伏笔 不难发现,如果目前曝光的相关信息属实,那么最快可能在2024年下半年便会登场的17代酷睿“Nova Lake”家族,将会带来前所未有的架构设计,同时完美解决现有“大小核”之间因架构差异而导致的种种兼容性和性能问题。 然而这样的“全新设计”,真的是“前所未有”的吗? |

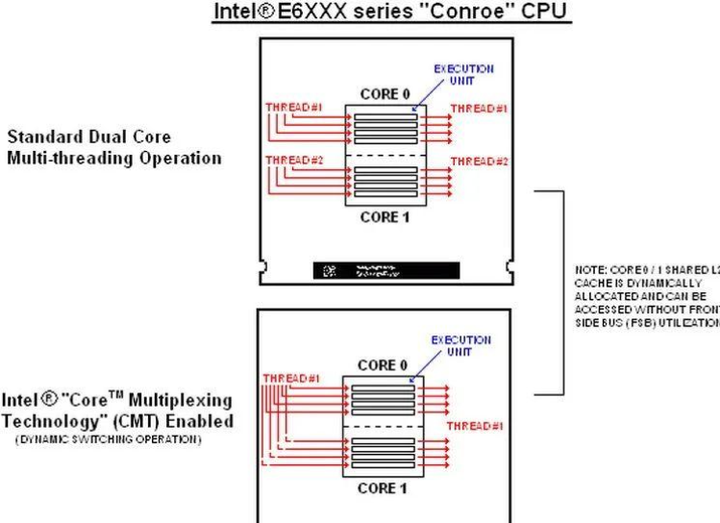

|

|

其实早在2006年年中、也就是差不多17年前,当时许多科技媒体就报道了一种名为“反超线程”的处理器技术。据称,它可以将两个处理器核心“合并”为一个,从而带来更高的单核性能。特别是对于当时的早期四核处理器来说,这一技术将有望让它们在很多(当时)只支持双核的应用中,获得惊人的性能提升。 有趣的是,翻看相关资料我们发现,早在2006年年中,Intel方面就在他们的高端主板(i975X)上,更新了一个被称为“Core Multiplexing Technology(核心多路复用技术)”的开关。有媒体发现,开启这个功能后,原本的双核处理器就会被识别为“具有两个逻辑单元的单核”,也就是将两个核心在软件层面“合并”了。 |

|

|

但或许是因为这项技术在当时过于超前,又或者Intel判断多核才是那个年代CPU发展的正确方向。总之,“Core Multiplexing Technology”这个功能仅仅只在Intel官方主板的BIOS里出现了一个月,就被后来的更新版本屏蔽掉,从此再也“不见天日”。 那么,这是否意味着由芯片大神Jim Keller亲自操刀的“Royal Core”,在基本理念上受到了Intel 17年前这项技术的启发呢?从现有的曝光信息来看,确实有这个可能。但很显然,“Royal Core”的核心合并机制会更彻底,也有望会带来一些以往从未在消费级处理器上出现过的新技术(比如四超线程)。 而至于它的实际效果如何,能否真正引领PC处理器架构设计的一个全新时代,可能就要等到2024年才能见分晓了。 |

|

|

同构和异构,虽然方向不同,但是目的却是一样的,都是为了提高处理器的性能与效率,让系统可以更灵活的分配任务和调用,不过异构和同构也确实有着不一样的擅长领域。先来说说异构,英特尔的大小核设计在功耗上的优势较为明显,而且让其在低使用率的情况下,可以提供优秀的功耗及发热表现,十分适合移动端和小型PC。 那么同构大小核呢?相对于异构大小核,同构设计的功耗优势显然会小很多,但是对比传统的全大核设计依然有着明显优势,而且还有着更多的线程数,相对而言,在高负荷的大型任务中,同构大小核的整体性能表现会更优秀一些。在日常使用时,两者的表现或许会十分相似,而在高负荷任务时,AMD的优势或许会显现出来。 不过,根据以往的测试结果来看,虽然异构设计的效率核性能不如性能核,但是英特尔的单核性能一直领先AMD,加上Windows系统的针对性调度优化,即使效率核的性能较弱,参与度却很高,一定程度上也弥补了其中的弱势,所以最终鹿死谁手,还不好说。 个人认为,在AMD的桌面端大小核处理器还未发布的情况下,其实并不好判断英特尔与AMD的方向谁优谁劣,但是,至少可以肯定在AMD的追赶下,英特尔应该也会再次提速,让处理器的升级速度再次加快,对于消费者来说,不管最终AMD和英特尔谁胜出,都是有益而无害的。 |

|

|

| [收藏本文] 【下载本文】 |

| 科技知识 最新文章 |

| 百度为什么越来越垃圾了? |

| 百度为什么越来越垃圾了? |

| 为什么程序员总是发现不了自己的Bug? |

| 出现在抖音评论区里边的算命真不真? |

| 你认为 C++ 最不应该存在的特性是什么? |

| 为什么 Windows 的兼容性这么强大,到底用了 |

| 如何看待Nvidia禁止使用翻译工具将cuda运行 |

| 为何苹果搞了十年的汽车还是难产,小米很快 |

| 该不该和AI说谢谢? |

| 为什么突破性的技术总是最先发生在西方? |

| 上一篇文章 下一篇文章 查看所有文章 |

|

|

|

| 股票涨跌实时统计 涨停板选股 分时图选股 跌停板选股 K线图选股 成交量选股 均线选股 趋势线选股 筹码理论 波浪理论 缠论 MACD指标 KDJ指标 BOLL指标 RSI指标 炒股基础知识 炒股故事 |

| 网站联系: qq:121756557 email:121756557@qq.com 天天财汇 |